DR: imagem de retrato único ?♂️ + áudio ? = vídeo da cabeça falante?.

A licença foi atualizada para Apache 2.0 e removemos a restrição não comercial

SadTalker agora foi oficialmente integrado ao Discord, onde você pode usá-lo gratuitamente enviando arquivos. Você também pode gerar vídeos de alta qualidade a partir de prompts de texto. Juntar:

Publicamos uma extensão webui de difusão estável. Confira mais detalhes aqui. Vídeo de demonstração

O modo de imagem completa já está disponível! Mais detalhes...

| ainda + intensificador em v0.0.1 | ainda + intensificador em v0.0.2 | imagem de entrada @ bagbag1815 |

|---|---|---|

still_e_n.mp4 | full_body_2.bus_chinese_enhanced.mp4 |  |

Vários novos modos (modos estáticos, de referência e de redimensionamento) estão agora disponíveis!

Estamos felizes em ver mais demonstrações da comunidade no bilibili, YouTube e X (#sadtalker).

O changelog anterior pode ser encontrado aqui.

[2023.06.12] : Adicionados mais novos recursos na extensão WebUI, veja a discussão aqui.

[2023.06.05] : Lançado um novo modelo de rosto de 512x512px (beta). Corrigidos alguns bugs e melhorado o desempenho.

[2023.04.15] : Adicionado um notebook WebUI Colab por @camenduru:

[2023.04.12] : Adicionado um documento de instalação do WebUI mais detalhado e corrigido um problema durante a reinstalação.

[2023.04.12] : Corrigidos problemas de segurança do WebUI devido a pacotes de terceiros e otimizado o caminho de saída em sd-webui-extension .

[2023.04.08] : Na v0.0.2, adicionamos uma marca d'água de logotipo ao vídeo gerado para evitar abusos. Esta marca d'água foi removida em uma versão posterior.

[2023.04.08] : Na v0.0.2, adicionamos recursos para animação completa da imagem e um link para baixar pontos de verificação do Baidu. Também otimizamos a lógica do intensificador.

Estamos acompanhando novas atualizações na edição nº 280.

Se você tiver algum problema, leia nossas Perguntas frequentes antes de abrir um problema.

Tutoriais da comunidade: 中文Windows教程 (tutorial chinês do Windows) | 日本語コース (Tutorial em japonês).

Instale Anaconda, Python e git .

Criando o ambiente e instalando os requisitos.

git clone https://github.com/OpenTalker/SadTalker.git

cd SadTalker

conda create -n sadtalker python=3.8

conda activate sadtalker

pip install torch==1.12.1+cu113 torchvision==0.13.1+cu113 torchaudio==0.12.1 --extra-index-url https://download.pytorch.org/whl/cu113

conda install ffmpeg

pip install -r requirements.txt

# ## Coqui TTS is optional for gradio demo.

# ## pip install TTS

Um tutorial em vídeo em chinês está disponível aqui. Você também pode seguir as seguintes instruções:

scoop install git .ffmpeg , seguindo este tutorial ou usando scoop: scoop install ffmpeg .git clone https://github.com/Winfredy/SadTalker.git .start.bat no Windows Explorer normalmente, como usuário não administrador, e uma demonstração WebUI com tecnologia Gradio será iniciada.Um tutorial sobre como instalar o SadTalker no macOS pode ser encontrado aqui.

Confira tutoriais adicionais aqui.

Você pode executar o seguinte script no Linux/macOS para baixar automaticamente todos os modelos:

bash scripts/download_models.sh Também fornecemos um patch offline ( gfpgan/ ), para que nenhum modelo seja baixado durante a geração.

sadt )sadt )O modelo explica:

| Modelo | Descrição |

|---|---|

| pontos de verificação/mapping_00229-model.pth.tar | MappingNet pré-treinado em Sadtalker. |

| pontos de verificação/mapping_00109-model.pth.tar | MappingNet pré-treinado em Sadtalker. |

| pontos de verificação/SadTalker_V0.0.2_256.safetensors | pontos de verificação sadtalker empacotados da versão antiga, renderização de 256 faces). |

| pontos de verificação/SadTalker_V0.0.2_512.safetensors | pontos de verificação sadtalker empacotados da versão antiga, renderização de 512 faces). |

| gfpgan/pesos | Detecção de rosto e modelos aprimorados usados em facexlib e gfpgan . |

| Modelo | Descrição |

|---|---|

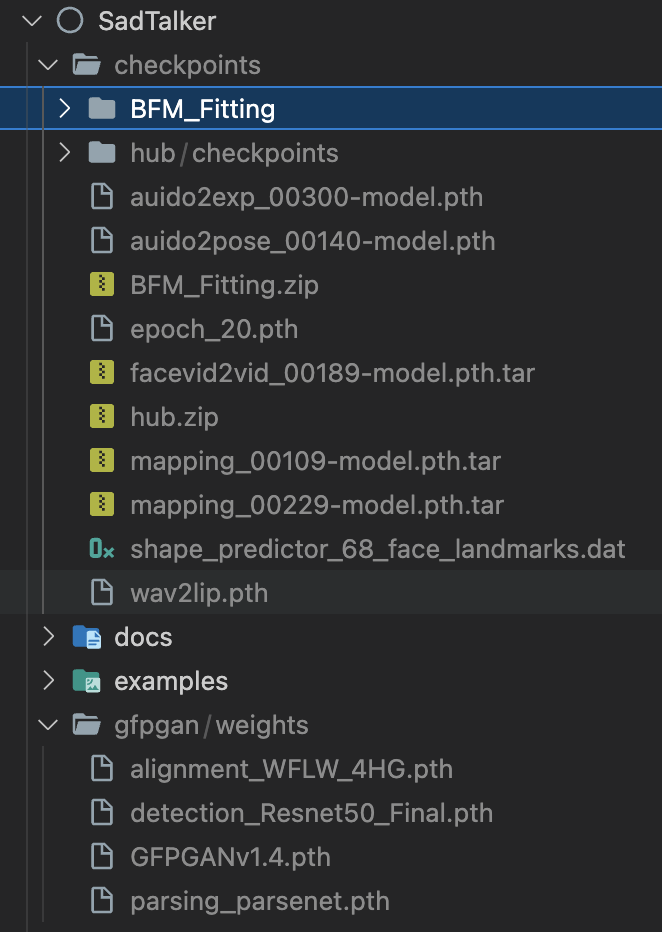

| pontos de verificação/auido2exp_00300-model.pth | ExpNet pré-treinado em Sadtalker. |

| pontos de verificação/auido2pose_00140-model.pth | PoseVAE pré-treinado em Sadtalker. |

| pontos de verificação/mapping_00229-model.pth.tar | MappingNet pré-treinado em Sadtalker. |

| pontos de verificação/mapping_00109-model.pth.tar | MappingNet pré-treinado em Sadtalker. |

| pontos de verificação/facevid2vid_00189-model.pth.tar | Modelo face-vid2vid pré-treinado a partir do reaparecimento de face-vid2vid. |

| pontos de verificação/epoch_20.pth | Extrator 3DMM pré-treinado em Deep3DFaceReconstruction. |

| pontos de verificação/wav2lip.pth | Modelo de sincronização labial altamente preciso em Wav2lip. |

| pontos de verificação/shape_predictor_68_face_landmarks.dat | Modelo de referência facial usado em dilb. |

| pontos de verificação/BFM | Arquivo de biblioteca 3DMM. |

| pontos de verificação/centro | Modelos de detecção facial usados no alinhamento facial. |

| gfpgan/pesos | Detecção de rosto e modelos aprimorados usados em facexlib e gfpgan . |

A pasta final será mostrada como:

Leia nosso documento sobre práticas recomendadas e dicas de configuração

Demonstração on-line : HuggingFace | SDWebUI-Colab | Colab

Extensão WebUI local : consulte a documentação do WebUI.

Demonstração gradio local (recomendada) : uma instância Gradio semelhante à nossa demonstração Hugging Face pode ser executada localmente:

# # you need manually install TTS(https://github.com/coqui-ai/TTS) via `pip install tts` in advanced.

python app_sadtalker.pyVocê também pode iniciá-lo com mais facilidade:

webui.bat e os requisitos serão instalados automaticamente.bash webui.sh para iniciar o webui.python inference.py --driven_audio < audio.wav >

--source_image < video.mp4 or picture.png >

--enhancer gfpgan Os resultados serão salvos em results/$SOME_TIMESTAMP/*.mp4 .

Usando --still para gerar um vídeo natural de corpo inteiro. Você pode adicionar enhancer para melhorar a qualidade do vídeo gerado.

python inference.py --driven_audio < audio.wav >

--source_image < video.mp4 or picture.png >

--result_dir < a file to store results >

--still

--preprocess full

--enhancer gfpgan Mais exemplos, configurações e dicas podem ser encontradas nos documentos >>> melhores práticas <<<.

Se você achar nosso trabalho útil em sua pesquisa, considere citar:

@article { zhang2022sadtalker ,

title = { SadTalker: Learning Realistic 3D Motion Coefficients for Stylized Audio-Driven Single Image Talking Face Animation } ,

author = { Zhang, Wenxuan and Cun, Xiaodong and Wang, Xuan and Zhang, Yong and Shen, Xi and Guo, Yu and Shan, Ying and Wang, Fei } ,

journal = { arXiv preprint arXiv:2211.12194 } ,

year = { 2022 }

}O código do Facerender é muito emprestado da reprodução de face-vid2vid e PIRender de zhanglonghao. Agradecemos aos autores por compartilhar seu código maravilhoso. No processo de treinamento, também utilizamos o modelo Deep3DFaceReconstruction e Wav2lip. Agradecemos pelo seu maravilhoso trabalho.

Também usamos as seguintes bibliotecas de terceiros:

Este não é um produto oficial da Tencent.

1. Please carefully read and comply with the open-source license applicable to this code before using it.

2. Please carefully read and comply with the intellectual property declaration applicable to this code before using it.

3. This open-source code runs completely offline and does not collect any personal information or other data. If you use this code to provide services to end-users and collect related data, please take necessary compliance measures according to applicable laws and regulations (such as publishing privacy policies, adopting necessary data security strategies, etc.). If the collected data involves personal information, user consent must be obtained (if applicable). Any legal liabilities arising from this are unrelated to Tencent.

4. Without Tencent's written permission, you are not authorized to use the names or logos legally owned by Tencent, such as "Tencent." Otherwise, you may be liable for legal responsibilities.

5. This open-source code does not have the ability to directly provide services to end-users. If you need to use this code for further model training or demos, as part of your product to provide services to end-users, or for similar use, please comply with applicable laws and regulations for your product or service. Any legal liabilities arising from this are unrelated to Tencent.

6. It is prohibited to use this open-source code for activities that harm the legitimate rights and interests of others (including but not limited to fraud, deception, infringement of others' portrait rights, reputation rights, etc.), or other behaviors that violate applicable laws and regulations or go against social ethics and good customs (including providing incorrect or false information, spreading pornographic, terrorist, and violent information, etc.). Otherwise, you may be liable for legal responsibilities.

LOGO: sugestão de cor e fonte: ChatGPT, fonte do logotipo: Montserrat Alternates.

Todos os direitos autorais das imagens e áudio de demonstração são de usuários da comunidade ou de geração de difusão estável. Sinta-se à vontade para entrar em contato conosco se desejar removê-los.