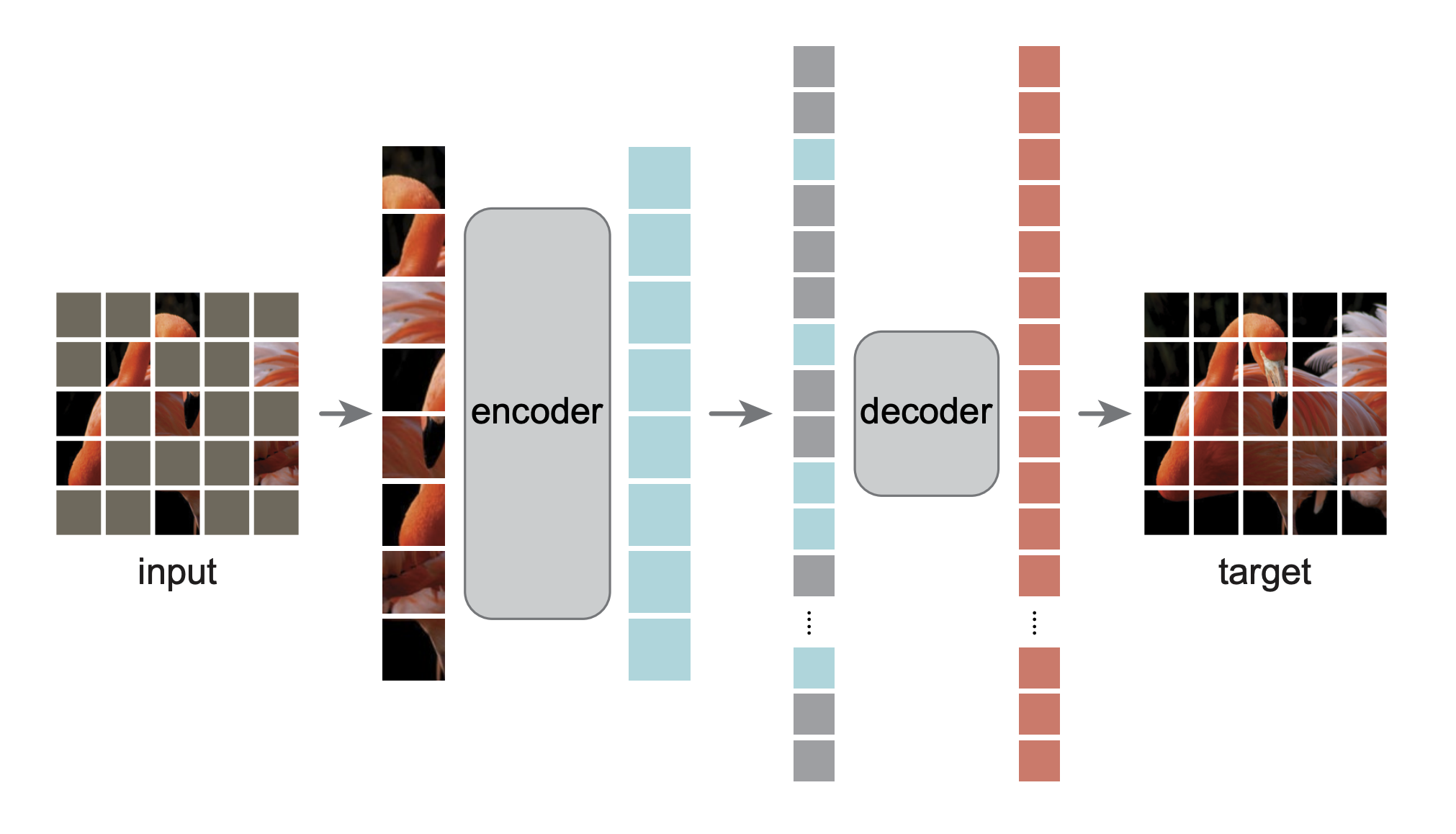

Esta é uma reimplementação PyTorch/GPU do artigo Masked Autoencoders Are Scalable Vision Learners:

@Article{MaskedAutoencoders2021,

author = {Kaiming He and Xinlei Chen and Saining Xie and Yanghao Li and Piotr Doll{'a}r and Ross Girshick},

journal = {arXiv:2111.06377},

title = {Masked Autoencoders Are Scalable Vision Learners},

year = {2021},

}

A implementação original foi em TensorFlow+TPU. Esta reimplementação está em PyTorch + GPU.

Este repositório é uma modificação do repositório DeiT. A instalação e preparação seguem esse repositório.

Este repositório é baseado em timm==0.3.2 , para o qual é necessária uma correção para funcionar com PyTorch 1.8.1+.

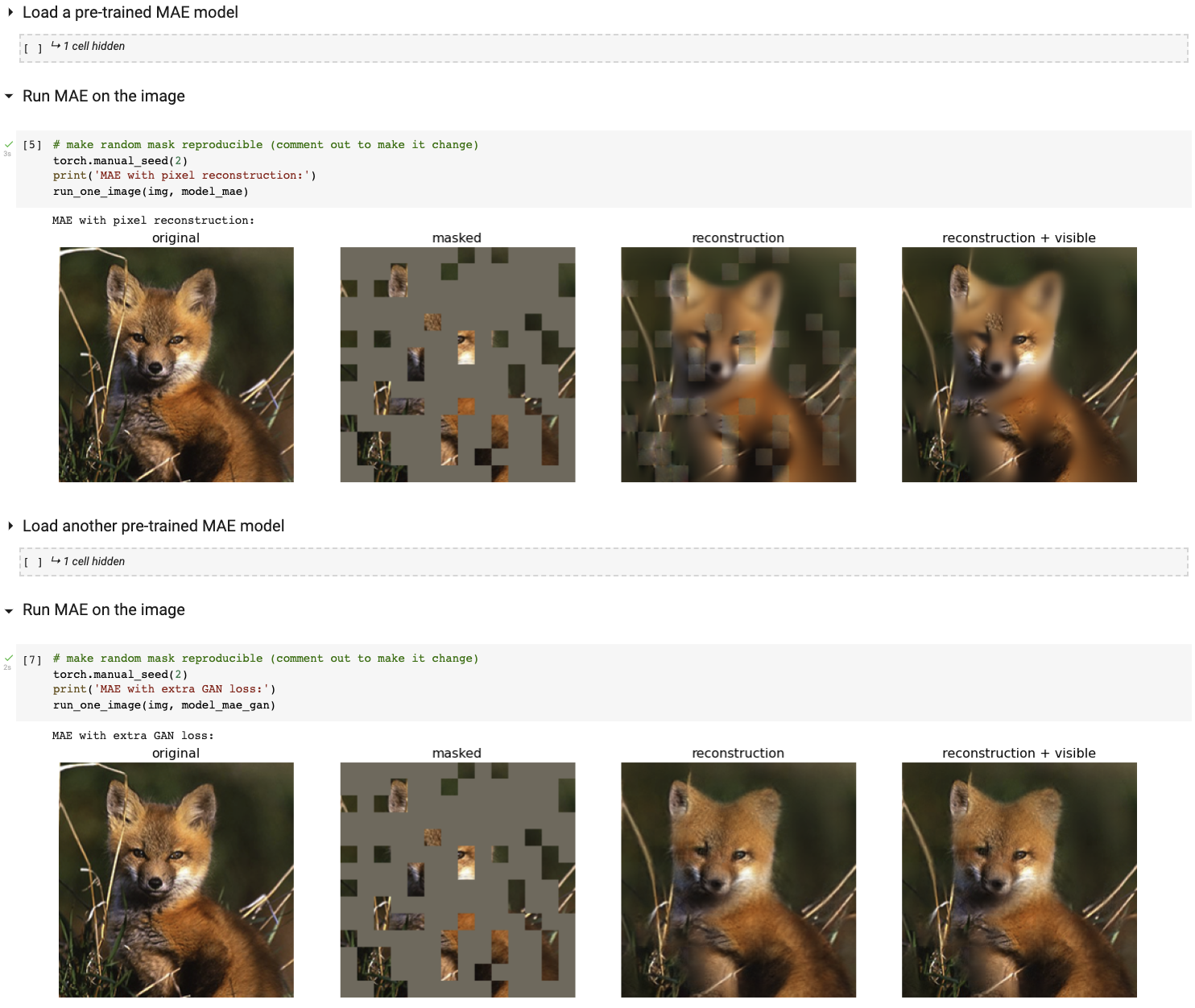

Execute nossa demonstração de visualização interativa usando o notebook Colab (sem necessidade de GPU):

A tabela a seguir fornece os pontos de verificação pré-treinados usados no artigo, convertidos de TF/TPU para PT/GPU:

| Base ViT | ViT-Grande | ViT-Enorme | |

|---|---|---|---|

| posto de controle pré-treinado | download | download | download |

| md5 | 8cad7c | b8b06e | 9bdbb0 |

A instrução de ajuste fino está em FINETUNE.md.

Ao ajustar esses modelos pré-treinados, ficamos em primeiro lugar nessas tarefas de classificação (detalhadas no artigo):

| ViT-B | ViT-L | ViT-H | ViT-H 448 | anterior melhor | |

|---|---|---|---|---|---|

| ImageNet-1K (sem dados externos) | 83,6 | 85,9 | 86,9 | 87,8 | 87,1 |

| a seguir estão as avaliações dos mesmos pesos do modelo (ajustados no ImageNet-1K original): | |||||

| ImageNet-Corruption (taxa de erro) | 51,7 | 41,8 | 33,8 | 36,8 | 42,5 |

| ImageNet-Adversário | 35,9 | 57.1 | 68,2 | 76,7 | 35,8 |

| Representação ImageNet | 48,3 | 59,9 | 64,4 | 66,5 | 48,7 |

| Esboço ImageNet | 34,5 | 45,3 | 49,6 | 50,9 | 36,0 |

| a seguir está a aprendizagem por transferência, ajustando o MAE pré-treinado no conjunto de dados de destino: | |||||

| iNaturalistas 2017 | 70,5 | 75,7 | 79,3 | 83,4 | 75,4 |

| iNaturalistas 2018 | 75,4 | 80,1 | 83,0 | 86,8 | 81,2 |

| iNaturalistas 2019 | 80,5 | 83,4 | 85,7 | 88,3 | 84,1 |

| Lugares205 | 63,9 | 65,8 | 65,9 | 66,8 | 66,0 |

| Lugares365 | 57,9 | 59,4 | 59,8 | 60,3 | 58,0 |

As instruções de pré-treinamento estão em PRETRAIN.md.

Este projeto está sob a licença CC-BY-NC 4.0. Consulte LICENÇA para obter detalhes.