Movie Gen é um elenco de modelos básicos que gera vídeos HD 1080p de alta qualidade com diferentes proporções e áudio sincronizado. Aqui, apresentamos nosso benchmark de avaliação "Movie Gen Bench", que inclui Movie Gen Video Bench (Seção 3.5.2) e Movie Gen Audio Bench (Seção 6.3.2), conforme detalhado no relatório técnico do Movie Gen.

Para permitir uma comparação justa e fácil com o Movie Gen para trabalhos futuros nesses benchmarks de avaliação, também lançamos os vídeos gerados não escolhidos a dedo do Movie Gen no Movie Gen Video Bench e no Movie Gen Audio Bench.

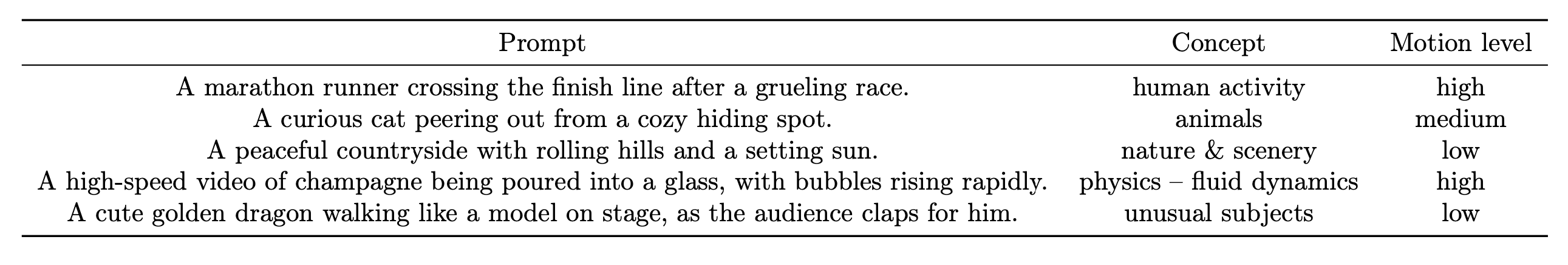

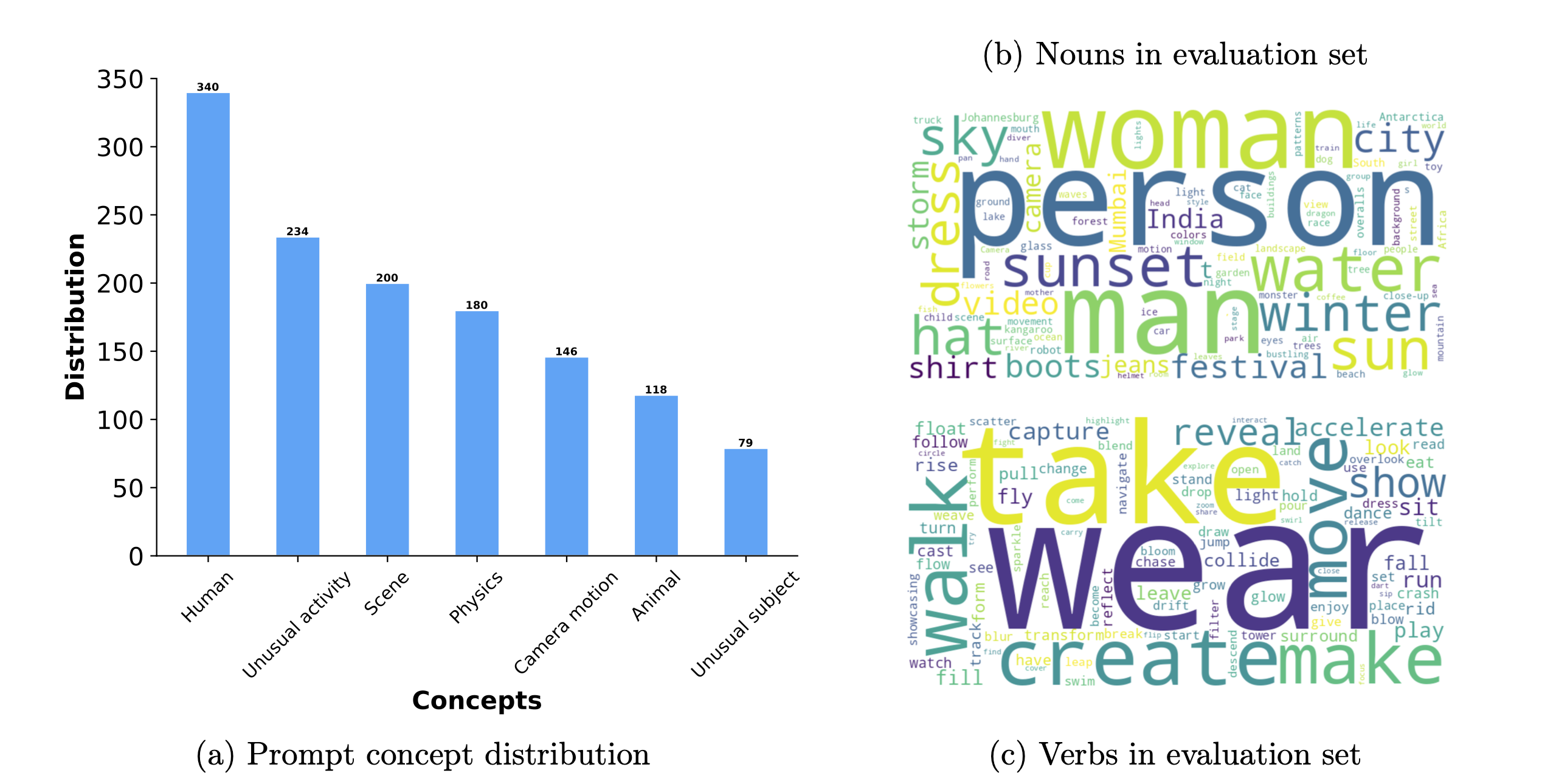

O Movie Gen Video Bench consiste em 1.003 prompts que cobrem todos os diferentes aspectos/conceitos de teste:

Além de uma cobertura abrangente de diferentes aspectos importantes do teste, os prompts também oferecem uma boa cobertura de níveis de movimento alto/médio/baixo ao mesmo tempo.

A lista de prompts benchmark/MovieGenVideoBench.txt está incluída neste repositório. Além disso, lançamos os conceitos de teste e tags de nível de movimento para cada prompt em benchmark/MovieGenVideoBenchWithTag.csv . Os vídeos gerados correspondentes (por Movie Gen) podem ser baixados através deste link.

O Movie Gen Video Bench também está disponível no Hugging Face.

O Movie Gen Audio Bench consiste em 527 vídeos gerados e efeitos sonoros e avisos musicais associados

benchmark/MovieGenAudioBenchSfx.jsonl inclui os prompts de efeitos sonoros usados para geração de efeitos sonoros e, adicionalmente, prompts de vídeo usados para gerar vídeos de teste. Vídeos com áudio e prompts podem ser baixados neste link.

benchmark/MovieGenAudioBenchSfxMusic.jsonl inclui o efeito sonoro e os prompts de música usados para geração conjunta de efeitos sonoros e música de fundo e, adicionalmente, prompts de vídeo usados para gerar vídeos de teste. Vídeos com áudio e prompts podem ser baixados neste link.

O modelo é licenciado sob a licença CC-BY-NC

Se você achar o Movie Gen Bench útil, considere citar:

@misc{polyak2024moviegencastmedia,

title={Movie Gen: A Cast of Media Foundation Models},

author={Adam Polyak and Amit Zohar and Andrew Brown and Andros Tjandra and Animesh Sinha and Ann Lee and Apoorv Vyas and Bowen Shi and Chih-Yao Ma and Ching-Yao Chuang and David Yan and Dhruv Choudhary and Dingkang Wang and Geet Sethi and Guan Pang and Haoyu Ma and Ishan Misra and Ji Hou and Jialiang Wang and Kiran Jagadeesh and Kunpeng Li and Luxin Zhang and Mannat Singh and Mary Williamson and Matt Le and Matthew Yu and Mitesh Kumar Singh and Peizhao Zhang and Peter Vajda and Quentin Duval and Rohit Girdhar and Roshan Sumbaly and Sai Saketh Rambhatla and Sam Tsai and Samaneh Azadi and Samyak Datta and Sanyuan Chen and Sean Bell and Sharadh Ramaswamy and Shelly Sheynin and Siddharth Bhattacharya and Simran Motwani and Tao Xu and Tianhe Li and Tingbo Hou and Wei-Ning Hsu and Xi Yin and Xiaoliang Dai and Yaniv Taigman and Yaqiao Luo and Yen-Cheng Liu and Yi-Chiao Wu and Yue Zhao and Yuval Kirstain and Zecheng He and Zijian He and Albert Pumarola and Ali Thabet and Artsiom Sanakoyeu and Arun Mallya and Baishan Guo and Boris Araya and Breena Kerr and Carleigh Wood and Ce Liu and Cen Peng and Dimitry Vengertsev and Edgar Schonfeld and Elliot Blanchard and Felix Juefei-Xu and Fraylie Nord and Jeff Liang and John Hoffman and Jonas Kohler and Kaolin Fire and Karthik Sivakumar and Lawrence Chen and Licheng Yu and Luya Gao and Markos Georgopoulos and Rashel Moritz and Sara K. Sampson and Shikai Li and Simone Parmeggiani and Steve Fine and Tara Fowler and Vladan Petrovic and Yuming Du},

year={2024},

eprint={2410.13720},

archivePrefix={arXiv},

primaryClass={cs.CV},

url={https://arxiv.org/abs/2410.13720},

}