Crie e implante aplicativos generativos (LLMs e difusores) (chatbots e APIs) em segundos.

input() e print() ou gravar o arquivo no disco.Concentre-se em IA (RAG, ajuste fino, alinhamento, treinamento) e ignore tarefas de engenharia (desenvolvimento de front-end, integração de back-end, implantação, operações).

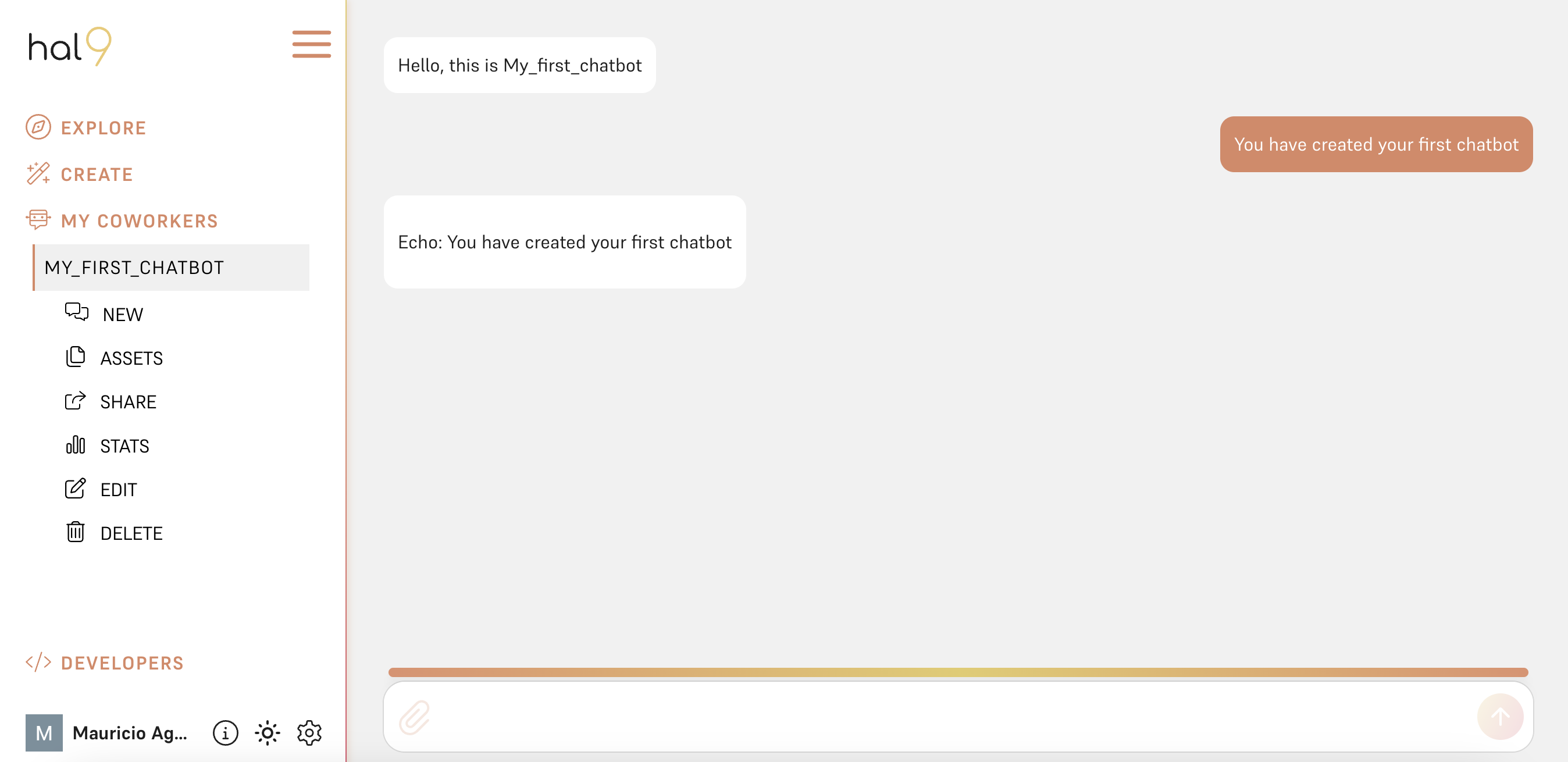

Crie e compartilhe um chatbot em segundos da seguinte maneira:

pip install hal9

hal9 create chatbot

hal9 deploy chatbot Observe que deploy precisa de uma variável de ambiente HAL9_TOKEN com um token de API que você pode obter em hal9.com/devs. Você pode usar esse token para implantar no seu computador local, um notebook ou automatizar no GitHub.

HAL9_TOKEN=H9YOURTOKEN hal9 deploy chatbot --name my_first_chatbotTão fácil quanto isso você criou seu primeiro chatbot!

O código dentro de /chatbot/app.py contém um chatbot "Hello World" que lê o prompt do usuário e repete o resultado:

prompt = input ()

print ( f"Echo: { prompt } " )Projetamos este pacote com a simplicidade em mente, a função do código é ler a entrada e escrever a saída, só isso. Dito isso, você pode criar chatbots que utilizam LLMs, gerar imagens, ou ainda utilizar ferramentas que se conectam a bancos de dados, ou até mesmo construir sites e jogos!

Por padrão, hal9 create padrões para o modelo --template echo , mas você pode escolher diferentes como segue:

hal9 create chatbot-openai --template openai

hal9 create chatbot-groq --template groq Um modelo fornece código pronto para uso com tecnologias e casos de uso específicos. É muito popular usar o modelo semelhante ao ChatGPT da OpenAI com --template openai , o código gerado será o seguinte:

import hal9 as h9

from openai import OpenAI

messages = h9 . load ( "messages" , [])

prompt = h9 . input ( messages = messages )

completions = OpenAI (). chat . completions . create ( model = "gpt-4" , messages = messages , stream = True )

h9 . complete ( completions , messages = messages )

h9 . save ( "messages" , messages , hidden = True ) A seção Aprender explica em detalhes como esse código funciona, mas fornecerá uma visão geral rápida. O pacote hal9 contém funções auxiliares para simplificar seu código de IA generativo. Você pode optar por não usar hal9 e usar as instruções input() e print() você mesmo, ou até mesmo processar ferramentas como langchain . As funções h9.load() e h9.save() carregam e salvam dados em sessões de chat, nossa plataforma é sem estado por padrão. A função h9.input() é um wrapper fino sobre input() que também armazena a entrada do usuário nas messages . Então h9.complete() é uma função auxiliar para ajudar a analisar os resultados da conclusão e salvar o resultado em messages . É isso!

Para fazer alterações em seu projeto, abra chatbot/ em seu IDE e modifique chatbot/app.py .

Você pode então executar seu projeto da seguinte maneira:

hal9 run chatbot Se você personalizou seu modelo com --template certifique-se de definir a chave correta, por exemplo, se estiver usando o modelo OpenAI para Linux ou macOS:

export OPENAI_KEY=YOUR_OPENAI_KEY.Para uso em Windows:

set OPENAI_KEY=YOUR_OPENAI_KEY.Para obter mais informações sobre como obter e usar sua chave de API OpenAI, consulte a documentação da chave de API OpenAI.

Você pode então executar seu aplicativo localmente com:

hal9 run chatbot Este comando é apenas um wrapper conveniente para você mesmo executar o código com algo como python app.py .

O comando deploy preparará a implantação do seu aplicativo generativo.

Por exemplo, você pode preparar a implantação como um aplicativo generativo (Hal9). Temos planos de também fornecer implantação para Docker e a comunidade de código aberto pode expandir isso ainda mais.

hal9 deploy chatbot --target hal9 Cada comando tem a tarefa de preparar a implantação da pasta do seu projeto. Por exemplo, --target docker deve criar um arquivo Dockerfile que deixe este projeto pronto para ser executado em contêineres de nuvem.

Para uso pessoal, --target hal9 oferece suporte a um nível gratuito em hal9.com ; o suporte empresarial também está disponível para implantação com --target hal9 --url hal9.yourcompany.com