ChatBot chinês/chatbot chinês

- O autor transferiu-se integralmente para

Direção da rede neural do gráfico GNN O desenvolvimento em C++ não acompanhará mais a PNL e o código do projeto deixará de ser mantido. Quando o projeto Yuanxiang foi concluído, havia poucos recursos online. O autor entrou em contato com PNL e Deep Learning por capricho. Superando muitas dificuldades, ele finalmente escreveu este modelo de brinquedo. Portanto, o autor sabe que não é fácil para iniciantes, portanto, mesmo que o projeto não seja mais mantido, questões ou e-mails ([email protected]) serão respondidos em tempo hábil para ajudar os recém-chegados ao Deep Learning. (A versão do Tensorflow que uso é muito antiga. Se você executar a nova versão diretamente, certamente obterá vários erros. Se encontrar dificuldades, não se preocupe em instalar a versão antiga do ambiente. É recomendado usar Pytorch para reconstruí-lo de acordo com minha lógica de processamento. Tenho preguiça de escrever).

- Aspecto GNN:

- Um conjunto de modelos de comparação de benchmark: GNNs-Baseline foi adaptado e compilado para facilitar a verificação rápida de ideias.

- O código-fonte aberto do meu artigo ACMMM 2023 (CCF-A) está aqui LSTGM.

- O código-fonte aberto do meu artigo ICDM 2023 (CCF-B) ainda está sendo compilado. . . GRN

- Os bolsistas são bem-vindos para adicionar, comunicar e aprender.

Configuração do ambiente

| programa | Versão |

|---|

| píton | 3,68 |

| fluxo tensor | 1.13.1 |

| Keras | 2.2.4 |

| janelas10 | |

| Júpiter | |

Principais materiais de referência

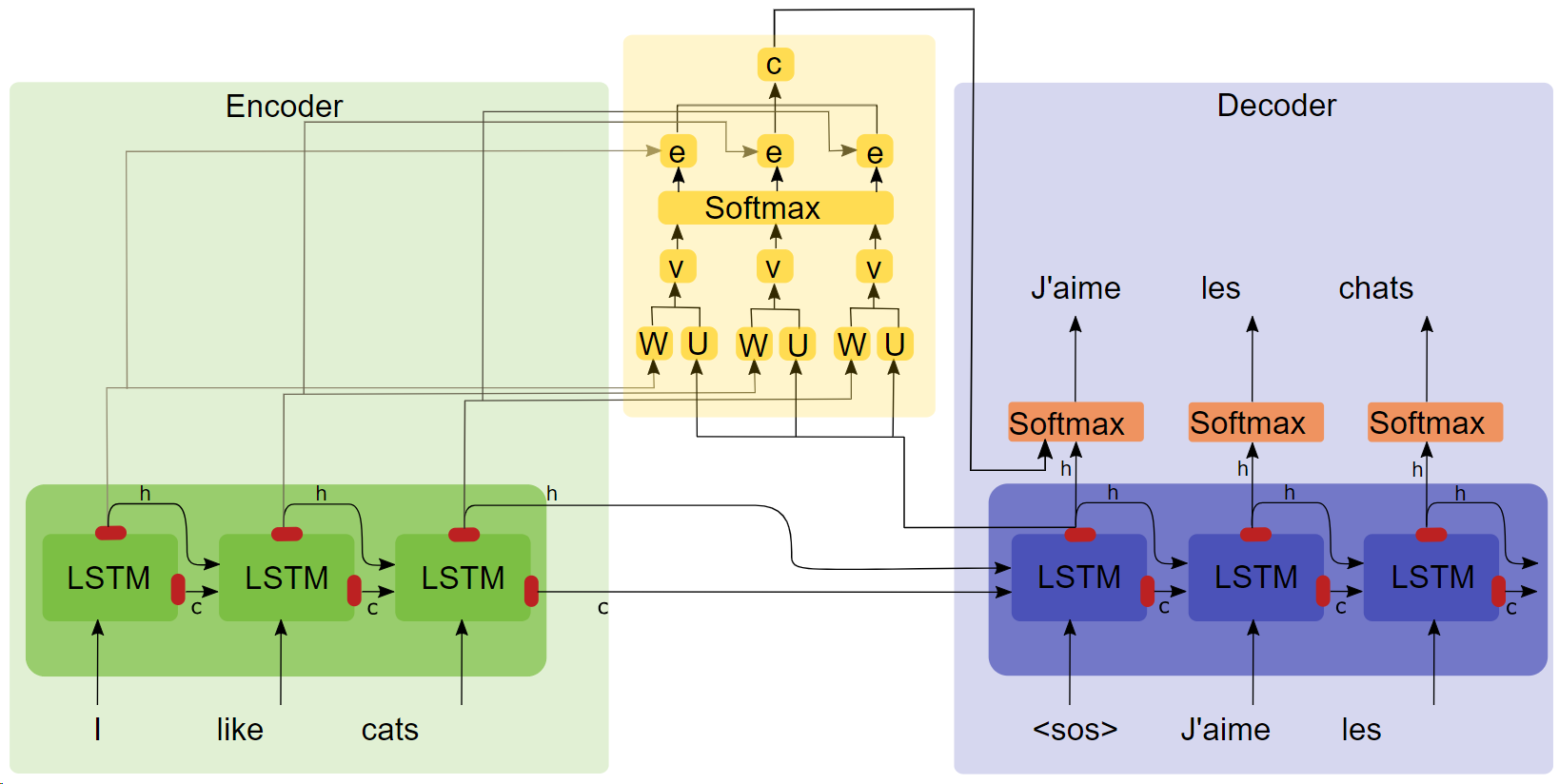

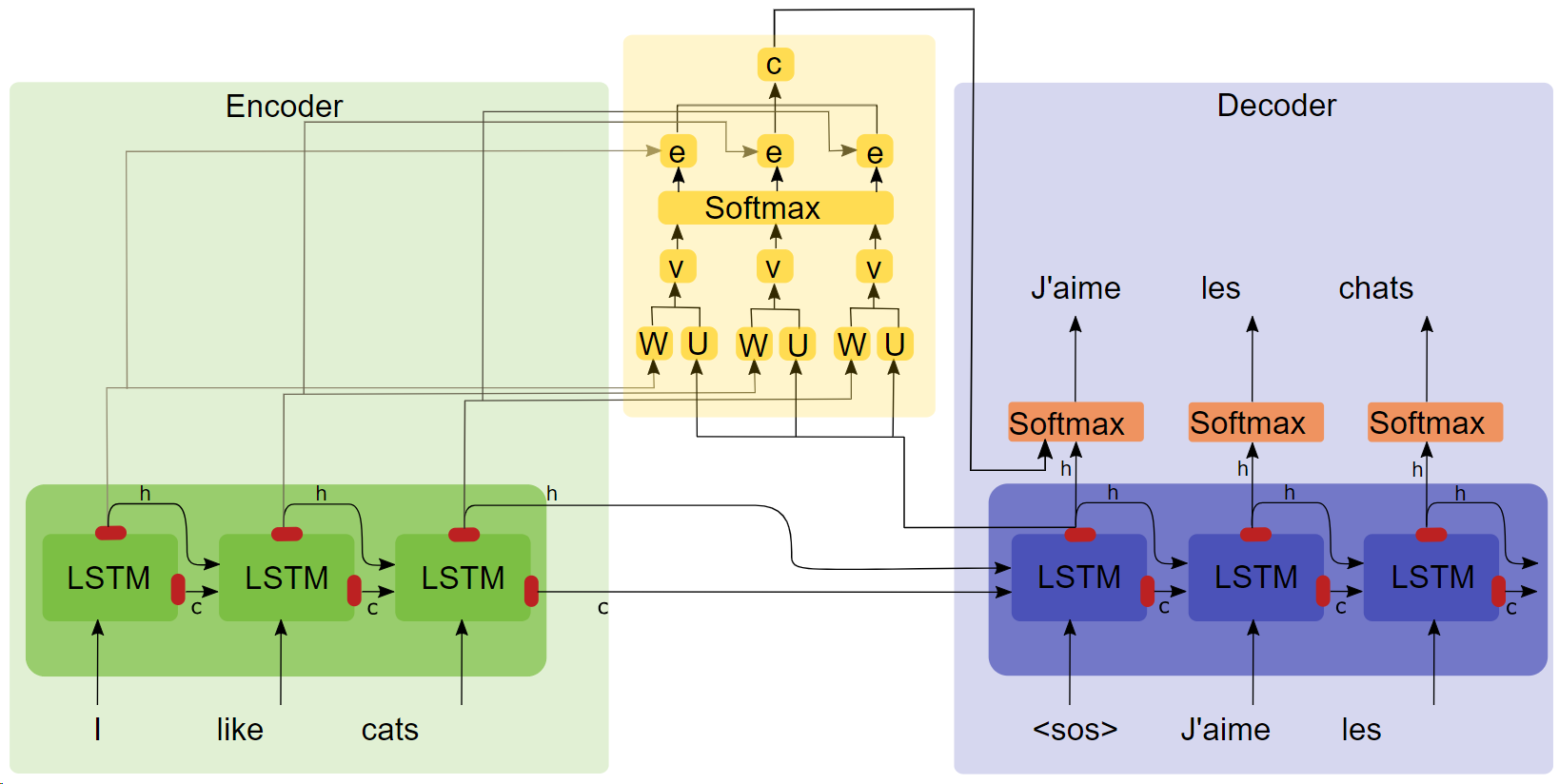

- Tese "TRADUÇÃO MÁQUINA NEURAL APRENDENDO EM CONJUNTO A ALINHAR E TRADUZIR ( Clique no título para fazer o download )"

- Diagrama de estrutura de atenção

Pontos-chave

- LSTM

- seq2seq

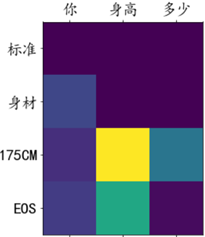

- Experimentos de atenção mostram que após adicionar o mecanismo de atenção, a velocidade de treinamento é mais rápida, a convergência é mais rápida e o efeito é melhor.

Corpus e ambiente de treinamento

100.000 grupos de diálogo do corpus Qingyun, treinados em colaboração com o Google.

correr

Método 1: processo completo

- Pré-processamento de dados

get_data

- Treinamento de modelo

chatbot_train (Esta é a versão montada no Google Colab, o caminho de execução local precisa ser ligeiramente modificado)

- Previsão do modelo

chatbot_inference_Attention

Método 2: carregar um modelo existente

- Execute

chatbot_inference_Attention

-

models/W--184-0.5949-.h5

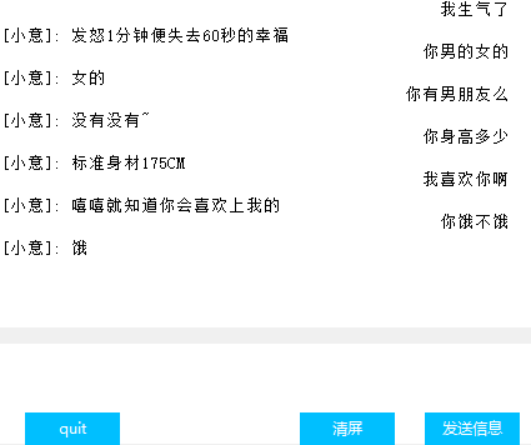

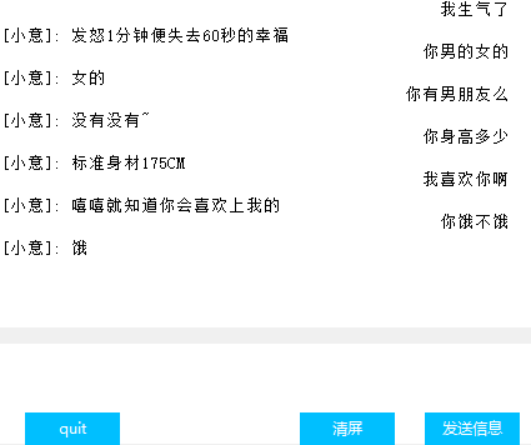

Interface(Tkinter)

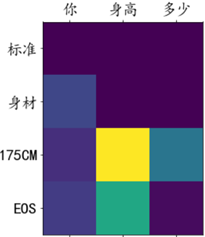

Visualização de peso de atenção

outro

- No arquivo de treinamento chat_bot, os dois primeiros dos três últimos blocos de código são usados para montar o Google Cloud Disk, e o último é usado para obter essas perdas para facilitar o desenho, não sei por que o tensorbord na função de retorno de chamada. não funciona, então criei esta estratégia;

- O penúltimo bloco de código no arquivo de previsão possui apenas entrada de texto, mas nenhuma interface. O último bloco de código é a interface. Um dos dois blocos pode ser executado imediatamente de acordo com as necessidades.

- Existem muitas saídas intermediárias no código, espero que ajude você a entender o código;

- Há um modelo que treinei em modelos. Não deve haver problemas na operação normal.

- O autor tem capacidade limitada e não encontrou um indicador para quantificar o efeito do diálogo, portanto a perda só pode refletir aproximadamente o progresso do treinamento.