Este é o repositório do projeto ChatPLUG, que visa construir e compartilhar um sistema chinês de diálogo de domínio aberto.

| 爱用emoji的萌妹子小婉 | 富有智慧的得道高僧 | 会说古文的的三国NPC关羽 |

|---|---|---|

|  |  |

Role-Play-Chat

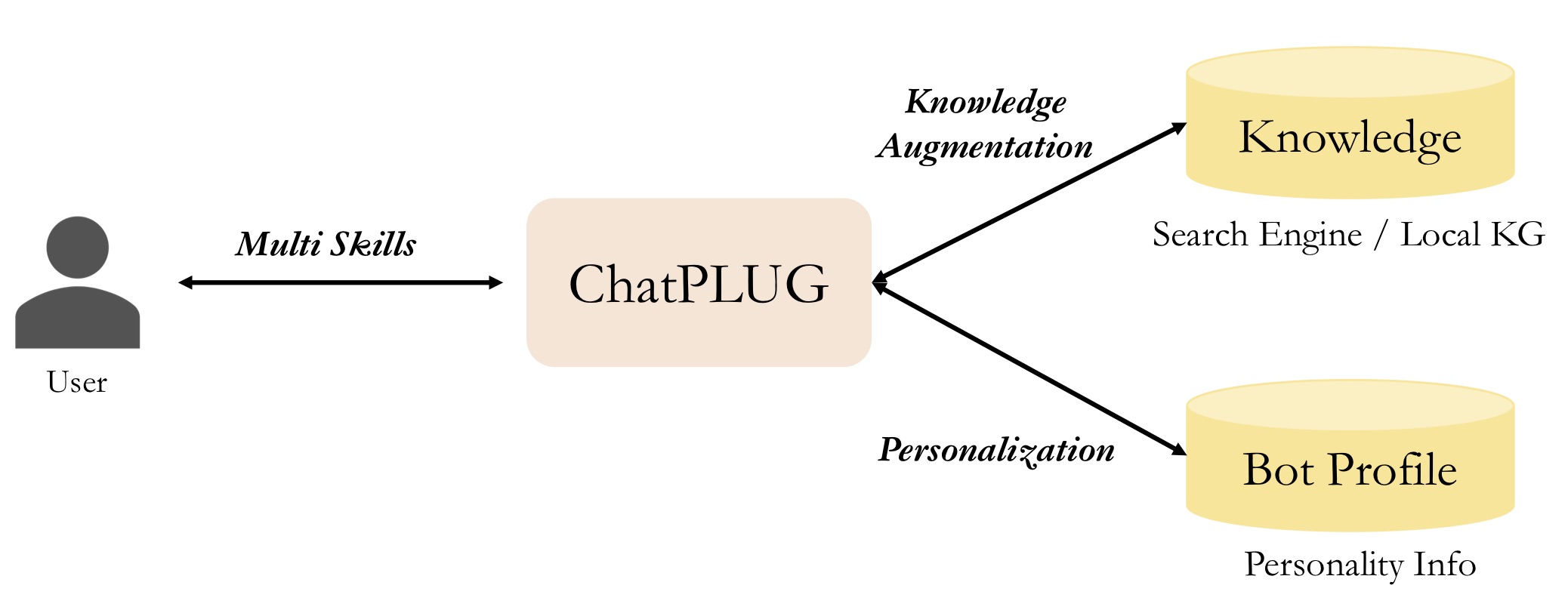

Em comparação com os modelos de código aberto existentes, destacamos três recursos do ChatPLUG como segue:

É flexível integrar conhecimento externo durante a inferência e esta é uma entrada opcional. Você pode utilizar um

search enginepara adquirir informações atualizadas ou usar uma base de conhecimento local para obter conhecimento do domínio.

É fácil personalizar o estilo das conversas e dos personagens definindo

bot profilesou usandorole-paly instructions.

Ele exibe sua proficiência em diálogo de domínio aberto por meio de conversas múltiplas, ao mesmo tempo que exibe impressionantes

multi-task abilitiesem uma ampla gama de tarefas de PNL.

Oferecemos três métodos para usar ou continuar desenvolvendo o ChatPLUG da seguinte forma:

| Começando | Inferência | Trem | Implantar | |

|---|---|---|---|---|

| ModelScope | Fácil | ✔️ Cli | Não está pronto | Não está pronto |

| Abraçando o rosto | Médio | ✔️ Cli | Não está pronto | Não está pronto |

| XDPX | Duro | ✔️ Cli | ✔️ Suporte | ✔️ Servindo |

Você pode baixar e usar modelos ChatPLUG do ModelScope.

| Nome do modelo | URL |

|---|---|

| Bate-papoPLUG-240M | ChatPLUG-开放域对话模型-240M |

| Bate-papoPLUG-3.7B | ChatPLUG-开放域对话模型-3.7B |

Em breve.

XDPX é uma biblioteca fácil de usar que permite que pesquisadores e desenvolvedores treinem modelos customizados e construam seus próprios chatbots de maneira simplificada. Sua funcionalidade completa permite uma solução completa que simplifica processos complexos. início rápido

Ao usar ChatPLUG-3.7B, você pode definir

core_chat_half_precision : truepara economizar memória.

# Requirement

# in the dir of XDPX

cd XDPX

pip install -e .

# Download checkpoints

# in the same dir as the download.sh

cd ..

sh download.sh

# Inference

# in the dir of XDPX

cd XDPX

CUDA_VISIBLE_DEVICES=0 x-script fidchat_new chat_pipeline/chatplug_3.7B_sftv2.6.0_instruction.hjson

# input `#exit` and exit the terminal Se sua GPU (por exemplo, A100, A10) suporta bf16, defina

deepspeed_bf16: trueedeepspeed_fp16: false, caso contrário, definadeepspeed_bf16: falseedeepspeed_fp16: true

# 1. Download dataset from belle

# in ChatPLUG/data/belle dir

cd data/belle

git lfs install

git clone https://huggingface.co/datasets/BelleGroup/train_0.5M_CN

python process_belle_0.5M.py

# $ls data/belle

# train_0.jsonl dev.jsonl ...

# 2. Preprocess Data

# in XDPX dir

x-prepro chat_pipeline/chatplug_prepro_sft_instruction.hjson

# $ls data/dialogue/sft/chatplug/belle_instruction

# train_0.pt dev.pt

# 3. Training

# in XDPX dir

x-train chat_pipeline/chatplug_3.7B_train_sftv2.6.0_instruction.hjsonEm breve.

Consulte Instalação para obter instruções de instalação.

Para guias do usuário detalhados, consulte nossa documentação:

Guias do usuário

Guias Avançados

Se você achar nosso projeto útil em seu trabalho, cite:

@misc{tian2023chatplug,

title={ChatPLUG: Open-Domain Generative Dialogue System with Internet-Augmented Instruction Tuning for Digital Human},

author={Junfeng Tian and Hehong Chen and Guohai Xu and Ming Yan and Xing Gao and Jianhai Zhang and Chenliang Li and Jiayi Liu and Wenshen Xu and Haiyang Xu and Qi Qian and Wei Wang and Qinghao Ye and Jiejing Zhang and Ji Zhang and Fei Huang and Jingren Zhou},

year={2023},

eprint={2304.07849},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

@misc{plug2021,

title = {{PLUG: Pre-training for Language Understanding and Generation}},

author={ModelScope},

publisher = {ModelScope},

journal = {ModelScope repository},

year = {2021},

howpublished = {url{https://modelscope.cn/models/damo/nlp_plug_text-generation_27B/summary}},

}

Este código está licenciado sob a licença Apache (versão 2.0).