Suporta saída de streaming de alta velocidade, suporta pesquisa de superrede Secret Tower AI (rede completa ou acadêmica e três modos de conciso, aprofundado e pesquisa), implantação de configuração zero e suporte a token multicanal.

Totalmente compatível com interface ChatGPT.

Há também as seguintes oito APIs gratuitas às quais você deve prestar atenção:

Interface Moonshot AI (Kimi.ai) para API kimi-free-api

Interface StepChat para API step-free-api

Interface Zhipu AI (Zhipu Qingyan) para API glm-free-api

Interface Alibaba Tongyi (Qwen) para API qwen-free-api

Interface Iflytek Spark para API spark-free-api

Interface MiniMax (Conch AI) para API hailuo-free-api

Interface DeepSeek para API deepseek-free-api

Interface de Listening Intelligence (Emohaa) para API emohaa-free-api

A API reversa é instável. Recomenda-se usar o Metaso AI oficial https://metaso.cn/ para evitar o risco de ser banido.

Esta organização e indivíduos não aceitam quaisquer doações ou transações financeiras. Este projeto é puramente para pesquisa, intercâmbio e aprendizagem!

É apenas para uso pessoal, sendo proibida a prestação de serviços externos ou uso comercial para evitar pressão sobre o serviço oficial, caso contrário é por sua conta e risco!

É apenas para uso pessoal, sendo proibida a prestação de serviços externos ou uso comercial para evitar pressão sobre o serviço oficial, caso contrário é por sua conta e risco!

É apenas para uso pessoal, sendo proibida a prestação de serviços externos ou uso comercial para evitar pressão sobre o serviço oficial, caso contrário é por sua conta e risco!

Este link é apenas uma função de teste temporária. Se você encontrar uma exceção, tente novamente mais tarde. É recomendável implantá-lo você mesmo.

https://udify.app/chat/46rRHl5xoVa4m1lo

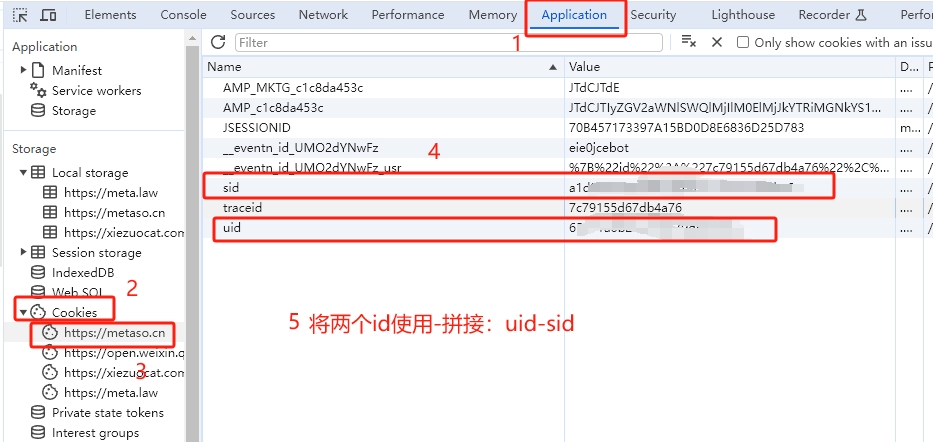

Obtenha uid e sid da pesquisa Secret Tower AI e use - :

Entre na pesquisa Secret Tower AI, faça login em sua conta ( recomenda-se fazer login em sua conta, caso contrário você pode encontrar restrições estranhas ), em seguida, abra as ferramentas do desenvolvedor com F12 e encontre uid e sid em Aplicativo> Biscoitos.

Junte uid e sid: uid-sid , como 65e91a6b2bac5b600dd8526a-5e7acc465b114236a8d9de26c9f41846 .

Isso servirá como o valor do Bearer Token para Autorização: Authorization: Bearer uid-sid

Nota: Atualmente, suspeita-se que a Secret Tower tenha um limite no número total de pesquisas por endereços IP. Recomenda-se aderir à rotação de IP.

Você pode fornecer o uid-sid de várias contas , usá-las juntas para fornecer:

Authorization: Bearer uid-sid1,uid-sid2,uid-sid3

Um deles será selecionado cada vez que o serviço for solicitado.

Prepare um servidor com IP público e porta aberta 8000.

Extraia a imagem e inicie o serviço

docker run -it -d --init --name metaso-free-api -p 8000:8000 -e TZ=Asia/Shanghai vinlic/metaso-free-api:latestVisualize logs de serviço em tempo real

docker logs -f metaso-free-apiReiniciar serviço

docker restart metaso-free-apiInterromper serviço

docker stop metaso-free-api version : ' 3 '

services :

metaso-free-api :

container_name : metaso-free-api

image : vinlic/metaso-free-api:latest

restart : always

ports :

- " 8000:8000 "

environment :

- TZ=Asia/Shanghai

labels :

- vinlic.scope.metaso=metaso

watchtower :

image : containrrr/watchtower

restart : unless-stopped

command :

--cleanup

--scope metaso

--interval 600

--include-restarting

# 可以配置通知地址,具体支持列表请查看:https://containrrr.dev/shoutrrr/v0.8/services/overview/

# --notification-url="bark://{填入bark的token}@api.day.app/{填入bark的token}/metaso-image-just-updated?title=Notification"

volumes :

- /var/run/docker.sock:/var/run/docker.sockNota: Algumas áreas de implantação podem não conseguir se conectar ao metaso. Se o log do contêiner mostrar um tempo limite de solicitação ou não puder ser conectado, mude para outras áreas para implantação. Nota: A instância do contêiner da conta gratuita irá parar automaticamente de funcionar após um período de inatividade, o que causará um atraso de 50 segundos ou mais na próxima solicitação. É recomendado marcar Render container keep alive.

Bifurque este projeto para sua conta do github.

Visite Render e faça login em sua conta do github.

Crie seu serviço Web (Novo+ -> Construa e implante a partir de um repositório Git -> Conecte seu projeto bifurcado -> Selecione a área de implantação -> Selecione o tipo de instância como Gratuito -> Criar serviço Web).

Após a conclusão da construção, copie o nome de domínio atribuído e divida o URL para acesso.

Nota: O tempo limite de resposta da solicitação para contas gratuitas Vercel é de 10 segundos, mas a resposta da interface geralmente leva mais tempo e você pode encontrar um erro de tempo limite 504 retornado pelo Vercel!

Certifique-se de ter instalado o ambiente Node.js primeiro.

npm i -g vercel --registry http://registry.npmmirror.com

vercel login

git clone https://github.com/LLM-Red-Team/metaso-free-api

cd metaso-free-api

vercel --prodPrepare um servidor com IP público e porta aberta 8000.

Instale o ambiente Node.js e configure as variáveis de ambiente primeiro e confirme se o comando node está disponível.

Instalar dependências

npm iInstale PM2 para proteção de processo

npm i -g pm2Compile e construa. Quando você vir o diretório dist, a compilação estará concluída.

npm run buildIniciar serviço

pm2 start dist/index.js --name " metaso-free-api "Visualize logs de serviço em tempo real

pm2 logs metaso-free-apiReiniciar serviço

pm2 reload metaso-free-apiInterromper serviço

pm2 stop metaso-free-apiÉ mais rápido e fácil usar o seguinte cliente de desenvolvimento secundário para acessar os projetos da série free-api e suporta upload de documentos/imagens!

LobeChat desenvolvido por Clivia https://github.com/Yanyutin753/lobe-chat

ChatGPT Web https://github.com/SuYxh/chatgpt-web-sea desenvolvido por Guangguang@

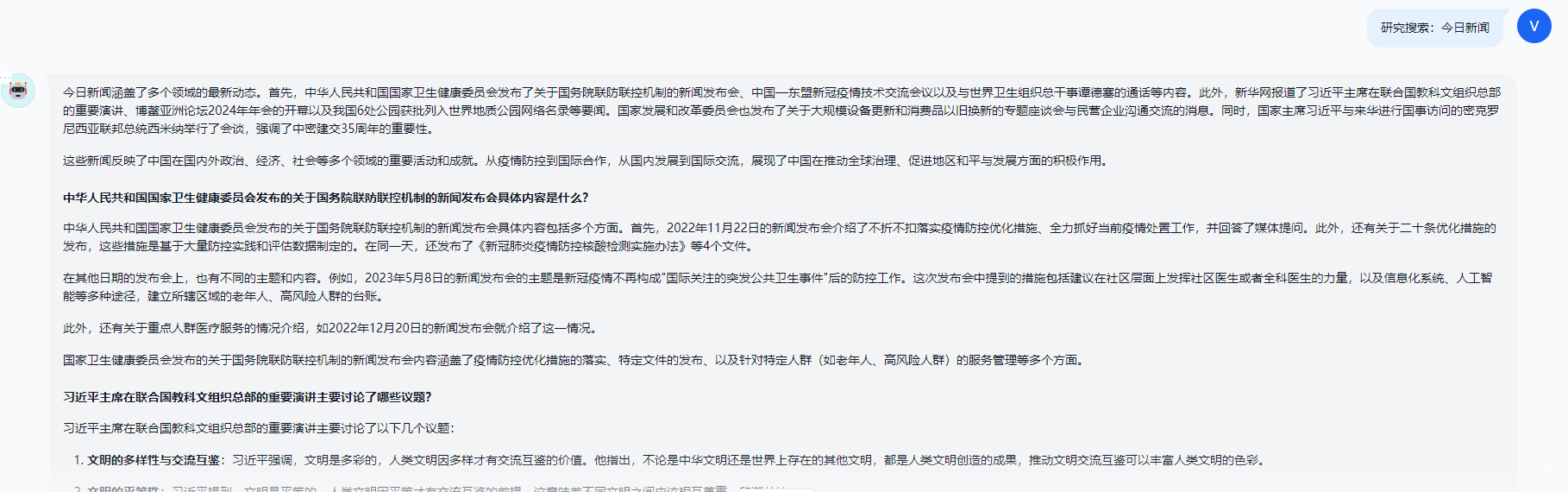

Atualmente, ele suporta a interface /v1/chat/completions compatível com openai. Você pode usar a interface de acesso do cliente compatível com openai ou outros clientes, ou usar serviços online como dify para acessá-la.

Interface de conclusão de conversa, compatível com chat-completions-api do openai.

POST /v1/chat/completions

header precisa definir o cabeçalho de autorização:

Authorization: Bearer [token]

Dados da solicitação:

{

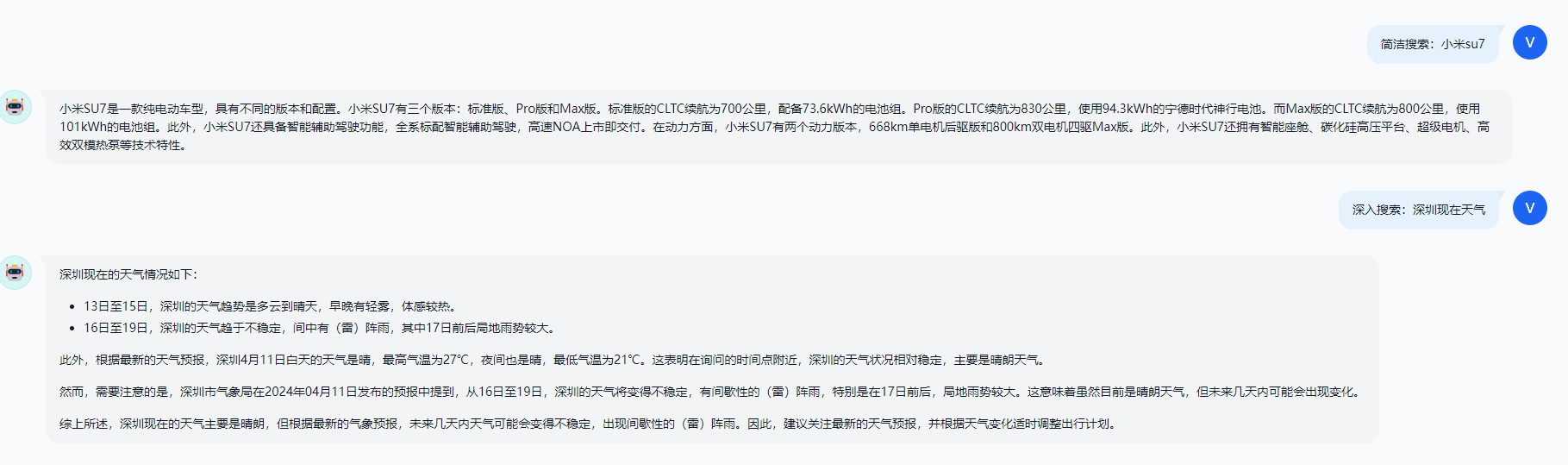

// 全网model名称支持 -> 简洁:concise / 深入:detail / 研究:research

// 学术model名称支持 -> 学术-简洁:concise-scholar / 学术-深入:detail-scholar / 学术-研究:research-scholar

// model乱填的话,可以通过tempature参数来控制(但不支持学术):简洁:< 0.4 / 深入:>= 0.4 && < 0.7 / 研究:>= 0.7

// model乱填的话,还可以通过消息内容包含指令来控制:↓↓↓

// 简洁 -> 简洁搜索小米su7 / 深入 -> 深入搜索小米su7 / 研究 -> 研究搜索小米su7

// 学术-简洁 -> 学术简洁搜索:小米su7 / 学术-深入 -> 学术深入搜索小米su7 / 学术研究 -> 学术研究搜索小米su7

// 优先级:model > 消息内容指令 > tempature

"model" : " concise " ,

"messages" : [

{

"role" : " user " ,

"content" : "秘塔AI "

}

],

// 如果使用SSE流请设置为true,默认false

"stream" : false

}Dados de resposta:

{

"id" : " 8466827997659213824 " ,

"model" : " concise " ,

"object" : " chat.completion " ,

"choices" : [

{

"index" : 0 ,

"message" : {

"role" : " assistant " ,

"content" : "秘塔AI搜索是上海秘塔网络科技有限公司在2024年初推出的一款新产品,被誉为中国版Perplexity。它利用自研的大模型MetaLLM,能够直接对用户的提问进行理解和回答,提供结构化、准确、直接的搜索结果,并明确列出来源参考,无需科学上网,解决了语言理解上的误差[[1]]。秘塔AI搜索通过其强大的语义理解能力和全网搜索功能,为用户提供了一个高效、无广告、信息丰富的搜索体验[[2]]。此外,秘塔AI搜索的特点包括没有广告,直达结果;结构化信息展示;以及信息来源追溯,为每条搜索结果提供了来源链接,用户可以轻松溯源验证信息的出处和可靠性[[4]]。秘塔科技成立于2018年4月,是一家新锐科技公司,致力于运用AI技术赋能专业场景,进行技术研发与产品落地[[3]]。 n "

},

"finish_reason" : " stop "

}

],

"usage" : {

"prompt_tokens" : 1 ,

"completion_tokens" : 1 ,

"total_tokens" : 2

},

"created" : 1712859314

}Verifique se o token está ativo. Se alive não for verdadeiro, caso contrário é falso. Por favor, não chame esta interface com frequência (menos de 10 minutos).

POST /token/cheque

Dados da solicitação:

{

"token" : " 65e91a6b2bac5b600dd8526a-5e7acc465b114236a8d9de26c9f41846 "

}Dados de resposta:

{

"live" : true

}Se você estiver usando o proxy reverso Nginx metaso-free-api, adicione os seguintes itens de configuração para otimizar o efeito de saída do fluxo e otimizar a experiência.

# 关闭代理缓冲。当设置为off时,Nginx会立即将客户端请求发送到后端服务器,并立即将从后端服务器接收到的响应发送回客户端。

proxy_buffering off ;

# 启用分块传输编码。分块传输编码允许服务器为动态生成的内容分块发送数据,而不需要预先知道内容的大小。

chunked_transfer_encoding on ;

# 开启TCP_NOPUSH,这告诉Nginx在数据包发送到客户端之前,尽可能地发送数据。这通常在sendfile使用时配合使用,可以提高网络效率。

tcp_nopush on ;

# 开启TCP_NODELAY,这告诉Nginx不延迟发送数据,立即发送小数据包。在某些情况下,这可以减少网络的延迟。

tcp_nodelay on ;

# 设置保持连接的超时时间,这里设置为120秒。如果在这段时间内,客户端和服务器之间没有进一步的通信,连接将被关闭。

keepalive_timeout 120 ;Como o lado da inferência não está em metaso-free-api, o token não pode ser contado e será retornado como um número fixo.