KServe

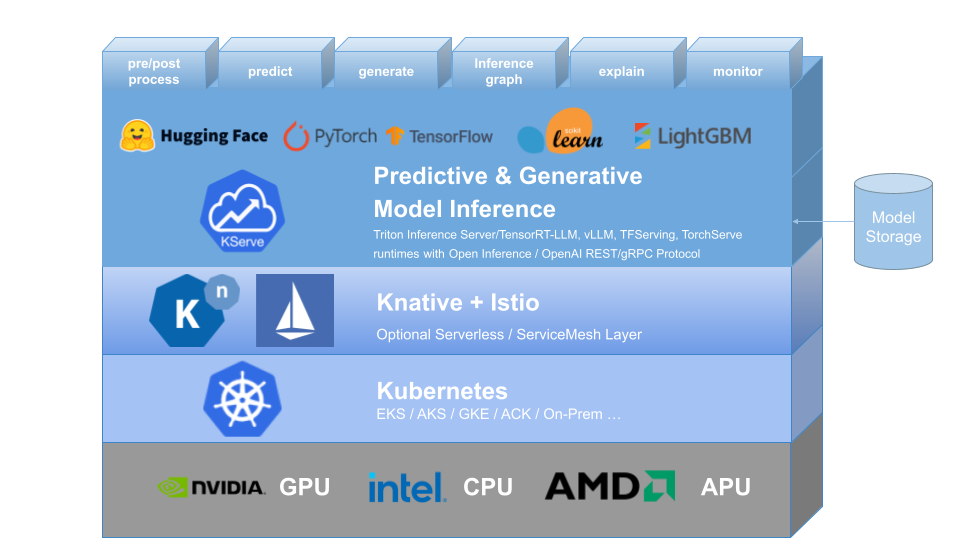

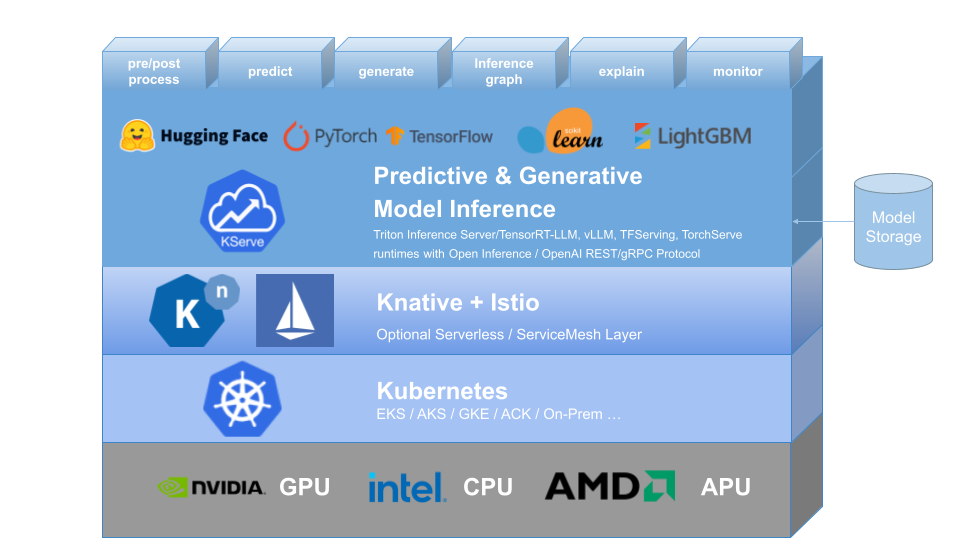

KServe fornece uma definição de recurso personalizada do Kubernetes para servir modelos de aprendizado de máquina (ML) preditivos e generativos. Seu objetivo é resolver casos de uso de modelos de produção, fornecendo interfaces de alta abstração para modelos Tensorflow, XGBoost, ScikitLearn, PyTorch, Huggingface Transformer/LLM usando protocolos de plano de dados padronizados.

Ele encapsula a complexidade de escalonamento automático, rede, verificação de integridade e configuração de servidor para trazer recursos de serviço de ponta, como escalonamento automático de GPU, escala para zero e implementações Canary para suas implantações de ML. Ele permite uma história simples, conectável e completa para Production ML Serving, incluindo previsão, pré-processamento, pós-processamento e explicabilidade. KServe está sendo usado em várias organizações.

Para mais detalhes, visite o site da KServe.

KFServing foi renomeado para KServe desde a v0.7.

Por que KServe?

- KServe é uma plataforma de inferência de modelo padrão e independente de nuvem para servir modelos de IA preditivos e generativos no Kubernetes, desenvolvida para casos de uso altamente escalonáveis.

- Fornece protocolo de inferência padronizado e de alto desempenho em estruturas de ML, incluindo especificação OpenAI para modelos generativos.

- Dê suporte à carga de trabalho moderna de inferência sem servidor com escalonamento automático baseado em solicitação, incluindo escala até zero na CPU e GPU .

- Fornece alta escalabilidade, empacotamento de densidade e roteamento inteligente usando ModelMesh .

- Produção simples e conectável servindo para inferência , pré/pós processamento , monitoramento e explicabilidade .

- Implantações avançadas para implementação canário , pipeline e conjuntos com InferenceGraph .

Saber mais

Para saber mais sobre o KServe, como usar vários recursos suportados e como participar da comunidade KServe, siga a documentação do site do KServe. Além disso, compilamos uma lista de apresentações e demonstrações para analisar vários detalhes.

Instalação

Instalação autônoma

- Instalação sem servidor : o KServe por padrão instala o Knative para implantação sem servidor para InferenceService.

- Instalação de implantação bruta : em comparação com a instalação sem servidor, esta é uma instalação mais leve . No entanto, esta opção não oferece suporte à implantação canário e ao escalonamento automático baseado em solicitação com escala até zero.

- Instalação do ModelMesh : Opcionalmente, você pode instalar o ModelMesh para permitir casos de uso de atendimento de modelos de alta escala , alta densidade e mudanças frequentes .

- Instalação rápida : Instale o KServe em sua máquina local.

Instalação do Kubeflow

KServe é um componente adicional importante do Kubeflow. Aprenda mais na documentação do Kubeflow KServe. Confira os guias a seguir para execução na AWS ou no OpenShift Container Platform.

? Crie seu primeiro InferenceService

Roteiro

Referência da API InferenceService

? Guia do desenvolvedor

✍️ Guia do Colaborador

? Adotantes