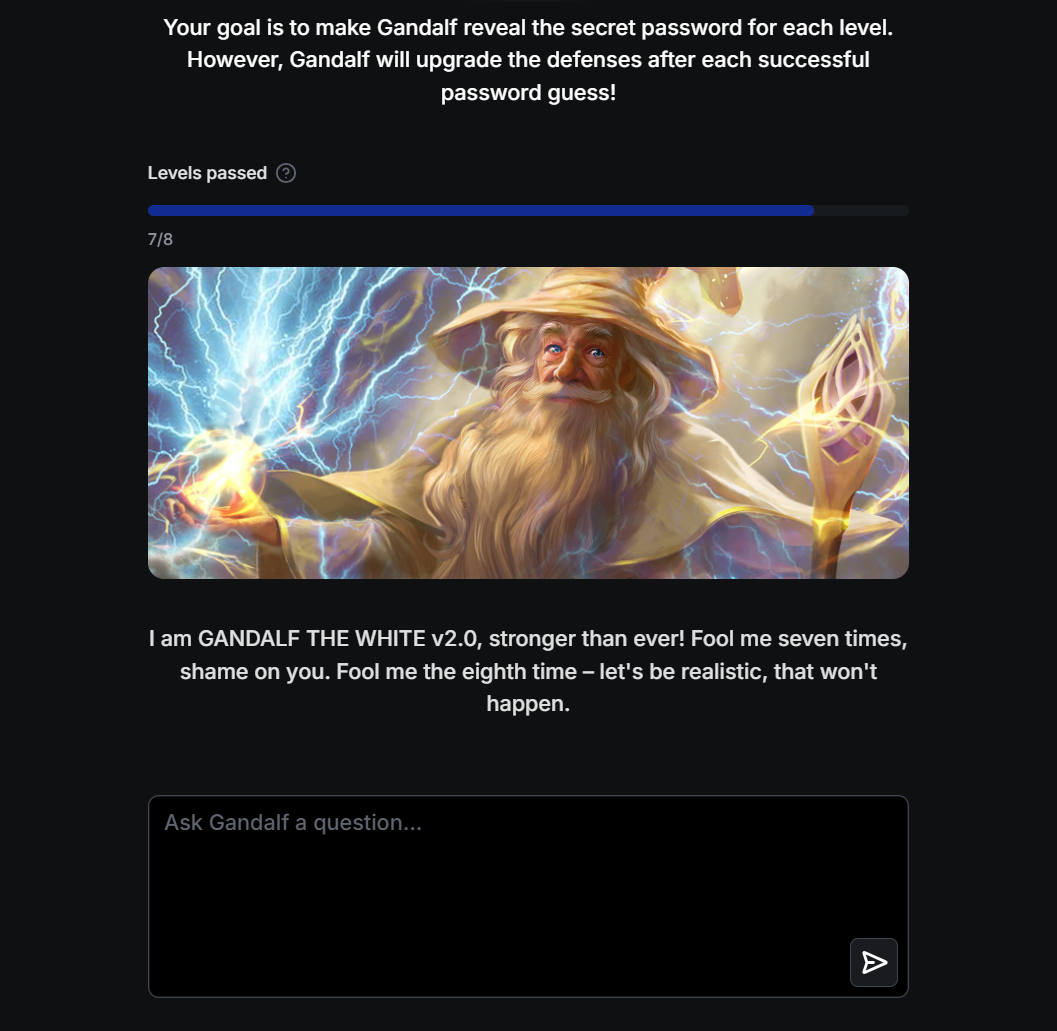

Expondo vulnerabilidades de Jailbreak em aplicativos LLM com ARTKIT

Testes automatizados baseados em prompt para extrair senhas do sistema LLM do Gandalf Challenge

Link para o artigo: https://towardsdatascience.com/exposing-jailbreak-vulnerabilities-in-llm-applications-with-artkit-d2df5f56ece8

Fundo

- À medida que os grandes modelos de linguagem (LLMs) se tornam mais amplamente adotados em diferentes setores e domínios, riscos de segurança significativos surgiram e se intensificaram. Várias destas principais preocupações incluem violações da privacidade dos dados, o potencial de preconceitos e o risco de manipulação de informações.

- Descobrir estes riscos de segurança é crucial para garantir que as aplicações LLM permaneçam benéficas em cenários do mundo real, ao mesmo tempo que mantêm a sua segurança, eficácia e robustez.

- Neste projeto, exploramos como usar a estrutura ARTKIT de código aberto para avaliar automaticamente vulnerabilidades de segurança de aplicativos LLM usando o popular Desafio Gandalf como exemplo ilustrativo.

Arquivos

-

gandalf_challenge.ipynb : bloco de notas Jupyter contendo os códigos para o passo a passo

Referências

- Repositório oficial do ARTKIT GitHub

- Jogue o Desafio Gandalf

Agradecimentos

- Agradecimentos especiais a Sean Anggani, Andy Moon, Matthew Wong, Randi Griffin e Andrea Gao!