Este projeto ponta a ponta que simplifica o ciclo de vida de aplicativos Large Language Model (LLM), incluindo desenvolvimento, produção e implantação. O repositório contém pastas e arquivos como componentes do projeto, como agentes, APIs, cadeias, chatbots, GROQ (uma linguagem de consulta), modelos Hugging Face, ObjectBox (um banco de dados incorporado), modelos OpenAI e Retrieval-Augmented Generation (RAG). ). O projeto visa fornecer uma solução abrangente para trabalhar com LLMs, abrangendo tratamento de dados, desenvolvimento de chatbot e integração com diversas ferramentas e frameworks.

Este projeto demonstra a criação de um chatbot usando modelos de linguagem em larga escala (LLMs) pagos e de código aberto via Langchain e Ollama. Abrange todo o ciclo de vida dos aplicativos LLM, incluindo desenvolvimento, produção e implantação.

Sim. Todas as APIs são secretas, com acesso restrito do usuário e .gitignore anônimo e outra camada de segurança através dos ambientes secretos do Github (desculpe! você terá que usar o seu próprio!)

conda create -p venv python==3.10 -y

venv S cripts a ctivate

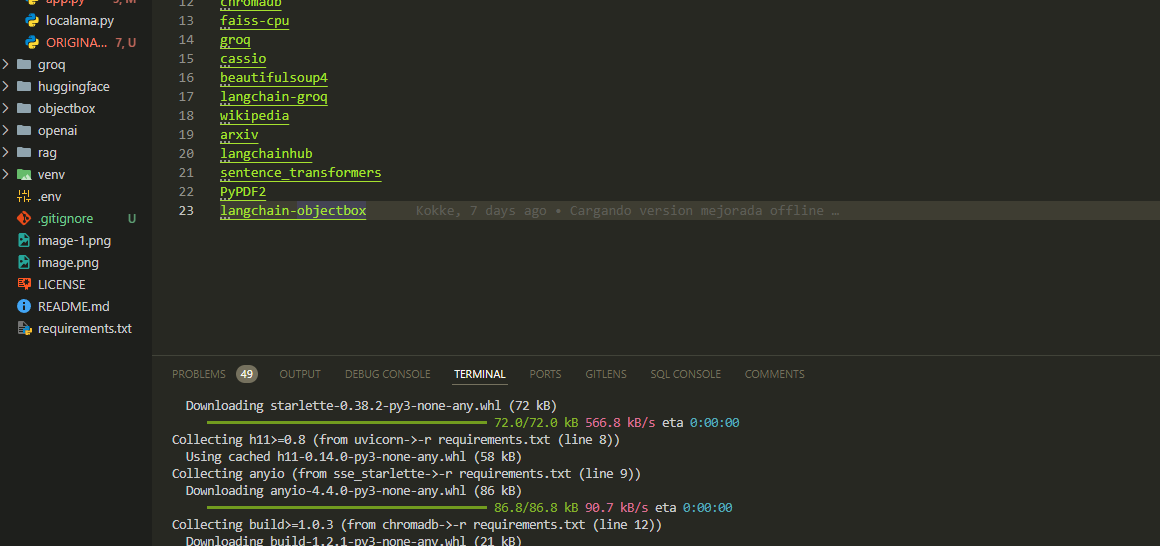

pip install -r requirements.txt Configure as chaves e configurações de API necessárias no arquivo app.py

python app.pyAbra um navegador da web e navegue até (ou a porta progressiva atribuída em seu computador). o meu é esse:

http://localhost:8502Criamos o arquivo chamando as 3 principais funções encadeadas do nosso chatbot base.

Carregamos requisitos para módulos e bibliotecas:

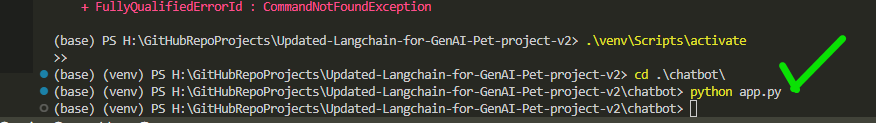

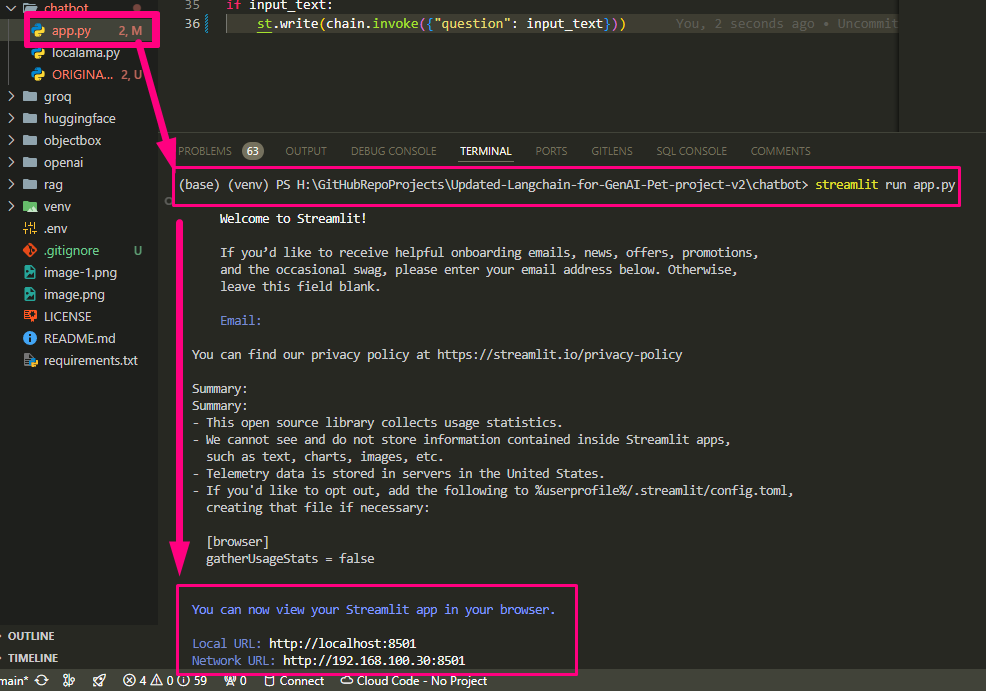

Executamos nosso app.py

Terminamos de configurar app.py e executamos

Ele retorna a rota e abre o host no navegador de teste

Local URL: http://localhost:8502

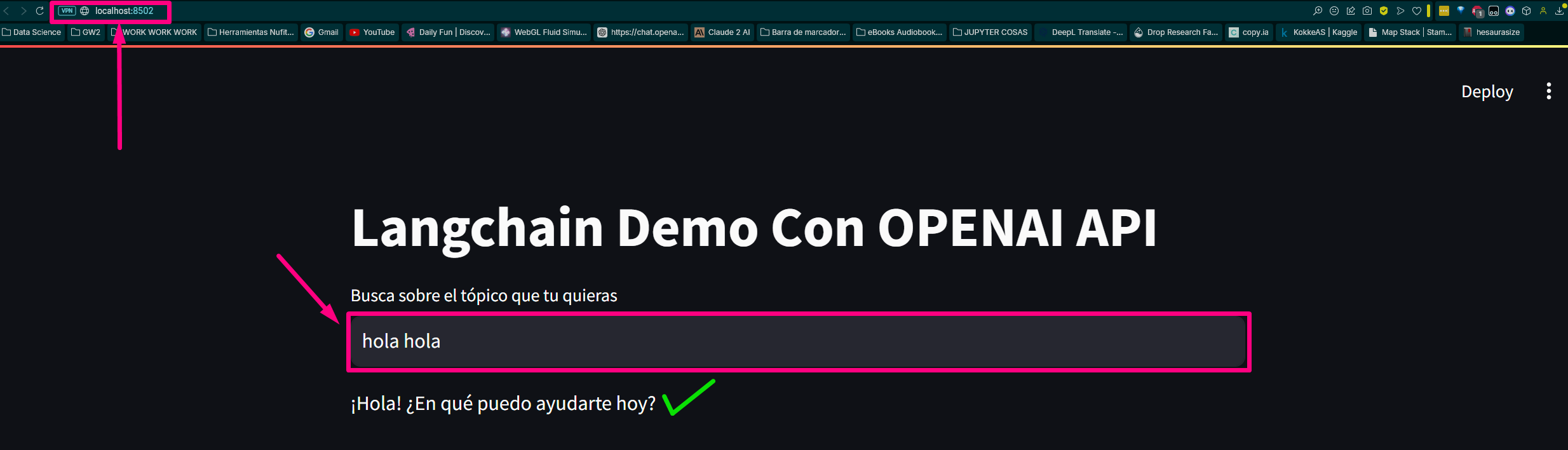

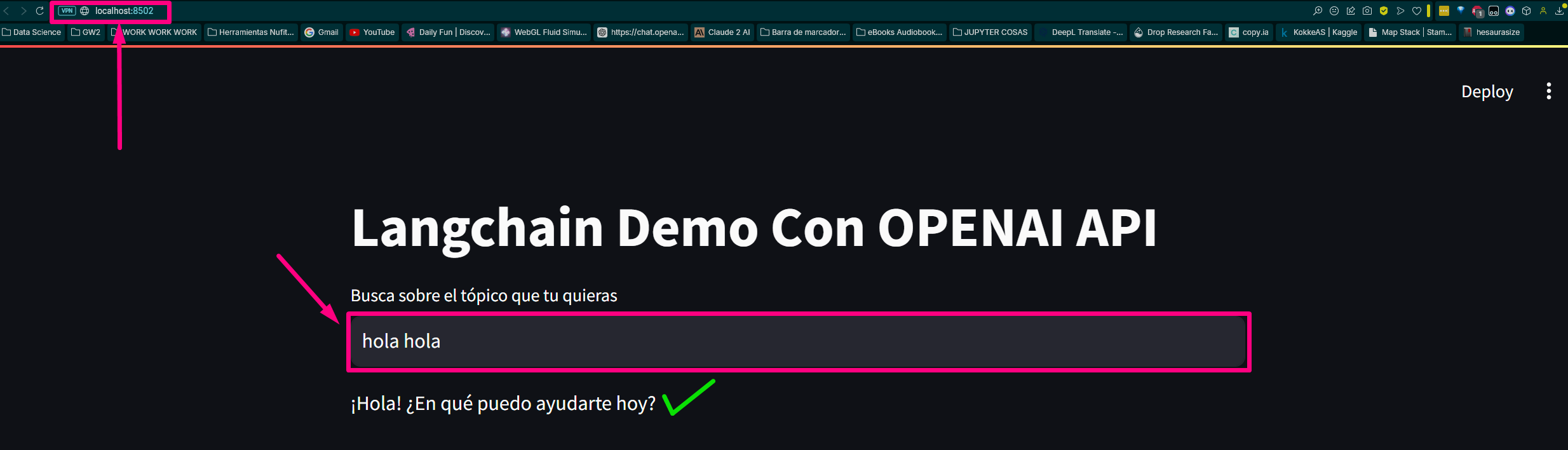

Network URL: http://192.168.100.30:8502 Vamos verificar a página:

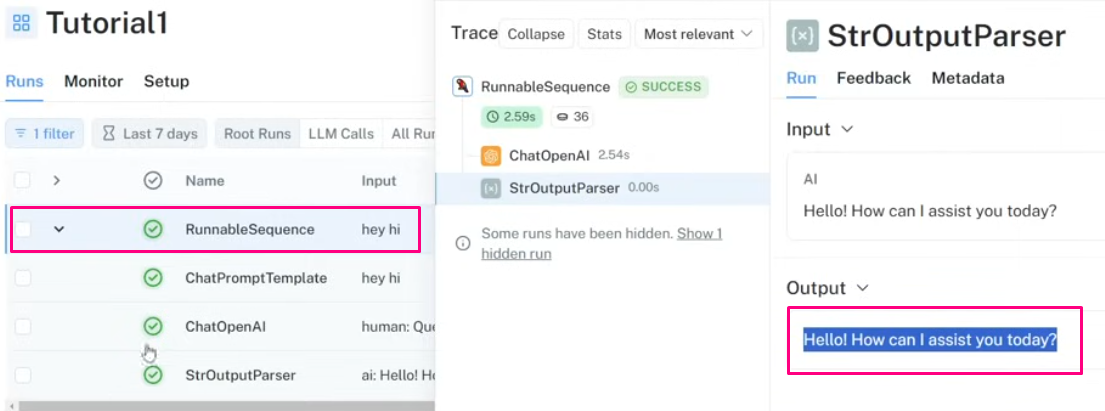

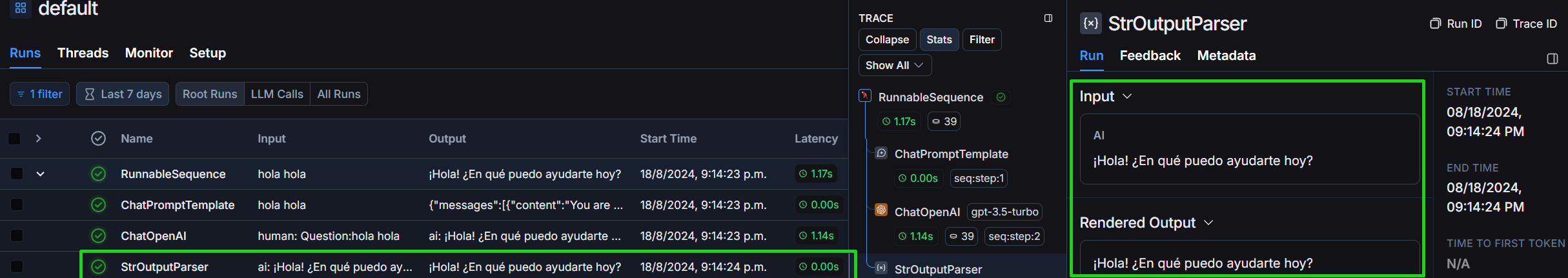

Vamos revisar o projeto na estrutura Langchain:

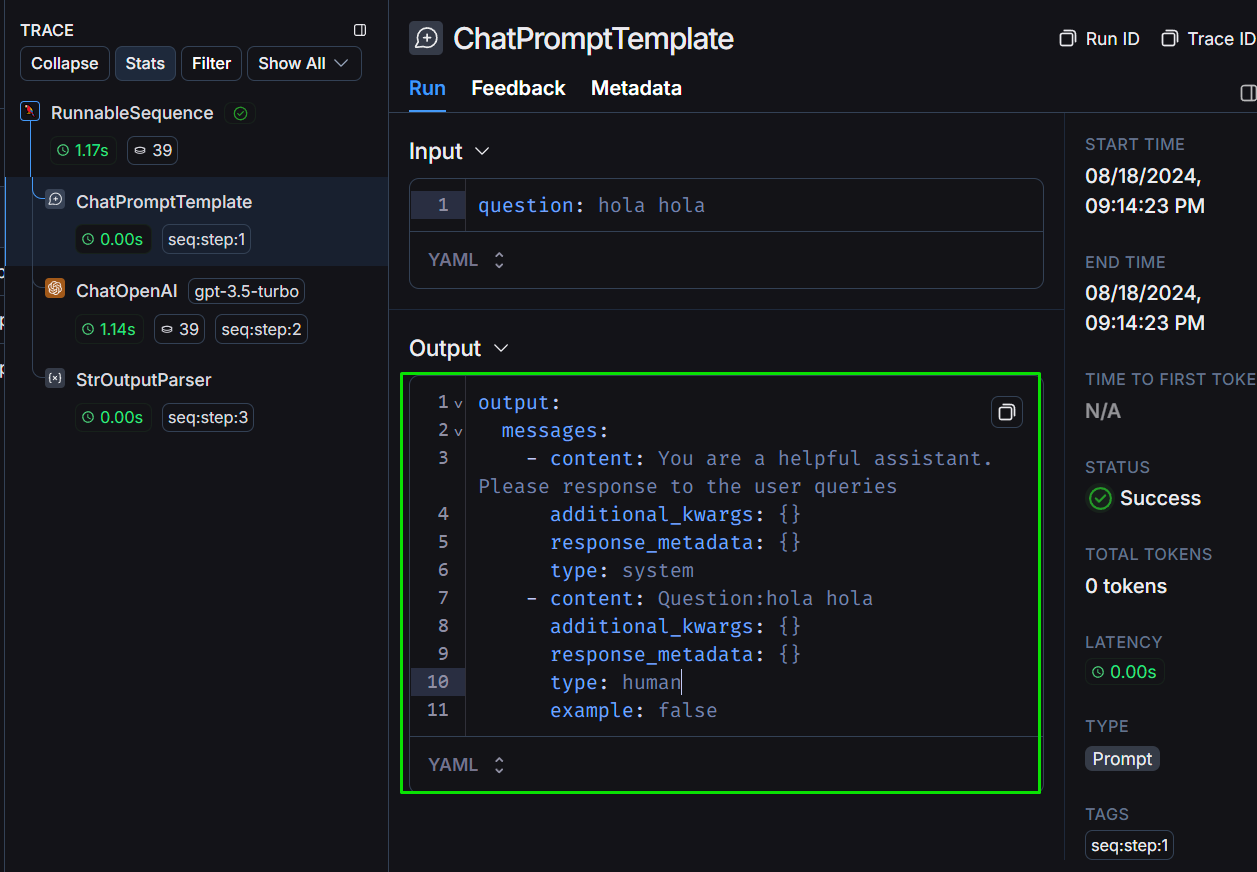

Vejamos a estrutura da saída conforme a definimos:

Vemos o StrOutputParser em detalhes:

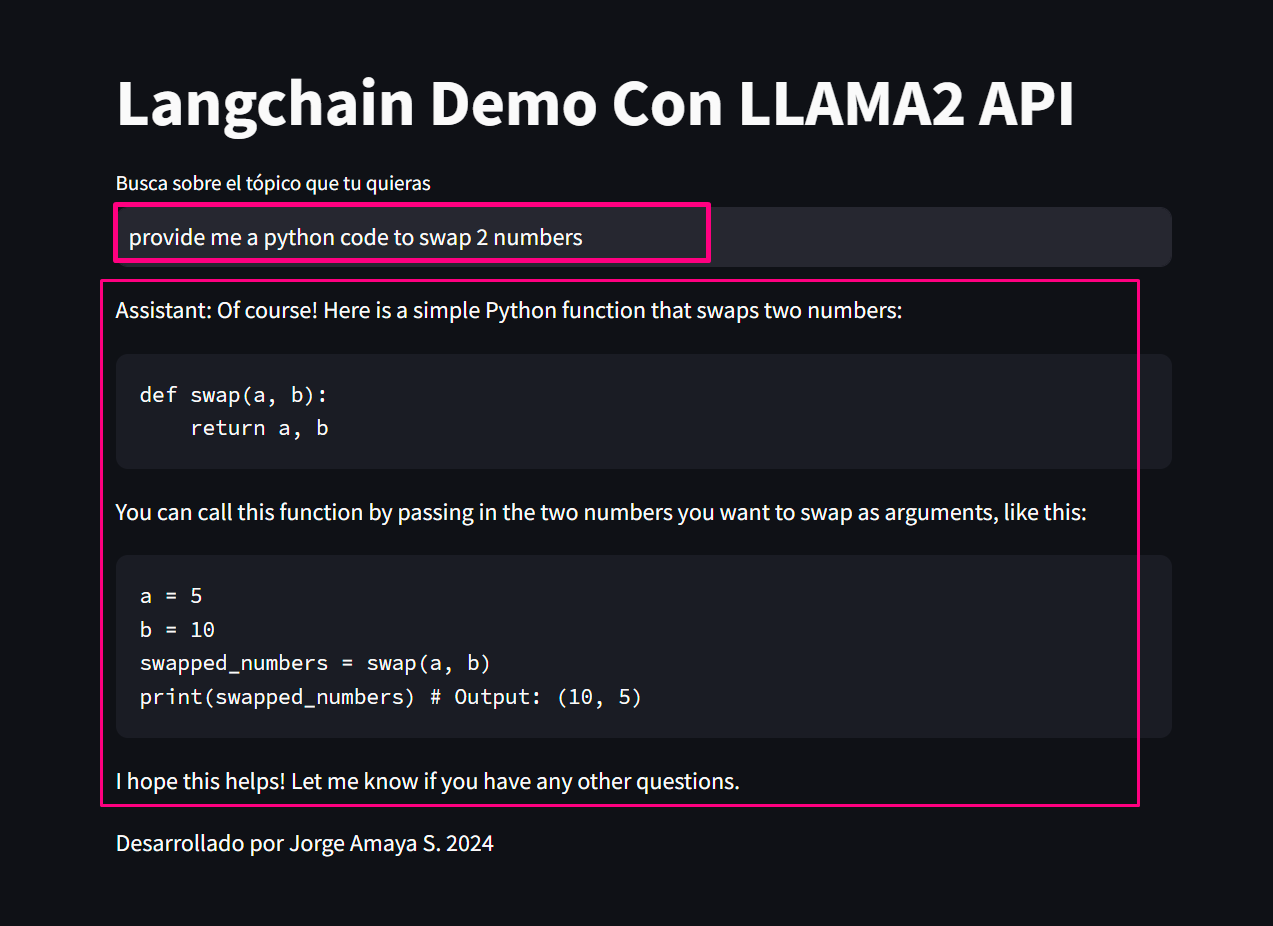

Perguntaremos sobre “fornecer código python que troque dois valores” para avaliar custo, tokenização e tempo de atraso para resolver a questão:

*proveeme de un código python que swapee 2 valores.* :

# Definir los dos valores a intercambiar

a = 5

b = 10

print ( "Valores originales:" )

print ( "a =" , a )

print ( "b =" , b )

# Intercambiar los valores

temp = a

a = b

b = temp

print ( " n Valores intercambiados:" )

print ( "a =" , a )

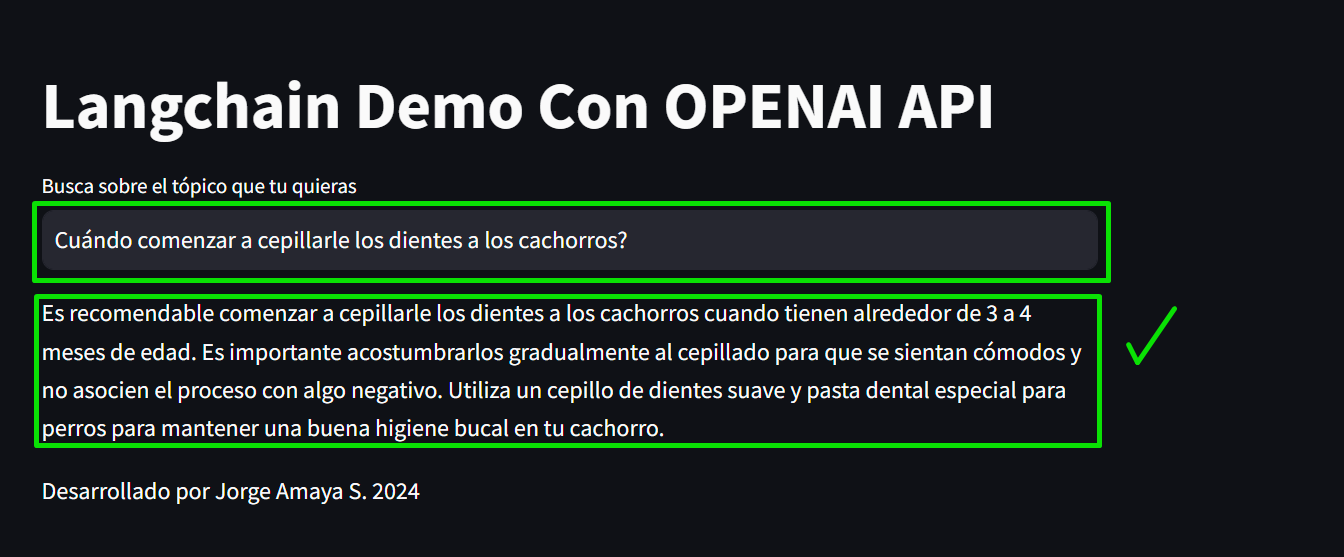

print ( "b =" , b )Finalmente, geramos uma consulta comum:

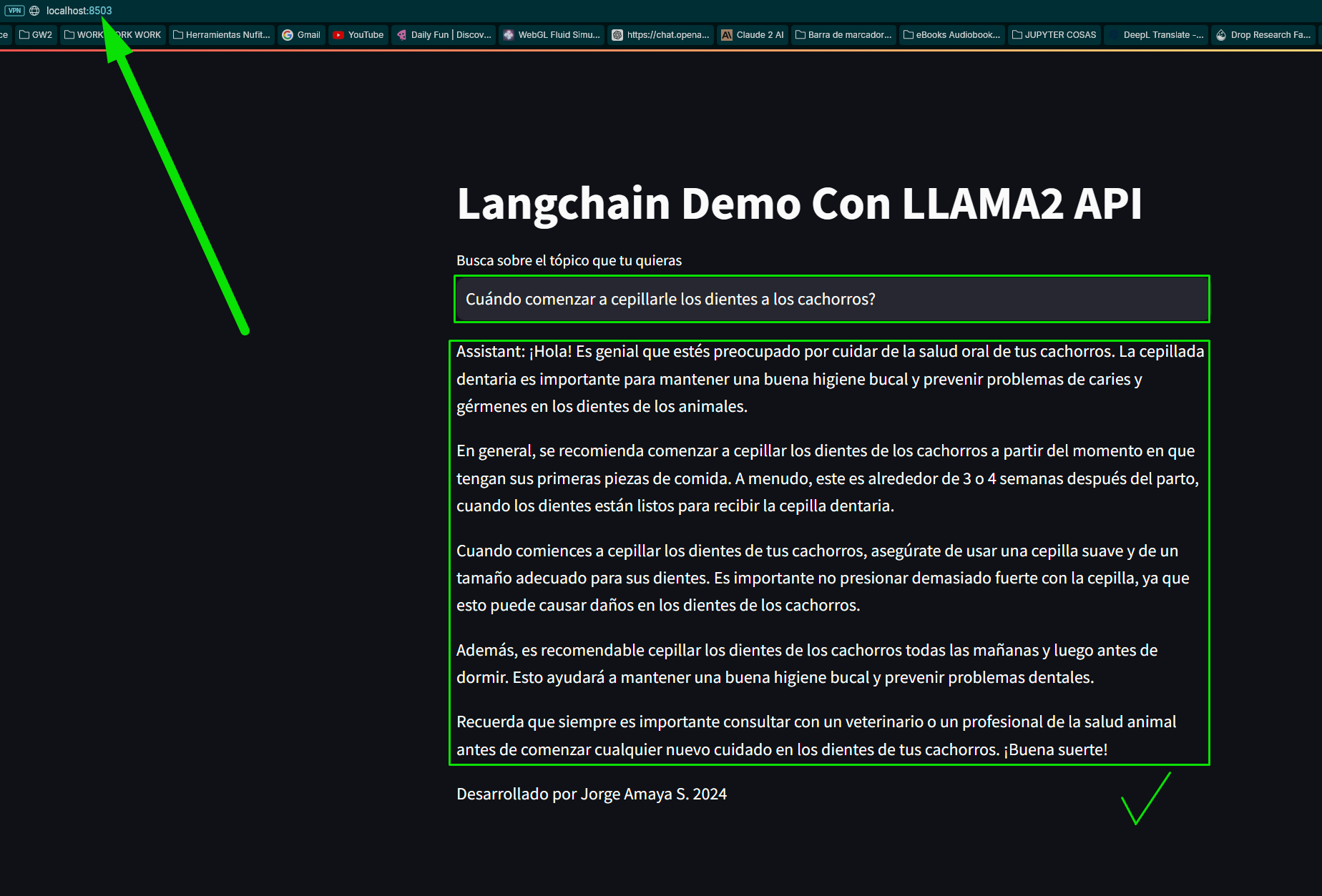

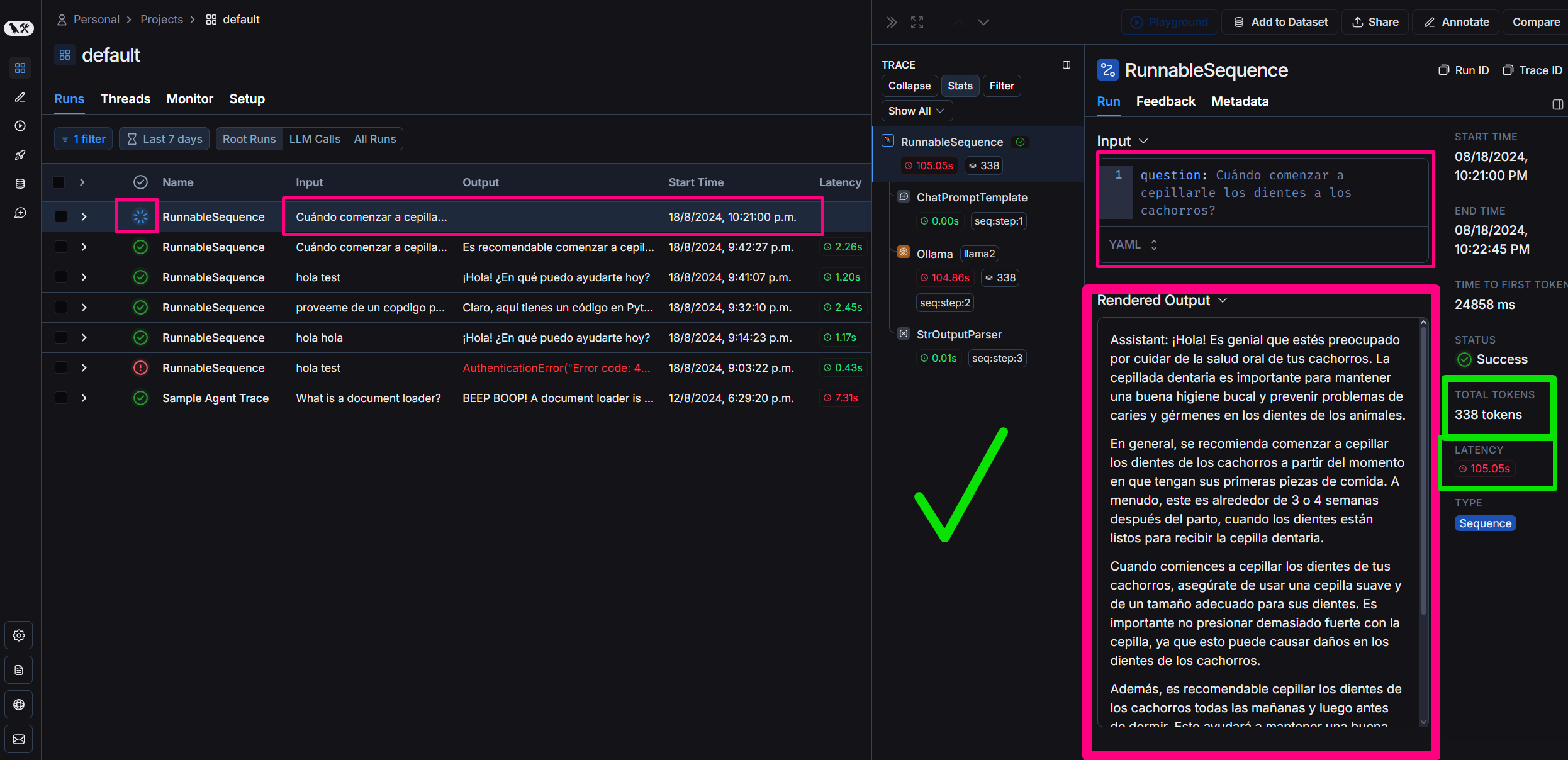

“pergunta": "Quando começar a escovar os dentes dos cachorrinhos?"

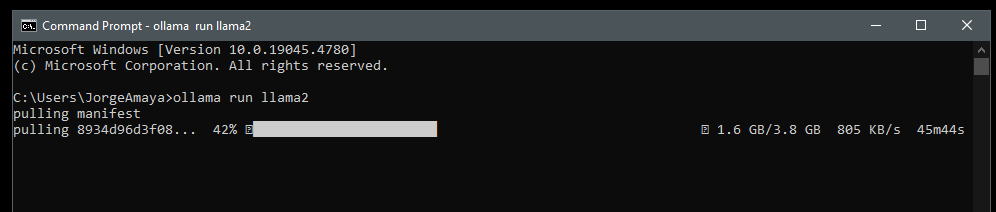

Carregaremos o Llamama especificamente baixando o Llama2 em nosso computador para executá-lo em meu ambiente local

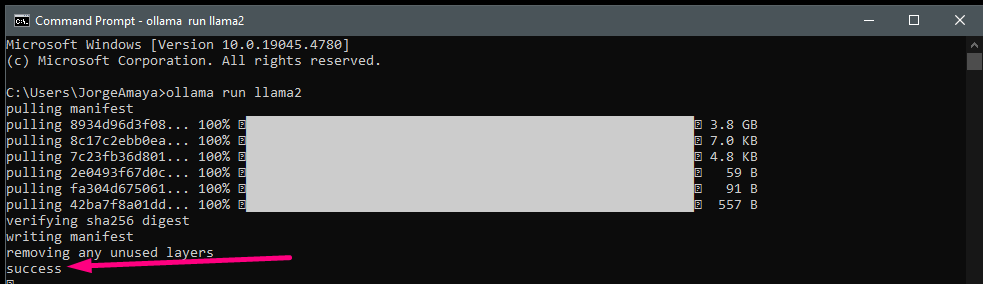

eu abro um cmd

ollama run llama2 baixamos llama2

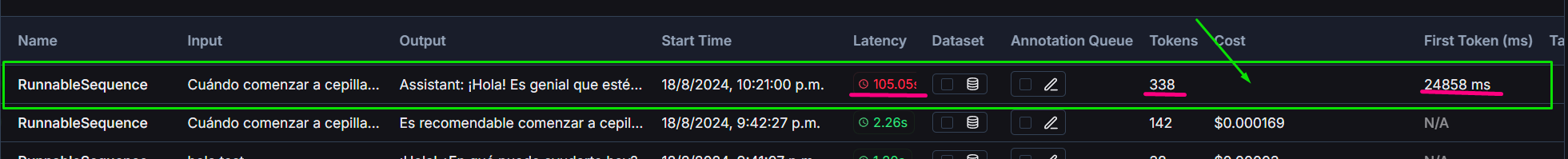

Llama2 em comparação com o gerado com gpt3.5 turbo

O projeto inclui uma comparação entre o GPT-3.5-turbo da OpenAI e o modelo Llama2 executado localmente:

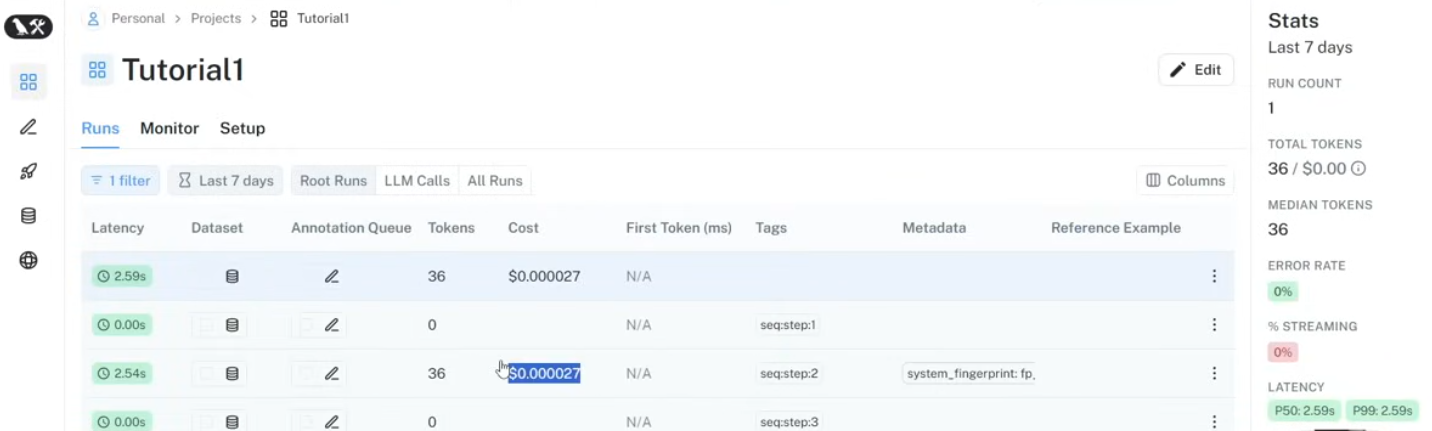

Usamos Langsmith no Langchain para monitorar:

Contribuições para melhorar o chatbot ou ampliar suas capacidades são sempre bem-vindas. Envie solicitações pull ou problemas em aberto para quaisquer melhorias.

#### Você quer aprender? me mande um DM!

Este projeto é de código aberto e está disponível sob a licença MIT.