Como sabemos que LLMs como o Gemini carecem de informações específicas da empresa. Mas esta informação mais recente está disponível através de PDFs, arquivos de texto, etc... Agora, se pudermos conectar nosso LLM com essas fontes, poderemos construir uma aplicação muito melhor.

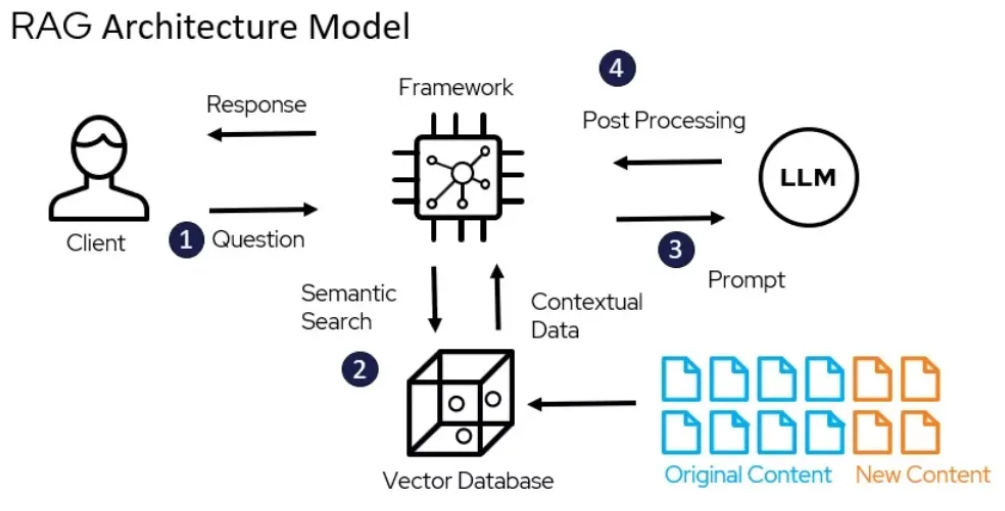

Usando a estrutura LangChain, construí um sistema Retrieval Augmented Generation (RAG) que pode utilizar o poder do LLM como Gemini 1.5 Pro para responder perguntas no artigo “Leave No Context Behind” publicado pelo Google em 10 de abril de 2024. Neste processo, externos os dados (ou seja, o papel Leave No Context Behind) são recuperados e então passados para o LLM durante a etapa de geração.

Você pode encontrar o papel aqui.

Encontre a implementação completa do código aqui.