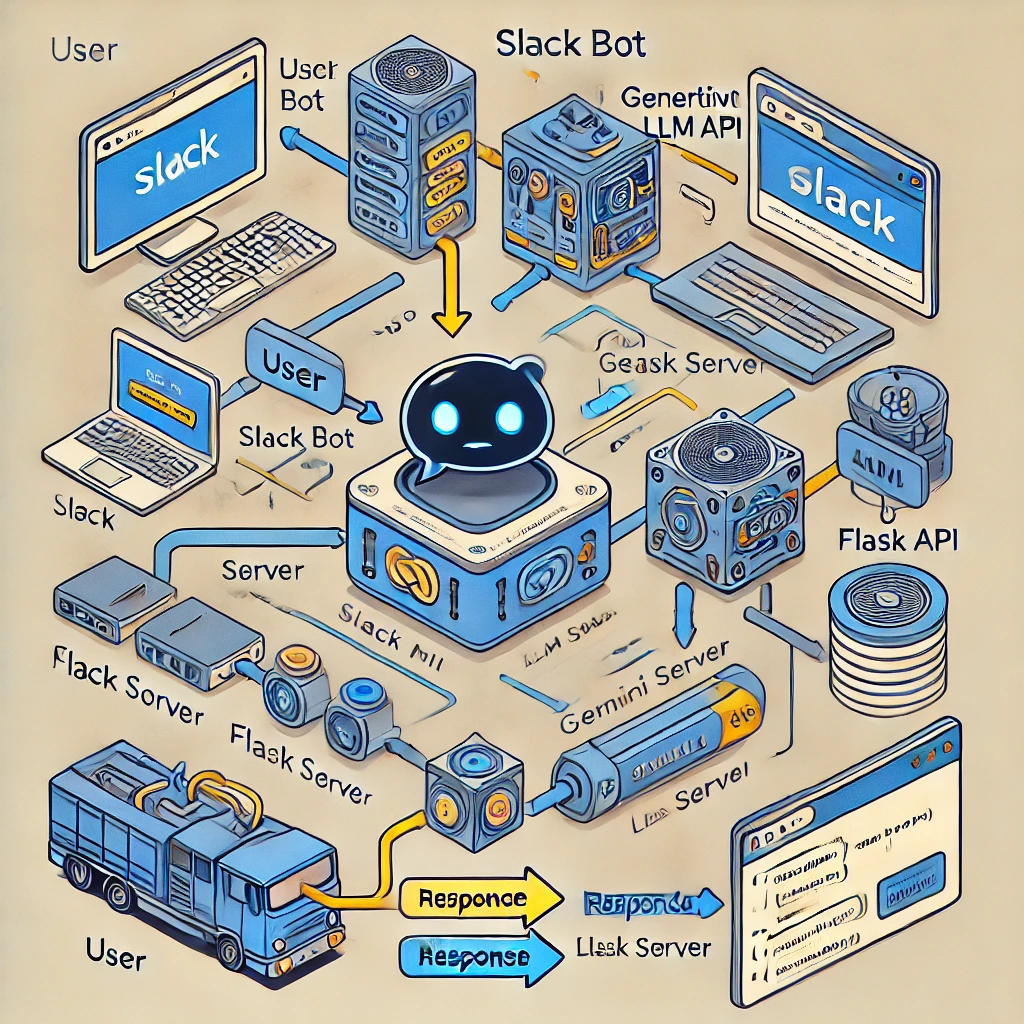

Este projeto demonstra como integrar um bot do Slack com um chatbot baseado em Large Language Model (LLM) usando o modelo Gemini do Google. A integração permite comunicação inteligente e sensível ao contexto diretamente no Slack.

O bot do Slack é construído usando Python e Flask e é integrado a um chatbot com tecnologia LLM utilizando o modelo Gemini. Essa configuração permite que o bot processe as entradas do usuário nos canais do Slack e responda de forma inteligente com base nas informações mais recentes de engenharia de dados.

Bibliotecas usadas: slack_sdk, slack_bolt Funcionalidade: O bot escuta eventos app_mention acionados quando alguém menciona o bot em um canal do Slack. Configuração: tokens e segredos são carregados com segurança de um arquivo .env usando variáveis de ambiente

Flask App: The Flask app handles incoming HTTP requests from Slack.

Event Processing: Slack events are processed through Flask using SlackRequestHandler from the slack_bolt.adapter.flask module.

Gemini Model: The Gemini model, provided by Google's Generative AI platform, processes and responds to queries.

Python Package: The google.generativeai package is used to interact with the Gemini model, allowing for prompt-based queries.

Configuration: Tokens are securely loaded from a .env file using environment variables for geminiai api.

Uso do ngrok: o ngrok fornece uma URL pública que encaminha solicitações para o aplicativo Flask local, permitindo que o Slack se comunique com o bot. Comando de configuração: ngrok http 6060 é usado para expor o aplicativo Flask à Internet.

A integração resulta em um bot do Slack capaz de realizar análises avançadas de dados e responder de forma inteligente às dúvidas dos usuários no Slack.