nvidia llm

1.0.0

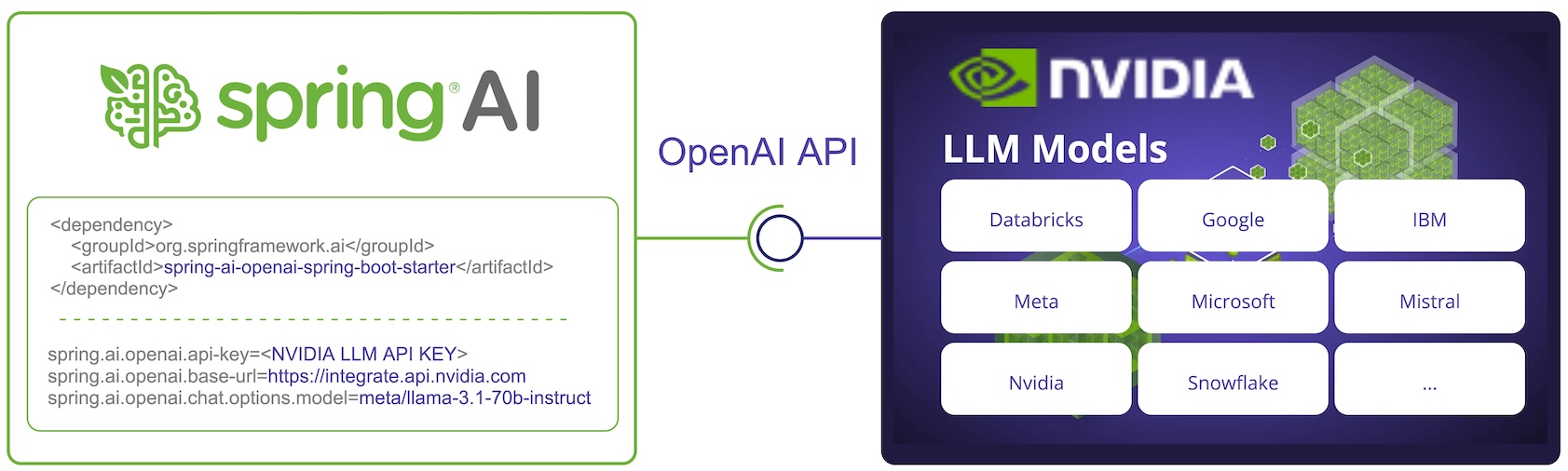

API NVIDIA LLM é um mecanismo de inferência de IA de proxy que oferece uma ampla variedade de modelos de vários fornecedores.

Spring AI integra-se à API NVIDIA LLM reutilizando o cliente Spring AI OpenAI existente.

Para isso, você precisa definir o URL base para https://integrate.api.nvidia.com , selecionar um dos https://docs.api.nvidia.com/nim/reference/llm-apis#model[ Modelos LLM] e obtenha uma api-key para isso.

NOTA: A API NVIDIA LLM requer que o parâmetro max-token seja definido explicitamente ou um erro do servidor será gerado.

Encontre mais na documentação de referência SpringAI/NVIDIA: https://docs.spring.io/spring-ai/reference/api/chat/nvidia-chat.html