tokviz /

├── assets/

│ ├── example-deberta-v3-small.png

│ └── example-gpt2.png

├── tokviz /

│ ├── __init__.py

│ └── visualization.py

├── README.md

├── LICENSE

├── setup.py

└── pyproject.toml

tokviz é uma biblioteca Python para visualizar padrões de tokenização em diferentes modelos de linguagem. Esta biblioteca oferece uma plataforma abrangente para pesquisadores, cientistas de dados e entusiastas de PNL obterem insights sobre como diferentes modelos de linguagem processam e tokenizam texto.

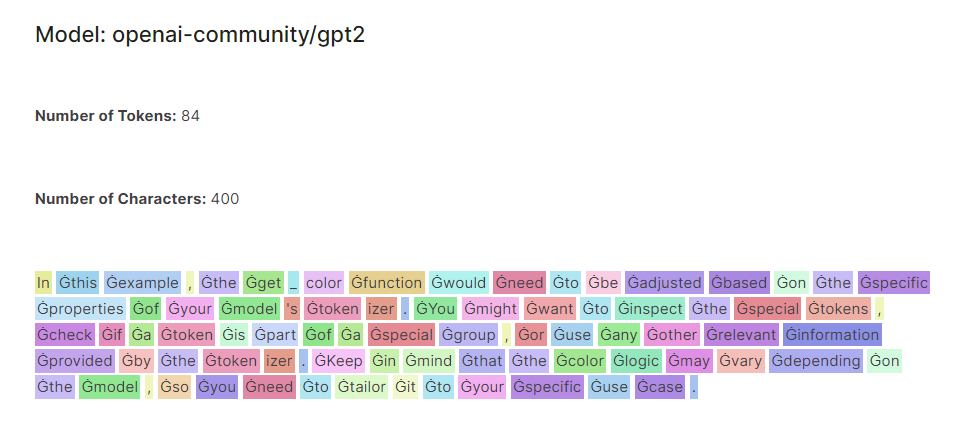

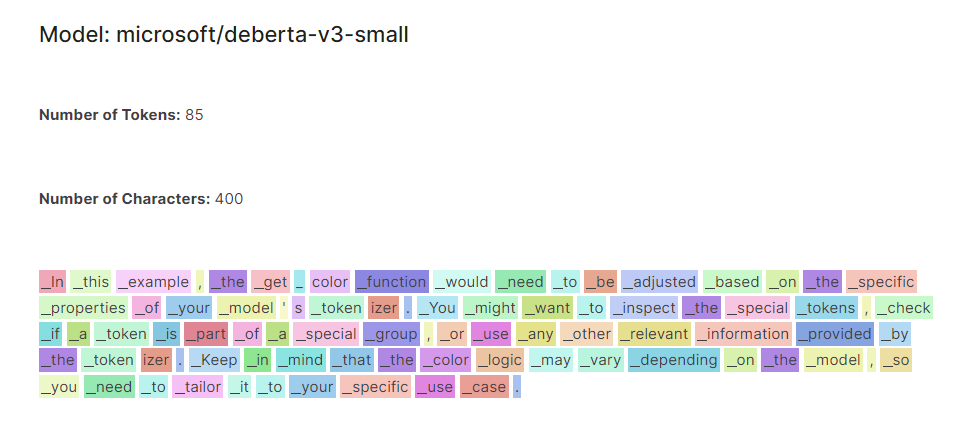

Comparação de modelos: o visualizador permite aos usuários comparar padrões de tokenização em vários modelos de linguagem, incluindo modelos populares como GPT-2, DistilGPT-2 e DeBERTa-v3-small. Ao exibir tokens codificados por cores lado a lado, os usuários podem identificar facilmente diferenças e semelhanças no comportamento de tokenização.

Entrada flexível: os usuários podem inserir qualquer texto de sua escolha, permitindo a exploração dinâmica de padrões de tokenização em diversas entradas textuais. Seja analisando frases curtas, parágrafos ou documentos inteiros, o visualizador se adapta às informações do usuário para uma análise abrangente.

Visualização codificada por cores: os tokens são codificados por cores com base em suas propriedades e índice, fornecendo uma representação visualmente intuitiva dos padrões de tokenização. Isso permite que os usuários identifiquem rapidamente símbolos e padrões individuais no texto, facilitando análises e interpretações mais profundas.

Você pode instalar tokviz via pip:

pip install tokviz from tokviz import token_visualizer

# Define input text

text = "In this example, the get_color function would need to be adjusted based on the specific properties of your model's tokenizer.

You might want to inspect the special tokens, check if a token is part of a special group,

or use any other relevant information provided by the tokenizer.

Keep in mind that the color logic may vary depending on the model,

so you need to tailor it to your specific use case."

# Compare tokenization across different language models

token_visualizer ( text , models = [ 'microsoft/deberta-v3-small' , 'openai-community/gpt2' ])Isto irá visualizar padrões de tokenização para o texto de entrada usando os modelos de linguagem especificados. Você pode passar uma lista de nomes ou identificadores de modelos para o parâmetro models. Por padrão, ele compara a tokenização com o modelo GPT-2.

Esta biblioteca é baseada no notebook LLM Tokenizer Visualizer