GPT-2 é um modelo de linguagem aprendido para prever bem a próxima palavra em um determinado texto e é otimizado para geração de frases. KoGPT2 é um modelo de linguagem decoder coreana aprendido com mais de 40 GB de texto para superar o desempenho insuficiente da língua coreana.

|

Treinado com Character BPE tokenizer do pacote tokenizers .

O tamanho do dicionário é 51.200, e a capacidade de reconhecimento dos tokens foi aumentada com a adição de emoticons e emojis, como aqueles frequentemente usados em conversas, conforme mostrado abaixo.

?, ?, ?, ?, ?, .. ,

:-),:),-),(-:...

Além disso, tokens não utilizados, como <unused0> a <unused99> foram definidos para que pudessem ser definidos e usados livremente dependendo da tarefa necessária.

> from transformers import PreTrainedTokenizerFast

> tokenizer = PreTrainedTokenizerFast . from_pretrained ( "skt/ KoGPT2 -base-v2" ,

bos_token = '</s>' , eos_token = '</s>' , unk_token = '<unk>' ,

pad_token = '<pad>' , mask_token = '<mask>' )

> tokenizer . tokenize ( "안녕하세요. 한국어 GPT-2 입니다.?:)l^o" )

[ '▁안녕' , '하' , '세' , '요.' , '▁한국어' , '▁G' , 'P' , 'T' , '-2' , '▁입' , '니다.' , '?' , ':)' , 'l^o' ]| Modelo | # de parâmetros | Tipo | Nº de camadas | # de cabeças | ffn_dim | oculto_dims |

|---|---|---|---|---|---|---|

KoGPT2 -base-v2 | 125 milhões | Decodificador | 12 | 12 | 3072 | 768 |

> import torch

> from transformers import GPT2LMHeadModel

> model = GPT2LMHeadModel . from_pretrained ( 'skt/ KoGPT2 -base-v2' )

> text = '근육이 커지기 위해서는'

> input_ids = tokenizer . encode ( text , return_tensors = 'pt' )

> gen_ids = model . generate ( input_ids ,

max_length = 128 ,

repetition_penalty = 2.0 ,

pad_token_id = tokenizer . pad_token_id ,

eos_token_id = tokenizer . eos_token_id ,

bos_token_id = tokenizer . bos_token_id ,

use_cache = True )

> generated = tokenizer . decode ( gen_ids [ 0 ])

> print ( generated )

근육이 커지기 위해서는 무엇보다 규칙적인 생활습관이 중요하다 .

특히 , 아침식사는 단백질과 비타민이 풍부한 과일과 채소를 많이 섭취하는 것이 좋다 .

또한 하루 30 분 이상 충분한 수면을 취하는 것도 도움이 된다 .

아침 식사를 거르지 않고 규칙적으로 운동을 하면 혈액순환에 도움을 줄 뿐만 아니라 신진대사를 촉진해 체내 노폐물을 배출하고 혈압을 낮춰준다 .

운동은 하루에 10 분 정도만 하는 게 좋으며 운동 후에는 반드시 스트레칭을 통해 근육량을 늘리고 유연성을 높여야 한다 .

운동 후 바로 잠자리에 드는 것은 피해야 하며 특히 아침에 일어나면 몸이 피곤해지기 때문에 무리하게 움직이면 오히려 역효과가 날 수도 있다 ...| NSMC (acc) | KorSTS (lanceiro) | |

|---|---|---|

| KoGPT2 2.0 | 89,1 | 77,8 |

Além da Wikipédia coreana, vários dados, como notícias e corpus de todos v1.0, foram usados para treinar o modelo.

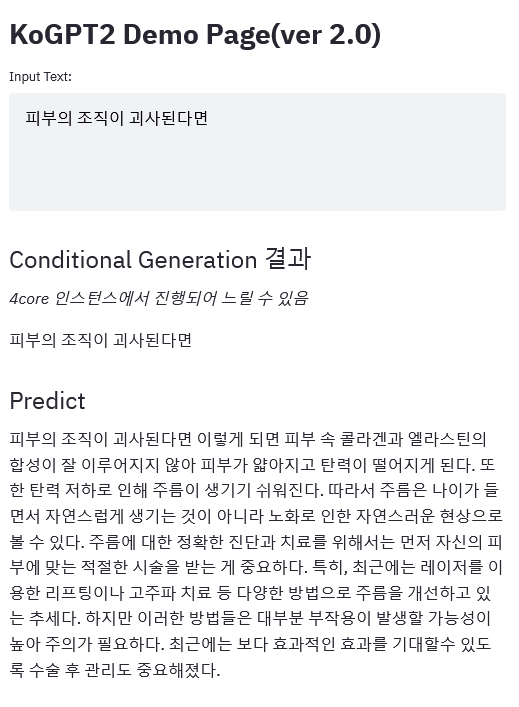

link de demonstração

|

Por favor, poste questões relacionadas ao KoGPT2 aqui.

KoGPT2 é lançado sob a licença CC-BY-NC-SA 4.0. Cumpra os termos de licença ao usar modelos e códigos. A licença completa pode ser encontrada no arquivo LICENSE.