Gabriele Sarti • Grzegorz Chrupała • Malvina Nissim • Arianna Bisazza

processo de duas etapas do pecore" width="300" style="max-width: 100%;">

processo de duas etapas do pecore" width="300" style="max-width: 100%;"> exemplos de pecore" width="500" style="max-width: 100%;">

exemplos de pecore" width="500" style="max-width: 100%;">

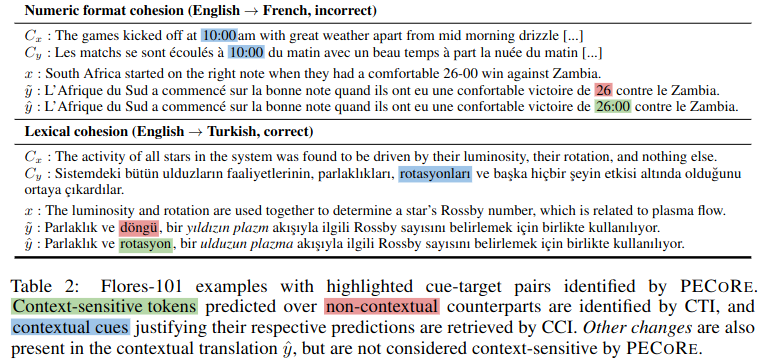

Resumo: Estabelecer se os modelos de linguagem podem usar informações contextuais de uma forma humanamente plausível é importante para garantir sua adoção segura em ambientes do mundo real. No entanto, as questões de quando e que partes do contexto afectam as gerações de modelos são normalmente abordadas separadamente, e as actuais avaliações de plausibilidade estão praticamente limitadas a um punhado de referências artificiais. Para resolver isso, apresentamos a Avaliação de Plausibilidade da Confiança no Contexto ( pecore ), uma estrutura de interpretabilidade ponta a ponta projetada para quantificar o uso do contexto nas gerações de modelos de linguagem. Nossa abordagem aproveita os aspectos internos do modelo para (i) identificar de forma contrastante tokens alvo sensíveis ao contexto em textos gerados e (ii) vinculá-los a dicas contextuais que justificam sua previsão. Usamos pecore para quantificar a plausibilidade de modelos de tradução automática sensíveis ao contexto, comparando os fundamentos do modelo com anotações humanas em vários fenômenos no nível do discurso. Finalmente, aplicamos nosso método a gerações não anotadas para identificar previsões mediadas pelo contexto e destacar instâncias de uso de contexto (im)plausível em traduções de modelos.

Este repositório contém scripts e cadernos associados ao artigo "Quantificando a plausibilidade da confiança no contexto na tradução automática neural". Se você utilizar algum dos seguintes conteúdos em seu trabalho, pedimos a gentileza de citar nosso artigo:

@inproceedings { sarti-etal-2023-quantifying ,

title = " Quantifying the Plausibility of Context Reliance in Neural Machine Translation " ,

author = " Sarti, Gabriele and

Chrupa{l}a, Grzegorz and

Nissim, Malvina and

Bisazza, Arianna " ,

booktitle = " The Twelfth International Conference on Learning Representations (ICLR 2024) " ,

month = may,

year = " 2024 " ,

address = " Vienna, Austria " ,

publisher = " OpenReview " ,

url = " https://openreview.net/forum?id=XTHfNGI3zT "

}Dica

Você pode experimentar pecore em nossa demonstração online no Hugging Face Spaces.

Embora este repositório implemente as funções utilizadas na avaliação experimental do artigo mencionado, fornecemos uma nova implementação CLI de pecore por meio da biblioteca de interpretabilidade Inseq. Aconselhamos fortemente os pesquisadores a adotarem essa implementação, pois ela é mais robusta e generalizável, suportando todos os modelos somente decodificador e codificador-decodificador da biblioteca Huggingface para detecção e atribuição de dependência de contexto de entrada e saída. Consulte a seção inseq attribute-context no README do Inseq para obter mais detalhes.

Todos os artefatos do artigo, incluindo modelos ajustados e conjuntos de dados de treinamento/avaliação estão disponíveis na coleção pecore HuggingFace. Uma demonstração será disponibilizada em breve, fique ligado!

Os modelos NMT sensíveis ao contexto são treinados usando o script train_context_aware_mt_model.py . O script é uma modificação do run_translation_no_trainer.py original. O script adiciona os seguintes campos para treinamento de modelo contextual:

context_size : o número de sentenças de contexto a serem usadas para treinamento. O valor padrão é 0 (treinamento em nível de frase).

sample_context : se definido, o tamanho do contexto para cada exemplo é amostrado a partir de uma distribuição uniforme entre 0 e context_size (inclusive). Se não for aprovado e context_size for maior que 0, o tamanho do contexto será sempre igual a context_size .

context_word_dropout : Probabilidade entre 0 e 1 de retirar uma palavra do contexto. O valor padrão é 0 (sem abandono).

use_target_context : se definido, o contexto também será incluído no texto traduzido para a perda de treinamento. Nesse caso, o formato de saída para uma entrada src_ctx <brk> src torna-se tgt_ctx <brk> tgt . Caso contrário, o formato de saída será tgt (apenas src será traduzido).

Aqui está um exemplo de ajuste fino de um modelo mBART 1 a 50 no conjunto de dados IWSLT17 aumentado por contexto com até 4 sentenças de contexto e uma eliminação de 10% de palavras de contexto:

accelerate launch scripts/train_context_aware_mt_model.py

--model_name_or_path facebook/mbart-large-50-one-to-many-mmt

--source_lang en_XX

--target_lang fr_XX

--dataset_name gsarti/iwslt2017_context

--dataset_config_name iwslt2017-en-fr

--output_dir outputs/models/iwslt17-mbart50-1toM-ctx4-cwd1-en-fr

--num_beams 5

--max_source_length 512

--max_target_length 128

--num_train_epochs 20

--gradient_accumulation_steps 4

--per_device_train_batch_size 8

--num_warmup_steps 500

--learning_rate 3e-4

--checkpointing_steps epoch

--with_tracking

--report_to tensorboard

--context_size 4

--sample_context

--context_word_dropout 0.1 Aqui está um exemplo de continuação do ajuste fino de um modelo En->Fr OpusMT com reconhecimento de contexto na parte de treinamento do SCAT com até 4 sentenças de contexto e uma eliminação de 10% de palavras de contexto:

accelerate launch scripts/train_context_aware_mt_model.py

--model_name_or_path context-mt/iwslt17-marian-big-ctx4-cwd1-en-fr

--dataset_name inseq/scat

--dataset_config_name sentences

--output_dir outputs/models/scat-marian-big-ctx4-cwd1-en-fr

--num_beams 5

--max_source_length 512

--max_target_length 128

--num_train_epochs 2

--gradient_accumulation_steps 2

--per_device_train_batch_size 8

--num_warmup_steps 0

--learning_rate 5e-5

--checkpointing_steps 1000

--logging_steps 200

--with_tracking

--report_to tensorboard

--context_size 4

--sample_context

--context_word_dropout 0.1 A CLI pecore é uma interface de linha de comando para executar as etapas pecore em um determinado modelo e conjunto de dados. A CLI é implementada no script pecore /cli.py e pode ser usada como pecore -viz ao instalar o pacote com pip install -e . . A implementação atual suporta a identificação de alvos sensíveis ao contexto (CTI) e a imputação de pistas contextuais (CCI) para todos os modelos codificadores-decodificadores suportados pela estrutura Inseq, incluindo modelos com tags de prefixo de idioma (mBART-50, NLLB, M2M100) e modelos treinados com tags de contexto especiais (por exemplo, a coleção de modelos encontrados na organização context-mt no HF Hub). A CLI pode ser usada para executar as etapas pecore em um determinado modelo e exemplo como segue:

pecore -viz

--model_name context-mt/scat-marian-small-ctx4-cwd1-en-fr

--attributions_aggregate_fns sum

--model_use_ctx_break

--impute_with_contextless_output

--force_context_aware_output_prefix

--input " Did I mention we stole a cow? A beautiful animal, truly. We brought it to the stable and kept it there for ages.<brk> Sadly, we could not foresee it would disappear. "O exemplo acima produz a seguinte saída, destacando corretamente a dependência do pronome “il” dos substantivos “vaca” e “animal” no contexto.

Context with contextual cues (std λ=1.00) followed by output sentence

with context-sensitive target spans (std λ=1.00):

Input context: Did I mention we stole a cow ? A beautiful animal, truly. We brought it to the stable and kept it there for ages.

Input current: Sadly, we could not foresee it would disappear.

Context-aware output: Malheureusement, nous n ' avons pas pu prévoir qu ' il disparaîtrait.

Using ' <brk> ' to separate context and current inputs.

# 1. (CTI |kl_divergence| > 0.14, CCI |saliency| > 0.71)

Contextless output: Malheureusement, nous n ' avons pas pu prévoir qu ' il disparaîtrait.

Current output: Malheureusement, nous n ' avons pas pu prévoir qu ' il(0.412) disparaîtrait.

Input context: Did I mention we stole a cow(1.524) ? A beautiful animal(1.472), truly. We brought it to the stable and kept it

there for ages.Ao usar a CLI para executar um modelo regular, será necessária uma etapa adicional para especificar a posição da quebra de contexto na geração do modelo se uma saída não for forçada pelo usuário. Aqui está um exemplo usando o modelo mBART-50 regular do HF Hub:

pecore -viz

--model_name facebook/mbart-large-50-one-to-many-mmt

--input_lang eng --output_lang fra --model_type mbart50-1toM

--impute_with_contextless_output

--force_context_aware_output_prefix

--input " Did I mention we stole a cow? A beautiful animal, truly. We brought it to the stable and kept it there for ages.<brk> Sadly, we could not foresee it would disappear. "O usuário será solicitado com a seguinte mensagem:

The following output was generate by the model: J’ai mentionné que nous avons volé une vache, c’est vraiment un beau animal, que nous avons emmené à l’élevage et que nous l’avons gardée pendant des époques. Malheureusement, nous n’avons pas pu prévoir qu’elle disparaîtrait.

Rewrite it here by adding ' <brk> ' wherever appropriate to mark context break: O usuário pode então reescrever a saída adicionando <brk> sempre que apropriado para marcar a quebra de contexto:

J’ai mentionné que nous avons volé une vache, c’est vraiment un beau animal, que nous avons emmené à l’élevage et que nous l’avons gardée pendant des époques. < brk > Malheureusement, nous n’avons pas pu prévoir qu’elle disparaîtrait.O resultado final será:

Context with contextual cues (std λ=1.00) followed by output sentence

with context-sensitive target spans (std λ=1.00):

Input context: Did I mention we stole a cow ? A beautiful animal, truly. We brought it to the stable and kept it there for ages.

Input current: Sadly, we could not foresee it would disappear.

Output context: J’ai mentionné que nous avons volé une vache, c’est vraiment un beau animal, que nous avons emmené à l’élevage et que nous l’avons gardée pendant

des époques.

Context-aware output: J’ai mentionné que nous avons volé une vache, c’est vraiment un beau animal, que nous avons emmené à l’élevage et que nous l’avons gardée

pendant des époques. Malheureusement, nous n’avons pas pu prévoir qu’elle disparaîtrait.

Using language tags for model type ' mbart50-1toM ' (eng - > fra).

# 1. (CTI |kl_divergence| > 1.08, CCI |saliency| > 0.00)

Contextless output: Malheureusement, nous n ' avons pas pu prévoir sa disparition.

Current output: Malheureusement, nous n’(3.505)avons pas pu prévoir qu’elle disparaîtrait.

Input context: Did I mention we stole a cow? A beautiful animal, truly. We brought it to the stable(0.002) and kept it there for ages.

Output context: J’(0.004)ai mentionné que nous avons volé une vache, c’(0.002)est vraiment un beau animal, que nous avons emmené à l’(0.003)élevage et que nous

l’(0.007)avons gardée pendant des époques. Nesse caso, vemos que o modelo opta por gerar o apóstrofo curvo ' em vez do reto ' usado por padrão na saída sem contexto para manter o estilo do contexto de saída, empregando esse caractere em diversas ocasiões (identificado como dicas contextuais por pecore ) .

Neste exemplo, usamos o peso de atenção do cabeçalho 8 na camada 5 para atribuir dependência de contexto. Descobriu-se empiricamente que esta cabeça se alinha bem com a intuição humana.

pecore -viz

--model_name context-mt/scat-marian-small-ctx4-cwd1-en-fr

--attributions_aggregate_fns mean mean

--model_use_ctx_break

--impute_with_contextless_output

--force_context_aware_output_prefix

--input " Did I mention we stole a cow? A beautiful animal, truly. We brought it to the stable and kept it there for ages.<brk> Sadly, we could not foresee it would disappear. "

--attribution_method attention

--select_attributions_idx 7 4python scripts/translate.py

--model_type mbart50-1toM

--model_id mbart50-1toM-scat

--model_name context-mt/scat-mbart50-1toM-ctx4-cwd1-en-fr

--context_size 4

--dataset scat

--context_word_dropout 1

python scripts/translate.py

--model_type marian-big

--model_id marian-big-scat-target

--model_name context-mt/scat-marian-big-target-ctx4-cwd0-en-fr

--context_size 4

--dataset disc_eval_mt

--context_word_dropout 0

--dataset_config anaphora

python scripts/translate.py

--model_type marian-big

--model_id marian-big-scat-target

--model_name context-mt/scat-marian-big-target-ctx4-cwd0-en-fr

--context_size 4

--dataset disc_eval_mt

--context_word_dropout 0

--dataset_config lexical-choice

python scripts/translate.py

--model_type marian-big

--model_id marian-big-scat

--model_name context-mt/scat-marian-big-ctx4-cwd1-en-fr

--context_size 4

--dataset disc_eval_mt

--context_word_dropout 1

--dataset_config anaphora

python scripts/translate.py

--model_type marian-big

--model_id marian-big-scat

--model_name context-mt/scat-marian-big-ctx4-cwd1-en-fr

--context_size 4

--dataset disc_eval_mt

--context_word_dropout 1

--dataset_config lexical-choice

python scripts/translate.py

--model_type mbart50-1toM

--model_id mbart50-1toM-scat

--model_name context-mt/scat-mbart50-1toM-ctx4-cwd1-en-fr

--context_size 0

--dataset disc_eval_mt

--context_word_dropout 0

--dataset_config lexical-choicepython scripts/evaluate_mt_outputs.py

--filepath outputs/translations/ctx/scat-marian-small-scat-target.txt

--model_id marian-small-scat-target

--dataset scat

--src_lang eng

--tgt_lang fra

--metrics bleu comet accuracy flip

--has_target_context

--max_idx 250

python scripts/evaluate_mt_outputs.py

--filepath outputs/translations/ctx/disc_eval_mt-anaphora-marian-small-scat-target.txt

--model_id marian-small-scat-target

--dataset disc_eval_mt

--src_lang eng

--tgt_lang fra

--metrics bleu comet accuracy flip

--has_target_context

--max_idx 250

python scripts/evaluate_mt_outputs.py

--filepath outputs/translations/ctx/scat-mbart50-1toM-scat.txt

--model_id mbart50-1toM-scat

--dataset scat

--src_lang eng

--tgt_lang fra

--metrics bleu comet accuracy

python scripts/evaluate_mt_outputs.py

--filepath outputs/translations/ctx/scat-mbart50-1toM-scat.txt

--model_id mbart50-1toM-scat

--dataset scat

--src_lang eng

--tgt_lang fra

--metrics comet accuracypython scripts/generate_examples.py

--dataset scat

--model_name context-mt/scat-marian-small-target-ctx4-cwd0-en-fr

--src_lang eng

--tgt_lang fra

--model_id marian-small-scat-target

--model_type marian-small

--has_context

--has_contrast

--has_target_context

python scripts/generate_examples.py

--dataset scat

--model_name context-mt/scat-mbart50-1toM-target-ctx4-cwd0-en-fr

--src_lang eng

--tgt_lang fra

--model_id mbart50-1toM-scat-target

--model_type mbart50-1toM

--has_context

--has_target_context

--has_contrast

python scripts/generate_examples.py

--dataset disc_eval_mt

--dataset_config anaphora

--model_name context-mt/scat-marian-small-ctx4-cwd1-en-fr

--src_lang eng

--tgt_lang fra

--model_id marian-small-scat

--model_type marian-small

--has_context

--has_contrast

python scripts/generate_examples.py

--dataset scat

--model_name Helsinki-NLP/opus-mt-en-fr

--src_lang eng

--tgt_lang fra

--model_id marian-small

--model_type marian-small

--has_contrastpython scripts/tag_cti_metrics.py

--examples_path outputs/processed_examples/scat-marian-small-scat.tsv

--model_name context-mt/scat-marian-small-ctx4-cwd1-en-fr

--model_type marian-small

python scripts/tag_cti_metrics.py

--examples_path outputs/processed_examples/scat-marian-big-scat.tsv

--model_name context-mt/scat-marian-big-ctx4-cwd1-en-fr

--model_type marian-big

python scripts/tag_cti_metrics.py

--examples_path outputs/processed_examples/scat-mbart50-1toM-scat.tsv

--model_name context-mt/scat-mbart50-1toM-ctx4-cwd1-en-fr

--model_type mbart50-1toM

python scripts/tag_cti_metrics.py

--examples_path outputs/processed_examples/scat-marian-small-scat-target.tsv

--model_name context-mt/scat-marian-small-target-ctx4-cwd0-en-fr

--model_type marian-small

python scripts/tag_cti_metrics.py

--examples_path outputs/processed_examples/scat-marian-big-scat-target.tsv

--model_name context-mt/scat-marian-big-target-ctx4-cwd0-en-fr

--model_type marian-big

python scripts/tag_cti_metrics.py

--examples_path outputs/processed_examples/scat-mbart50-1toM-scat-target.tsv

--model_name context-mt/scat-mbart50-1toM-target-ctx4-cwd0-en-fr

--model_type mbart50-1toMpython scripts/tag_cci_metrics.py

--examples_path outputs/processed_examples/scat-marian-small-scat.tsv

--model_name context-mt/scat-marian-small-ctx4-cwd1-en-fr

--model_type marian-small

python scripts/tag_cci_metrics.py

--examples_path outputs/processed_examples/scat-mbart50-1toM-scat-target.tsv

--model_name context-mt/scat-mbart50-1toM-target-ctx4-cwd0-en-fr

--model_type mbart50-1toMpython scripts/evaluate_tagged_metrics.py

--scores_path outputs/scores/scat-marian-small-scat-cti.tsv

--eval_mode cti

--use_trained_model

python scripts/evaluate_tagged_metrics.py

--scores_path outputs/scores/scat-marian-small-scat-cti.tsv

--eval_mode cti

--average_example_scores

--metrics random pcxmi kl_divergence

--save_preds

python scripts/evaluate_tagged_metrics.py

--scores_path outputs/scores/scat-marian-small-scat-cci.tsv

--eval_mode cci

--example_target_column is_supporting_context

--average_example_scores

--metrics random saliency_contrast_prob_diff attention_default attention_best

python scripts/evaluate_tagged_metrics.py

--scores_path outputs/scores/scat-marian-small-scat-target-cti.tsv

--eval_mode cti

--average_example_scores

--metrics random pcxmi kl_divergence

--save_preds