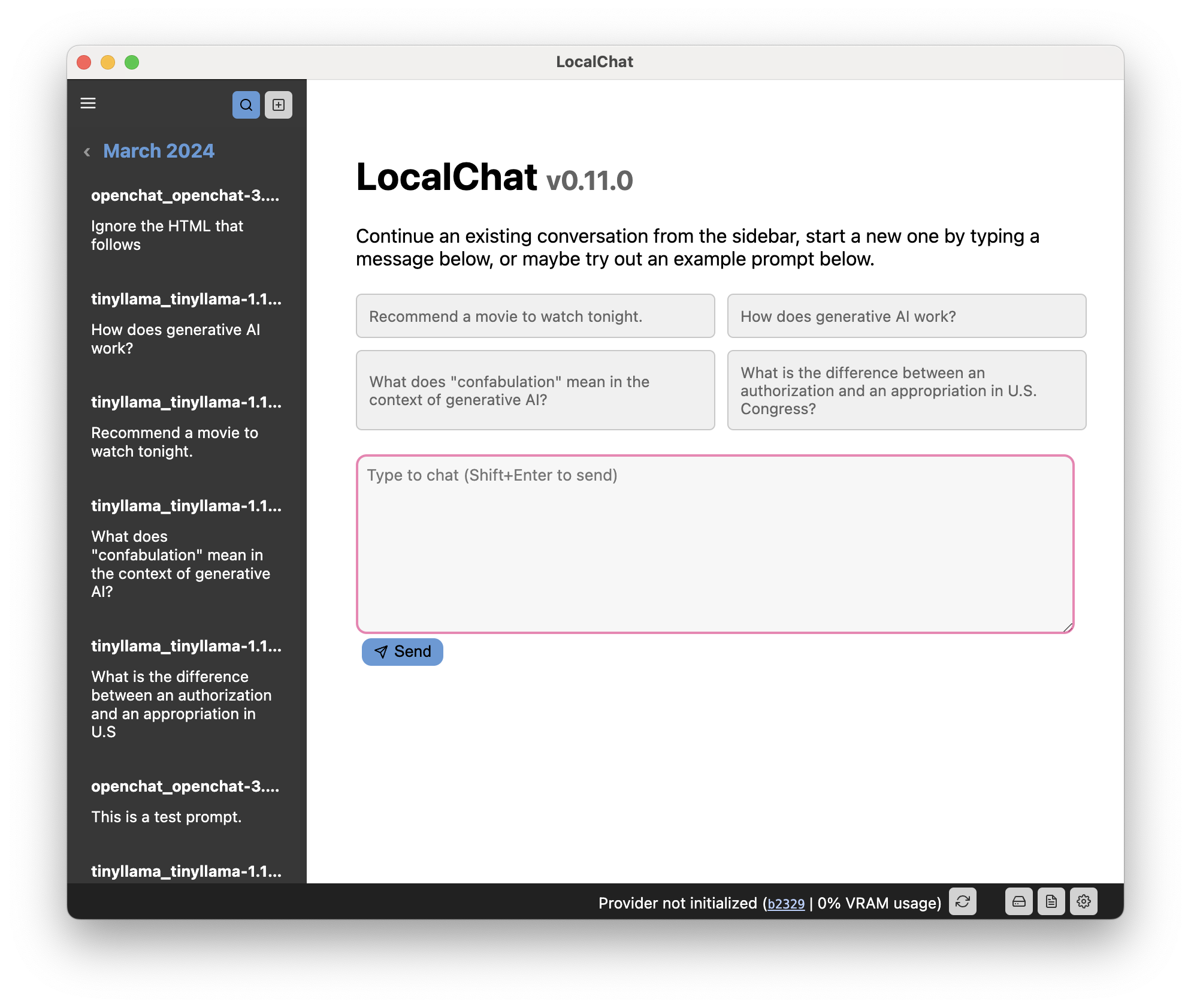

Converse com modelos de linguagem generativa localmente em seu computador sem nenhuma configuração. LocalChat é um bate-papo local de IA simples, fácil de configurar e de código aberto, criado com base em llama.cpp. Não requer nenhum conhecimento técnico e permite que os usuários experimentem um comportamento semelhante ao ChatGPT em suas próprias máquinas – totalmente compatível com GDPR e sem medo de vazar informações acidentalmente. Baixe LocalChat para macOS, Windows ou Linux aqui.

Índice

Visão geral | Justificativa | Requisitos do sistema | Início rápido | Documentação

LocalChat fornece uma interface semelhante a um chat para interagir com Large Language Models (LLMs) generativos. Parece qualquer conversa de bate-papo, mas acontece localmente no seu computador. Nenhum dado é transmitido para algum servidor em nuvem.

Já existem vários modelos de linguagem generativa extremamente capazes que se parecem quase com o ChatGPT. A principal diferença é que esses modelos são executados localmente e são de peso aberto.

Importante

Como você provavelmente já sabe, conversar com um LLM pode parecer muito natural, mas os modelos permanecem probabilísticos: eles gerarão a próxima palavra provável com base no que mais estiver no prompt. Os LLMs não têm noção de tempo, causalidade, contexto e o que os linguistas chamam de pragmática. Assim, eles tendem a inventar eventos que nunca aconteceram, misturar fatos de eventos totalmente diferentes ou contar mentiras descaradas (conhecidas como "alucinações"). O mesmo se aplica ao código ou aos cálculos que esses modelos podem gerar. Dito isto:

Tenha cuidado e use este modelo por sua própria conta e risco. Lembre-se de que se trata de um brinquedo e não de algo confiável.

Quando o ChatGPT foi lançado em novembro de 2022, fiquei extremamente animado – mas ao mesmo tempo também cauteloso. Embora tenha ficado muito impressionado com as capacidades do GPT-3, estava dolorosamente ciente do fato de que o modelo era proprietário e, mesmo que não fosse, seria impossível de ser executado localmente. Como cidadão europeu consciente da privacidade, não gosto da ideia de estar dependente de uma empresa multibilionária que pode cortar o acesso a qualquer momento.

Por conta disso, não pude brincar muito com GPT e resolvi esperar o inevitável: o desenvolvimento de ferramentas menores e melhores. Até agora, existem vários modelos que atendem a todos os requisitos: eles são executados localmente e parecem ChatGPT. Com a quantização (que basicamente reduz a resolução com algumas perdas de qualidade), eles podem até ser executados em hardware mais antigo.

No entanto, se você não tiver nenhuma experiência com LLMs, será difícil executá -los.

A razão pela qual este aplicativo existe é (a) eu queria implementá-lo sozinho para ver como funciona ergonomicamente e (b) eu queria fornecer uma camada muito simples para interagir com essas coisas sem ter que me preocupar em configurar o PyTorch e Transformadores localmente.

Você apenas instala o aplicativo, baixa um modelo e pronto.

Este aplicativo requer um computador moderadamente recente para funcionar. No entanto, este aplicativo depende de LLMs, que são notoriamente ávidos por energia. Portanto, o hardware do seu computador ditará quais modelos você pode executar.

Os modelos de tamanho “normal” provavelmente precisarão de uma placa gráfica dedicada com algo entre 6 e 18 GB de memória de vídeo, a menos que você esteja disposto a esperar mais de um segundo por palavra.

Muitos modelos hoje em dia vêm em formato quantizado, o que torna os modelos maiores também disponíveis para hardware mais antigo ou menos potente. A quantização às vezes reduz bastante os requisitos do sistema, mesmo de modelos muito grandes, sem muitas perdas de qualidade (mas sua milhagem pode variar de modelo para modelo).

Importante

Como é um modelo de linguagem grande, a geração de respostas levará um pouco de tempo. Portanto, especialmente se você não tiver uma GPU dedicada em seu computador, seja paciente ou experimente um modelo menor.

Dica

Você pode encontrar a documentação completa no site do aplicativo.

A interface do usuário é separada em três componentes principais:

Este código é licenciado via GNU GPL 3.0. Leia mais no arquivo LICENSE.