Algoritmos de auditoria incríveis

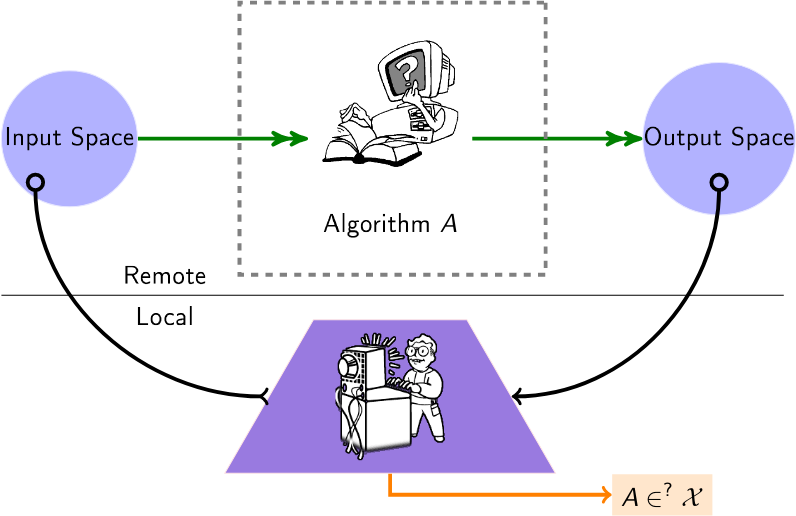

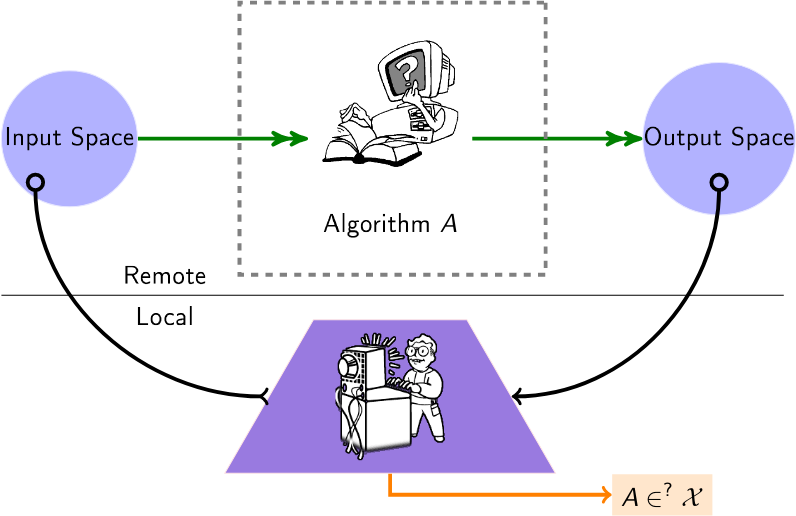

Uma lista selecionada de algoritmos para auditar algoritmos de caixa preta. Hoje em dia, muitos algoritmos (recomendação, pontuação, classificação) são operados em fornecedores terceiros, sem que os utilizadores ou instituições tenham qualquer conhecimento sobre como operam com os seus dados. Os algoritmos de auditoria nesta lista aplicam-se, portanto, a esta configuração, denominada configuração de "caixa preta", onde um auditor deseja obter alguns insights sobre esses algoritmos remotos.

Um usuário consulta um algoritmo remoto (por exemplo, por meio de APIs disponíveis) para inferir informações sobre esse algoritmo.

Conteúdo

- Artigos

- Eventos Relacionados (conferências/workshops)

Artigos

2024

- Auditar explicações locais é difícil - (NeurIPS) Fornece a complexidade de consulta (proibitiva) das explicações de auditoria.

- LLMs também alucinam gráficos: uma perspectiva estrutural - (redes complexas) Consulta LLMs em busca de gráficos conhecidos e estuda alucinações topológicas. Propõe uma classificação de alucinação estrutural.

- Auditoria de justiça com colaboração multiagente - (ECAI) Considera vários agentes trabalhando juntos, cada um auditando a mesma plataforma para tarefas diferentes.

- Mapeando o Campo da Auditoria de Algoritmos: Uma Revisão Sistemática da Literatura Identificando Tendências de Pesquisa, Disparidades Linguísticas e Geográficas - (Arxiv) Revisão sistemática de estudos de auditoria de algoritmos e identificação de tendências em suas abordagens metodológicas.

- FairProof: Justiça Confidencial e Certificada para Redes Neurais - (Arxiv) Propõe um paradigma alternativo à auditoria tradicional usando ferramentas criptográficas como Provas de Conhecimento Zero; fornece um sistema chamado FairProof para verificar a imparcialidade de pequenas redes neurais.

- Sob manipulações, alguns modelos de IA são mais difíceis de auditar? - (SATML) Relaciona a dificuldade das auditorias caixa preta com a capacidade dos modelos alvo, utilizando a complexidade Rademacher.

- Ataques de inferência de associação aprimorados contra modelos de classificação de linguagem - (ICLR) Apresenta uma estrutura para executar ataques de inferência de associação contra classificador, em modo de auditoria.

- Auditoria de justiça por apostas - (Neurips) [Código] Métodos sequenciais que permitem o monitoramento contínuo dos dados recebidos de um classificador ou regressor caixa preta.

2023

- Auditoria de privacidade com uma (1) execução de treinamento - (NeurIPS - melhor artigo) Um esquema para auditar sistemas de aprendizado de máquina diferencialmente privados com uma única execução de treinamento.

- Auditar a justiça sob o desconhecimento através do raciocínio contrafactual - (Processamento e Gestão da Informação) Mostra como desvendar se um modelo de caixa preta, em conformidade com os regulamentos, ainda é tendencioso ou não.

- XAudit: Um olhar teórico sobre auditoria com explicações - (Arxiv) Formaliza o papel das explicações na auditoria e investiga se e como as explicações do modelo podem ajudar as auditorias.

- Acompanhando os modelos de linguagem: interação robustez-viés em dados e modelos NLI - (Arxiv) Propõe uma maneira de estender a vida útil de conjuntos de dados de auditoria usando os próprios modelos de linguagem; também encontra problemas com as atuais métricas de auditoria de preconceito e propõe alternativas - essas alternativas destacam que a fragilidade do modelo aumentou superficialmente as pontuações de preconceito anteriores.

- Auditoria de imparcialidade online por meio de refinamento iterativo - (KDD) Fornece um processo adaptativo que automatiza a inferência de garantias probabilísticas associadas à estimativa de métricas de imparcialidade.

- Roubando os algoritmos de decodificação de modelos de linguagem - (CCS) Roube o tipo e os hiperparâmetros dos algoritmos de decodificação de um LLM.

- Modelando tocas de coelho no YouTube - (SNAM) Modela a dinâmica de captura de usuários em tocas de coelho no YouTube e fornece uma medida desse recinto.

- Auditando o algoritmo de recomendação do YouTube para bolhas de filtro de desinformação - (transações em sistemas de recomendação) O que é necessário para “estourar a bolha”, ou seja, reverter a bolha das recomendações.

- Auditando a classificação de negócios e recomendação de revisão do Yelp através da lente da justiça - (Arxiv) Audita a justiça da classificação de negócios do Yelp e dos sistemas de recomendação de revisão, com paridade demográfica, exposição e testes estatísticos, como regressão linear quantílica e logística.

- Confidential-PROFITT: PROof Confidential of FaIr Training of Trees - (ICLR) Propõe algoritmos de aprendizagem de árvores de decisão justas juntamente com protocolos de prova de conhecimento zero para obter uma prova de justiça no servidor auditado.

- SCALE-UP: Uma detecção eficiente de backdoor em nível de entrada de caixa preta por meio da análise de consistência de previsão em escala - (ICLR) Considera a detecção de backdoor sob a configuração de caixa preta em aplicativos de aprendizado de máquina como serviço (MLaaS).

2022

- Duas Faces: Auditoria Adversarial de Sistemas Comerciais de Reconhecimento Facial - (ICWSM) Realiza uma auditoria adversarial em APIs e conjuntos de dados de vários sistemas, fazendo uma série de observações preocupantes.

- Ampliando auditorias de mecanismos de pesquisa: insights práticos para auditoria de algoritmos - (Journal of Information Science) (Código) Audita vários mecanismos de pesquisa usando comportamento de navegação simulado com agentes virtuais.

- Uma raspa de limão: em direção a distâncias de modelo independentes de arquitetura - (ICLR) Mede a distância entre dois modelos remotos usando LIME.

- Active Fairness Auditing - (ICML) Estudos de algoritmos de auditoria baseados em consultas que podem estimar a paridade demográfica de modelos de ML de maneira eficiente em termos de consulta.

- Veja a variação! Explicações eficientes de caixa preta com análise de sensibilidade baseada em Sobol - (NeurIPS) Os índices Sobol fornecem uma maneira eficiente de capturar interações de ordem superior entre regiões de imagem e suas contribuições para a previsão de uma rede neural (caixa preta) através das lentes de variância.

- Seus ecos são ouvidos: rastreamento, criação de perfil e segmentação de anúncios no ecossistema Amazon Smart Speaker - (arxiv) Infere um link entre o sistema Amazon Echo e o algoritmo de segmentação de anúncios.

2021

- Quando o árbitro também é um jogador: preconceito nas recomendações de produtos de marca própria em mercados de comércio eletrônico - (FAccT) Os produtos de marca própria da Amazon recebem uma parcela injusta de recomendações e, portanto, são favorecidos em comparação com produtos de terceiros?

- Auditoria diária de algoritmos: entendendo o poder dos usuários diários em revelar comportamentos algorítmicos prejudiciais - (CHI) Defende a "auditoria algorítmica diária" por parte dos usuários.

- Auditoria de modelos de previsão de caixa preta para conformidade de minimização de dados - (NeurIPS) Mede o nível de minimização de dados satisfeito pelo modelo de previsão usando um número limitado de consultas.

- Definindo o registro mais direto sobre o banimento de sombra - (INFOCOM) (Código) Considera a possibilidade de banimento de sombra no Twitter (ou seja, o algoritmo de caixa preta de moderação) e mede a probabilidade de diversas hipóteses.

- Extraindo dados de treinamento de modelos de linguagem grande - (Segurança USENIX) Extraia sequências de texto textuais dos dados de treinamento do modelo GPT-2.

- FairLens: Auditando sistemas de suporte à decisão clínica de caixa preta - (Processamento e gerenciamento de informações) Apresenta um pipeline para detectar e explicar possíveis problemas de justiça no Clinical DSS, comparando diferentes medidas de disparidade de classificação multi-rótulo.

- Auditoria de viés algorítmico no Twitter - (WebSci).

- Execução de algoritmo bayesiano: estimando propriedades computáveis de funções de caixa preta usando informações mútuas - (ICML) Um procedimento de otimização bayesiana e com orçamento limitado para extrair propriedades de um algoritmo de caixa preta.

2020

- Black-Box Ripper: Copiando modelos de caixa preta usando algoritmos evolutivos generativos - (NeurIPS) Replica a funcionalidade de um modelo neural de caixa preta, mas sem limite na quantidade de consultas (através de um esquema professor/aluno e uma pesquisa evolutiva) .

- Auditar caminhos de radicalização em - (FAT*) Estuda a acessibilidade de canais radicais entre si, utilizando passeios aleatórios em recomendações de canais estáticos.

- Extração de modelo adversário em redes neurais de grafos - (Workshop AAAAI sobre aprendizado profundo em grafos: metodologias e aplicações) Apresenta a extração de modelo GNN e apresenta uma abordagem preliminar para isso.

- A explicabilidade remota enfrenta o problema do segurança - (Nature Machine Intelligence volume 2, páginas 529–539) (Código) Mostra a impossibilidade (com uma solicitação) ou a dificuldade de detectar mentiras nas explicações de uma decisão remota de IA.

- GeoDA: uma estrutura geométrica para ataques adversários de caixa preta - (CVPR) (Código) Cria exemplos adversários para enganar modelos, em uma configuração de caixa preta pura (sem gradientes, apenas classe inferida).

- O Jogo da Imitação: Seleção de Algoritmos Explorando o Recomendador Caixa Preta - (Netys) (Código) Parametrizar um algoritmo de recomendação local imitando a decisão de um algoritmo remoto e melhor treinado.

- Auditoria de sistemas de curadoria de notícias: um estudo de caso examinando a lógica algorítmica e editorial no Apple News - (ICWSM) Estudo de auditoria do Apple News como um sistema de curadoria de notícias sociotécnicas (seção de histórias de tendências).

- Algoritmos de Auditoria: Sobre Lições Aprendidas e os Riscos da Minimização de Dados - (AIES) Uma auditoria prática para um aplicativo de recomendação de bem-estar desenvolvido pela Telefónica (principalmente sobre preconceito).

- Extraindo dados de treinamento de modelos de linguagem grandes - (arxiv) Executa um ataque de extração de dados de treinamento para recuperar exemplos de treinamento individuais consultando o modelo de linguagem.

2019

- Adversarial Frontier Stitching for Remote Neural Network Watermarking - (Neural Computing and Applications) (Implementação alternativa) Verifique se um modelo de aprendizado de máquina remoto é "vazado": por meio de solicitações de API padrão para um modelo remoto, extraia (ou não) um zero- marca d'água bit, que foi inserida para marcar modelos valiosos (por exemplo, grandes redes neurais profundas).

- Redes Knockoff: Roubando Funcionalidade de Modelos de Caixa Preta - (CVPR) Pergunte até que ponto um adversário pode roubar funcionalidade de tais modelos de "vítimas" com base apenas em interações de caixa preta: entrada de imagem, saída de previsões.

- Abrindo a caixa preta: auditando o algoritmo de notícias principais do Google - (Flairs-32) Auditoria do painel de notícias principais do Google que fornece insights sobre suas escolhas algorítmicas para selecionar e classificar editores de notícias

- Tornando os ataques de evasão de caixa preta direcionados eficazes e eficientes - (arXiv) Investiga como um adversário pode usar de maneira otimizada seu orçamento de consulta para ataques de evasão direcionados contra redes neurais profundas.

- Aprendizagem on-line para medir a compatibilidade de incentivos em leilões de anúncios - (WWW) Mede os mecanismos de compatibilidade de incentivos (IC) (arrependimento) de plataformas de leilão de caixa preta.

- TamperNN: Detecção Eficiente de Adulteração de Redes Neurais Implantadas - (ISSRE) Algoritmos para criar entradas que podem detectar a violação com um modelo classificador executado remotamente.

- Ataques de extração de modelo de rede neural em dispositivos de borda por meio de dicas de arquitetura - (arxiv) Através da aquisição de eventos de acesso à memória a partir de espionagem de barramento, identificação de sequência de camada pelo modelo LSTM-CTC, conexão de topologia de camada de acordo com o padrão de acesso à memória e estimativa de dimensão de camada sob restrições de volume de dados, demonstra que é possível recuperar com precisão uma arquitetura de rede semelhante ao ponto de partida do ataque

- Roubando conhecimento de redes neurais profundas protegidas usando dados compostos não rotulados - (ICNN) Método composto que pode ser usado para atacar e extrair o conhecimento de um modelo de caixa preta, mesmo que oculte completamente sua saída softmax.

- Inversão de Rede Neural em Ambiente Adversário via Alinhamento de Conhecimento Básico - (CCS) Abordagem de inversão de modelo no ambiente adversário com base no treinamento de um modelo de inversão que atua como um inverso do modelo original. Sem conhecimento completo sobre os dados de treinamento originais, uma inversão precisa ainda é possível treinando o modelo de inversão em amostras auxiliares extraídas de uma distribuição de dados mais genérica.

2018

- Explicações contrafactuais sem abrir a caixa preta: decisões automatizadas e o GDPR - (Harvard Journal of Law & Technology) Para explicar uma decisão sobre x, encontre um contrafactual: o ponto mais próximo de x que altera a decisão.

- Destilar e comparar: auditando modelos de caixa preta usando destilação de modelo transparente - (AIES) Trata modelos de caixa preta como professores, treinando modelos de alunos transparentes para imitar as pontuações de risco atribuídas por modelos de caixa preta.

- Rumo a redes neurais de caixa preta de engenharia reversa - (ICLR) (Código) Inferir hiperparâmetros internos (por exemplo, número de camadas, tipo de ativação não linear) de um modelo de rede neural remota analisando seus padrões de resposta a certas entradas.

- Ataques exploratórios baseados em dados em classificadores de caixa preta em domínios adversários - (Neurocomputação) Engenharia reversa de modelos de classificadores remotos (por exemplo, para escapar de um teste CAPTCHA).

- xGEMs: Gerando exemplos para explicar modelos de caixa preta - (arXiv) Pesquisa preconceitos no modelo de caixa preta treinando um modelo generativo implícito não supervisionado. Em seguida, resume quantitativamente o comportamento do modelo de caixa preta, perturbando amostras de dados ao longo da variedade de dados.

- Aprendendo redes a partir de semelhanças de nós baseados em caminhada aleatória - (NIPS) Reverter gráficos observando alguns tempos de deslocamento de caminhada aleatória.

- Identificando a família de aprendizado de máquina a partir de modelos de caixa preta - (CAEPIA) Determina que tipo de modelo de aprendizado de máquina está por trás das previsões retornadas.

- Roubar redes neurais por meio de canais laterais de temporização - (arXiv) Roubar/aproximar um modelo por meio de ataques de temporização usando consultas.

- Copycat CNN: Roubando conhecimento ao persuadir a confissão com dados aleatórios não rotulados - (IJCNN) (Código) Roubando conhecimento de modelos de caixa preta (CNNs), consultando-os com imagens naturais aleatórias (ImageNet e Microsoft-COCO).

- Auditando a Personalização e Composição de Páginas de Resultados de Mecanismos de Pesquisa Politicamente Relacionadas - (WWW) Uma extensão do Chrome para pesquisar participantes e coletar as páginas de resultados de mecanismos de pesquisa (SERPs) e sugestões de preenchimento automático, para estudar personalização e composição.

2017

- Descobrindo livros de receitas de influência: Engenharia reversa do impacto topológico em serviços de classificação de pares - (CSCW) Visa identificar quais métricas de centralidade estão em uso em um serviço de classificação de pares.

- A face topológica da recomendação: modelos e aplicação à detecção de viés - (Redes Complexas) Propõe uma estrutura de detecção de viés para itens recomendados aos usuários.

- Ataques de inferência de membros contra modelos de aprendizado de máquina - (Simpósio sobre segurança e privacidade) Dado um modelo de aprendizado de máquina e um registro, determine se esse registro foi usado como parte do conjunto de dados de treinamento do modelo ou não.

- Ataques práticos de caixa preta contra aprendizado de máquina - (Ásia CCS) Entenda quão vulnerável é um serviço remoto a ataques de classificação adversários.

2016

- Transparência Algorítmica via Influência Quantitativa de Entrada: Teoria e Experimentos com Sistemas de Aprendizagem - (IEEE S&P) Avaliar a influência individual, conjunta e marginal de recursos em um modelo usando valores shapley.

- Auditoria de modelos de caixa preta para influência indireta - (ICDM) Avalie a influência de uma variável em um modelo de caixa preta removendo-a "habilmente" do conjunto de dados e observando a lacuna de precisão

- Projeção iterativa de recursos ortogonais para diagnóstico de viés em modelos de caixa preta - (Workshop FATML) Executa classificação de recursos para analisar modelos de caixa preta

- Preconceito em mercados autônomos on-line: evidências do TaskRabbit - (workshop dat) Mede a classificação do algoritmo de pesquisa do TaskRabbit.

- Roubar modelos de aprendizado de máquina por meio de APIs de previsão - (Segurança Usenix) (Código) Visa extrair modelos de aprendizado de máquina em uso por serviços remotos.

- “Por que devo confiar em você?” Explicando as previsões de qualquer classificador - (arXiv) (Código) Explica um modelo de classificador de caixa preta por amostragem em torno de instâncias de dados.

- De volta ao preto: rumo à análise formal de caixa preta de desinfetantes e filtros - (Segurança e privacidade) Análise de caixa preta de desinfetantes e filtros.

- Transparência Algorítmica via Influência Quantitativa de Entradas: Teoria e Experimentos com Sistemas de Aprendizagem - (Segurança e Privacidade) Introduz medidas que capturam o grau de influência das entradas nas saídas do sistema observado.

- Uma análise empírica de preços algorítmicos no Amazon Marketplace - (WWW) (Código) Desenvolve uma metodologia para detectar preços algorítmicos e usá-la empiricamente para analisar sua prevalência e comportamento no Amazon Marketplace.

2015

- Certificando e Removendo Impactos Disparados - (SIGKDD) Propõe métodos baseados em SVM para certificar a ausência de preconceitos e métodos para remover preconceitos de um conjunto de dados.

- Espreitando sob o capô do Uber - (IMC) Inferir detalhes de implementação do algoritmo de aumento de preço do Uber.

2014

- Uma espiada na caixa preta: explorando classificadores por randomização - (Diário de mineração de dados e descoberta de conhecimento) (código) Encontra grupos de recursos que podem ser permutados sem alterar o rótulo de saída das amostras previstas

- XRay: Melhorando a Transparência da Web com Correlação Diferencial - (Segurança USENIX) Audita quais dados de perfil de usuário foram usados para direcionar um determinado anúncio, recomendação ou preço.

2013

- Medindo a Personalização de Pesquisa na Web - (WWW) Desenvolve uma metodologia para medir a personalização em resultados de pesquisa na Web.

- Auditoria: Aprendizado Ativo com Custos de Consulta Dependentes do Resultado - (NIPS) Aprende com um classificador binário pagando apenas por rótulos negativos.

2012

- Estratégias de consulta para evitar classificadores indutores convexos - (JMLR) Métodos de evasão para classificadores convexos. Considera a complexidade da evasão.

2008

- Privacy Oracle: um sistema para encontrar vazamentos de aplicativos com testes diferenciais de caixa preta - (CCS) Privacy Oracle: um sistema que descobre vazamentos de informações pessoais de aplicativos em transmissões para servidores remotos.

2005

- Adversarial Learning - (KDD) Engenharia reversa de classificadores lineares remotos, usando consultas de associação.

Eventos Relacionados

2024

- 1ª Conferência Internacional sobre Auditoria e Inteligência Artificial

- Workshop sobre ML regulável (RegML'24)

2023

- Apoiando o envolvimento do usuário em testes, auditoria e contestação de IA (Auditoria de IA de usuário CSCW)

- Workshop sobre Auditorias Algorítmicas de Algoritmos (WAAA)

- Workshop sobre ML regulável (RegML'23)