Compilação Ofensiva de IA

Uma lista selecionada de recursos úteis que cobrem IA ofensiva.

? Conteúdo?

- Abuso

- ? Aprendizado de máquina adversário?

- ⚡ Ataques ⚡

- Extração

- ️ Limitações ️

- ?️ Ações defensivas ?️

- ? Links úteis?

- ⬅️ Inversão (ou inferência) ⬅️

- ?️ Ações defensivas ?️

- ? Links úteis?

- ? Envenenamento?

- ? Portas dos fundos?

- ?️ Ações defensivas ?️

- ? Links úteis?

- ?♂️ Evasão ?♂️

- ?️ Ações defensivas ?️

- ? Links úteis?

- Ferramentas

- ? Usar ?

- ♂️ Pentesting ♂️

- ? Malware?

- ?️ OSINT ?️

- ? Phishing?

- ?? IA generativa ??

- ? Áudio?

- Ferramentas

- Aplicativos

- ? Detecção?

- ? Imagem?

- Ferramentas

- Aplicativos

- ? Detecção?

- ? Vídeo ?

- Ferramentas

- Aplicativos

- ? Detecção?

- ? Texto ?

- Ferramentas

- ? Detecção?

- Aplicativos

- Diversos

- Pesquisas

- ? Contribuintes?

- ©️ Licença ©️

Abuso

Explorando as vulnerabilidades dos modelos de IA.

? Aprendizado de máquina adversário?

O Adversarial Machine Learning é responsável por avaliar seus pontos fracos e fornecer contramedidas.

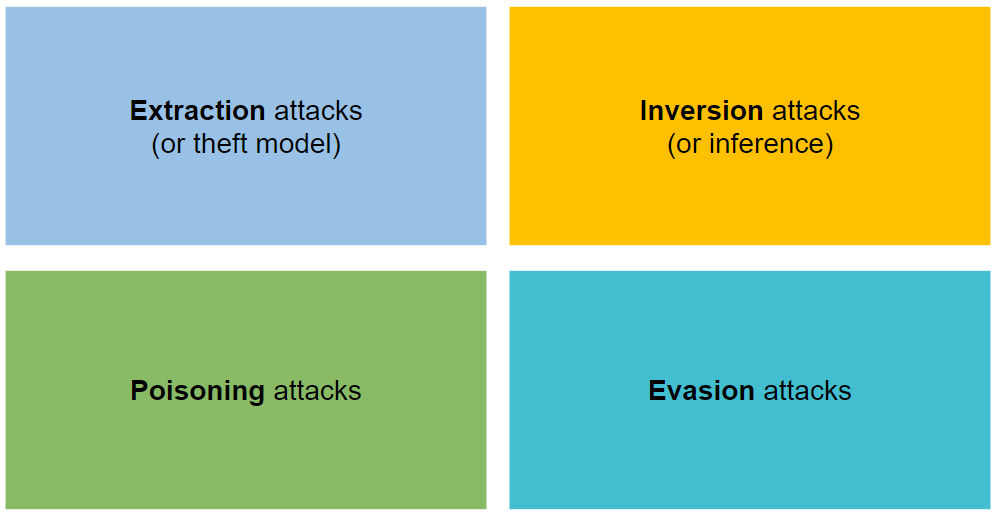

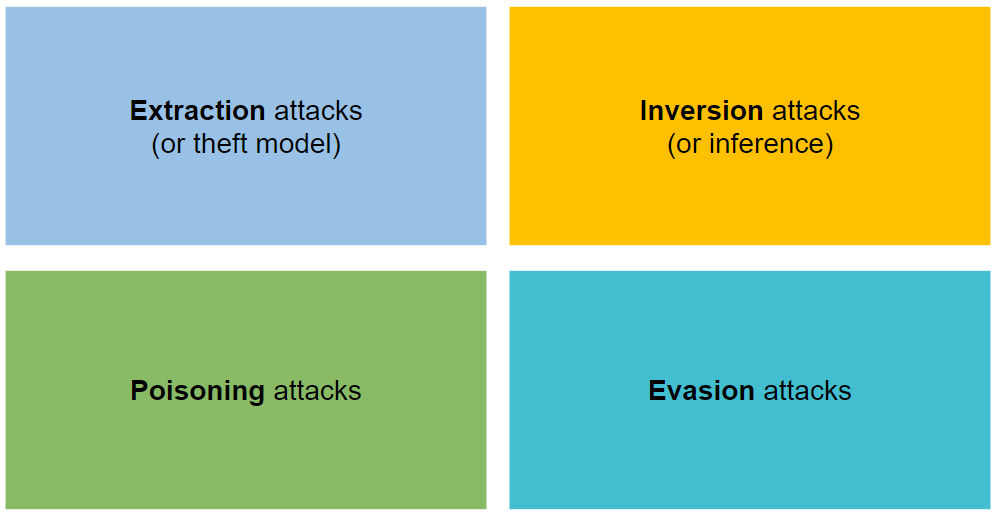

⚡ Ataques ⚡

Está organizado em quatro tipos de ataques: extração, inversão, envenenamento e evasão.

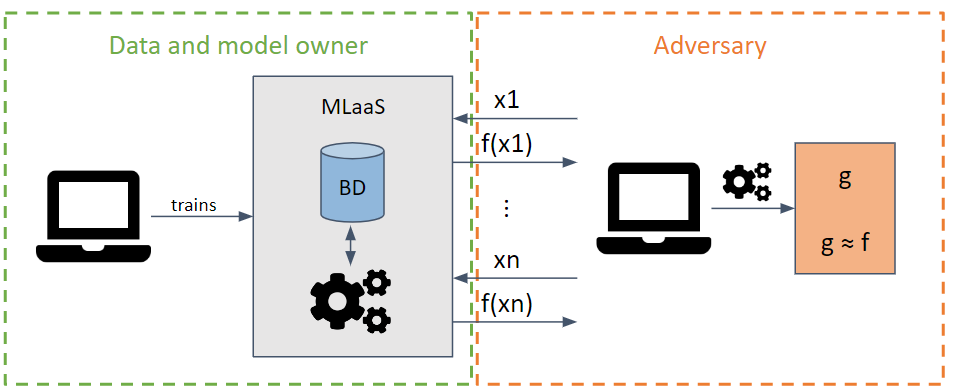

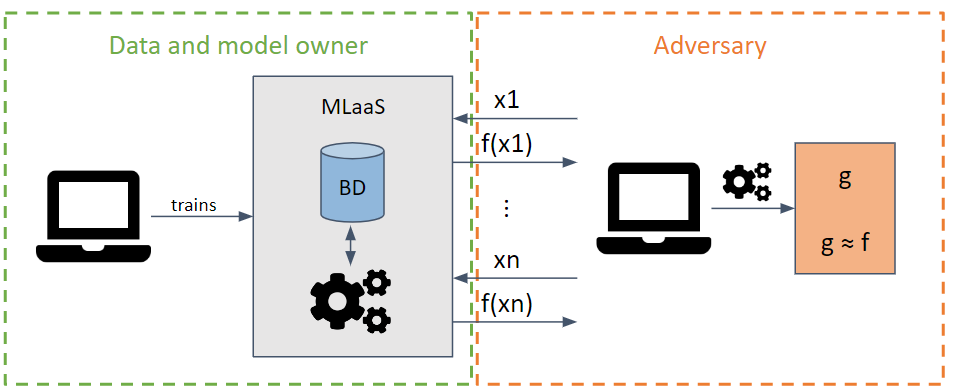

Extração

Ele tenta roubar os parâmetros e hiperparâmetros de um modelo fazendo solicitações que maximizem a extração de informações.

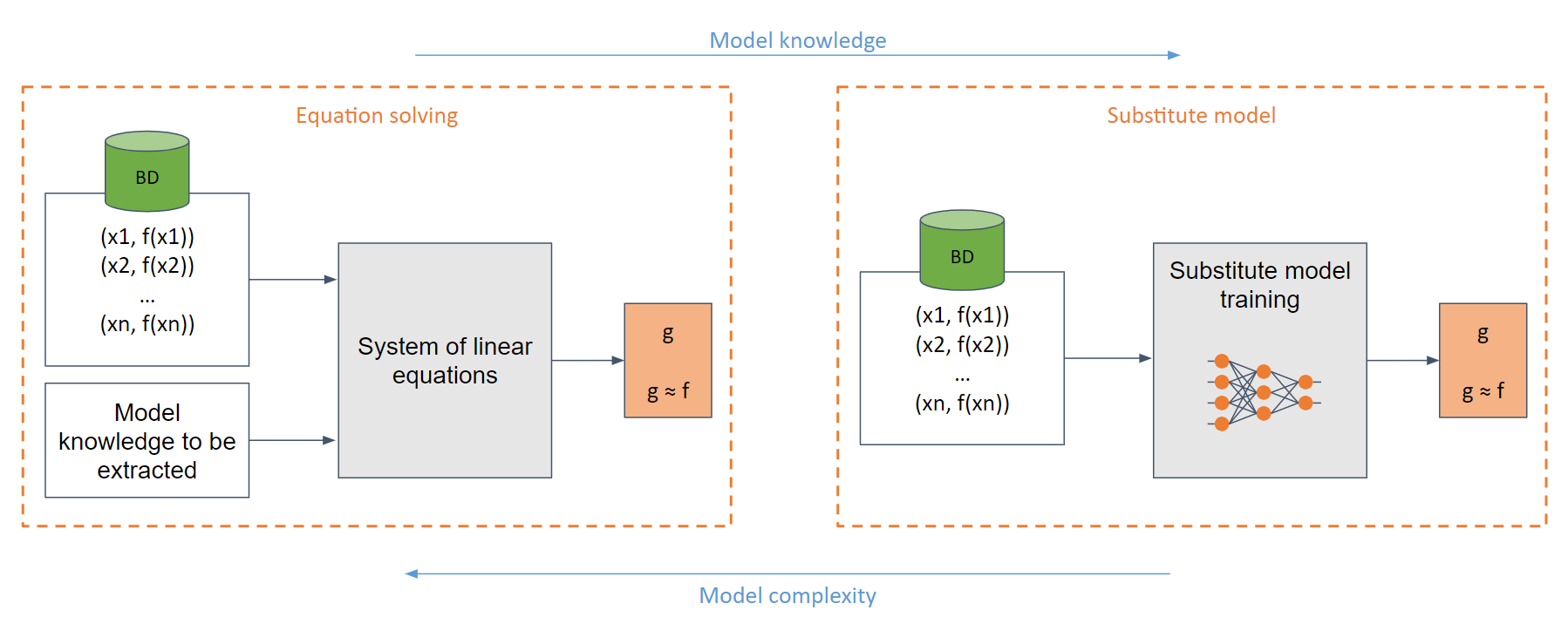

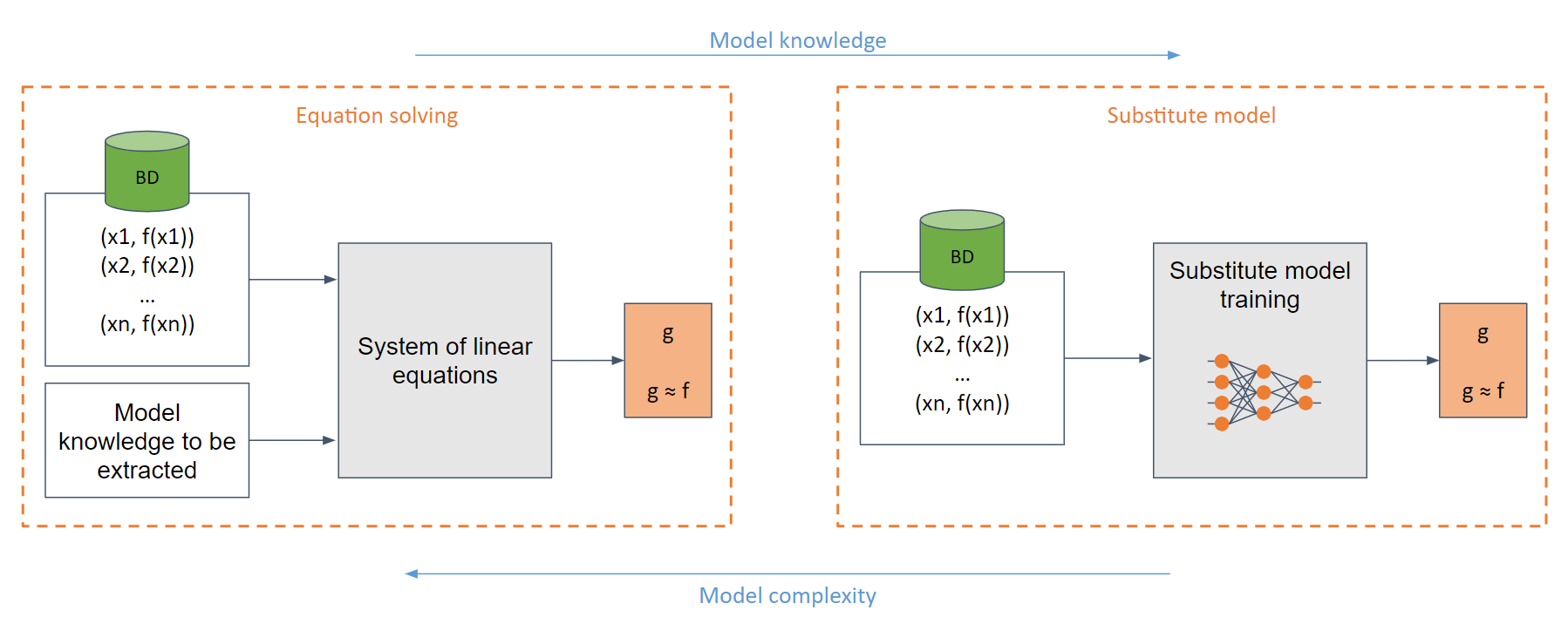

Dependendo do conhecimento do modelo do adversário, podem ser realizados ataques de caixa branca e de caixa preta.

No caso mais simples de caixa branca (quando o adversário tem pleno conhecimento do modelo, por exemplo, uma função sigmóide), pode-se criar um sistema de equações lineares que pode ser facilmente resolvido.

No caso genérico, onde há conhecimento insuficiente do modelo, utiliza-se o modelo substituto. Este modelo é treinado com as solicitações feitas ao modelo original para imitar a mesma funcionalidade do original.

️ Limitações ️

Treinar um modelo substituto é equivalente (em muitos casos) a treinar um modelo do zero.

Muito computacionalmente intensivo.

O adversário tem limitações quanto ao número de solicitações antes de ser detectado.

?️ Ações defensivas ?️

Arredondamento dos valores de saída.

Uso de privacidade diferencial.

Uso de conjuntos.

Uso de defesas específicas

- Arquiteturas específicas

- PRADA

- Desinformação adaptativa

- ...

? Links úteis?

- Roubando modelos de aprendizado de máquina por meio de APIs de previsão

- Roubando hiperparâmetros em aprendizado de máquina

- Redes Knockoff: Roubando Funcionalidade de Modelos de Caixa Preta

- Aviso de extração de modelo no paradigma MLaaS

- Copycat CNN: Roubando conhecimento ao persuadir a confissão com dados aleatórios não rotulados

- Envenenamento por previsão: em direção a defesas contra ataques de roubo de modelo DNN

- Roubando redes neurais por meio de canais laterais de temporização

- Modelo de ataques de roubo contra redes neurais de grafos indutivos

- Extração de redes neurais de alta precisão e alta fidelidade

- Envenenar conjuntos de dados de treinamento em escala web é prático

- Extração criptoanalítica em tempo polinomial de modelos de redes neurais

- Ataques de envenenamento específicos de prompt em modelos geradores de texto para imagem

- Incríveis ataques de backdoor e envenenamento de dados: uma lista selecionada de artigos e recursos vinculados a envenenamento de dados, ataques de backdoor e defesas contra eles.

- BackdoorBox: uma caixa de ferramentas Python de código aberto para ataques e defesas backdoor.

- Roubando parte de um modelo de linguagem de produção

- Extração criptoanalítica de rótulo rígido de modelos de redes neurais

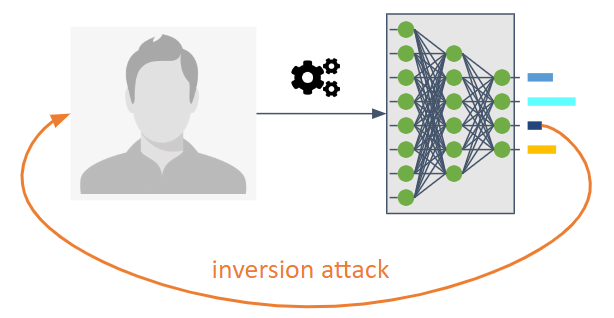

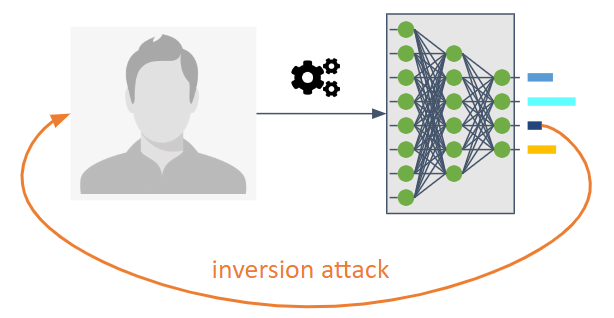

⬅️ Inversão (ou inferência) ⬅️

O objetivo deles é reverter o fluxo de informações de um modelo de aprendizado de máquina.

Eles permitem que um adversário conheça o modelo que não foi explicitamente planejado para ser compartilhado.

Eles nos permitem conhecer os dados ou informações de treinamento como propriedades estatísticas do modelo.

Três tipos são possíveis:

Ataque de inferência de membros (MIA) : um adversário tenta determinar se uma amostra foi empregada como parte do treinamento.

Ataque de inferência de propriedade (PIA) : um adversário visa extrair propriedades estatísticas que não foram explicitamente codificadas como recursos durante a fase de treinamento.

Reconstrução : Um adversário tenta reconstruir uma ou mais amostras do conjunto de treinamento e/ou seus rótulos correspondentes. Também chamada de inversão.

?️ Ações defensivas ?️

Uso de criptografia avançada. As contramedidas incluem privacidade diferencial, criptografia homomórfica e computação multipartidária segura.

Utilização de técnicas de regularização como o Dropout devido à relação entre overtraining e privacidade.

A compressão do modelo foi proposta como defesa contra ataques de reconstrução.

? Links úteis?

- Ataques de inferência de membros contra modelos de aprendizado de máquina

- Ataques de inversão de modelos que exploram informações de confiança e contramedidas básicas

- Modelos de aprendizado de máquina que lembram muito

- ML-Leaks: ataques e defesas de inferência de membros independentes de modelo e dados em modelos de aprendizado de máquina

- Modelos profundos sob o GAN: vazamento de informações do aprendizado profundo colaborativo

- LOGAN: Ataques de inferência de membros contra modelos generativos

- Overfitting, robustez e algoritmos maliciosos: um estudo das possíveis causas de risco à privacidade no aprendizado de máquina

- Análise abrangente de privacidade de aprendizado profundo: aprendizado autônomo e federado sob ataques de inferência de caixa branca passivos e ativos

- Ataques de inferência contra a aprendizagem colaborativa

- The Secret Sharer: avaliando e testando memorização não intencional em redes neurais

- Rumo à ciência da segurança e privacidade no aprendizado de máquina

- MemGuard: Defesa contra ataques de inferência de membros de caixa preta por meio de exemplos adversários

- Extraindo dados de treinamento de grandes modelos de linguagem

- Ataques de inferência de propriedade em redes neurais totalmente conectadas usando representações invariantes de permutação

- Extraindo dados de treinamento de modelos de difusão

- Reconstrução de imagens de alta resolução com modelos de difusão latente da atividade cerebral humana

- Roubar e escapar de classificadores de malware e antivírus em condições de falsos positivos baixos

- Ataques realistas de apresentação de impressões digitais baseados em uma abordagem adversária

- Testes Adversariais Ativos: Aumentando a Confiança nas Avaliações de Robustez Adversarial.

- Status do Jailbreak GPT: Atualizações sobre o status do jailbreak do modelo de linguagem OpenAI GPT.

- Aceleração de ordem de magnitude para inferência de membros LLM

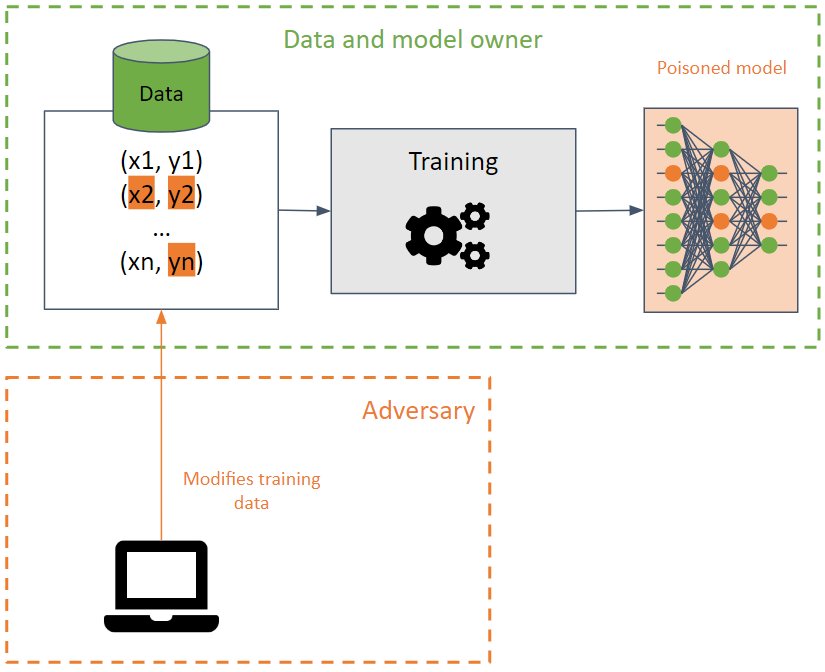

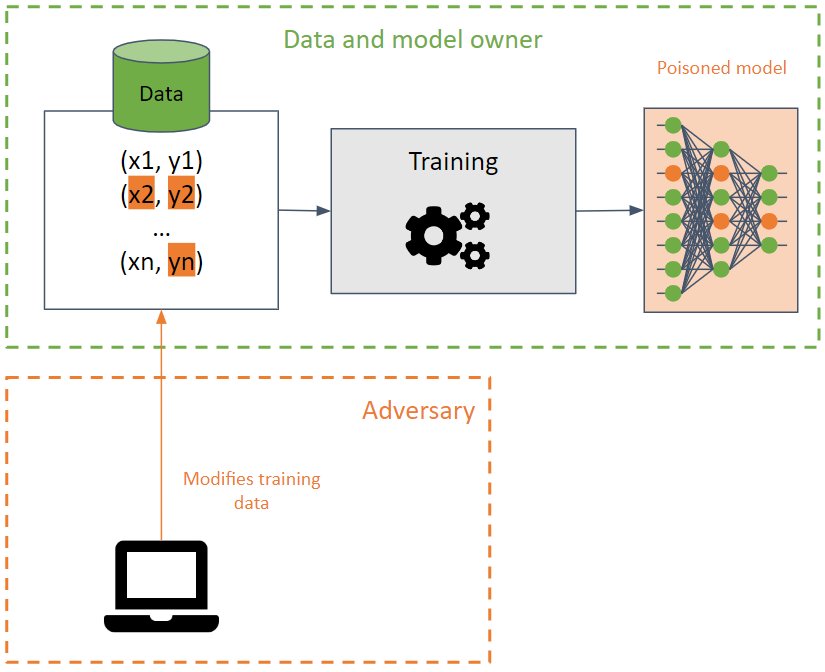

? Envenenamento?

Eles visam corromper o conjunto de treinamento, fazendo com que um modelo de aprendizado de máquina reduza sua precisão.

Este ataque é difícil de detectar quando executado nos dados de treinamento, pois o ataque pode se propagar entre diferentes modelos usando os mesmos dados de treinamento.

O adversário procura destruir a disponibilidade do modelo modificando o limite de decisão e, como resultado, produzindo previsões incorretas ou criando uma backdoor em um modelo. Neste último, o modelo se comporta corretamente (retornando as previsões desejadas) na maioria dos casos, exceto para determinados inputs especialmente criados pelo adversário que produzem resultados indesejados. O adversário pode manipular os resultados das previsões e lançar ataques futuros.

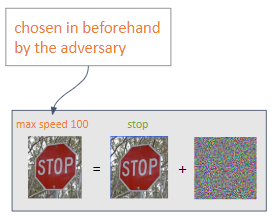

? Portas dos fundos?

BadNets são o tipo mais simples de backdoor em um modelo de aprendizado de máquina. Além disso, BadNets podem ser preservados em um modelo, mesmo que sejam treinados novamente para uma tarefa diferente da do modelo original (transferência de aprendizagem).

É importante observar que modelos públicos pré-treinados podem conter backdoors .

?️ Ações defensivas ?️

Detecção de dados envenenados, juntamente com o uso de sanitização de dados.

Métodos de treinamento robustos.

Defesas específicas.

- Limpeza Neural: Identificando e Mitigando Ataques Backdoor em Redes Neurais

- STRIP: Uma defesa contra ataques de Trojan em redes neurais profundas

- Detectando ataques backdoor em redes neurais profundas por cluster de ativação

- ABS: Varredura de redes neurais em busca de portas traseiras por estimulação cerebral artificial

- DeepInspect: uma estrutura de detecção e mitigação de cavalos de Troia de caixa preta para redes neurais profundas

- Defesa de backdoors neurais por meio de modelagem de distribuição generativa

- Uma pesquisa abrangente sobre ataques backdoor e suas defesas em sistemas de reconhecimento facial

- DataElixir: purificando conjunto de dados envenenados para mitigar ataques backdoor por meio de modelos de difusão

? Links úteis?

- Ataques de envenenamento contra máquinas de vetores de suporte

- Ataques backdoor direcionados a sistemas de aprendizagem profunda usando envenenamento de dados

- Ataque de trojan em redes neurais

- Poda fina: defesa contra ataques backdoor em redes neurais profundas

- Sapos Venenosos! Ataques direcionados de envenenamento de rótulo limpo em redes neurais

- Assinaturas espectrais em ataques backdoor

- Ataques backdoor latentes em redes neurais profundas

- Regula Sub-rosa: ataques backdoor latentes em redes neurais profundas

- Ataques backdoor de gatilho oculto

- Ataques transferíveis de envenenamento de rótulo limpo em redes neurais profundas

- TABOR: uma abordagem altamente precisa para inspecionar e restaurar backdoors de Trojan em sistemas de IA

- Rumo ao envenenamento de algoritmos de aprendizado profundo com otimização de gradiente posterior

- Quando o aprendizado de máquina FALHA? Transferibilidade generalizada para ataques de evasão e envenenamento

- Defesas Certificadas para Ataques de Envenenamento de Dados

- Ataque backdoor dinâmico com reconhecimento de entrada

- Como fazer backdoor de aprendizagem federada

- Plantando backdoors indetectáveis em modelos de aprendizado de máquina

- Engane a IA!: Hackers podem usar backdoors para envenenar dados de treinamento e fazer com que um modelo de IA classifique imagens incorretamente. Saiba como os pesquisadores da IBM podem saber quando os dados foram envenenados e, em seguida, adivinhar quais backdoors foram ocultados nesses conjuntos de dados. Você consegue adivinhar a porta dos fundos?

- Backdoor Toolbox: Uma caixa de ferramentas compacta para ataques e defesas backdoor.

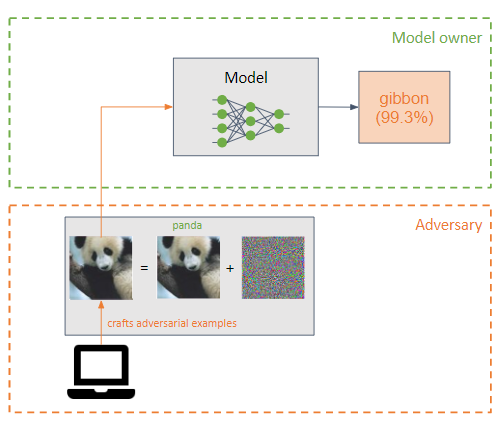

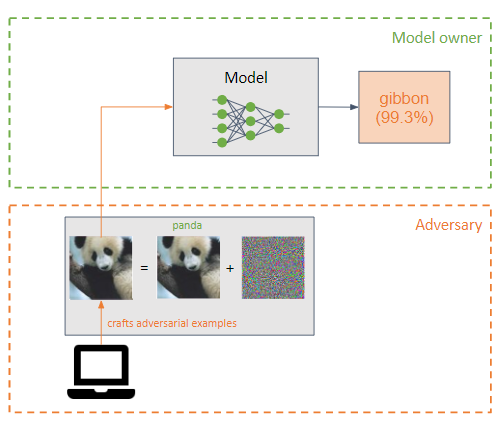

?♂️ Evasão ?♂️

Um adversário adiciona uma pequena perturbação (na forma de ruído) à entrada de um modelo de aprendizado de máquina para classificá-lo incorretamente (exemplo de adversário).

São semelhantes aos ataques de envenenamento, mas a principal diferença é que os ataques de evasão tentam explorar as fraquezas do modelo na fase de inferência.

O objetivo do adversário é que os exemplos adversários sejam imperceptíveis para um ser humano.

Dois tipos de ataque podem ser realizados dependendo da saída desejada pelo oponente:

Os ataques mais comuns são ataques de caixa branca :

- L-BFGS

- FGSM

- BIM

- JSMA

- Carlini & Wagner (C&W)

- NewtonTolo

- EAD

- UAP

?️ Ações defensivas ?️

Treinamento adversário, que consiste na elaboração de exemplos adversários durante o treinamento para permitir que o modelo aprenda características dos exemplos adversários, tornando o modelo mais robusto para esse tipo de ataque.

Transformações em insumos.

Mascaramento/regularização de gradiente. Não é muito eficaz.

Defesas fracas.

Defesas de injeção imediata: Todas as defesas práticas e propostas contra injeção imediata.

Lakera PINT Benchmark: O benchmark Prompt Injection Test (PINT) fornece uma maneira neutra de avaliar o desempenho de um sistema de detecção de injeção imediata, como o Lakera Guard, sem depender de conjuntos de dados públicos conhecidos que essas ferramentas podem usar para otimizar o desempenho da avaliação.

Inferência do Diabo: Um método para avaliar adversamente o modelo Phi-3 Instruct, observando a distribuição da atenção em suas cabeças quando exposto a entradas específicas. Esta abordagem leva o modelo a adoptar a “mentalidade do diabo”, permitindo-lhe gerar resultados de natureza violenta.

? Links úteis?

- Ataques práticos de caixa preta contra aprendizado de máquina

- As limitações do aprendizado profundo em ambientes adversários

- Para avaliar a robustez das redes neurais

- Destilação como defesa contra perturbações adversárias contra redes neurais profundas

- Exemplos adversários no mundo físico

- Treinamento Adversarial Ensemble: Ataques e Defesas

- Rumo a modelos de aprendizagem profunda resistentes a ataques adversários

- Propriedades intrigantes de redes neurais

- Explicando e aproveitando exemplos adversários

- Investigando exemplos adversários transferíveis e ataques de caixa preta

- Aprendizado de máquina adversário em escala

- Ataques adversários de caixa preta com consultas e informações limitadas

- Compressão de recursos: detectando exemplos adversários em redes neurais profundas

- Ataques adversários baseados em decisões: ataques confiáveis contra modelos de aprendizado de máquina de caixa preta

- Impulsionando ataques adversários com impulso

- O espaço dos exemplos adversários transferíveis

- Combatendo imagens adversárias usando transformações de entrada

- Defense-GAN: protegendo classificadores contra ataques adversários usando modelos generativos

- Sintetizando exemplos adversários robustos

- Mitigando efeitos adversários por meio de randomização

- Sobre a detecção de perturbações adversárias

- Patch adversário

- PixelDefend: aproveitando modelos generativos para compreender e se defender contra exemplos adversários

- Ataque de um pixel para enganar redes neurais profundas

- Defesas eficientes contra ataques adversários

- Ataques robustos do mundo físico à classificação visual de aprendizado profundo

- Perturbações adversas contra redes neurais profundas para classificação de malware

- Ataques adversários em 3D além da nuvem de pontos

- Perturbações adversárias enganam detectores de deepfake

- Deepfakes Adversariais: Avaliando a Vulnerabilidade de Detectores de Deepfake a Exemplos Adversariais

- Uma visão geral das vulnerabilidades dos sistemas controlados por voz

- FastWordBug: um método rápido para gerar texto adversário contra aplicativos de PNL

- Fantasma do ADAS: protegendo sistemas avançados de assistência ao motorista contra ataques fantasmas de frações de segundo

- llm-attacks: ataques universais e transferíveis em modelos de linguagem alinhados.

- Ataques a modelos de IA: injeção imediata versus envenenamento da cadeia de suprimentos

- Ataque de injeção imediata contra aplicativos integrados ao LLM

- garak: scanner de vulnerabilidade LLM.

- Transformações Adversariais Simples em PyTorch

- Plug-ins ChatGPT: exfiltração de dados por meio de imagens e falsificação de solicitação cruzada de plug-ins

- Sequestros de imagens: imagens adversárias podem controlar modelos generativos em tempo de execução

- Multiataques: muitas imagens + o mesmo ataque adversário → muitos rótulos de alvo

- ATIVO: Rumo à camuflagem física 3D altamente transferível para evasão de veículos universal e robusta

- LLM Red Teaming GPTS: vazamento de prompt, vazamento de API, vazamento de documentos

- Exemplos adversários produzidos por humanos

- Desafios de Jailbreak Multilíngue em Grandes Modelos de Idiomas

- Uso indevido de ferramentas em grandes modelos de linguagem com exemplos de adversários visuais

- AutoDAN: ataques adversários baseados em gradiente interpretável em grandes modelos de linguagem

- Injeção Multimodal: (Ab) usando Imagens e Sons para Injeção Indireta de Instrução em LLMs Multimodais.

- JailbreakingLLMs: Jailbreaking Black Box Large Language Models em vinte consultas.

- Árvore de ataques: desbloqueio automático de LLMs de caixa preta

- GPTs: prompts vazados de GPTs.

- Explorações de IA: uma coleção de explorações de IA/ML do mundo real para vulnerabilidades divulgadas de forma responsável.

- Agentes LLM podem hackear sites de forma autônoma

- Cloudflare anuncia Firewall para IA

- PromptInject: Estrutura que monta prompts de forma modular para fornecer uma análise quantitativa da robustez dos LLMs a ataques imediatos adversários.

- LLM Red Teaming: abordagens adversárias, de programação e linguísticas VS ChatGPT, Claude, Mistral, Grok, LLAMA e Gemini

- A hierarquia de instruções: treinando LLMs para priorizar instruções privilegiadas

- Injeção imediata / JailBreaking de um agente bancário LLM (GPT-4, Langchain)

- Chat do GitHub Copilot: da injeção imediata à exfiltração de dados

- Exemplos adversários estão desalinhados em variedades de modelos de difusão

- Jailbreak lógico de imagem para texto: sua imaginação pode ajudá-lo a fazer qualquer coisa

- Mitigando Skeleton Key, um novo tipo de técnica generativa de jailbreak de IA

- Benchmark de ofuscação de imagem: este repositório contém o código para avaliar modelos no benchmark de ofuscação de imagem, apresentado pela primeira vez em Benchmarking Robustness to Adversarial Image Obfuscations.

- Desbloqueando grandes modelos de linguagem com matemática simbólica

Ferramentas

| Nome | Tipo | Algoritmos suportados | Tipos de ataque suportados | Ataque/Defesa | Estruturas suportadas | Popularidade |

|---|

| Inteligente | Imagem | Aprendizado profundo | Evasão | Ataque | Tensorflow, Keras, JAX | |

| Caixa de tolos | Imagem | Aprendizado profundo | Evasão | Ataque | Tensorflow, PyTorch, JAX | |

| ARTE | Qualquer tipo (imagem, dados tabulares, áudio,...) | Aprendizado profundo, SVM, LR, etc. | Qualquer (extração, inferência, envenenamento, evasão) | Ambos | Tensorflow, Keras, Pytorch, Scikit Learn | |

| Ataque de texto | Texto | Aprendizado profundo | Evasão | Ataque | Keras, abraçando o rosto | |

| Lanterna publicitária | Imagem | Aprendizado profundo | Evasão | Ambos | --- | |

| AdvBox | Imagem | Aprendizado profundo | Evasão | Ambos | PyTorch, Tensorflow, MxNet | |

| ProfundoRobusto | Imagem, gráfico | Aprendizado profundo | Evasão | Ambos | PyTorch | |

| Contra-ajuste | Qualquer | Qualquer | Evasão | Ataque | --- | |

| Exemplos de áudio adversário | Áudio | Fala Profunda | Evasão | Ataque | --- | |

ARTE

Adversarial Robustness Toolbox, abreviado como ART, é uma biblioteca Adversarial Machine Learning de código aberto para testar a robustez de modelos de aprendizado de máquina.

É desenvolvido em Python e implementa ataques e defesas de extração, inversão, envenenamento e evasão.

ART oferece suporte às estruturas mais populares: Tensorflow, Keras, PyTorch, MxNet e ScikitLearn, entre muitas outras.

Não se limita ao uso de modelos que utilizam imagens como entrada, mas também suporta outros tipos de dados, como áudio, vídeo, dados tabulares, etc.

Workshop para aprender Aprendizado de Máquina Adversarial com ART ??

Inteligente

Cleverhans é uma biblioteca para realizar ataques de evasão e testar a robustez de um modelo de aprendizagem profunda em modelos de imagem.

É desenvolvido em Python e integra-se aos frameworks Tensorflow, Torch e JAX.

Implementa inúmeros ataques como L-BFGS, FGSM, JSMA, C&W, entre outros.

? Usar ?

A IA é usada para realizar tarefas maliciosas e impulsionar ataques clássicos.

♂️ Pentesting ♂️

- GyoiThon: ferramenta de teste de penetração de última geração, ferramenta de coleta de inteligência para servidor web.

- Deep Exploit: ferramenta de teste de penetração totalmente automática usando Deep Reinforcement Learning.

- AutoPentest-DRL: Teste de penetração automatizado usando aprendizado de reforço profundo.

- DeepGenerator: Gere códigos de injeção de forma totalmente automática para avaliação de aplicações web usando Algoritmo Genético e Redes Adversariais Generativas.

- Eyeballer: Eyeballer destina-se a testes de penetração de rede de grande escopo, onde você precisa encontrar alvos "interessantes" em um enorme conjunto de hosts baseados na web.

- Nebulosa: Assistente de Hacking Ético com tecnologia de IA.

- Equipes de agentes LLM podem explorar vulnerabilidades de dia zero

- Insights e lacunas atuais em scanners de vulnerabilidade LLM de código aberto: uma análise comparativa

? Malware?

- DeepLocker: Ocultando ataques direcionados com serralharia de IA, por IBM Labs em BH.

- Uma visão geral da inteligência artificial usada em malware: uma lista selecionada de recursos de malware de IA.

- DeepObfusCode: ofuscação do código-fonte por meio de redes sequência a sequência.

- AutoCAT: Aprendizado por reforço para exploração automatizada de ataques de temporização de cache.

- BOTNET BASEADO EM IA: Uma abordagem teórica de jogos para defesa contra ataques de botnets baseados em IA.

- SECML_Malware: biblioteca Python para criar ataques adversários contra detectores de malware do Windows.

- Liberação transcendente: usando avaliação conforme para detectar desvios de conceito que afetam a detecção de malware.

?️ OSINT ?️

- SNAP_R: Gere automaticamente postagens de spearphishing nas redes sociais.

- SpyScrap: SpyScrap combina métodos de reconhecimento facial para filtrar os resultados e usa processamento de linguagem natural para obter entidades importantes do site que o usuário aparece.

? Phishing?

- DeepDGA: Implementação de DeepDGA: geração e detecção de domínio ajustada pelo adversário.

? Inteligência de ameaças?

- Das areias às mansões: possibilitando a construção automática de ataques cibernéticos em todo o ciclo de vida com LLM

? Canais laterais?

- SCAAML: ataques de canal lateral assistidos com aprendizado de máquina.

?? IA generativa ??

? Áudio?

Ferramentas

- conversão de voz profunda: Redes neurais profundas para conversão de voz (transferência de estilo de voz) no Tensorflow.

- tacotron: uma implementação TensorFlow da síntese de fala Tacotron do Google com modelo pré-treinado (não oficial).

- Clonagem de voz em tempo real: Clone uma voz em 5 segundos para gerar fala arbitrária em tempo real.

- mimic2: mecanismo Text to Speech baseado na arquitetura Tacotron, inicialmente implementado por Keith Ito.

- Clonagem de voz neural com poucas amostras: implementação de clonagem de voz neural com poucas amostras Artigo de pesquisa do Baidu.

- Vall-E: Uma implementação não oficial do PyTorch do áudio LM VALL-E.

- trocador de voz: trocador de voz em tempo real.

- WebUI de conversão de voz baseada em recuperação: uma estrutura de conversão de voz fácil de usar baseada em VITS.

- Audiocraft: Audiocraft é uma biblioteca para processamento e geração de áudio com aprendizado profundo. Ele apresenta o compressor/tokenizer de áudio EnCodec de última geração, junto com MusicGen, um LM de geração de música simples e controlável com condicionamento textual e melódico.

- VALL-EX: Uma implementação de código aberto do modelo VALL-E X zero-shot TTS da Microsoft.

- OpenVoice: clonagem instantânea de voz por MyShell.

- MeloTTS: Biblioteca de conversão de texto em fala multilíngue de alta qualidade da MyShell.ai. Suporte inglês, espanhol, francês, chinês, japonês e coreano.

- VoiceCraft: edição de fala zero-shot e conversão de texto em fala na natureza.

- Parler-TTS: Biblioteca de inferência e treinamento para modelos TTS de alta qualidade.

- ChatTTS: Um modelo de fala generativo para o diálogo diário.

Aplicativos

- Lip2Wav: Gere fala de alta qualidade apenas com movimentos labiais.

- AudioLDM: geração de texto para áudio com modelos de difusão latente

- deepvoice3_pytorch: implementação PyTorch de modelos de síntese de texto para fala baseados em redes neurais convolucionais.

- ? Riffusion: Difusão estável para geração de música em tempo real.

- sussurro.cpp: Porta do modelo Whisper da OpenAI em C/C++.

- TTS: ? - um kit de ferramentas de aprendizagem profunda para conversão de texto em fala, testado em pesquisa e produção.

- YourTTS: Rumo ao TTS de vários alto-falantes Zero-Shot e à conversão de voz Zero-Shot para todos.

- TorToiSe: Um sistema TTS multivoz treinado com ênfase na qualidade.

- DiffSinger: Síntese de voz cantada via mecanismo de difusão rasa (SVS e TTS).

- Vocoder WaveNet: Implementação do vocoder WaveNet, que pode gerar amostras de fala bruta de alta qualidade condicionadas a características linguísticas ou acústicas.

- Deepvoice3_pytorch: Implementação PyTorch de modelos de síntese de texto para fala baseados em redes neurais convolucionais.

- eSpeak NG Text-to-Speech: eSpeak NG é um sintetizador de voz de código aberto que suporta mais de cem idiomas e sotaques.

- RealChar: Crie, personalize e converse com seu personagem/companheiro de IA em tempo real (base de código tudo em um!). Tenha uma conversa natural e contínua com IA em qualquer lugar (móvel, web e terminal) usando LLM OpenAI GPT3.5/4, Anthropic Claude2, Chroma Vector DB, Whisper Speech2Text, ElevenLabs Text2Speech.

- Clonagem de voz neural com algumas amostras

- NAUTILUS: um sistema versátil de clonagem de voz

- Aprendendo a falar fluentemente em uma língua estrangeira: síntese de fala multilíngue e clonagem de voz entre idiomas

- Quando o bem se torna mal: inferência de pressionamento de tecla com smartwatch

- KeyListener: inferindo pressionamentos de tecla no teclado QWERTY da tela sensível ao toque por meio de sinais acústicos

- Esta voz não existe: sobre síntese de voz, deepfakes de áudio e sua detecção

- AudioSep: Separe tudo o que você descrever.

- stable-audio-tools: Modelos generativos para geração de áudio condicional.

- GPT-SoVITS-WebUI: dados de voz de 1 min também podem ser usados para treinar um bom modelo TTS! (poucas cenas de clonagem de voz).

- Hybrid-Net: Separação de fontes de áudio em tempo real, geração de letras, acordes, batidas.

- CosyVoice: modelo multilíngue de geração de voz grande, fornecendo capacidade de inferência, treinamento e implantação full-stack.

- EasyVolcap: Acelerando a pesquisa de vídeo volumétrico neural.

? Detecção?

- detecção de voz falsa: usando convolução temporal para detectar Deepfakes de áudio.

- Um sistema robusto de detecção de falsificação de voz usando novos recursos CLS-LBP e LSTM

- Detector de falsificação de voz: uma estrutura anti-spoofing unificada

- Protegendo interfaces acionadas por voz contra ataques de áudio falsos (clonados)

- DeepSonar: Rumo à detecção eficaz e robusta de vozes falsas sintetizadas por IA

- Combatendo a IA com IA: detecção de fala falsa usando aprendizado profundo

- Uma revisão dos métodos modernos de detecção de deepfake de áudio: desafios e direções futuras

? Imagem?

Ferramentas

- StyleGAN: StyleGAN - Implementação oficial do TensorFlow.

- StyleGAN2: StyleGAN2 - Implementação oficial do TensorFlow.

- stylegan2-ada-pytorch: StyleGAN2-ADA – Implementação oficial do PyTorch.

- StyleGAN-nada: Adaptação de domínio guiada por CLIP de geradores de imagens.

- StyleGAN3: implementação oficial do PyTorch do StyleGAN3.

- Imaginaire: Imaginaire é uma biblioteca pytorch que contém a implementação otimizada de diversos métodos de síntese de imagem e vídeo desenvolvidos na NVIDIA.

- conjunto de dados ffhq: Conjunto de dados Flickr-Faces-HQ (FFHQ).

- DALLE2-pytorch: Implementação de DALL-E 2, rede neural de síntese de texto para imagem atualizada da OpenAI, em Pytorch.

- ImaginAIry: imagens imaginadas por IA. Geração pitônica de imagens de difusão estável.

- Lama Cleaner: ferramenta de pintura de imagens desenvolvida pelo modelo SOTA AI. Remova qualquer objeto, defeito ou pessoa indesejado de suas fotos ou apague e substitua (alimentado por difusão estável) qualquer coisa em suas fotos.

- Invertible-Image-Rescaling: Esta é a implementação PyTorch do artigo: Invertible Image Rescaling.

- DifFace: Restauração de face cega com contração de erro difuso (PyTorch).

- CodeFormer: Rumo à restauração robusta de faces cegas com Codebook Lookup Transformer.

- Difusão Personalizada: Personalização Multiconceitual de Difusão de Texto para Imagem.

- Difusores: ? Difusores: modelos de difusão de última geração para geração de imagem e áudio em PyTorch.

- Difusão Estável: Síntese de Imagens de Alta Resolução com Modelos de Difusão Latente.

- InvokeAI: InvokeAI é um mecanismo criativo líder para modelos de difusão estável, capacitando profissionais, artistas e entusiastas a gerar e criar mídia visual usando as mais recentes tecnologias baseadas em IA. A solução oferece uma WebUI líder do setor, oferece suporte ao uso de terminal por meio de uma CLI e serve como base para vários produtos comerciais.

- UI da web de difusão estável: UI da web de difusão estável.

- Stable Diffusion Infinity: Outpainting com Stable Diffusion em uma tela infinita.

- Difusão rápida e estável: difusão rápida e estável + DreamBooth.

- GET3D: um modelo generativo de formas texturizadas 3D de alta qualidade aprendidas a partir de imagens.

- Síntese incrível de imagens de arte de IA: uma lista de ferramentas, ideias, ferramentas de engenharia imediatas, colaborações, modelos e ajudantes incríveis para o designer imediato brincar com aiArt e síntese de imagens. Abrange Dalle2, MidJourney, StableDiffusion e ferramentas de código aberto.

- Difusão Estável: Um modelo de difusão latente de texto para imagem.

- Difusão climática: código para "Restaurar a visão em condições climáticas adversas com modelos de difusão de eliminação de ruído baseados em patches".

- DF-GAN: uma linha de base simples e eficaz para síntese de texto para imagem.

- Dall-E Playground: Um playground para gerar imagens a partir de qualquer prompt de texto usando Stable Diffusion (antigo: usando DALL-E Mini).

- MM-CelebA-HQ-Dataset: um conjunto de dados de imagens faciais em grande escala que permite geração de texto para imagem, manipulação de imagem guiada por texto, geração de esboço para imagem, GANs para geração e edição de rosto, legenda de imagem e VQA.

- Deep Daze: ferramenta simples de linha de comando para geração de texto para imagem usando CLIP e Siren da OpenAI (rede de representação neural implícita).

- StyleMapGAN: Explorando dimensões espaciais de latente em GAN para edição de imagens em tempo real.

- Kandinsky-2: Modelo de difusão latente multilíngue text2image.

- DragGAN: manipulação interativa baseada em pontos no coletor de imagens generativas.

- Segmentar qualquer coisa: o repositório fornece código para executar inferência com o modelo SegmentAnything (SAM), links para baixar os pontos de verificação do modelo treinado e blocos de anotações de exemplo que mostram como usar o modelo.

- Segment Anything 2: O repositório fornece código para executar inferência com o Meta Segment Anything Model 2 (SAM 2), links para baixar os pontos de verificação do modelo treinado e cadernos de exemplo que mostram como usar o modelo.

- MobileSAM: Este é o código oficial do projeto MobileSAM que torna o SAM leve para aplicativos móveis e muito mais!

- FastSAM: segmente qualquer coisa rapidamente

- Infinigen: mundos fotorrealistas infinitos usando geração processual.

- DALL·E 3

- StreamDiffusion: uma solução em nível de pipeline para geração interativa em tempo real.

- AnyDoor: personalização de imagem em nível de objeto de disparo zero.

- DiT: Modelos de Difusão Escaláveis com Transformadores.

- BrushNet: um modelo de pintura de imagem plug-and-play com difusão de ramificação dupla decomposta.

- OOTDiffusion: Equipando difusão latente baseada em fusão para teste virtual controlável.

- VAR: impl. oficial. de "Modelagem Visual Autoregressiva: Geração de Imagem Escalável via Previsão de Próxima Escala".

- Imagine Flash: Acelerando Modelos de Difusão Emu com Destilação Regressiva

Aplicativos

- ArtLine: Um projeto baseado em Deep Learning para a criação de retratos de arte linear.

- Depix: Recupera senhas de capturas de tela pixelizadas.

- Trazendo fotos antigas de volta à vida: restauração de fotos antigas (implementação oficial do PyTorch).

- Reescrita: Ferramenta interativa para editar diretamente as regras de um GAN para sintetizar cenas com objetos adicionados, removidos ou alterados. Mude o StyleGANv2 para fazer sobrancelhas extravagantes ou cavalos usando chapéus.

- Fawkes: Ferramenta de preservação de privacidade contra sistemas de reconhecimento facial.

- Pulse: Upsampling de fotos auto-supervisionado por meio de exploração espacial latente de modelos generativos.

- HiDT: Repositório oficial do artigo "Tradução diurna de alta resolução sem rótulos de domínio".

- Pintura de fotos 3D: Fotografia 3D usando pintura de profundidade em camadas com reconhecimento de contexto.

- SteganoGAN: SteganoGAN é uma ferramenta para criar imagens esteganográficas usando treinamento adversário.

- Stylegan-T: Desbloqueando o poder dos GANs para síntese rápida de texto em imagem em grande escala.

- MegaRetratos: Avatares de cabeças neurais de megapixels únicos.

- eg3d: Redes Adversariais Gerativas 3D com reconhecimento de geometria eficiente.

- TediGAN: implementação Pytorch para TediGAN: geração e manipulação de imagens faciais diversas guiadas por texto.

- DALLE-pytorch: Implementação/replicação de DALL-E, Text to Image Transformer da OpenAI, em Pytorch.

- StyleNeRF: Esta é a implementação de código aberto do artigo ICLR2022 "StyleNeRF: A Style-based 3D-Aware Generator for High-resolution Image Synthesis".

- DeepSVG: Código oficial do artigo "DeepSVG: A Hierarchical Generative Network for Vector Graphics Animation". Inclui uma biblioteca PyTorch para aprendizado profundo com dados SVG.

- NUWA: Um pipeline de transformador 3D unificado para síntese visual.

- Image-Super-Resolution-via-Iterative-Refinement: Implementação não oficial de Image Super-Resolution via Iterative Refinement por Pytorch.

- Lama: ? Pintura de imagem LaMa, pintura de máscara grande com resolução robusta e convoluções de Fourier.

- Person_reID_baseline_pytorch: Pytorch ReID: uma implementação pytorch pequena, amigável e forte da linha de base de reidentificação de objetos.

- instruct-pix2pix: implementação PyTorch do InstructPix2Pix, um modelo de edição de imagens baseado em instruções.

- GFPGAN: GFPGAN visa desenvolver algoritmos práticos para restauração facial no mundo real.

- DeepVecFont: Sintetizando fontes vetoriais de alta qualidade por meio de aprendizagem de dupla modalidade.

- Stargan v2 Tensorflow: implementação oficial do Tensorflow.

- Destilação StyleGAN2: A tradução emparelhada de imagem para imagem, treinada em dados sintéticos gerados por StyleGAN2, supera as abordagens existentes na manipulação de imagens.

- Extraindo dados de treinamento de modelos de difusão

- Mann-E - Mann-E (persa: مانی) é um modelo gerador de arte baseado nos pesos do Stable Diffusion 1.5 e em dados coletados de material artístico disponível no Pinterest

- Redes de codificação e decodificação CNN treinadas de ponta a ponta para esteganografia de imagens

- Grounded-Segment-Anything: Casando Grounding DINO com Segment Anything & Stable Diffusion & Tag2Text & BLIP & Whisper & ChatBot - Detecta, segmenta e gera automaticamente qualquer coisa com entradas de imagem, texto e áudio.

- AnimateDiff: anime seus modelos personalizados de difusão de texto para imagem sem ajuste específico.

- BasicSR: caixa de ferramentas de restauração de imagem e vídeo de código aberto para super-resolução, Denoise, Deblurring, etc. Atualmente, inclui EDSR, RCAN, SRResNet, SRGAN, ESRGAN, EDVR, BasicVSR, SwinIR, ECBSR, etc. [](https://github.com/XPixelGroup/ BasicSR)

- Real-ESRGAN: O Real-ESRGAN visa desenvolver Algoritmos Práticos para Restauração Geral de Imagens/Vídeos.

- ESRGAN: SRGAN aprimorado. Campeão do Desafio PIRM em Super-Resolução Perceptual.

- MixNMatch: Desemaranhamento e codificação multifatorial para geração de imagens condicionais.

- Clarity-upscaler: Upscaling de imagem reimaginado para todos.

- Difusão de uma etapa com destilação correspondente à distribuição

- Ponto invisível: gerando cenas 3D lisas com profundidade de pintura.

- SSR: Reconstrução de cena 3D de vista única com formato e textura de alta fidelidade.

- INVSR: Super-resolução de etapas arbitrárias via inversão de difusão.

? Detecção?

- Stylegan3-Detector: Stylegan3 Detecção de imagem sintética.

- Stylegan2-Projecting-Imagens: Projetando imagens para o espaço latente com Stylegan2.

- FaldeTector: Detectando rostos do Photoshop por Scripts Photoshop.

? Vídeo ?

Ferramentas

- Deepfacelab: Deepfacelab é o software líder para criar os deepfakes.

- Faceswap: DeepFakes Software para todos.

- DOT: O kit de ferramentas ofensivo de Deepfake.

- SIMSWAP: Uma estrutura arbitrária de troca de rosto em imagens e vídeos com um único modelo treinado!

- FACESWAP-GAN: Um denoising AutoEncoder + perdas adversárias e mecanismos de atenção para troca de rosto.

- Celeb DeepFakeforensics: um conjunto de dados desafiador de larga escala para a Deepfake Forensics.

- VGEN: Um ecossistema holístico de geração de vídeo para geração de vídeo construindo modelos de difusão.

- Musev: geração de vídeo humano virtual de alta fidelidade e alta fidelidade com denoising paralelo condicionado visual.

- Glee: Modelo de fundação de objeto geral para imagens e vídeos em escala.

- T-Rex: Rumo à detecção de objetos genéricos por meio de sinergia rápida e visual de texto.

- Dynamicrafter: Animando imagens de domínio aberto com Priors de difusão de vídeo.

- Mora: Mais como Sora para geração de vídeo generalista.

Aplicativos

- Face2face-Demo: Pix2pix Demo que aprende com marcos faciais e traduz isso em um rosto.

- Faceswap-Deepfake-Pytorch: Faceswap com Pytorch ou Deepfake com Pytorch.

- Point-E: Difusão da nuvem de pontos para a síntese do modelo 3D.

- EGVSR: Super-resolução de vídeo eficiente e genérico.

- STIT: Costure a tempo: edição facial baseada em GaN de vídeos reais.

- BackgroundMattingV2: Fatting de fundo de alta resolução em tempo real.

- MODNET: Uma solução de matting de retrato sem troca em tempo real.

- Matriz de fundo: Fundamento Matting: O mundo é sua tela verde.

- Modelo de primeira ordem: este repositório contém o código -fonte do modelo de movimento de primeira ordem para animação de imagem.

- Animação articulada: este repositório contém o código -fonte para as representações de movimento de papel CVPR'2021 para animação articulada.

- Remoção de pessoa em tempo real: Removendo as pessoas de origens complexas em tempo real usando o tensorflow.js no navegador da web.

- Estilo de Adain: transferência de estilo arbitrário em tempo real com normalização de instância adaptativa.

- Interpolação de quadros: interpolação do quadro para grande movimento.

- Coloração de imagem impressionante: uma coleção de colorização de imagem baseada em aprendizado profundo e papéis de coloração de vídeo.

- SadTalker: Aprendendo coeficientes de movimento 3D realistas para a animação de rosto de imagem única estilizada em áudio.

- Roop: Deepfake de um clique (troca de rosto).

- StableVideo: edição de vídeo de difusão consome orientada por texto.

- Magicedit: Edição de vídeo temporalmente coerente de alta fidelidade.

- Re-render_a_video: Tradução de vídeo para vídeo guiada por texto com tiro zero.

- Dreameditor: edição de cena 3D acionada por texto com campos neurais.

- DreamEditor: Síntese de visualização em 4D em tempo real na resolução 4K.

- AnimateanyOne: síntese de imagem para vídeo consistente e controlável para animação de caracteres.

- Moore-Animateanyone: Este repositório reproduz animateanyone.

- AUDIO2PHOTORAL: DA AUDIO À INCLIMAGEM FOTICOURAL: Sintetizando os seres humanos em conversas.

- MagicVideo-V2: geração de vídeo de alta e-estética em vários estágios

- LWM: Um modelo autoregressivo multimodal de grande contexto de uso geral. É treinado em um grande conjunto de dados de diversos vídeos e livros longos usando o Ringattion e pode executar a linguagem, a imagem e a compreensão e a geração de vídeos.

- Aniportraito: síntese orientada a áudio da animação de retrato fotorrealista.

- Champ: Animação de imagem humana controlável e consistente com orientação paramétrica 3D.

- Streamv2V: Translação de vídeo para vídeo com bancos de recursos.

- Deep-Live-Cam: troca de rosto em tempo real e vídeo de um clique Deepfake com apenas uma única imagem.

- Sapiens: Fundação para modelos de visão humana.

? Detecção?

- FaceForensics ++: conjunto de dados do Faceforensics.

- DeepFake-Detection: Rumo a DeepFake que realmente funciona.

- FakeVideoforensics: Detect Deep Fakes Videos.

- DeepFake-Detection: A implementação de Pytorch da detecção de DeepFake com base na Faceforensics ++.

- SEQDEEPFAKE: Código Pytorch para Seqdeepfake: Detectar e recuperar a manipulação sequencial de Deepfake.

- PCL-I2G: Implementação não oficial: Aprendendo a autoconsistência para a detecção de DeepFake.

- Desafio do DFDC Deepfake: uma solução vencedora de prêmios para o DFDC Challenge.

- Poi-Forensics: Detecção de DeepFake de pessoa visual audiovisual.

- Padronizando a detecção de fagos de Deep: por que os especialistas dizem que é importante

- Quer ver um Deepfake? Procure as estrelas em seus olhos

? Texto ?

Ferramentas

- GLM-130B: Um modelo pré-treinado bilíngue aberto.

- LongTermChatexternalSources: GPT-3 Chatbot com memória de longo prazo e fontes externas.

- Esboço: Assistente de redação de código da AI que entende o conteúdo de dados.

- Langchain: ⚡ Construindo aplicações com LLMs através da composibilidade ⚡.

- Chatgpt Wrapper: API para interagir com o ChatGPT usando o Python e o Shell.

- OpenI-Python: A Biblioteca OpenAI Python fornece acesso conveniente à API OpenAI a partir de aplicativos escritos no idioma Python.

- BETO: Versão espanhola do modelo Bert.

- GPT-Code-Clippy: GPT-Code-Clippy (GPT-CC) é uma versão de código aberto do GitHub Copilot, um modelo de idioma-baseado no GPT-3, chamado GPT-Codex.

- GPT NEO: Uma implementação dos modelos de modelos GPT-2 e GPT-3 paralelos usando a biblioteca de tensorflow de malha.

- Ctrl: Modelo de linguagem do transformador condicional para geração controlável.

- LLAMA: Código de inferência para modelos de llama.

- Llama2

- Guarda de lhama 3

- Ul2 20b: um aluno de idioma unificado de código aberto

- Burgpt: uma extensão do Burp Suite que integra o GPT da OpenAI para realizar uma varredura passiva adicional para descobrir vulnerabilidades altamente personalizadas e permite a análise de qualquer tipo baseada em tráfego em execução.

- Ollama: Fique em funcionamento com o LLAMA 2 e outros modelos de idiomas grandes localmente.

- SneakyPrompt: Modelos generativos de texto para imagem de jailbreak.

- Copiloto por segurança: uma solução de segurança generativa de IA que ajuda a aumentar a eficiência e as capacidades dos defensores para melhorar os resultados da segurança na velocidade e na escala da máquina, permanecendo em conformidade com os princípios responsáveis da IA.

- LM Studio: Descubra, baixe e execute LLMS local

- Introdução GPT: Converta o texto da IA em conteúdo humano

- MGM: A estrutura suporta uma série de modelos densos e MOE de grandes idiomas (LLMS) de 2b a 34b com entendimento, raciocínio e geração de imagem simultaneamente.

- Secret Llama: Chatbot LLM totalmente privado que é executado inteiramente com um navegador sem necessidade de servidor. Apoia Mistral e Llama 3.

- LLAMA3: O local oficial do Meta Llama 3 Github.

? Detecção?

- Detectando texto falso: sala de teste de modelo de linguagem gigante.

- Grover: Código para defender contra notícias falsas neurais.

- Rebuff.ai: detector de injeção imediata.

- Novo classificador de IA para indicar texto escrito por IA

- Descubra os 4 métodos mágicos para detectar texto gerado pela IA (incluindo chatgpt)

- GptZero

- Detector de Conteúdo da IA (Beta)

- Uma marca d'água para grandes modelos de idiomas

- O texto gerado pela IA pode ser detectado com segurança?

- Detectores GPT são tendenciosos contra escritores ingleses não nativos

- Para conversar, ou não Chatgpt: essa é a pergunta!

- Os linguistas podem distinguir entre chatgpt/ai e escrita humana?: Um estudo de ética em pesquisa e publicação acadêmica

- Chatgpt é besteira

Aplicativos

- manuscrito: a manuscrito gera uma fonte personalizada com base na sua amostra de caligrafia.

- Sandbox GPT: O objetivo deste projeto é permitir que os usuários criem demonstrações legais da Web usando a API OpenAI GPT-3, recém-lançada, com apenas algumas linhas de Python.

- Passgan: Uma abordagem de aprendizado profundo para adivinhar a senha.

- Índice GPT: o Índice GPT é um projeto que consiste em um conjunto de estruturas de dados projetadas para facilitar o uso de grandes bases de conhecimento externas com o LLMS.

- Nanogpt: O repositório mais simples e mais rápido para o treinamento/Finetuning GPTs de tamanho médio.

- whatsapp-gpt

- Extensão do Chatgpt Chrome: uma extensão Chatgpt Chrome. Integra o ChatGPT em todas as caixas de texto da Internet.

- Unilm: pré-treinamento auto-supervisionado em larga escala entre tarefas, idiomas e modalidades.

- MINGPT: Uma reimplementação mínima de pytorch do treinamento do OpenAI GPT (transformador pré-traido generativo).

- CodegeEx: um modelo de geração de código multilíngue aberto.

- Livro de receitas do OpenAI: Exemplos e Guias para usar a API Openai.

- ? Prompts de chatgpt impressionantes: Este repositório inclui uma curadoria rápida do ChatGPT para usar melhor o ChatGPT.

- Alice: dando acesso ao chatgpt a um terminal real.

- Revisão do código de segurança com chatgpt

- Os usuários escrevem mais código inseguro com assistentes de IA?

- Ignorando os filtros de spam do Gmail com chatgpt

- Recorrente Gans Password Cracker para aprimoramento de segurança de senha da IoT

- PENTESTGPT: Uma ferramenta de teste de penetração de GPT-EMpowered.

- Pesquisador GPT: Agente autônomo baseado em GPT que faz pesquisas abrangentes on -line sobre qualquer tópico.

- Engenheiro GPT: Especifique o que você deseja construir, a IA pede esclarecimentos e o constrói.

- LocalPilot: Use o GitHub Copilot localmente no seu MacBook com um clique!

- [Wormgpt]) (https://thehackernews.com/2023/07/wormgpt-new-ai-ool-allows.html): a nova ferramenta de IA permite que os cibercriminosos lançem sofisticados ataques cibernéticos

- Poisongpt: Como escondemos um LLM lobotomizado em abraçar o rosto para espalhar notícias falsas

- Passgpt: modelagem de senha e geração (guiada) com grandes modelos de linguagem

- Deeppass - Encontrando senhas com aprendizado profundo

- GPTFUZZ: Red em parceria com grandes modelos de idiomas com avisos de jailbreak gerados automaticamente.

- INTERPRETER ABERTO: O intérprete de código do OpenAI no seu terminal, executando localmente.

- Eureka: Design de recompensa no nível humano através de codificação de grandes modelos de linguagem.

- Metaclip: desmistificação de dados do clipe.

- LLM OSINT: método de prova de conceito de usar o LLMS para coletar informações da Internet e, em seguida, executar uma tarefa com essas informações.

- HackingBuddyGPT: LLMS x Pentesting.

- Chatgpt-Jailbreaks: Jailbreak oficial para ChatGPT (GPT-3.5). Envie uma longa mensagem no início da conversa com o ChatGPT para se tornar respostas ofensivas, antiéticas, agressivas e humanas em inglês e italiano.

- Magika: Detecte os tipos de conteúdo de arquivo com aprendizado profundo.

- Jan: Uma alternativa de código aberto ao ChatGPT que executa 100% offline no seu computador.

- Librechat: Clone de chatgpt aprimorado: apresenta OpenAI, API de assistentes, Azure, Groq, GPT-4 Visão, Mistral, Bing, Antrópico, OpenRouter, Vertex AI, Gemini, AI Modelo Switching, pesquisa de mensagens, Langchain, Dall-E-3, Chatgpt Plugins, funções do OpenAI, sistema multiusuário seguro, predefinições, de código aberto para auto-hospedagem.

- Lumina-T2X: Uma estrutura unificada para texto para qualquer geração de modalidade.

Diversos

- A incrível segurança GPT +: uma lista com curadoria de ferramentas de segurança impressionantes, caso experimental ou outras coisas interessantes com LLM ou GPT.

- Aprendizagem de reforço impressionante para segurança cibernética: uma lista com curadoria de recursos dedicados ao aprendizado de reforço aplicado à segurança cibernética.

- Aprendizagem de máquina impressionante para segurança cibernética: uma lista com curadoria de ferramentas e recursos incrivelmente impressionantes relacionados ao uso do aprendizado de máquina para segurança cibernética.

- Abraçando o curso dos modelos de difusão de rosto: materiais para o curso dos modelos de difusão de faces abraçados.

- Awesome-ai-segurança: uma lista com curadoria de recursos de segurança de IA.

- ML para hackers: código que acompanha o livro "Aprendizagem de máquina para hackers".

- AI Horty AI: IA TRAVIDADE é uma lista com curadoria para rastrear usos assustadores da IA - na esperança de aumentar a conscientização.

- NIST AI Risk Management Framework Playbook

- SOK: Aprendizado de máquina explicável para aplicativos de segurança de computador

- Quem avalia os avaliadores? Sobre métricas automáticas para avaliar geradores de código ofensivo baseados em IA

- Priorização de vulnerabilidades: uma abordagem de segurança ofensiva

- MITER ATLAS ™ (cenário de ameaças adversárias para sistemas de inteligência artificial)

- Uma pesquisa sobre segurança de aprendizado de reforço com aplicação para direção autônoma

- Como evitar armadilhas de aprendizado de máquina: um guia para pesquisadores acadêmicos

- Uma lista com curadoria de eventos de segurança e privacidade da IA

- NIST AI 100-2 E2023: Aprendizado de máquina adversário. Uma taxonomia e terminologia de ataques e mitigações.

- ?? ROOTENCON 2023 - InteLigncian Artificial ofensiva - ¿Cómo Podemos Estar Preparados?

- Segurança dos sistemas de IA: Fundamentos - Aprendizagem profunda adversária

- Além das salvaguardas: explorando os riscos de segurança do chatgpt

- O mapa de superfície de ataque da IA v1.0

- Sobre a segurança impossível de grandes modelos de IA

- Regulamento da IA da Frontier: Gerenciamento de riscos emergentes para a segurança pública

- Estrutura multicamada para boas práticas de segurança cibernética para IA

- Apresentando a estrutura de AI segura do Google

- OWASP Top 10 para LLM

- Awesome LLM Security: uma curadoria de ferramentas, documentos e projetos impressionantes sobre a LLM Security.

- Uma estrutura para usar com segurança LLMs nas empresas. Parte 1: Visão geral dos riscos. Parte 2: Gerenciando o risco. Parte 3: proteger o ChatGPT e o GitHub Copilot.

- Um estudo sobre robustez e confiabilidade da geração de código de modelo de grande linguagem

- Identificando imagens geradas pela IA com sintid

- Auditando grandes modelos de idiomas: uma abordagem de três camadas

- Resolvendo a Batalha de Risco de AI curto a longo prazo

- Fraudgpt: O Avatar do Vilão de Chatgpt

- AI riscos - Schneier em segurança

- Uso de LLMs para fins ilícitos: ameaças, medidas de prevenção e vulnerabilidades

- A IA Red-Tamaming não é uma solução única para os danos da IA: recomendações para o uso de térmicas vermelhas para a responsabilidade da IA

- Uma taxonomia de confiabilidade para inteligência artificial

- Gerenciando os riscos de IA em uma era de progresso rápido

- Google - agindo sobre o nosso compromisso com a IA segura e segura

- Manual de ML ofensivo

- IA generativa desmistificadora? Notas de um pesquisador de segurança

- Aventuras de segurança genai: uma iniciativa de código aberto para compartilhar notas, apresentações e uma coleção diversificada de experimentos apresentados nos cadernos de Jupyter, todos com o objetivo de ajudá-lo a entender os conceitos essenciais por trás de grandes modelos de linguagem e explorar a interseção intrigante de segurança e natural processamento de idiomas.

- O AI Safety Camp conecta você a uma pesquisa de pesquisa para colaborar em um projeto - para ver onde seu trabalho pode ajudar a garantir que a IA futura seja segura.

- Diretrizes para desenvolvimento seguro do sistema de IA

- Abordagem à inteligência artificial e segurança cibernética. Relatório de melhores práticas

- Stanford seguro, seguro e confiável AI EO 14110 Tracker

- A incrível segurança de ML: uma lista com curadoria de referências, orientações, ferramentas e muito mais.

- Caminho previsível da IA: 7 coisas a serem esperadas da IA em 2024+

- Inteligência artificial e segurança cibernética (em espanhol ??)

- Vigília: Detecte injeções rápidas, jailbreaks e outras entradas de Modelo de Línguas de Grandes Linguagem (LLM) potencialmente arriscadas.

- Modelos de IA generativos - oportunidades e riscos para a indústria e as autoridades

- Implantando sistemas de IA com segurança. Melhores práticas para implantar sistemas de IA seguros e resilientes

- NIST AI 600-1: Estrutura de gerenciamento de riscos de inteligência artificial: Perfil de inteligência artificial generativa

- ?? Anssi: Recomendações de Sécurité Poad Un Système D'IA Générative (recomendações de segurança para um sistema de IA generativo)

- Pyrit: A Ferramenta de Identificação de Risco Python para IA generativa (Pyrit) é uma estrutura de automação de acesso aberto para capacitar profissionais de segurança e engenheiros de aprendizado de máquina para encontrar riscos proativamente em seus sistemas generativos de IA.

- OWASP-AGENTIC-AI: Trabalhando para criar o OWASP Top 10 para AI Agentic (AI Agent Security).

- Rumo à IA segura garantida: uma estrutura para garantir sistemas de IA robustos e confiáveis

- Definindo riscos de IA reais

- Abordagem segura da IA generativa

- Grandes modelos de linguagem em segurança cibernética

- Ei, esse é o meu modelo! Apresentando a Chain & Hash, uma técnica de impressão digital LLM

- Uso indevido de IA generativa: uma taxonomia de táticas e idéias de dados do mundo real

- Repositório de risco de IA

- Revisitando a IA Red-Tamaming

- Recomendações alemãs-francas para o uso de assistentes de programação de IA

- MARTE d'água escalável para identificar grandes saídas de modelo de linguagem

Pesquisas

- A ameaça de IA ofensiva para as organizações

- Inteligência artificial no domínio cibernético: ofensa e defesa

- Uma pesquisa sobre ataques e defesas adversárias

- Aprendizagem profunda adversária: uma pesquisa sobre ataques adversários e mecanismos de defesa na classificação da imagem

- Uma pesquisa sobre ataques de privacidade no aprendizado de máquina

- Para ameaças à segurança de sistemas de aprendizado profundo: uma pesquisa

- Uma pesquisa sobre ameaças à segurança e técnicas defensivas de aprendizado de máquina: uma visão orientada a dados

- SOK: Segurança e privacidade no aprendizado de máquina

- Aprendizado adversário da máquina: o aumento do crime habilitado para a AI e seu papel na evasão do filtro de spam

- Ameaças, vulnerabilidades e controles de sistemas baseados em aprendizado de máquina: uma pesquisa e taxonomia

- Ataques e defesas adversárias: uma pesquisa

- Matérias de segurança: uma pesquisa sobre aprendizado de máquina adversária

- Uma pesquisa sobre ataques adversários para análise de malware

- Aprendizado adverso da máquina na classificação da imagem: uma pesquisa para a perspectiva do zagueiro

- Uma pesquisa de treinamento adversário robusto em reconhecimento de padrões: fundamental, teoria e metodologias

- Privacidade em grandes modelos de idiomas: ataques, defesas e direções futuras

? Mantenedores?

Miguel Hernández |

José Ignacio escribano |

© licione Licença © iqu

- Creative Commons Attribution-Share da Tipo 4.0 Internacional