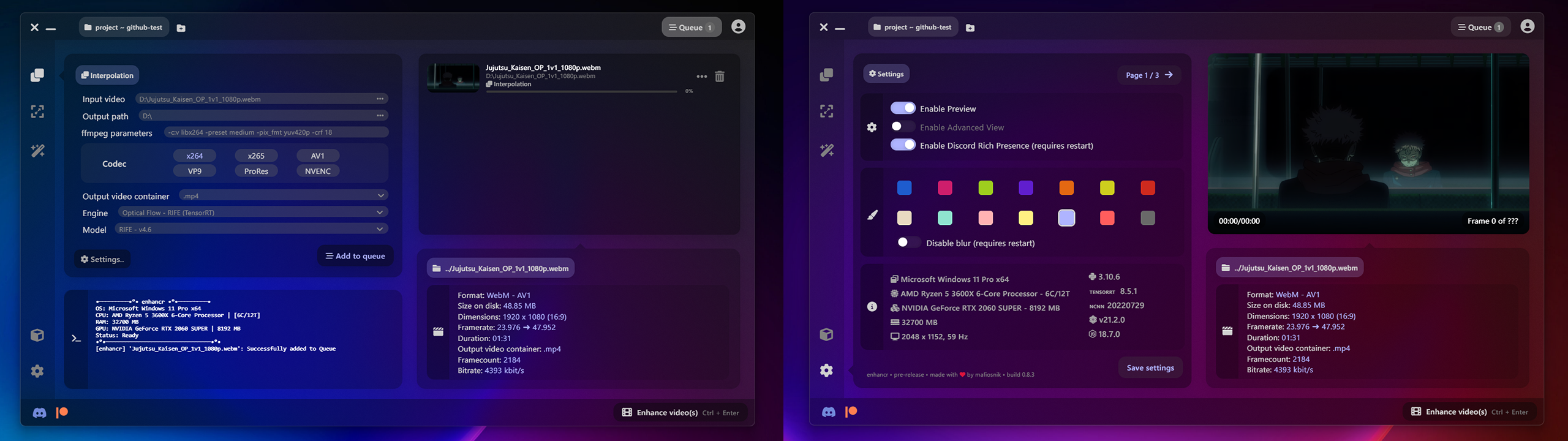

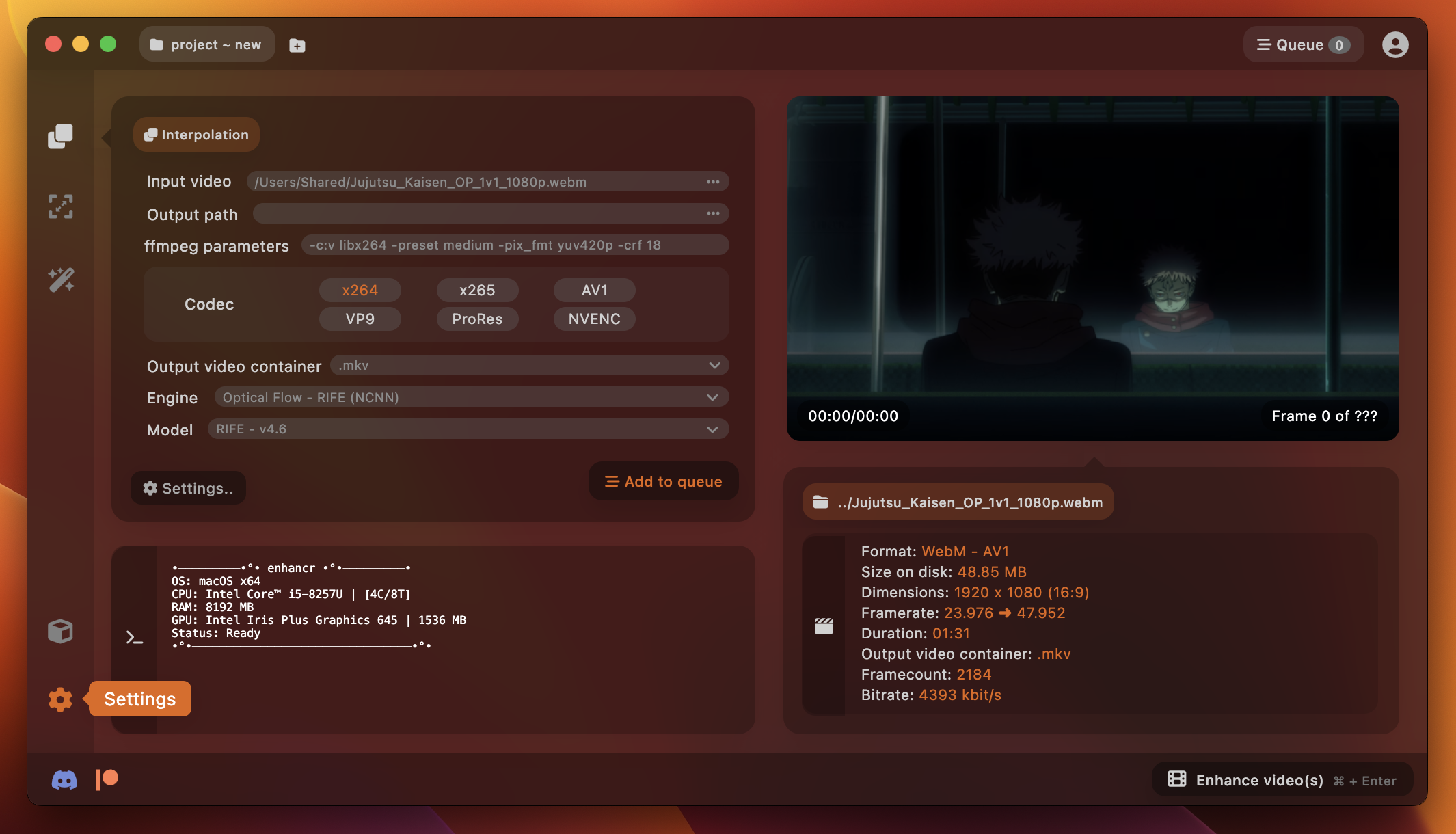

enhancr é uma GUI elegante e fácil de usar para interpolação de quadros de vídeo e upscaling de vídeo que aproveita a inteligência artificial construída usando node.js e Electron . Ele foi criado para aprimorar a experiência do usuário para qualquer pessoa interessada em aprimorar imagens de vídeo usando inteligência artificial. A GUI foi projetada para fornecer uma experiência impressionante alimentada por tecnologias de última geração, sem parecer desajeitada e desatualizada como outras alternativas.

Ele apresenta inferência TensorRT extremamente rápida da NVIDIA, que pode acelerar significativamente os processos de IA. Pré-empacotado, sem a necessidade de instalação de Docker ou WSL (Windows Subsystem for Linux) - e inferência NCNN da Tencent que é leve e roda em NVIDIA , AMD e até Apple Silicon - em contraste com a gigantesca inferência que PyTorch é, que só funciona em GPUs NVIDIA .

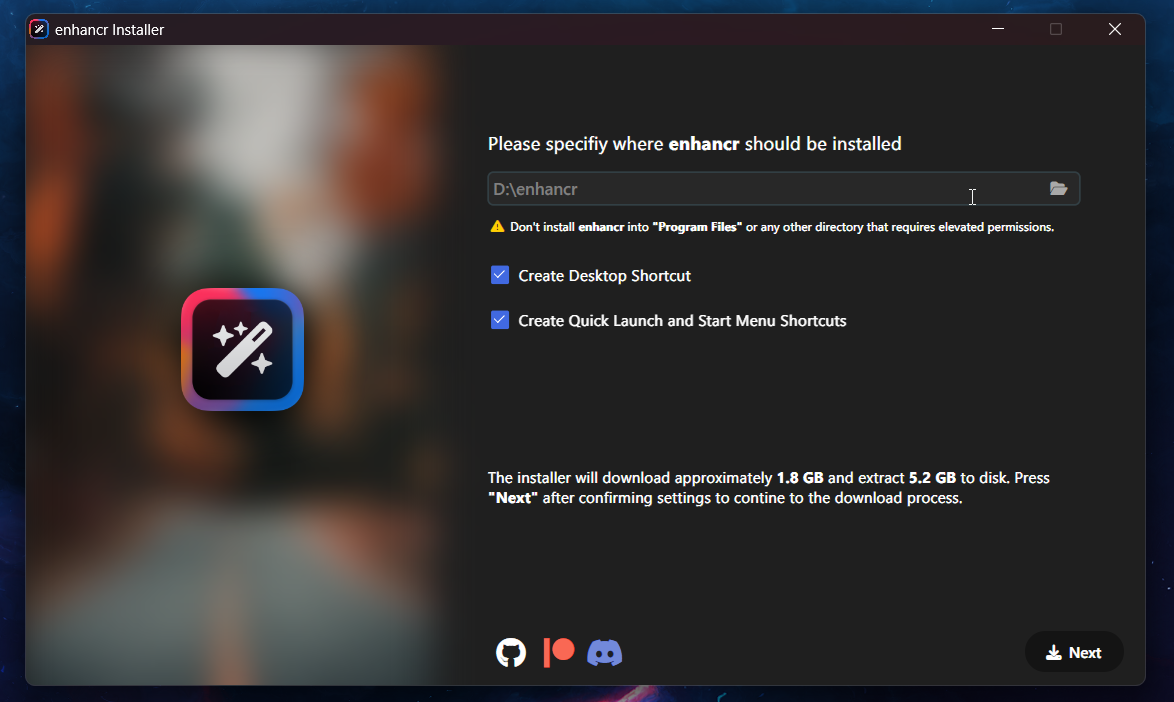

A versão 0.9.9 apresenta uma versão gratuita? https://dl.enhancr.app/setup/enhancr-setup-free-0.9.9.exe

Para garantir que você tenha a versão mais recente do software e todas as dependências necessárias, recomendamos baixar o instalador do Patreon. Observe que compilações e um ambiente python incorporável para a versão Pro não são fornecidos por meio deste repositório.

RIFE (NCNN) - megvii-research/ ECCV2022-RIFE - desenvolvido com styler00dollar/ VapourSynth-RIFE-NCNN-Vulkan

RIFE (TensorRT) - megvii-research/ ECCV2022-RIFE - desenvolvido por AmusementClub/ vs-mlrt & styler00dollar/ VSGAN-tensorrt-docker

GMFSS - União (PyTorch/TensorRT) - 98mxr/ GMFSS_Union - desenvolvido por HolyWu/ vs-gmfss_union

GMFSS - Fortuna (PyTorch/TensorRT) - 98mxr/ GMFSS_Fortuna - desenvolvido por HolyWu/ vs-gmfss_fortuna

CAIN (NCNN) - myungsub/ CAIN - desenvolvido por mafiosnik/ vsynth-cain-NCNN-vulkan (não lançado)

CAIN (DirectML) - myungsub/ CAIN - desenvolvido por AmusementClub/ vs-mlrt

CAIN (TensorRT) - myungsub/ CAIN - desenvolvido por HubertSotnowski/ cain-TensorRT

ShuffleCUGAN (NCNN) - styler00dollar/ VSGAN-tensorrt-docker - desenvolvido por AmusementClub/ vs-mlrt

ShuffleCUGAN (TensorRT) - styler00dollar/ VSGAN-tensorrt-docker - desenvolvido por AmusementClub/ vs-mlrt

RealESRGAN (NCNN) - xinntao/ Real-ESRGAN - desenvolvido por AmusementClub/ vs-mlrt

RealESRGAN (DirectML) - xinntao/ Real-ESRGAN - desenvolvido por AmusementClub/ vs-mlrt

RealESRGAN (TensorRT) - xinntao/ Real-ESRGAN - desenvolvido por AmusementClub/ vs-mlrt

RealCUGAN (TensorRT) - bilibili/ ailab/Real-CUGAN - desenvolvido por AmusementClub/ vs-mlrt

SwinIR (TensorRT) - JingyunLiang/ SwinIR - desenvolvido por mafiosnik777/ SwinIR-TensorRT (não lançado)

DPIR (DirectML) - cszn/ DPIR - desenvolvido por AmusementClub/ vs-mlrt

DPIR (TensorRT) - cszn/ DPIR - desenvolvido por AmusementClub/ vs-mlrt

SCUNet (TensorRT) - cszn/ SCUNet - desenvolvido por mafiosnik777/ SCUNet-TensorRT (não lançado)

Nota lateral: A partir do TensorRT 8.6, o suporte para Kepler e Maxwell de 2ª geração (série 900 e inferior) foi eliminado. Você precisará de pelo menos uma GPU Pascal (série 1000 e superior) e CUDA 12.0 + versão do driver >= 525.xx para executar inferência usando TensorRT.

A GUI foi criada pensando na compatibilidade entre plataformas e é compatível com ambos os sistemas operacionais. Nosso foco principal no momento é garantir uma solução estável e totalmente funcional para usuários do Windows, mas o suporte para Linux e macOS será disponibilizado com a atualização 1.0.

O suporte para Apple Silicon também está planejado, mas atualmente só tenho um Intel Macbook Pro disponível para teste vou conseguir uma instância do Apple Silicon no Amazon AWS para implementar isso, a tempo para o lançamento 1.0.

Tamanho de entrada: 1920x1080 @ 2x

| RTX 2060S 1 | RTX30702 | RTX A4000 3 | RTX 3090Ti4 | RTX 4090 5 | |

|---|---|---|---|---|---|

| RIFE / rife-v4.6 (NCNN) | 53,78fps | 64,08fps | 80,56fps | 86,24fps | 136,13fps |

| RIFE / rife-v4.6 (TensorRT) | 70,34fps | 94,63fps | 86,47fps | 122,68 fps | 170,91fps |

| CAIN/cvp-v6 (NCNN) | 9,42fps | 10,56fps | 13,42fps | 17,36fps | 44,87fps |

| CAIN/cvp-v6 (TensorRT) | 45,41fps | 63,84fps | 81,23fps | 112,87fps | 183,46 fps |

| GMFSS/Up (PyTorch) | - | - | 4,32fps | - | 16,35fps |

| GMFSS/União (PyTorch) | - | - | 3,68fps | - | 13,93fps |

| GMFSS/União (TensorRT) | - | - | 6,79fps | - | - |

| RealESRGAN/animevideov3 (TensorRT) | 7,64fps | 9,10fps | 8,49fps | 18,66fps | 38,67fps |

| RealCUGAN (TensorRT) | - | - | 5,96fps | - | - |

| SwinIR (PyTorch) | - | - | 0,43fps | - | - |

| DPIR/Redução de ruído (TensorRT) | 4,38fps | 6,45fps | 5,39fps | 11,64fps | 27,41fps |

1 Ryzen 5 3600X - Gainward RTX 2060 Super @ estoque

2 Ryzen 7 3800X - Gigabyte RTX 3070 Eagle OC @ estoque

3 Ryzen 5 3600X - PNY RTX A4000 @ estoque

4 i9 12900KF - ASUS RTX 3090 Ti Strix OC @ ~ 2220 MHz

5 Ryzen 9 5950X - ASUS RTX 4090 Strix OC - @ ~3100MHz com curva para alcançar desempenho máximo

Esta seção foi movida para o wiki: https://github.com/mafiosnik777/enhancr/wiki

Confira para saber mais sobre como aproveitar ao máximo o aprimoramento ou como corrigir vários problemas.

TensorRT é um tempo de execução de inferência de IA altamente otimizado para GPUs NVIDIA. Ele usa benchmarking para encontrar o kernel ideal para usar em sua GPU específica, e há uma etapa extra para construir um mecanismo na máquina na qual você executará a IA. No entanto, o desempenho resultante também é normalmente muito melhor do que qualquer implementação PyTorch ou NCNN.

NCNN é uma estrutura de computação de inferência de rede neural de alto desempenho otimizada para plataformas móveis. A NCNN não possui dependências de terceiros. É multiplataforma e roda mais rápido do que todas as estruturas de código aberto conhecidas na maioria das principais plataformas. Suporta NVIDIA, AMD, Intel Graphics e até Apple Silicon. NCNN está sendo usado atualmente em muitos aplicativos Tencent, como QQ, Qzone, WeChat, Pitu e assim por diante.

Ficaria muito grato se você pudesse demonstrar seu apoio a este projeto contribuindo no Patreon ou através de uma doação no PayPal. Seu apoio ajudará a acelerar o desenvolvimento e trazer mais atualizações para o projeto. Além disso, se você tiver as habilidades, também poderá contribuir abrindo uma solicitação pull. Independentemente da forma de apoio que você escolher dar, saiba que ela é muito apreciada.

Estou trabalhando continuamente para melhorar a base de código, inclusive resolvendo quaisquer inconsistências que possam ter surgido devido a limitações de tempo. Atualizações regulares serão lançadas, incluindo novos recursos, correções de bugs e a incorporação de novas tecnologias e modelos à medida que estiverem disponíveis. Obrigado pela sua compreensão e apoio.

Nosso player depende de mpv e ModernX para OSC.

Obrigado a HubertSontowski e styler00dollar por ajudar na implementação do CAIN.

Para interagir com a comunidade, compartilhar seus resultados ou obter ajuda ao encontrar algum problema visite nosso discord. Prévias das próximas versões também serão exibidas lá.