DeepRTS é um jogo de estratégia em tempo real de alto desempenho para pesquisas de Aprendizado por Reforço. Ele foi escrito em C++ para desempenho, mas fornece uma interface python para melhor interface com kits de ferramentas de aprendizado de máquina. Deep RTS pode processar o jogo com mais de 6.000.000 de passos por segundo e 2.000.000 de passos ao renderizar gráficos. Em comparação com outras soluções, como StarCraft, este é um tempo de simulação 15.000% mais rápido rodando em Intel i7-8700k com Nvidia RTX 2080 TI.

O objetivo do Deep RTS é trazer uma solução mais acessível e sustentável para a pesquisa RTS AI, reduzindo o tempo de computação.

Recomenda-se usar o branch master para a versão mais recente (e geralmente melhor) do ambiente. Estou grato por qualquer contribuição em relação à melhoria do meio ambiente.

Por favor, use a seguinte citação ao usar isso em seu trabalho!

@INPROCEEDINGS{8490409,

author={P. {Andersen} and M. {Goodwin} and O. {Granmo}},

booktitle={2018 IEEE Conference on Computational Intelligence and Games (CIG)},

title={Deep RTS: A Game Environment for Deep Reinforcement Learning in Real-Time Strategy Games},

year={2018},

volume={},

number={},

pages={1-8},

keywords={computer games;convolution;feedforward neural nets;learning (artificial intelligence);multi-agent systems;high-performance RTS game;artificial intelligence research;deep reinforcement learning;real-time strategy games;computer games;RTS AIs;Deep RTS game environment;StarCraft II;Deep Q-Network agent;cutting-edge artificial intelligence algorithms;Games;Learning (artificial intelligence);Machine learning;Planning;Ground penetrating radar;Geophysical measurement techniques;real-time strategy game;deep reinforcement learning;deep q-learning},

doi={10.1109/CIG.2018.8490409},

ISSN={2325-4270},

month={Aug},}

sudo pip3 install git+https://github.com/cair/DeepRTS.git

git clone https://github.com/cair/deep-rts.git

cd deep-rts

git submodule sync

git submodule update --init

sudo pip3 install .

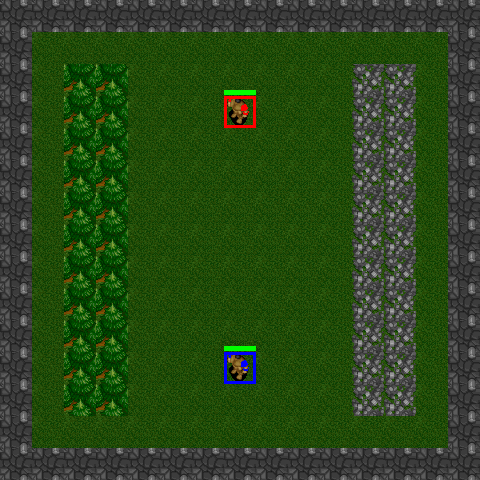

10x10-2-FFA

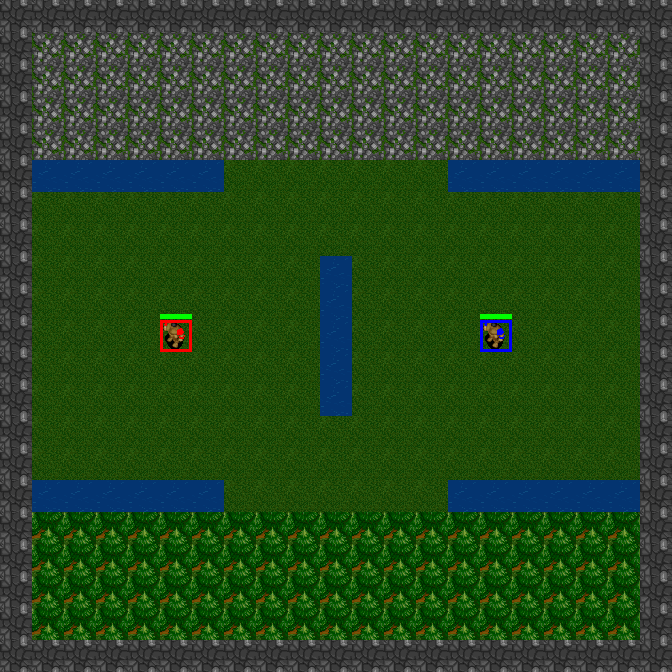

15x15-2-FFA

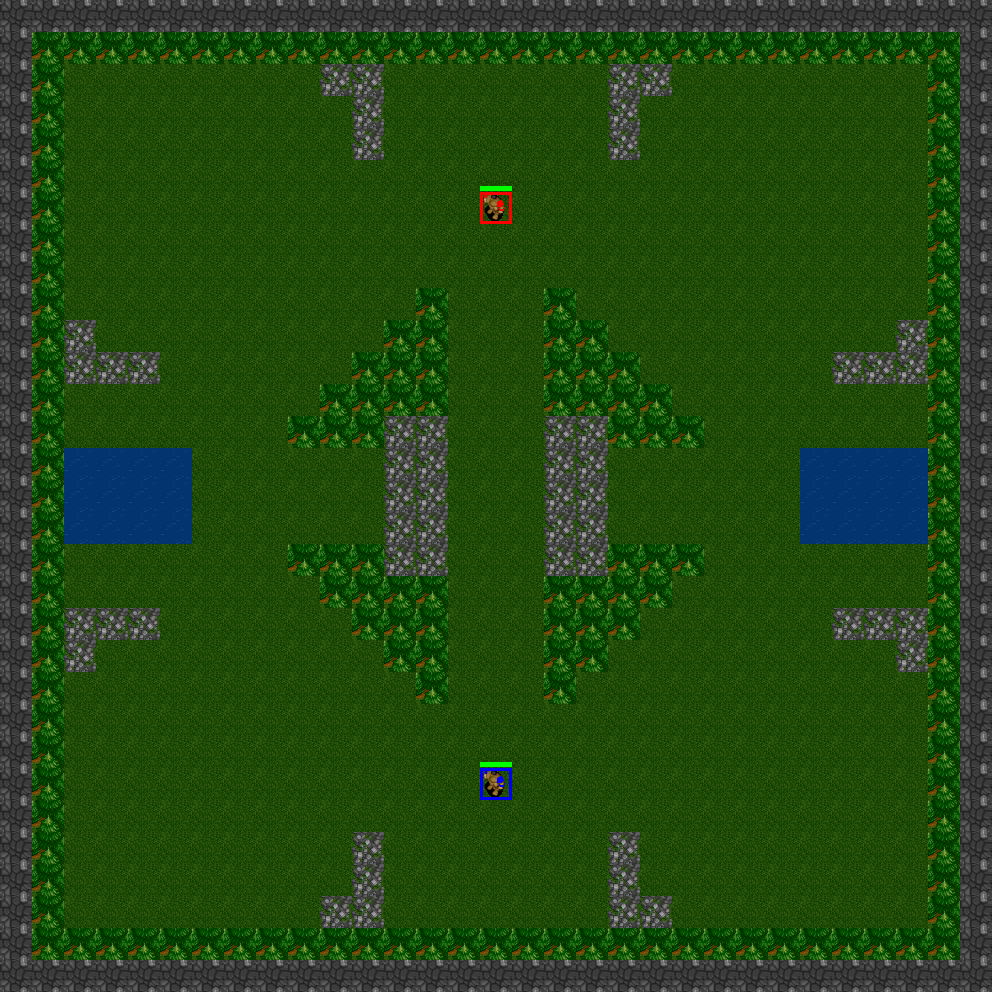

21x21-2-FFA

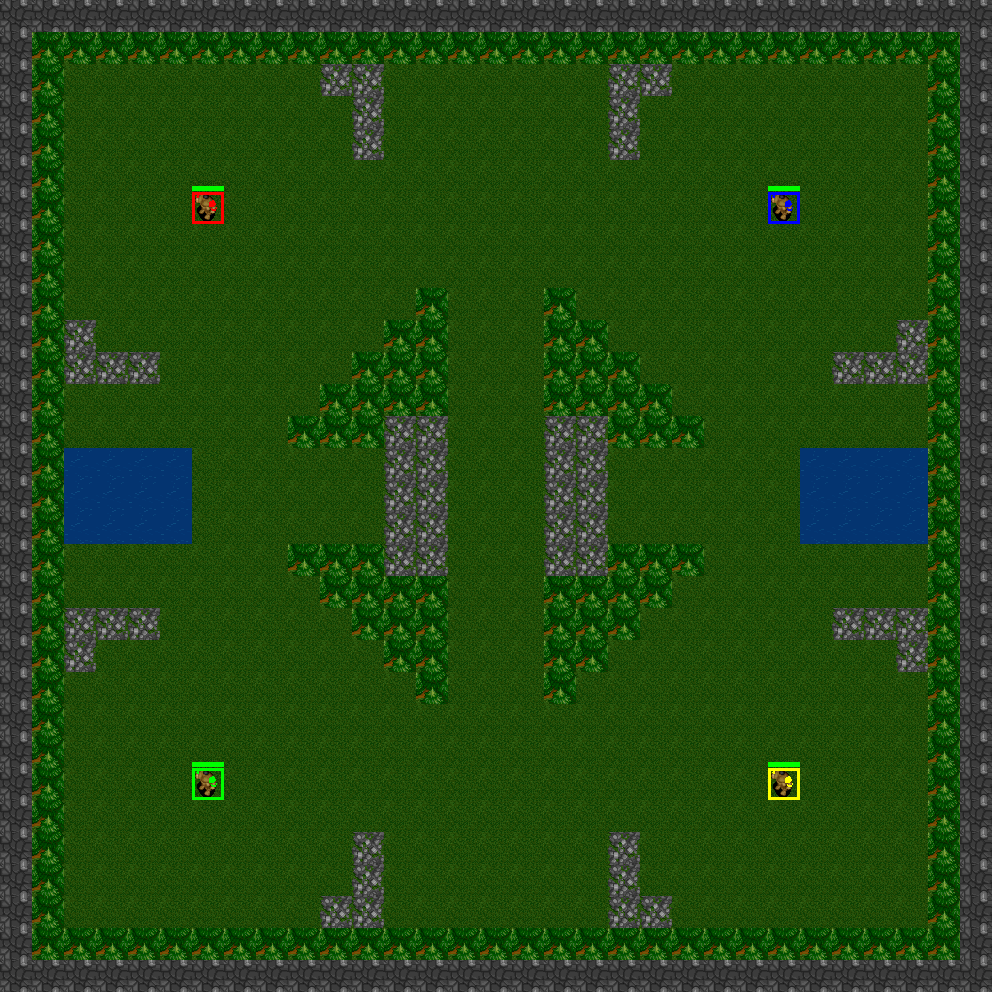

31x31-2-FFA

31x31-4-FFA

31x31-6-FFA

Deep RTS apresenta cenários que são minijogos pré-construídos. Esses minijogos são adequados para treinar agentes em tarefas específicas ou para testar algoritmos em diferentes configurações de problemas. Os benefícios de usar cenários é que você pode projetar funções de recompensa de maneira trivial usando critérios em que cada uma gera um sinal de recompensa/punição dependendo da conclusão da tarefa. Exemplos de tarefas são:

Deep RTS implementa atualmente os seguintes cenários

GoldCollectFifteen

GeneralAIOneVersusOne

import random

from DeepRTS . python import Config

from DeepRTS . python import scenario

if __name__ == "__main__" :

random_play = True

episodes = 100

for i in range ( episodes ):

env = scenario . GeneralAI_1v1 ( Config . Map . THIRTYONE )

state = env . reset ()

done = False

while not done :

env . game . set_player ( env . game . players [ 0 ])

action = random . randrange ( 15 )

next_state , reward , done , _ = env . step ( action )

state = next_state

if ( done ):

break

env . game . set_player ( env . game . players [ 1 ])

action = random . randrange ( 15 )

next_state , reward , done , _ = env . step ( action )

state = next_state