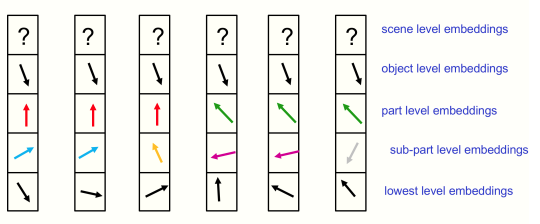

Uma implementação de Glom, a nova ideia de Geoffrey Hinton que integra conceitos de campos neurais, processamento de cima para baixo e de baixo para cima e atenção (consenso entre colunas) para aprender hierarquias parte-todo emergentes a partir de dados.

O vídeo de Yannic Kilcher foi fundamental para me ajudar a entender este artigo

$ pip install glom-pytorch import torch

from glom_pytorch import Glom

model = Glom (

dim = 512 , # dimension

levels = 6 , # number of levels

image_size = 224 , # image size

patch_size = 14 # patch size

)

img = torch . randn ( 1 , 3 , 224 , 224 )

levels = model ( img , iters = 12 ) # (1, 256, 6, 512) - (batch - patches - levels - dimension) Passe o argumento da palavra-chave return_all = True adiante e você receberá todos os estados de coluna e nível por iteração (incluindo o estado inicial, número de iterações + 1). Você pode então usar isso para anexar quaisquer perdas a qualquer nível de saída em qualquer intervalo de tempo.

Ele também fornece acesso a todos os dados de nível entre iterações para clustering, a partir dos quais é possível inspecionar as ilhas teorizadas no artigo.

import torch

from glom_pytorch import Glom

model = Glom (

dim = 512 , # dimension

levels = 6 , # number of levels

image_size = 224 , # image size

patch_size = 14 # patch size

)

img = torch . randn ( 1 , 3 , 224 , 224 )

all_levels = model ( img , iters = 12 , return_all = True ) # (13, 1, 256, 6, 512) - (time, batch, patches, levels, dimension)

# get the top level outputs after iteration 6

top_level_output = all_levels [ 7 , :, :, - 1 ] # (1, 256, 512) - (batch, patches, dimension)Eliminando o ruído da aprendizagem auto-supervisionada para encorajar a emergência, conforme descrito por Hinton

import torch

import torch . nn . functional as F

from torch import nn

from einops . layers . torch import Rearrange

from glom_pytorch import Glom

model = Glom (

dim = 512 , # dimension

levels = 6 , # number of levels

image_size = 224 , # image size

patch_size = 14 # patch size

)

img = torch . randn ( 1 , 3 , 224 , 224 )

noised_img = img + torch . randn_like ( img )

all_levels = model ( noised_img , return_all = True )

patches_to_images = nn . Sequential (

nn . Linear ( 512 , 14 * 14 * 3 ),

Rearrange ( 'b (h w) (p1 p2 c) -> b c (h p1) (w p2)' , p1 = 14 , p2 = 14 , h = ( 224 // 14 ))

)

top_level = all_levels [ 7 , :, :, - 1 ] # get the top level embeddings after iteration 6

recon_img = patches_to_images ( top_level )

# do self-supervised learning by denoising

loss = F . mse_loss ( img , recon_img )

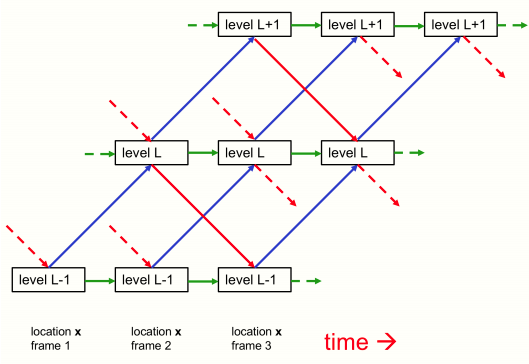

loss . backward ()Você pode passar o estado da coluna e dos níveis de volta ao modelo para continuar de onde parou (talvez se estiver processando quadros consecutivos de um vídeo lento, conforme mencionado no artigo)

import torch

from glom_pytorch import Glom

model = Glom (

dim = 512 ,

levels = 6 ,

image_size = 224 ,

patch_size = 14

)

img1 = torch . randn ( 1 , 3 , 224 , 224 )

img2 = torch . randn ( 1 , 3 , 224 , 224 )

img3 = torch . randn ( 1 , 3 , 224 , 224 )

levels1 = model ( img1 , iters = 12 ) # image 1 for 12 iterations

levels2 = model ( img2 , levels = levels1 , iters = 10 ) # image 2 for 10 iteratoins

levels3 = model ( img3 , levels = levels2 , iters = 6 ) # image 3 for 6 iterationsObrigado a Cfoster0 por revisar o código

@misc { hinton2021represent ,

title = { How to represent part-whole hierarchies in a neural network } ,

author = { Geoffrey Hinton } ,

year = { 2021 } ,

eprint = { 2102.12627 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

}