Importante

2024.10.10: Cirurgia, restauração de emergência do servidor de arquivos que fornece pacote WHL

2024.10.8: Versão 3..90 Adicionar suporte preliminar para llama-idex, a versão 3.80 adiciona função de menu secundário plug-in (consulte o wiki para obter detalhes)

2024.5.1: Adicione a função do papel PDF de tradução doc2x, veja os detalhes

2024.3.11: Apoie totalmente modelos de grandes idiomas chineses, como Qwen, Glm, Deepseekcoder! Sovits Módulo de clonagem de voz, visualize detalhes 2024.1.17: Ao instalar dependências, selecione a versão especificada no requirements.txt . Comando de instalação: pip install -r requirements.txt . Este projeto é completamente de código aberto e gratuito.

Se você gosta deste projeto, por favor, dê uma estrela;

Se você gosta deste projeto, dê uma estrela multi_language.py

Observação

1. A função de cada arquivo neste projeto é o relatório de auto -tradução self_analysis.md . Com a iteração da versão, você também pode clicar no plugue de função relevante -a qualquer momento, para chamar o Relatório de auto -comparação de re -generação. Para perguntas comuns, verifique o Wiki.

2. Este projeto é compatível e incentiva o teste de grandes modelos domésticos de base de idiomas chineses, como Tongyi Qianqian, Spectrum Wisdom Glm, etc. Suporte a coexistência de múltiplas teclas API, você pode preencher o arquivo de configuração, como API_KEY="openai-key1,openai-key2,azure-key3,api2d-key4" . Quando você precisar substituir temporariamente API_KEY , insira a API_KEY temporária na área de entrada e envie -a para a tecla Ride para entrar em vigor.

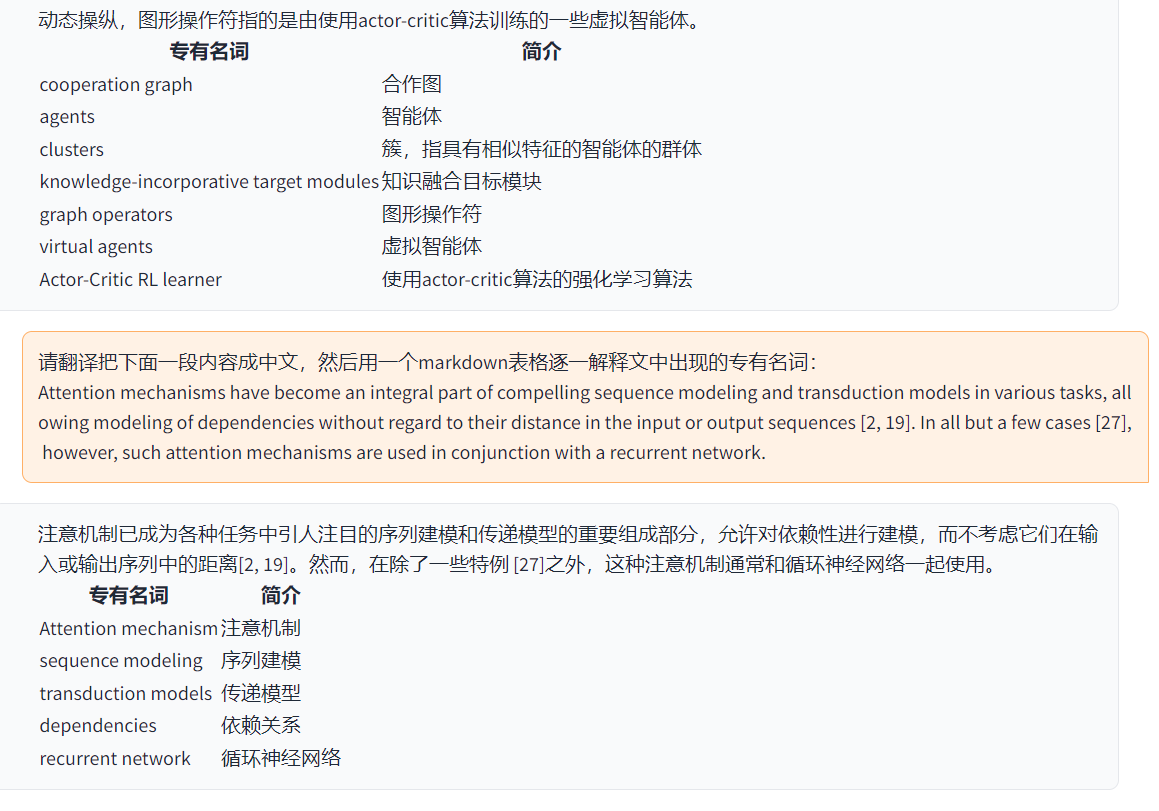

| Função (= novos recursos recentes) | descrever |

|---|---|

| Novo modelo | Baidu Qianfan e Wenxin disseram, Tongyi Qian Qi Qwen, Scholar Scholar Ai-Lab de Shanghai, Xun Feixing Fire, LLAMA2, Wisdom Speed Glm4, Dalle3, Deepseekcoder |

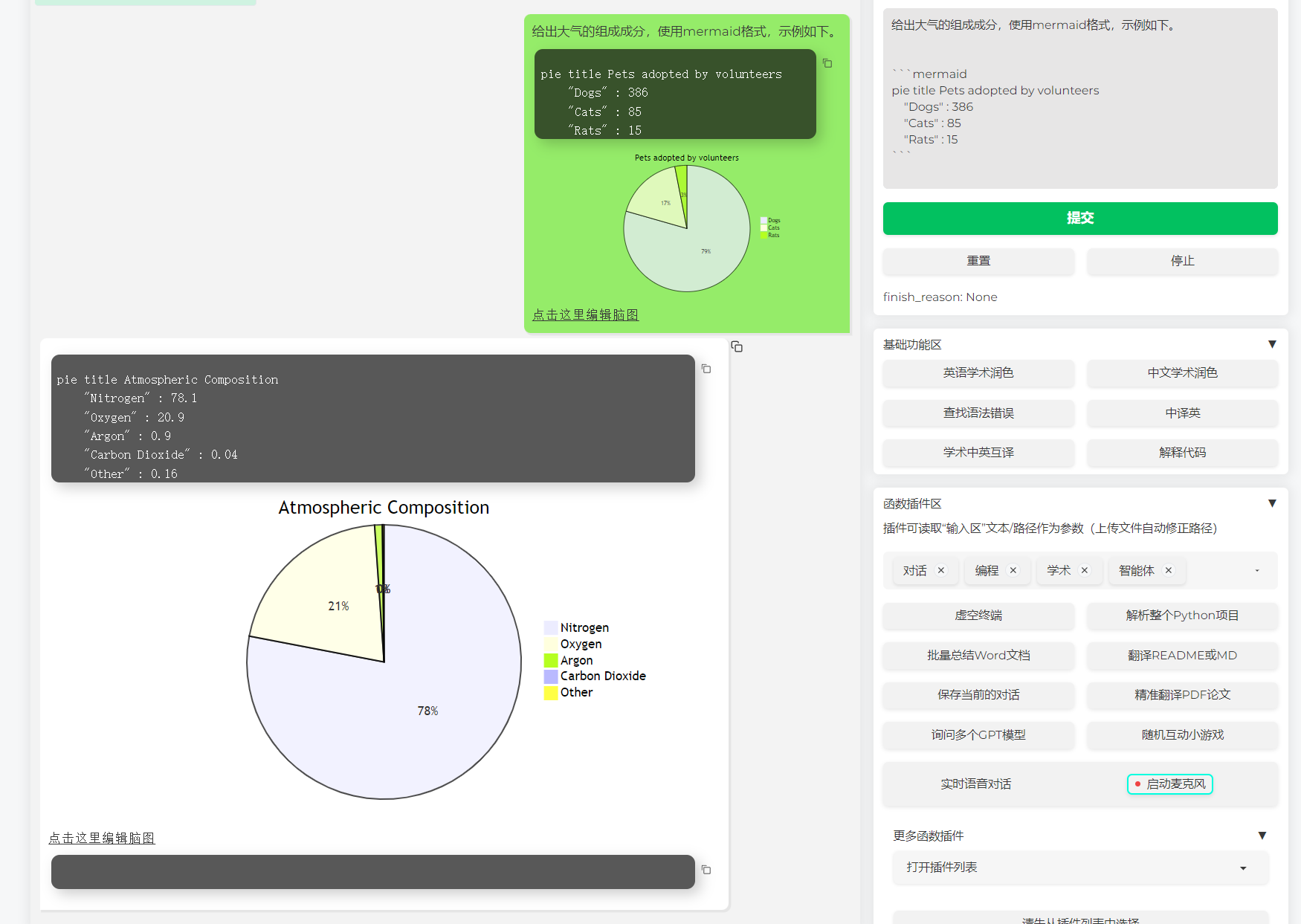

| Suporte a renderização da imagem da sereia | Suporte para permitir que o GPT gere fluxogramas, diagramas de transferência de status, mapas de gands, bolos, gitgraph etc. (versão 3.7) |

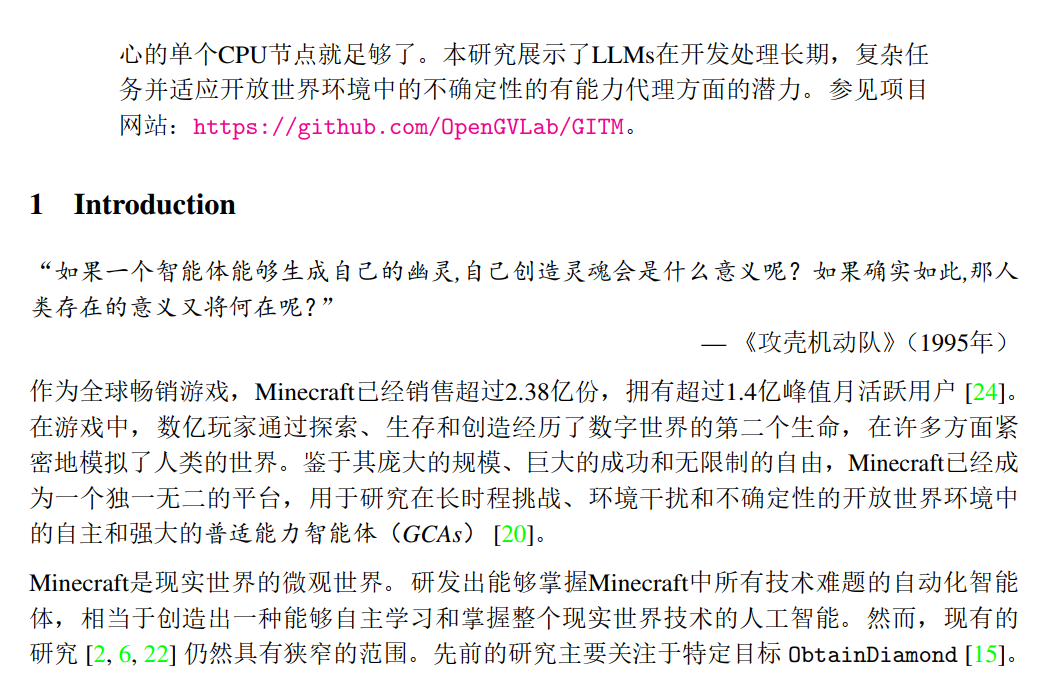

| Tese Arxiv Tradução fina (Docker) | [Plug -in] Tradução de um clique da tese de arxiv com um clique, a melhor ferramenta de tradução em papel atualmente |

| Entrada de diálogo de voz real -Time | [Plug -in] áudio de audição assíncrono, desconexão automática de frase, encontre automaticamente o tempo para responder |

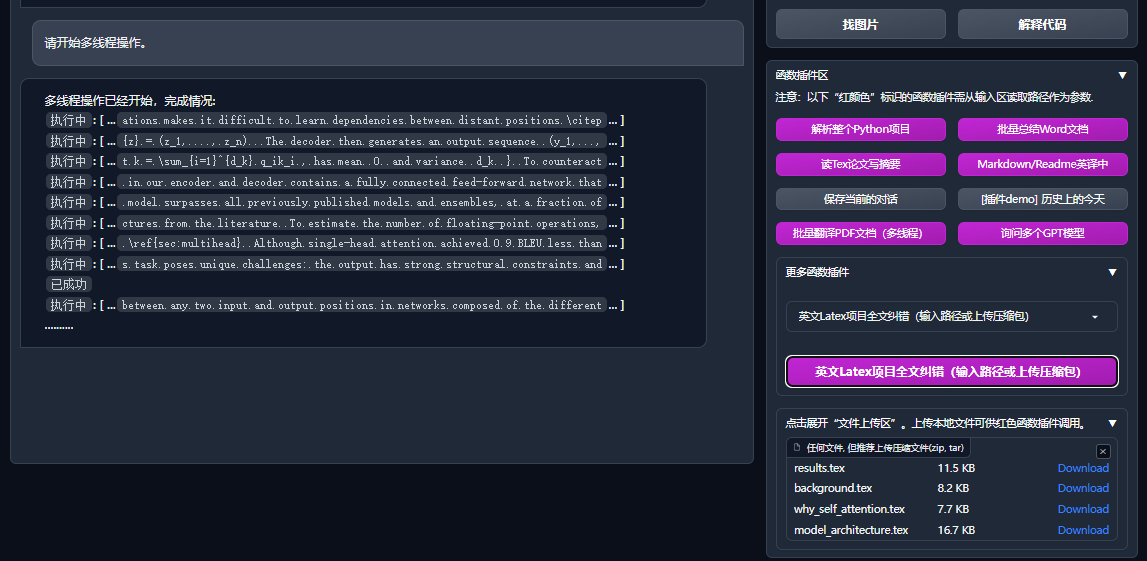

| Plugin multi -smart automático | [Plug -in] Com a ajuda do Microsoft Autogen, explore a possibilidade do surgimento inteligente do agente da dupla! |

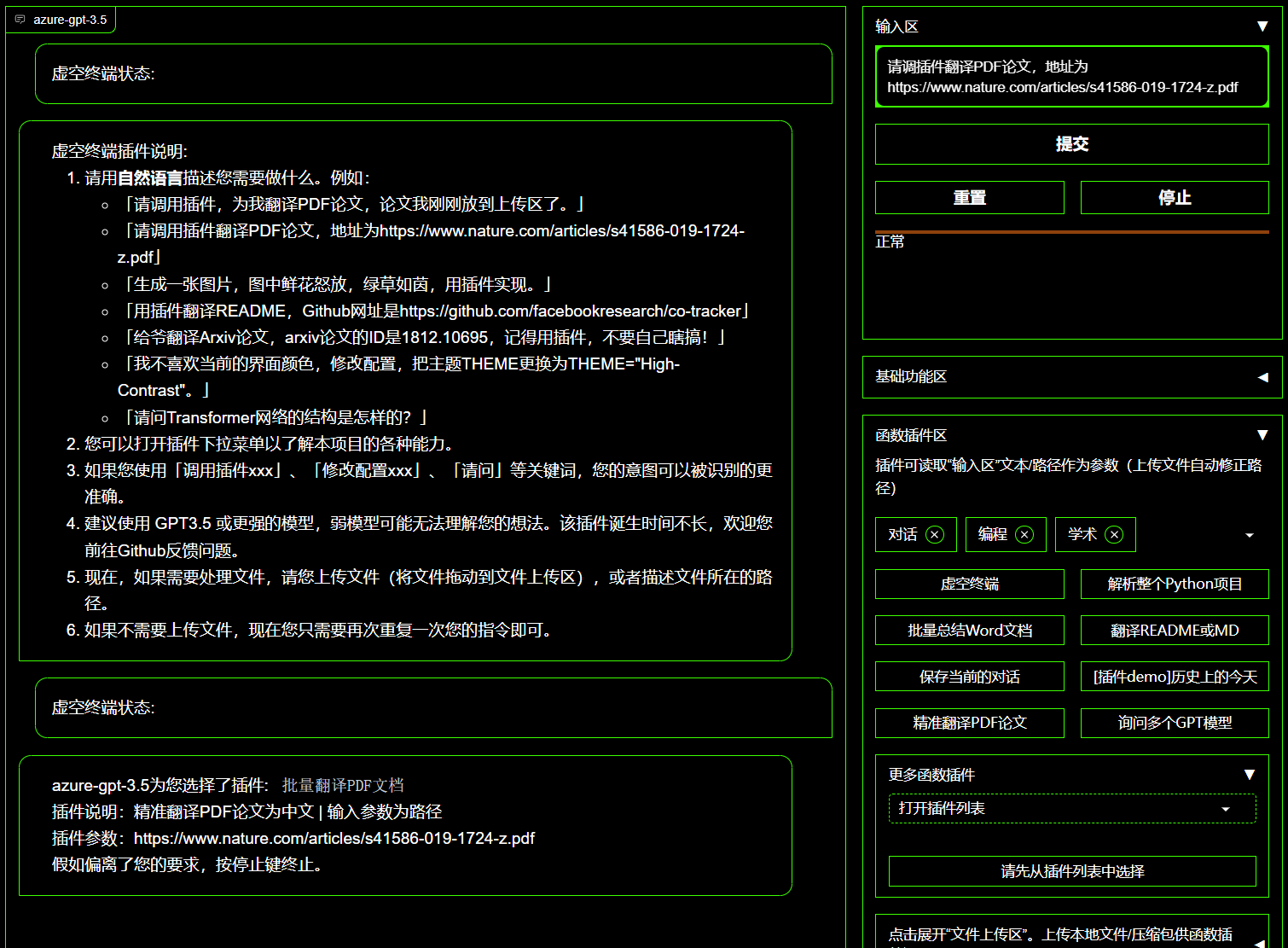

| Plug -in de terminal vazio | [Plug -in] pode agendar diretamente outro plug -in neste projeto em linguagem natural |

| Interpretação de cor, tradução, explicação de código | Um clique hidratante, tradução, encontrando erros de gramática, código de interpretação |

| Chave de atalho personalizada | Suporte as chaves de atalho personalizadas |

| Design modular | Suportar plug -in forte personalizado, plug -in suporta atualizações quentes |

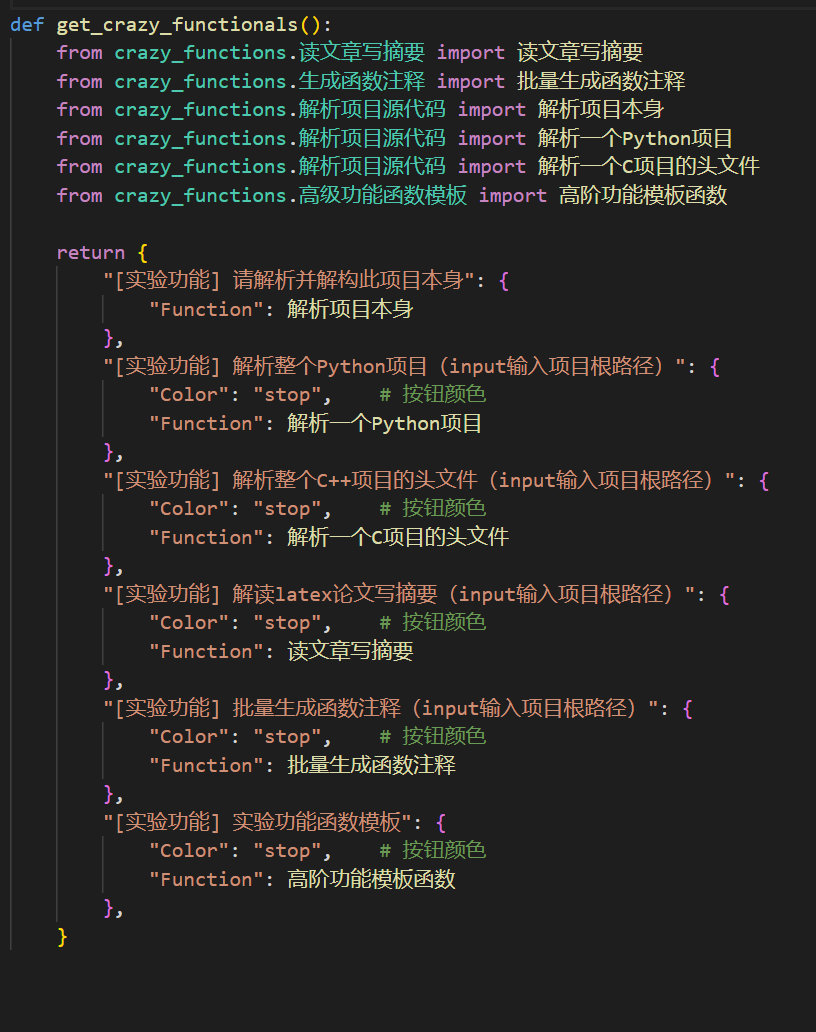

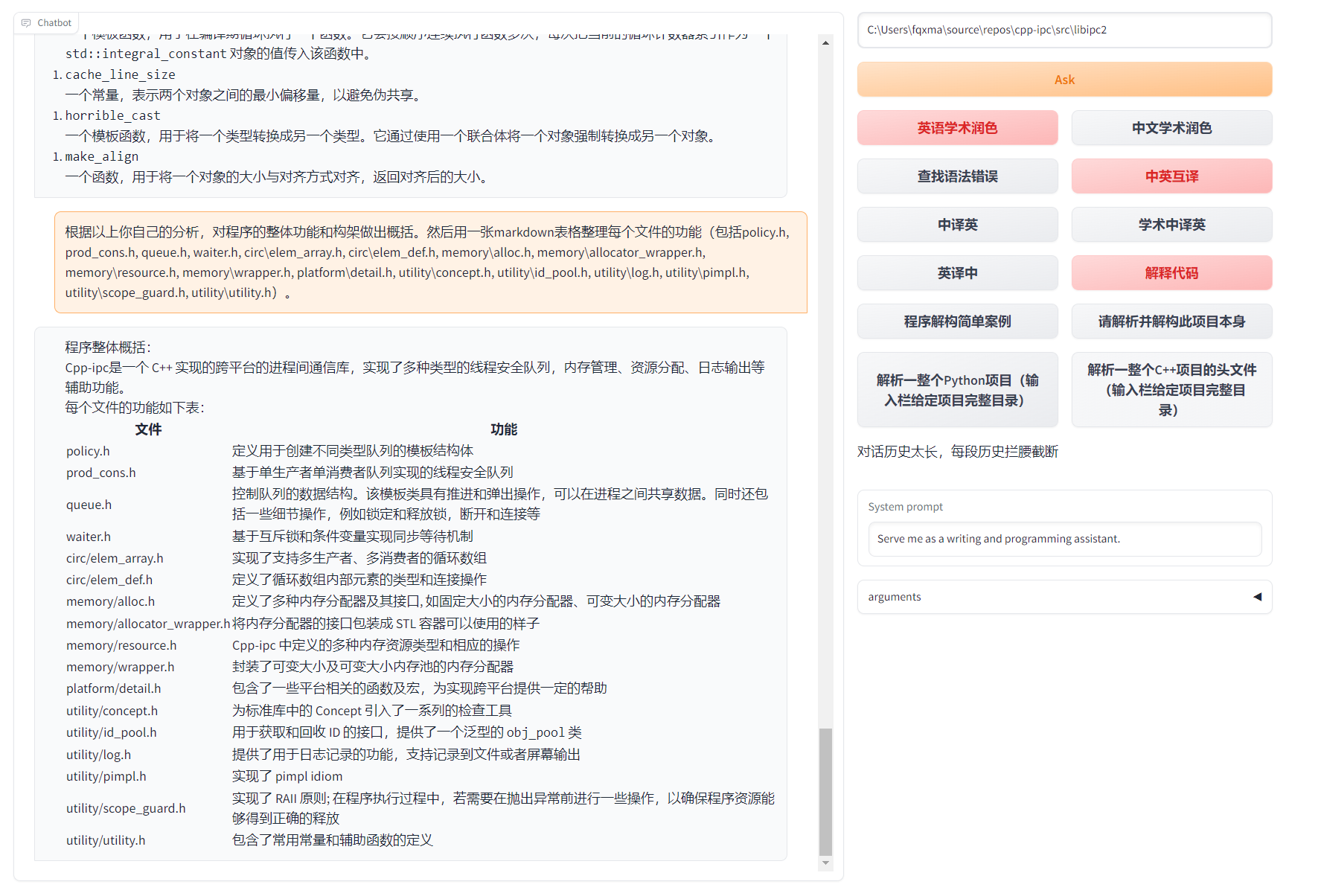

| Análise do programa | [Plug -in] Análise de um clique de python/c/c ++/java/lua/... árvore de projeto ou auto -análise |

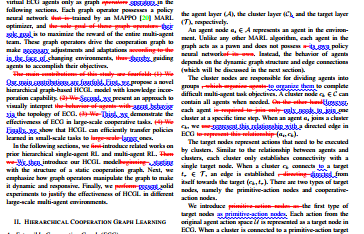

| Leia o jornal, traduza a tese | [Plug -in] Interpretação de um clique de papel de látex/PDF Texto completo e de geração de resumos |

| Tradução completa de látex, hidratante | [Plug -in] Tradução de um clique ou papel hidratante de látex |

| Anotação em lote | [Plug -in] One -clique em lote gerar anotação da função |

| Rekdown Chinese e British Mutual Translations | [Plug -in] Você vê o idioma de leitura 5? É de sua caligrafia |

| Função de tradução de texto completo em papel | [Plug -in] PDF Extrato de papel Perguntas e resumo+Tradução Texto completo (multi -thread) |

| Arxiv Assistente | [Plug -in] Digite o artigo do artigo ARXIV para um resumo de tradução de um clique+download pdf |

| Papers de Latex One -Click School Par | [Plug -in] imitação de gramática à sintaxe, correção de feitiços+controle de saída PDF em artigos de látex |

| Assistente de integração acadêmica do Google | [Plug -in] Dado o URL da página de pesquisa acadêmica de Ren Itália, deixe o GPT ajudá -lo a escrever o RelatedWorks |

| Agregação de informações da Internet+GPT | [Plug -in] Um clique para permitir que o GPT obtenha informações da Internet e responda a perguntas, para que as informações nunca fiquem desatualizadas |

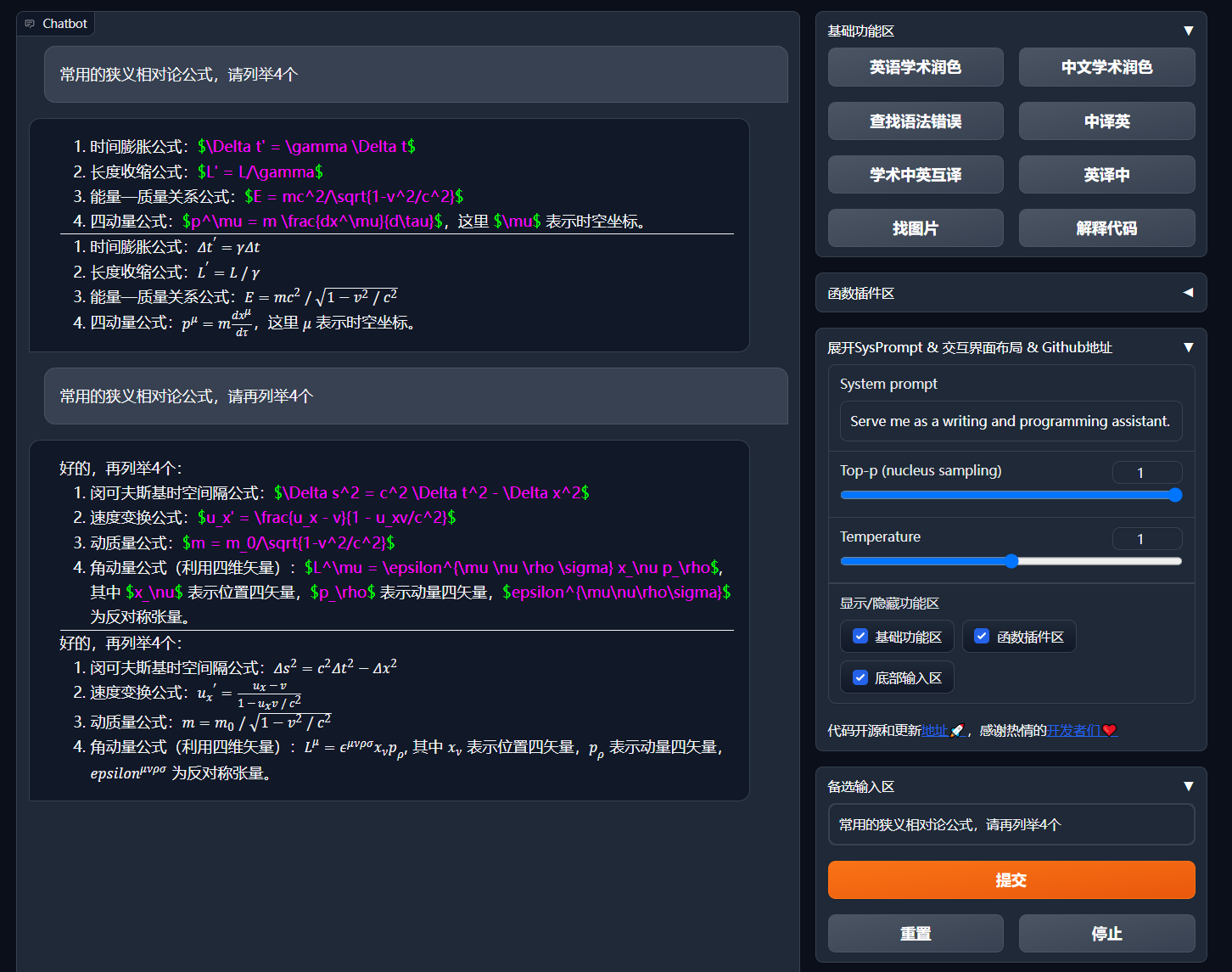

| Exibição de fórmula/imagem/formulário | Você pode exibir a fórmula e a forma de renderização da fórmula ao mesmo tempo e apoiar a fórmula e o destaque do código |

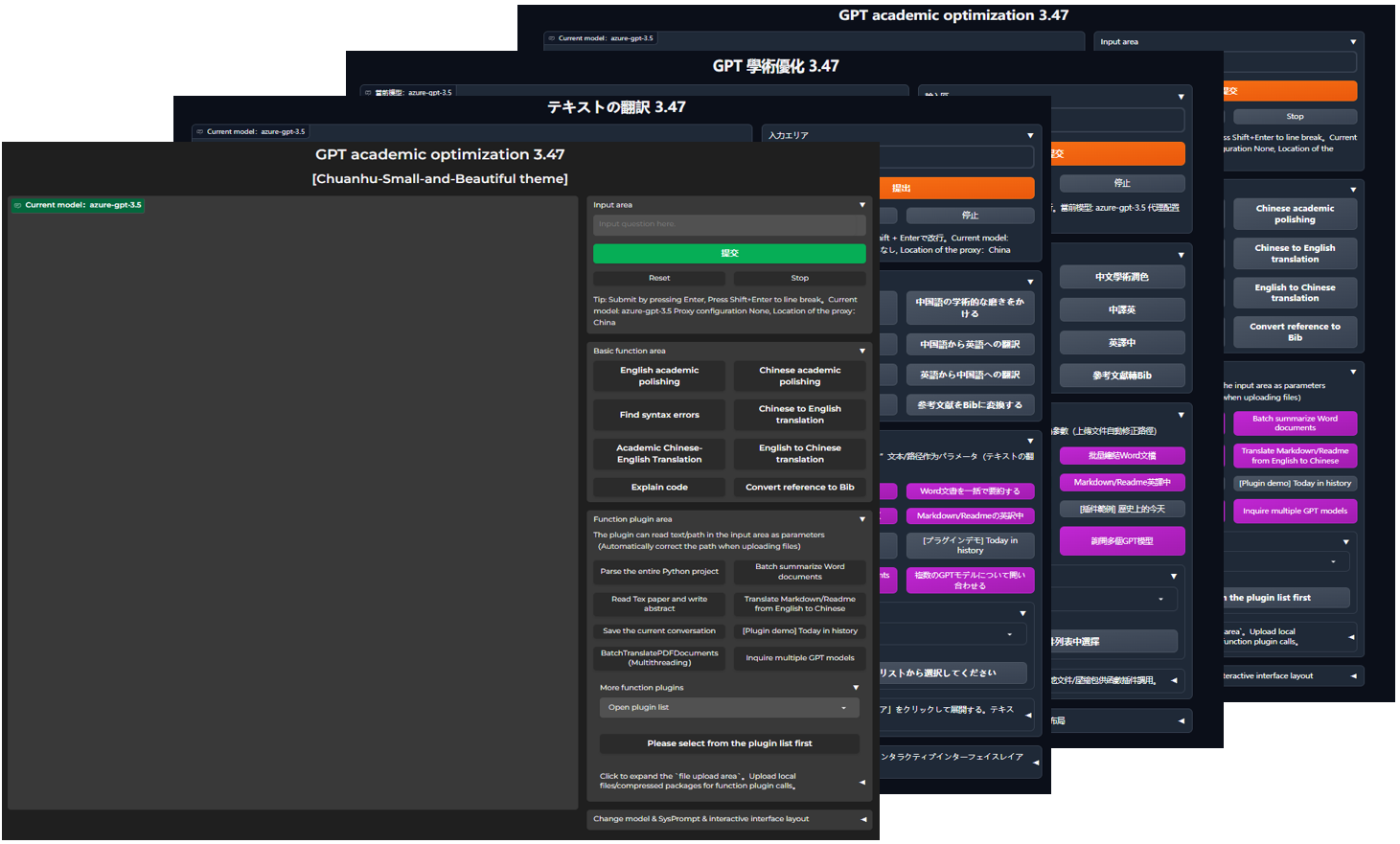

| Comece o tema sombrio | Adicionar /?__theme=dark |

| Suporte de modelo multi LLM | Ao mesmo tempo, o sentimento de ser servido por GPT3.5, GPT4, Tsinghua chatglm2, Fudan Moss deve ser muito bom? |

| Mais acesso ao modelo LLM, suporta a implantação do HuggingFace | Junte -se à Interface Newbing (New Must), apresente Tsinghua Jittorllms para apoiar a llama e o Pangu α |

| Pacote PIP de Vazio-Terminal | Deixando a GUI, chame diretamente todo o plugue de função -in do item em Python (em desenvolvimento) |

| Mais nova exibição de recursos (geração de imagens, etc.) ... | Veja o final deste artigo ... |

config.py para obter a comutação "esquerda -correta" e "layout superior e inferior")

Fluxograma TD

A {"Método de instalação"} -> w1 ("i.? Execute diretamente (Windows, Linux ou MacOS)"))))

W1-> W11 ["1. Dependência do gerenciamento de pacotes python pip"]

W1-> W12 ["2. Dependências de gerenciamento de pacotes da Anaconda (Recomendação)"]]

A -> w2 ["ii.? Use Docker (Windows, Linux ou MacOS)"]]

W2-> K1 ["1. Imagem de espelho grande implantando todos os recursos (recomendação)"]]]

W2-> K2 ["2. Somente modelo online (GPT, Glm4, etc.) espelho"]

W2-> K3 ["3. Modelo online+ espelho grande do látex"]

A -> w4 ["iv. Outros métodos de implantação"]]]

W4-> C1 ["1. Windows/MacOS One -Click Instalação e Run Script (Recomendação)"]

W4-> C2 ["2. Huggingface, implantação remota de foca"]]

W4-> C4 ["3. ... Outro ..."]]

Projeto de download

git clone --depth=1 https://github.com/binary-husky/gpt_academic.git

cd gpt_academicConfigurar API_KEY e outras variáveis

Em config.py , configure variáveis como a chave da API. Método de configuração de ambiente de rede especial, descrição da configuração do projeto Wiki.

"O programa dará prioridade a verificar se existe um arquivo de configuração privado chamado config_private.py e configurar o mesmo nome com a configuração do config.py . Se você pode entender a lógica de leitura acima, recomendamos fortemente Mesmo caminho do config_private.py config.py config_private.py

"Apoie o item de configuração环境变量, consulte o arquivo docker-compose.yml ou nossa página wiki do formato de escrita da variável de ambiente. Prioridade de leitura de configuração:环境变量> config_private.py > config.py ".

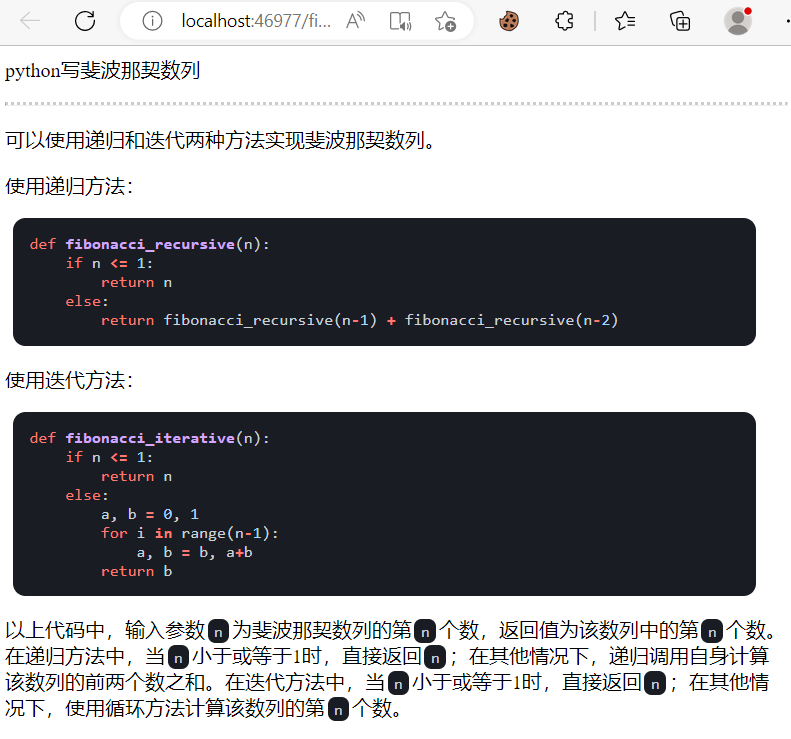

Dependência da instalação

# (选择I: 如熟悉python, python推荐版本 3.9 ~ 3.11)备注:使用官方pip源或者阿里pip源, 临时换源方法:python -m pip install -r requirements.txt -i https://mirrors.aliyun.com/pypi/simple/

python -m pip install -r requirements.txt

# (选择II: 使用Anaconda)步骤也是类似的 (https://www.bilibili.com/video/BV1rc411W7Dr):

conda create -n gptac_venv python=3.11 # 创建anaconda环境

conda activate gptac_venv # 激活anaconda环境

python -m pip install -r requirements.txt # 这个步骤和pip安装一样的步骤[Etapas opcionais] Se você precisar oferecer suporte a Tsinghua Chatglm3/Fudan Moss como back -end, precisar

# 【可选步骤I】支持清华ChatGLM3。清华ChatGLM备注:如果遇到"Call ChatGLM fail 不能正常加载ChatGLM的参数" 错误,参考如下: 1:以上默认安装的为torch+cpu版,使用cuda需要卸载torch重新安装torch+cuda; 2:如因本机配置不够无法加载模型,可以修改request_llm/bridge_chatglm.py中的模型精度, 将 AutoTokenizer.from_pretrained("THUDM/chatglm-6b", trust_remote_code=True) 都修改为 AutoTokenizer.from_pretrained("THUDM/chatglm-6b-int4", trust_remote_code=True)

python -m pip install -r request_llms/requirements_chatglm.txt

# 【可选步骤II】支持复旦MOSS

python -m pip install -r request_llms/requirements_moss.txt

git clone --depth=1 https://github.com/OpenLMLab/MOSS.git request_llms/moss # 注意执行此行代码时,必须处于项目根路径

# 【可选步骤III】支持RWKV Runner

参考wiki:https://github.com/binary-husky/gpt_academic/wiki/%E9%80%82%E9%85%8DRWKV-Runner

# 【可选步骤IV】确保config.py配置文件的AVAIL_LLM_MODELS包含了期望的模型,目前支持的全部模型如下(jittorllms系列目前仅支持docker方案):

AVAIL_LLM_MODELS = [ " gpt-3.5-turbo " , " api2d-gpt-3.5-turbo " , " gpt-4 " , " api2d-gpt-4 " , " chatglm " , " moss " ] # + ["jittorllms_rwkv", "jittorllms_pangualpha", "jittorllms_llama"]

# 【可选步骤V】支持本地模型INT8,INT4量化(这里所指的模型本身不是量化版本,目前deepseek-coder支持,后面测试后会加入更多模型量化选择)

pip install bitsandbyte

# windows用户安装bitsandbytes需要使用下面bitsandbytes-windows-webui

python -m pip install bitsandbytes --prefer-binary --extra-index-url=https://jllllll.github.io/bitsandbytes-windows-webui

pip install -U git+https://github.com/huggingface/transformers.git

pip install -U git+https://github.com/huggingface/accelerate.git

pip install peftpython main.py Todos os recursos de implantar projetos (este é um espelho grande que contém CUDA e LATEX. Mas se você tiver uma velocidade lenta de rede e um pequeno disco rígido, esse método não será recomendado para implantar um item completo)

# 修改docker-compose.yml,保留方案0并删除其他方案。然后运行:

docker-compose up Somente ChatGpt + Glm4 + Wenxin disse + Spark e outros modelos online (recomendados pela maioria das pessoas)

# 修改docker-compose.yml,保留方案1并删除其他方案。然后运行:

docker-compose upSe o PS precisar confiar na função de plug -in de látex, consulte o Wiki. Além disso, você também pode usar diretamente o Esquema 4 ou o Esquema 0 para obter a função LATEX.

Chatgpt + Glm3 + Moss + Llama2 + Tongyi Qianwen (Precisa estar familiarizado com o Nvidia Docker ao correr)

# 修改docker-compose.yml,保留方案2并删除其他方案。然后运行:

docker-compose upScript de tempo de execução do Windows One Click . Os usuários do Windows que não estão familiarizados com o ambiente Python podem baixar o script de execução de um clique publicado no lançamento para instalar uma versão sem modelos locais. Fonte de contribuição do script: Oobabooga.

Use a API de terceira parte, azul, etc., Wen Xinyi, Star Fire, etc., veja a página da wiki

Os servidores em nuvem implantaram remotamente as diretrizes para evitar o poço. Visite o Wiki de implantação remota do Cloud Server

Implantar em outras plataformas e implantação secundária de URL

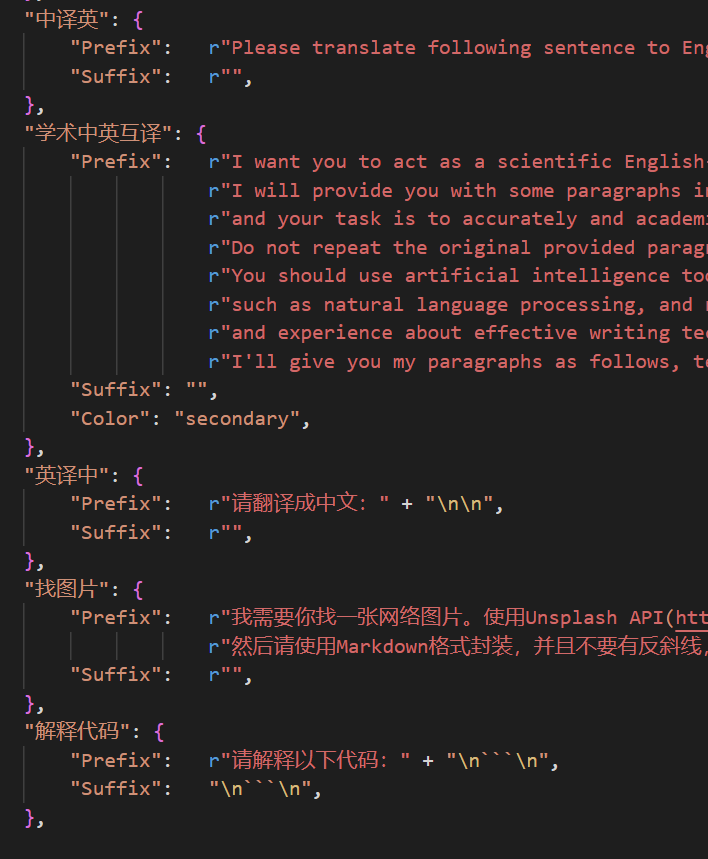

http://localhost/subpath ). Visite as instruções de operação do FASTAPI Agora você pode adicionar um novo botão conveniente ao自定义菜单no menu界面外观na interface do usuário. Se você precisar defini -lo no código, use qualquer editor de texto para abrir core_functional.py , adicione as seguintes entradas:

"超级英译中" : {

# 前缀,会被加在你的输入之前。例如,用来描述你的要求,例如翻译、解释代码、润色等等

"Prefix" : "请翻译把下面一段内容成中文,然后用一个markdown表格逐一解释文中出现的专有名词: n n " ,

# 后缀,会被加在你的输入之后。例如,配合前缀可以把你的输入内容用引号圈起来。

"Suffix" : "" ,

},

Escreva um poderoso plugue de função -para executar as tarefas que desejar e inesperadamente. O plug -in e a depuração deste projeto são muito baixos. Para detalhes, consulte o Guia de plug -in de função.

保存当前的对话na área de plug -in de função para salvar o diálogo atual como载入对话历史存档HTML de Legable+Recuperação.载入对话历史存档para restaurar a sessão anterior. Dica: se você não especificar o arquivo, clique载入对话历史存档para visualizar o cache histórico de arquivo html.

===>

===>

config.py )

===>

===>

Desenvolvedor Acadêmico GPT Grupo: 610599535

requirement.txt para instalar o gradio Linha do tempo LR

Título do Título GPT-Acadêmico Processo de Desenvolvimento de Projetos Seção 2.x

1.0 ~ 2.2: Função básica: Introduzir plugue da função modular --in: layout dobrável: plugue da função -in suporta carga térmica 2.3 ~ 2.5: aprimorar a interação multi -trigerada: novo PDF Full -Text Tradução Função: nova função de posição de troca de área de entrada: atualizado 2.6: Reconstruindo a estrutura do plugue: melhorando a interação: adicione mais plug -in Seção 3.x

3.0 ~ 3.1: Suporte para ChatGlm: Suporte a outros pequenos LLM: Suporte a vários modelos GPT ao mesmo tempo: suporta múltiplos APIKEY Balanceamento de carga 3.2 ~ 3.3: O plugue da função -in suporta mais interface de parâmetro: Salvar a função de diálogo: Interprete qualquer código de idioma: Ao mesmo tempo, pergunte a qualquer combinação LLM: Função abrangente de informações da Internet 3.4: Junte -se à tradução da tese do ARXIV: Adicionar função de correção de tese de látex 3.44: Suporta oficialmente o Azure: interface otimizada Fácil Uso 3.46: Modelo de filtro Chatglm2 personalizado: Real -Time Voice Dialogue 3.49: Apoie Alida Mo Yuan Tongyi Qian Qian: Shanghai Ai-Lab Scholar: Xun Fei Xinghuo: Suporte Baidu Qianfan Platform & Wenxin A Word 3.50: Terminal void: Terminal de suporte Plug-in: Melhorar a interface do usuário: Design Novo Tópico 3.53: Selecione Dinâmica Selecionar Diferentes Temas de Interface : Estabilidade de melhoria: resolva o problema do conflito multi -usuário 3.55: Interpreper de código dinâmico: Reconstrução da interface frontal -END: Introdução de janelas suspensas e barra de menu 3.56: Botão de função básica adicional dinâmica: novo relatório PDF Resumo Página 3.57: GLM3, GLM3, Star Fire V3: Suporte Wenxinyi Speaking V4: Corrija o bug simultâneo do modelo local

3.60: Introdução ao Autogen

3.70: Introduzir Desenho da sereia: Implementando funções como GPT Brain Desenion 3.80 (TODO): plugue automático otimizado -tema: design derivado de derivado -in Você pode mudar de temas modificando o THEME

Chuanhu-Small-and-Beautifulmaster : ramo principal, versão estávelfrontier Branch: Branch de Desenvolvimento, versão de teste代码中参考了很多其他优秀项目中的设计,顺序不分先后:

# 清华ChatGLM2-6B:

https://github.com/THUDM/ChatGLM2-6B

# 清华JittorLLMs:

https://github.com/Jittor/JittorLLMs

# ChatPaper:

https://github.com/kaixindelele/ChatPaper

# Edge-GPT:

https://github.com/acheong08/EdgeGPT

# ChuanhuChatGPT:

https://github.com/GaiZhenbiao/ChuanhuChatGPT

# Oobabooga one-click installer:

https://github.com/oobabooga/one-click-installers

# More:

https://github.com/gradio-app/gradio

https://github.com/fghrsh/live2d_demo