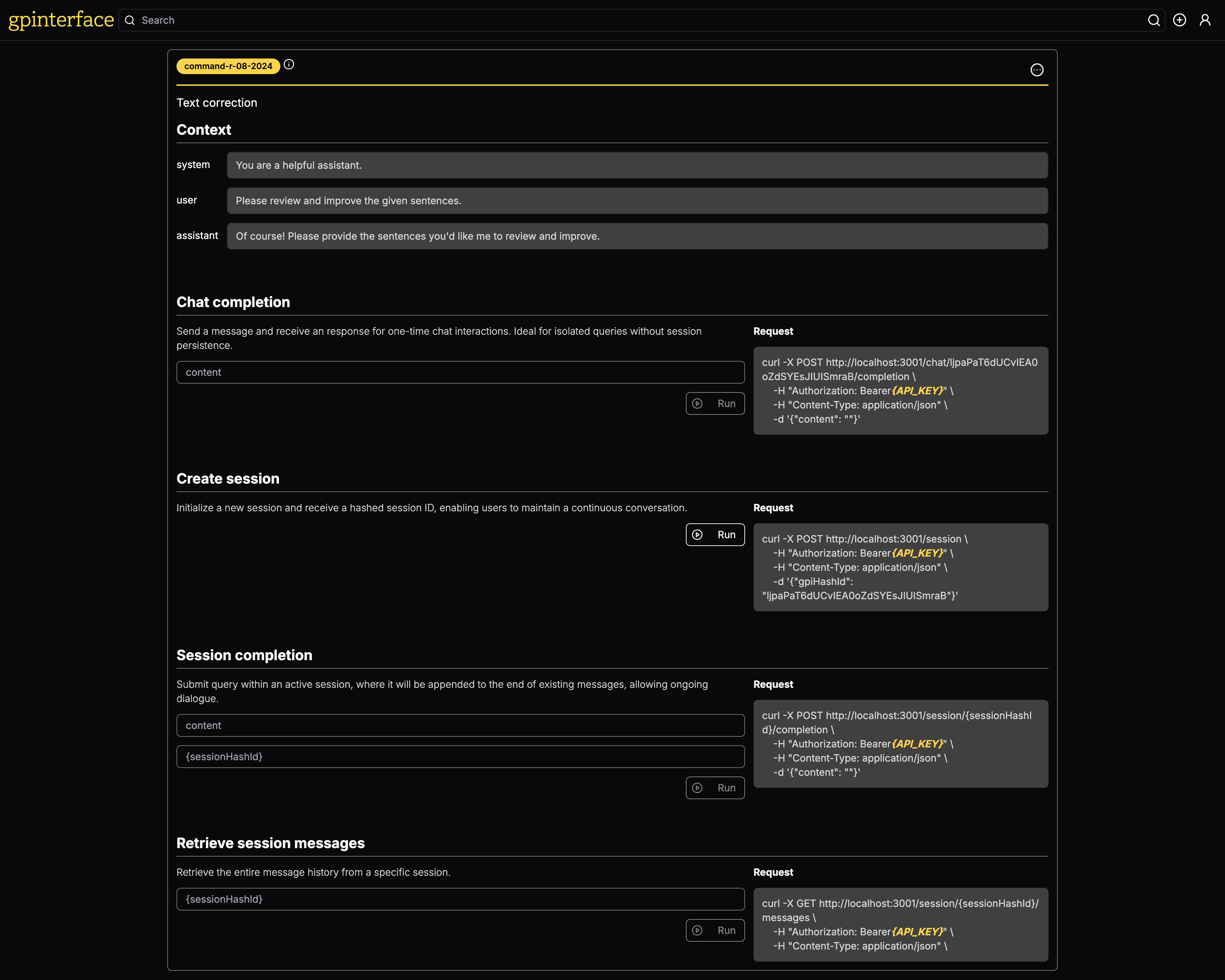

Com gpinterface , você pode criar facilmente API para seus avisos.

Uma demonstração ao vivo está disponível em gpinterface.com.

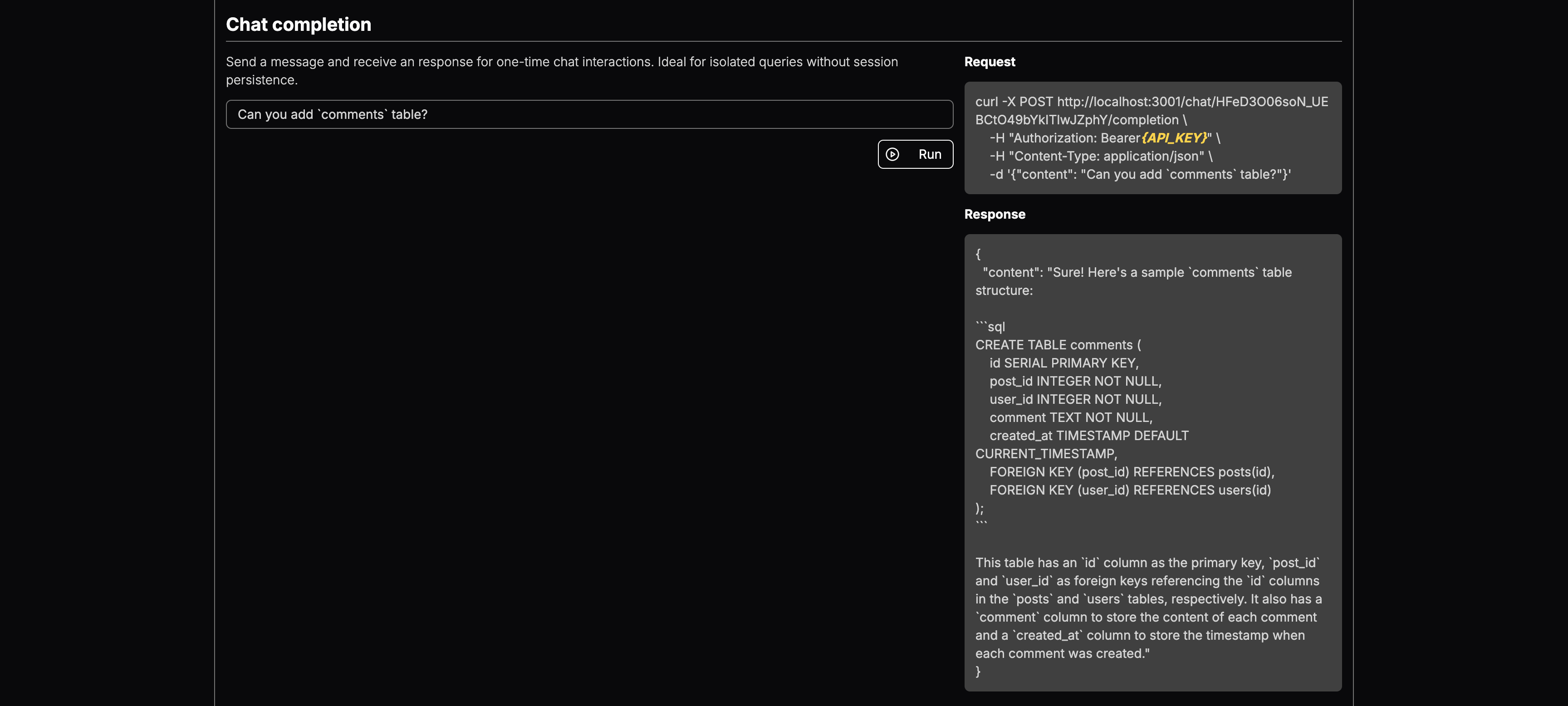

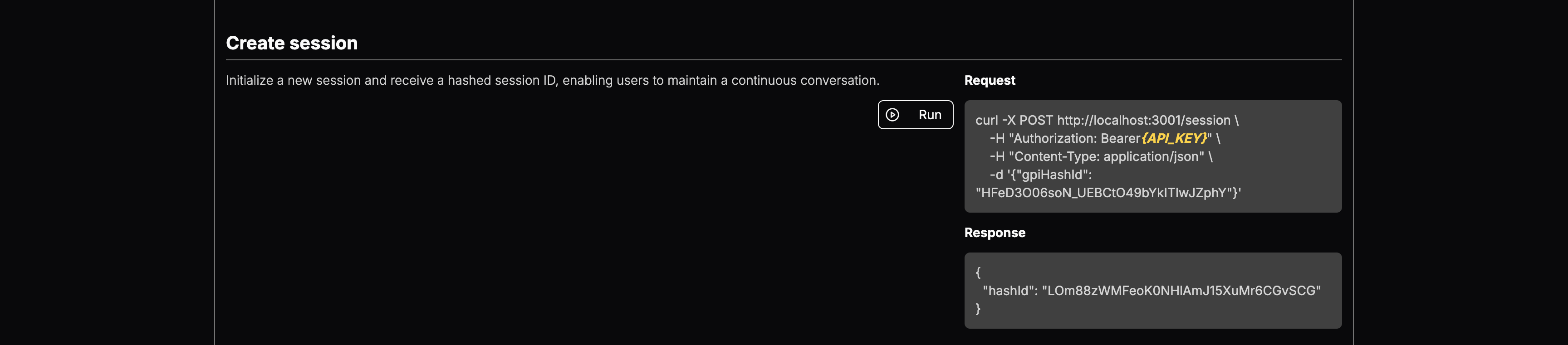

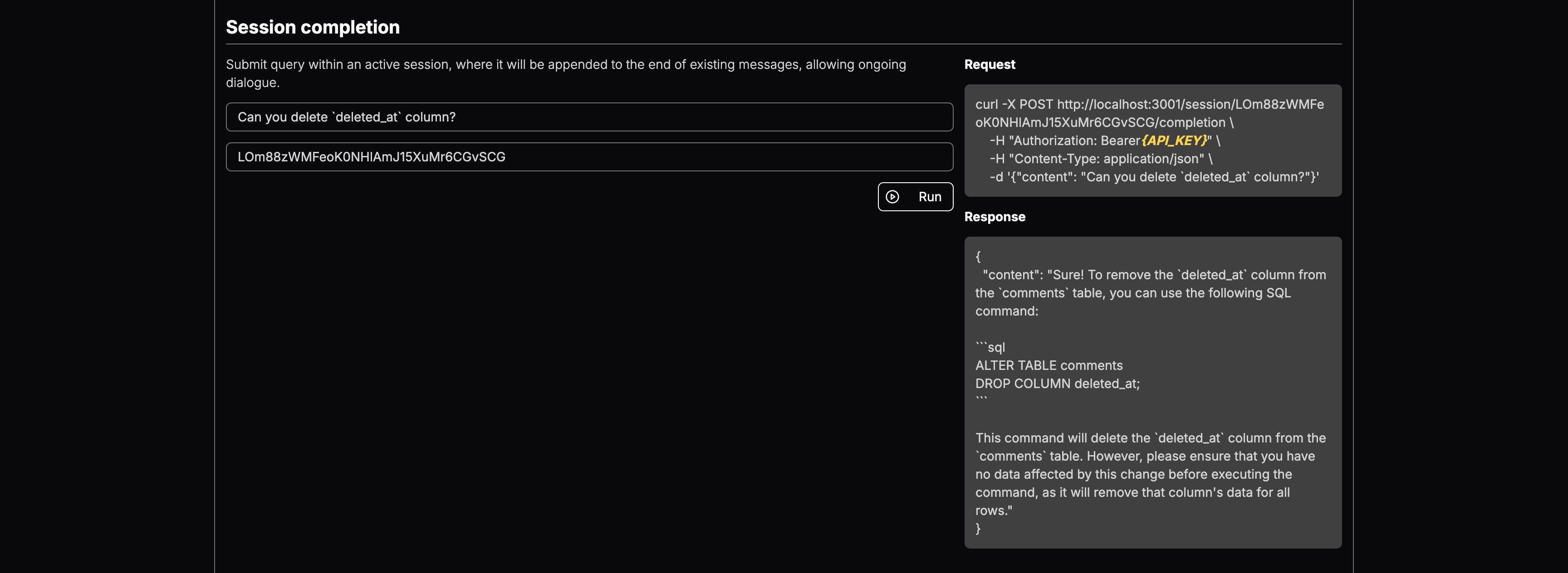

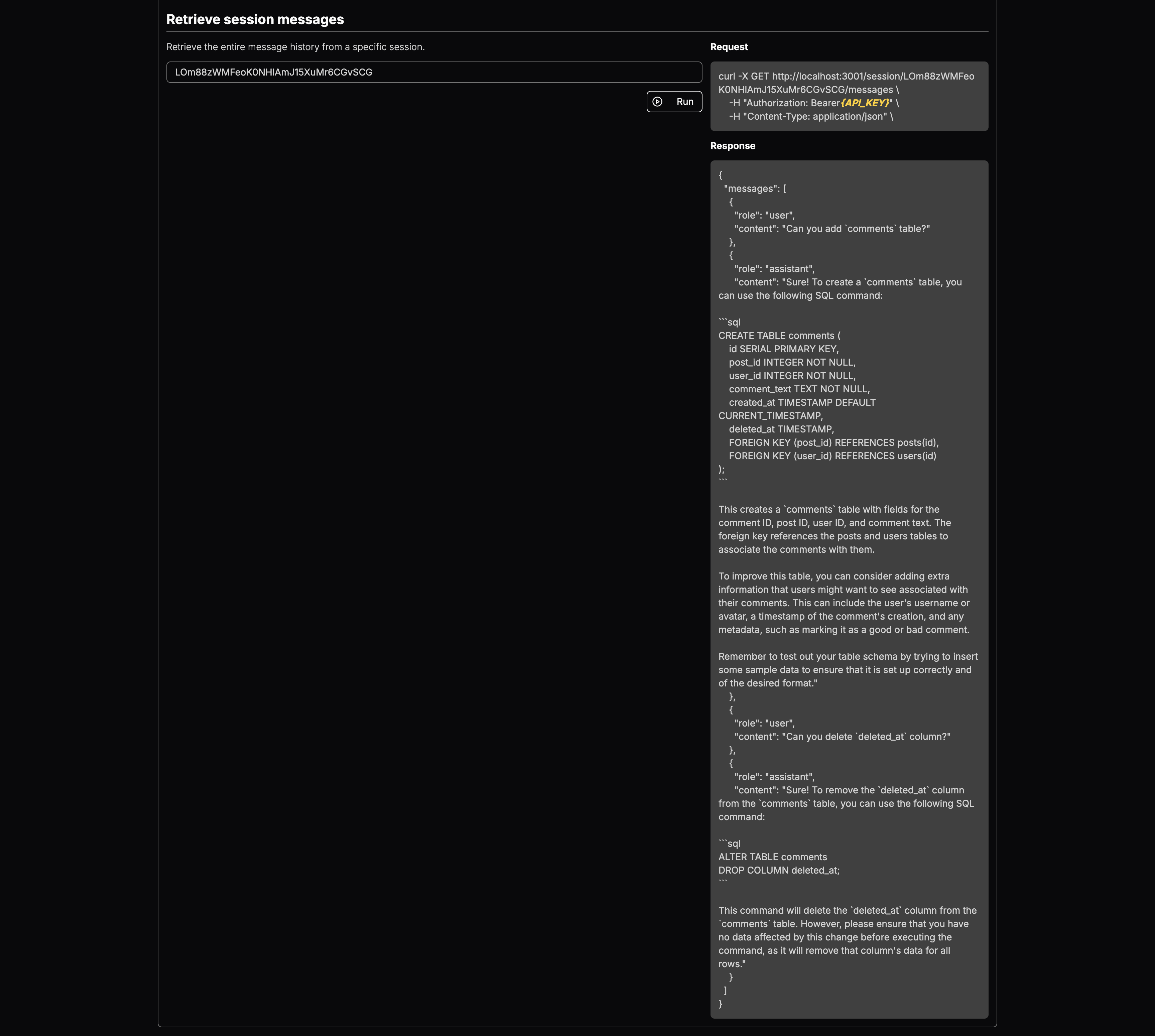

Aqui estão alguns exemplos específicos do que gpinterface pode fazer:

Você pode selecionar o modelo LLM e adicionar contexto. Uma vez implantado, você receberá pontos de extremidade para:

É uma ferramenta poderosa projetada para otimizar o teste e a implantação de avisos generativos em vários modelos de idiomas grandes (LLMS). Com uma interface da web fácil de usar, gpinterface permite configuração e experimentação rápidas.

Atualmente, gpinterface suporta uma variedade de grandes modelos de idiomas, incluindo:

Esse suporte diversificado permite escolher o melhor modelo para suas necessidades e requisitos específicos.

Não vê seu modelo favorito? Sinta -se à vontade para abrir PR ou entre em contato comigo!

O aplicativo requer um banco de dados PostGresql. Inicie o banco de dados usando o Docker:

cd backend

docker-compose up -dO back -end utiliza o Prisma para gerenciar o esquema e as migrações do banco de dados. Execute os seguintes comandos na inicialização do banco de dados:

npm run prisma:migratePara semear o banco de dados com dados iniciais para cada modelo de idioma grande suportado, execute os seguintes comandos:

npx ts-node prisma/seedBack -end

O back -end exige que as seguintes variáveis de ambiente sejam definidas:

CLIENT_URL= " http://localhost:3003 "

DATABASE_URL= " postgresql://postgres:[email protected]:5432/postgres " # can be replaced with your DB endpoint

AI21_API_KEY= " YOUR_AI21_API_KEY "

ANTHROPIC_API_KEY= " YOUR_ANTHROPIC_API_KEY "

COHERE_API_KEY= " YOUR_COHERE_API_KEY "

GOOGLE_API_KEY= " YOUR_GOOGLE_API_KEY "

MISTRAL_API_KEY= " YOUR_MISTRAL_API_KEY "

OPENAI_API_KEY= " YOUR_OPENAI_API_KEY "

AWS_ACCESS_KEY_ID= " AWS_ACCESS_KEY " # you need Llama model access in AWS Bedrock

AWS_SECRET_ACCESS_KEY= " AWS_SECRET_KEY " # you need Llama model access in AWS Bedrock

JWT_SECRET= " SECURE_RANDOM_STRING "

COOKIE_SECRET= " SECURE_RANDOM_STRING "

NODE_ENV= " development " # for development logging Verifique se essas variáveis estão definidas em um arquivo .env no diretório de back -end antes de iniciar o aplicativo.

front-end

O aplicativo front -end requer as seguintes variáveis de ambiente:

NEXT_PUBLIC_API_ENDPOINT= " http://localhost:3000 "

NEXT_PUBLIC_CHAT_ENDPOINT= " http://localhost:3001 "

NEXT_PUBLIC_HOSTNAME= " http://localhost:3003 "

NEXT_PUBLIC_GOOGLE_OAUTH_CLIENT_KEY= " "Eles devem ser configurados para corresponder aos pontos de extremidade em que os serviços de back -end estão disponíveis, garantindo que o front -end possa se comunicar com o back -end corretamente.

Para executar os componentes do aplicativo separadamente para fins de desenvolvimento:

Execute back -end

cd backend && npm run devExecute o front -end

cd frontend && npm run devPara construir todos os componentes para implantação de produção, siga estas etapas sequencialmente

cd shared

npm run build

cd ../backend

npm run build

cd ../frontend

npm run buildPara iniciar o servidor

Execute back -end

cd backend && npm run startExecute o servidor de bate -papo (servidor de API)

cd backend && npm run start:chatExecute o front -end

cd frontend && npm run start