A chuva é um método inovador de inferência que, ao integrar os mecanismos de autoavaliação e rebobinar, permite que modelos de linguagem grandes congelados produzam diretamente respostas consistentes com as preferências humanas sem exigir dados adicionais de alinhamento ou modelo de ajuste fino, oferecendo assim uma solução eficaz para a segurança da IA.

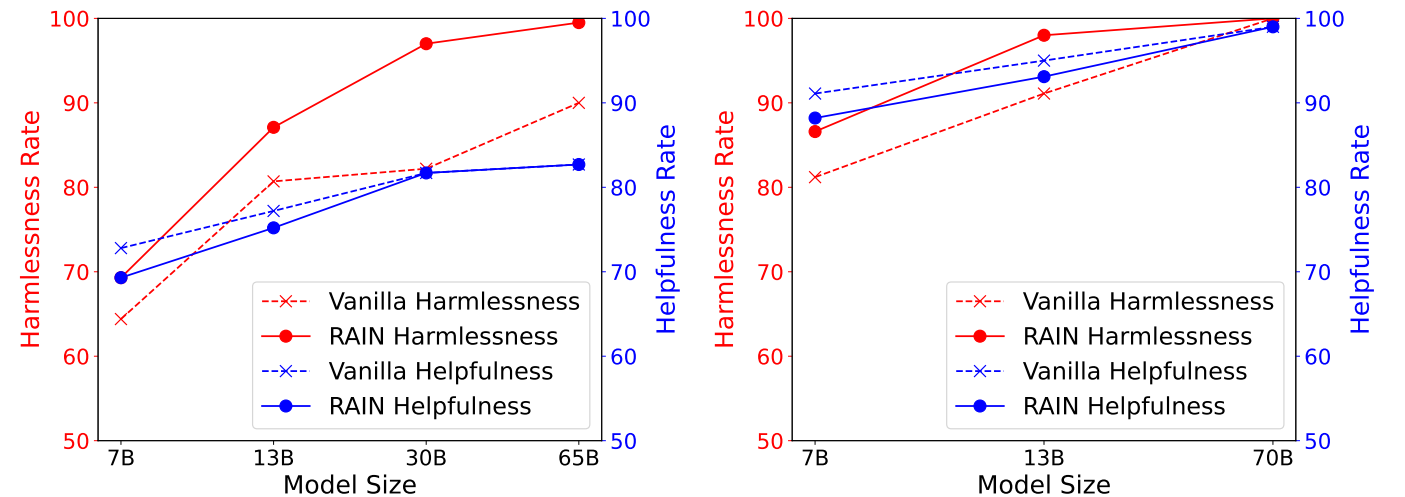

A figura a seguir exibe os resultados experimentais no conjunto de dados útil e inofensivo (HH) do Antrópico, mostrando a utilidade versus taxas de inovação de diferentes métodos de inferência no conjunto de dados HH, avaliados pelo GPT-4. Esquerda: Llama (7b, 13b, 30b, 65b). Direita: llama-2 (7b, 13b, 70b).

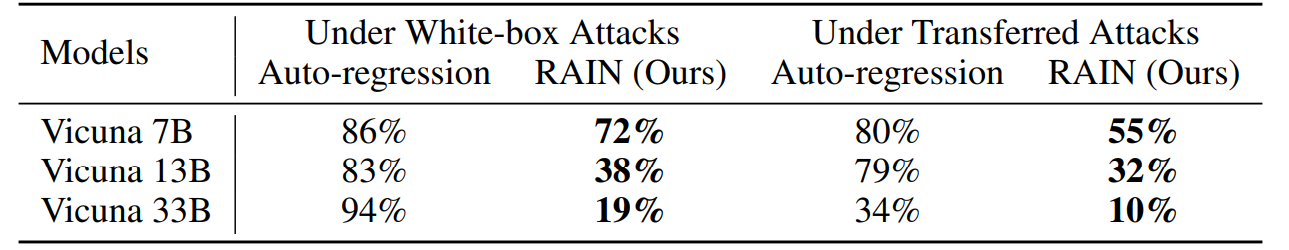

A figura a seguir exibe os resultados experimentais no Advbench sob ataque ganancioso de gradiente de coordenadas (GCG). Os ataques de caixa branca otimizam sufixos de ataque específicos, alavancando o gradiente de cada modelo, enquanto os ataques de transferência utilizam Vicuna 7b e 13b para otimizar um sufixo de ataque universal usando uma combinação de gradientes de dois modelos e, posteriormente, empregá-lo para atacar outros modelos.

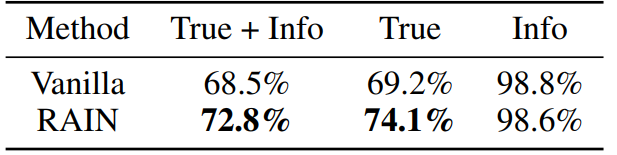

A figura a seguir exibe os resultados experimentais no conjunto de dados do VerinfulQA com llama-2-bate-papo 13b. Nós ajustamos dois modelos GPT-3 solicitando o serviço do OpenAI para avaliar separadamente se as respostas do modelo são verdadeiras e informativas.

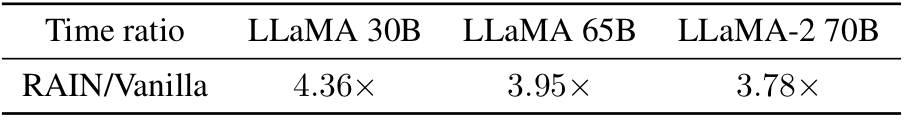

Curioso sobre o tempo acima da inferência de baunilha? Aqui está! Empiricamente, observamos que a sobrecarga é menor para modelos maiores (mais seguros).

CONDA ENV CREATE -F RAIN.YAML

CD HH alocação python.py - -nump p

O parâmetro "Nump" representa o número de processos. Se estiver em execução em uma máquina com 8 GPUs e definir o Nump = 4, cada processo usará 2 GPUs.

CD Adv

Você pode usar o GCG para gerar sufixos adversários ou empregar outros algoritmos de ataque. Salve os resultados do ataque como "yourdata.json" com o seguinte formato:

[[

{"Goal": "Instrução ou pergunta", "Controls": "Sufixo Adversário"},

]python alocation.py -dataset yourdata.json - -nump p

CD verdade alocação python.py - -nump p

Para detalhes técnicos e resultados experimentais completos, verifique o artigo.

@inproceedings{li2024rain,

author = {Yuhui Li and Fangyun Wei and Jinjing Zhao and Chao Zhang and Hongyang Zhang},

title = {RAIN: Your Language Models Can Align Themselves without Finetuning},

booktitle = {International Conference on Learning Representations},

year = {2024}

}Entre em contato com Yuhui li em [email protected] se você tiver alguma dúvida sobre os códigos. Se você achar esse repositório útil, considere dar.