ebsynth_utility

Visão geral

Automatic1111 Extensão da interface do usuário para criar vídeos usando img2img e ebsynth.

Esta extensão permite que você produz vídeos editados usando o ebsynth. (Ae não é necessário)

Com o ControlNet instalado, confirmei que todos os recursos desta extensão estão funcionando corretamente!

O ControlNet é obrigatório para a edição de vídeo, por isso recomendo instalá -lo.

O Multi ControlNet ("Canny" + "Normal Mapa") seria adequado para edição de vídeo.

Modifiquei o Animatediff-cli para criar uma ferramenta TXT2Video que permite especificações rápidas flexíveis. Você pode usá -lo se quiser.

Animatediff-cli-PROMPT-TRAVEL

Sample2.mp4

Exemplo

- A amostra a seguir é a saída bruta desta extensão.

amostra 1 máscara com clipseg

- primeiro da esquerda: original

- Segundo da esquerda: mascarar "gato" exclua "dedo"

- Terceiro da esquerda: mascarando a "cabeça de gato"

- Direita: cor corrigida com o colorido de cores (consulte o estágio 3.5)

- Vários alvos também podem ser especificados. (Por exemplo, gato, cachorro, menino, menina)

sample_clipseg_and_colormacher.mp4

Amostra 2 Borden Background

- Pessoa: obra -prima, melhor qualidade, obra -prima, 1Girl, obra -prima, melhor qualidade, screencap de anime, estilo de anime

- Antecedentes: Cyberpunk, fábrica, quarto, screencap de anime, estilo de anime

- Também é possível misturar com seus vídeos favoritos.

Sample6.mp4

amostra 3 marcação automática

- Esquerda: original

- Centro: aplique os mesmos instruções em todos os quadros -chave

- Direita: Aplique a marcação automática de DeepDanbooru em todos os quadros -chave

- Esta função melhora as mudanças detalhadas nas expressões faciais, expressões manuais, etc.

No vídeo de amostra, as tags "fechado_eyes" e "hands_on_own_face" foram adicionadas para representar melhor os olhos e as mãos trazidas na frente do rosto.

sample_autotag.mp4

Amostra 4 etiqueta automática (aplique Lora dinamicamente)

- Esquerda: Aplique marcação automática de DeepDanbooru em todos os quadros -chave

- Direita: Aplique a etiqueta automática por DeepDanbooru em todos os quadros -chave + Aplique "Anyahehface" Lora dinamicamente

- Adicionado a função para aplicar dinamicamente Ti, Hypernet, Lora e prompts adicionais de acordo com tags conectadas automaticamente.

No vídeo de amostra, se a tag "Smile" for dada, as palavras -chave Lora e Lora Trigger serão definidas para serem adicionadas de acordo com a força da tag "Smile".

Além disso, como as tags adicionadas automaticamente são às vezes incorretas, as tags desnecessárias são listadas na lista negra.

Aqui está o arquivo de configuração real usado. colocado no "Diretório do Projeto" para uso.

Amostra.ANYAHEH.MP4

Instalação

- Instale o FFMPEG para o seu sistema operacional (https://www.geeksforgeeks.org/how-tonstall-ffmpeg-on-windows/)

- Instale o ebsynth

- Use a guia Extensões do Webui para [instalar a partir do URL]

Uso

- Vá para a guia [Ebsynth Utility].

- Crie um diretório vazio em algum lugar e preencha o campo "Diretório do projeto".

- Coloque o vídeo que você deseja editar de algum lugar e preencha o campo "Caminho do filme original". Use vídeos curtos de alguns segundos no início.

- Selecione o estágio 1 e gerar.

- Execute em ordem do estágio 1 a 7. O progresso durante o processo não se reflete no webui; portanto, verifique a tela do console. Se você vir "concluído". Em Webui, está concluído.

(No webui mais recente atual, parece causar um erro se você não soltar a imagem na tela principal do IMG2IMG.

Por favor, solte a imagem, pois ela não afeta o resultado.)

Nota 1

Para referência, aqui está o que eu fiz quando editei um vídeo 1280x720 30fps 15seg com base em

Estágio 1

Não há nada para configurar.

Todos os quadros das imagens de vídeo e máscara para todos os quadros são gerados.

Estágio 2

Na implementação desta extensão, o intervalo de quadro -chave é escolhido para ser mais curto, onde há muito movimento e mais tempo onde há pouco movimento.

Se a animação terminar, aumente o quadro -chave, se ele pisca, diminua o quadro -chave.

Primeiro, gerar uma vez com as configurações padrão e vá em frente sem se preocupar com o resultado.

Estágio 3

Selecione um dos quadros -chave, jogue -o para img2img e execute [interrogar Deepbooru].

Exclua palavras indesejadas, como o Blur do prompt exibido.

Preencha o restante das configurações, como você normalmente faria para a geração de imagens.

Aqui estão as configurações que usei.

- Método de amostragem: Euler A

- Etapas de amostragem: 50

- Largura: 960

- Altura: 512

- Escala CFG: 20

- Força de denoising: 0.2

Aqui estão as configurações para extensão.

- Modo de máscara (Substituir o modo de máscara img2img): Normal

- IMG2IMG REPET CONTA (LOOP VOLTA): 5

- Adicione n à semente ao repetir: 1

- Use Crop Face IMG2IMG: Verdadeiro

- Método de detecção de rosto: yunet

- Tamanho máximo da colheita: 1024

- Força de denoising Face: 0,25

- Ampliação da área do rosto: 1.5 (quanto maior o número, mais próximo do estilo de pintura do modelo, mas maior a probabilidade de mudar quando se fundir com o corpo.)

- Ativar Pump Face: False

Trial e erro nesse processo é a parte mais demorada.

Monitore a pasta de destino e se você não gosta de resultados, interrompa e altere as configurações.

[Prompt] [Força denoising] e as configurações de força de denoising] ao usar o img2Img da colheita de face afetarão bastante o resultado.

Para mais informações sobre o FACE CROP IMG2IMG, verifique aqui

Se você tiver muita memória de sobra, aumentar os valores de largura e altura, mantendo a proporção, pode melhorar bastante os resultados.

Esta extensão pode ajudar com o ajuste.

https://github.com/s9roll7/img2img_for_all_method

As informações acima são de uma época em que não havia controle.

Quando o ControlNet é usado em conjunto (especialmente multi-controlnets), mesmo a definição de "força de denoising" em um valor alto funciona bem, e até defini-lo como 1.0 produz resultados significativos.

Se a "força de denoising" estiver definida como um valor alto, "loop back" puder ser definido como 1.

Estágio 4

Escala -o para cima ou para baixo e processe exatamente o mesmo tamanho que o vídeo original.

Esse processo deve precisar ser feito apenas uma vez.

- Largura: 1280

- Altura: 720

- Upscaler 1: R-Esrgan 4x+

- Upscaler 2: R-Esrgan 4x+ Anime6b

- Upscaler 2 Visibilidade: 0,5

- GFPGAN Visibilidade: 1

- Código Visibilidade: 0

- Peso do Formador de Código: 0

Estágio 5

Não há nada para configurar.

O arquivo .ebs será gerado.

Estágio 6

Execute o arquivo .ebs.

Eu não alteraria as configurações, mas você poderia ajustar as configurações .ebs.

Estágio 7

Finalmente, produza o vídeo.

No meu caso, todo o processo de 1 a 7 levou cerca de 30 minutos.

- Taxa de mistura Crossfade: 1.0

- Tipo de exportação: MP4

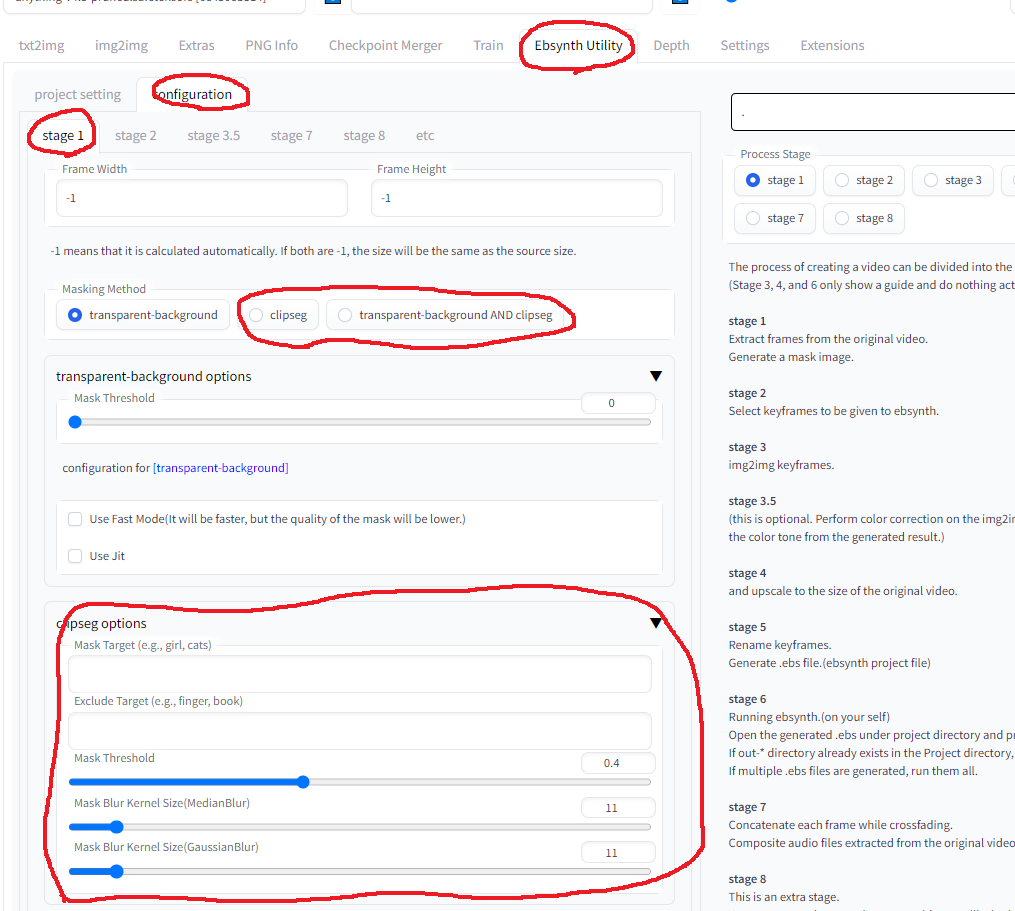

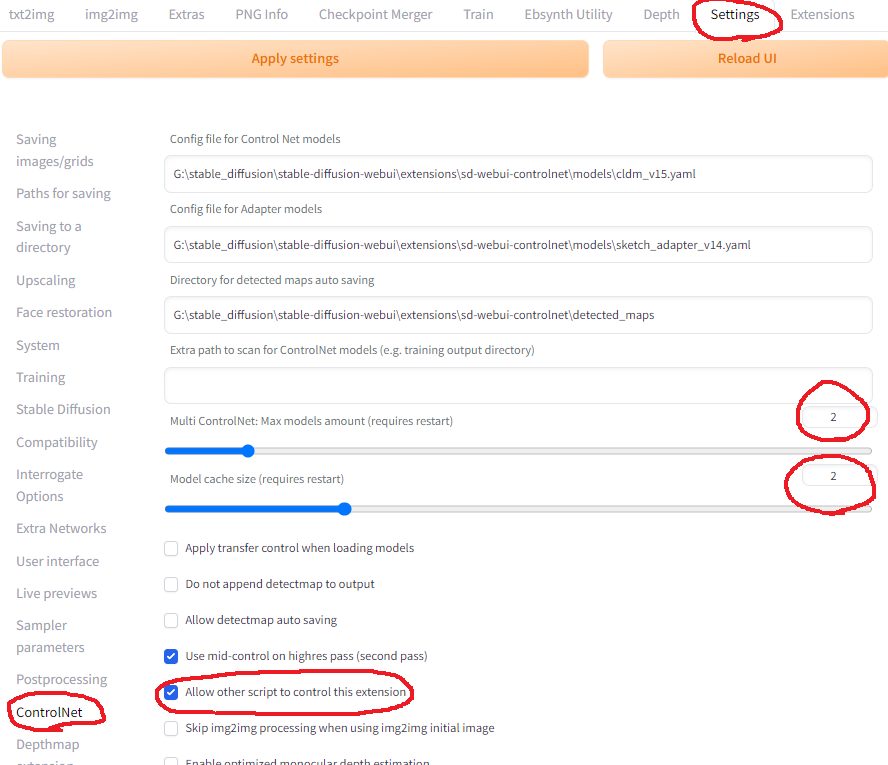

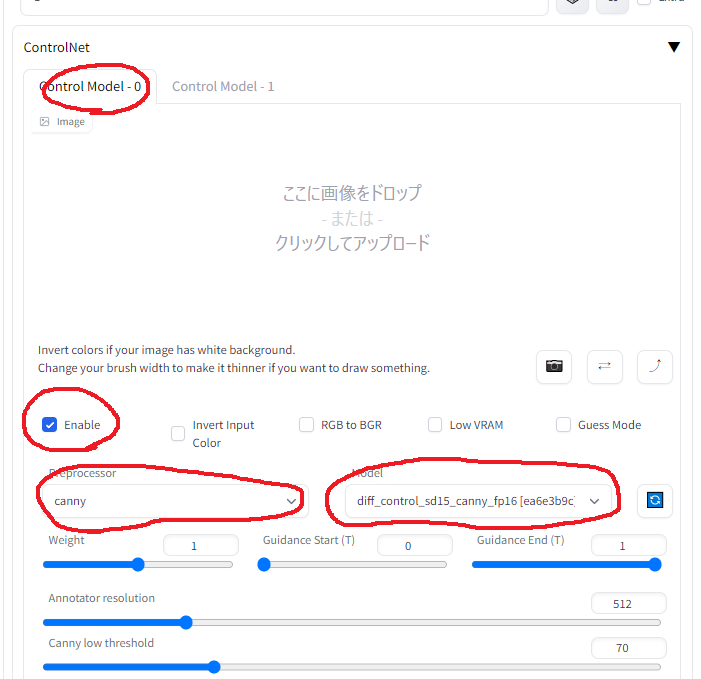

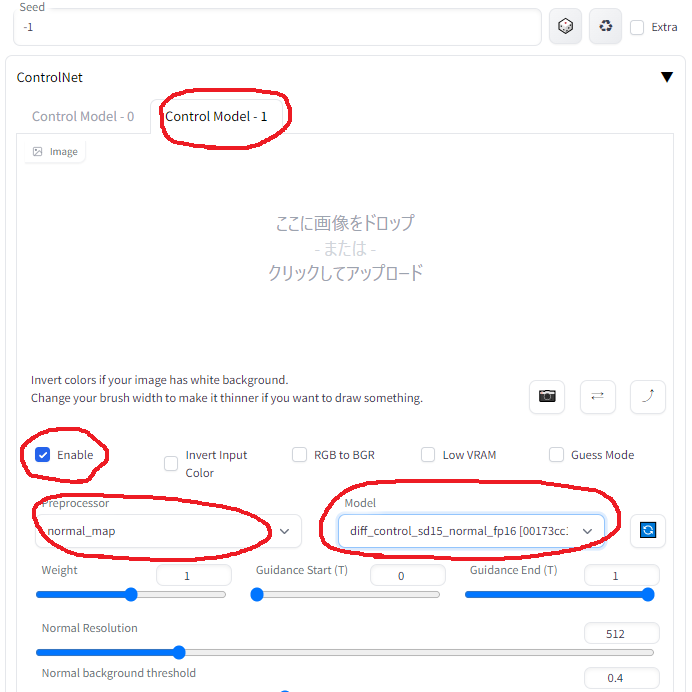

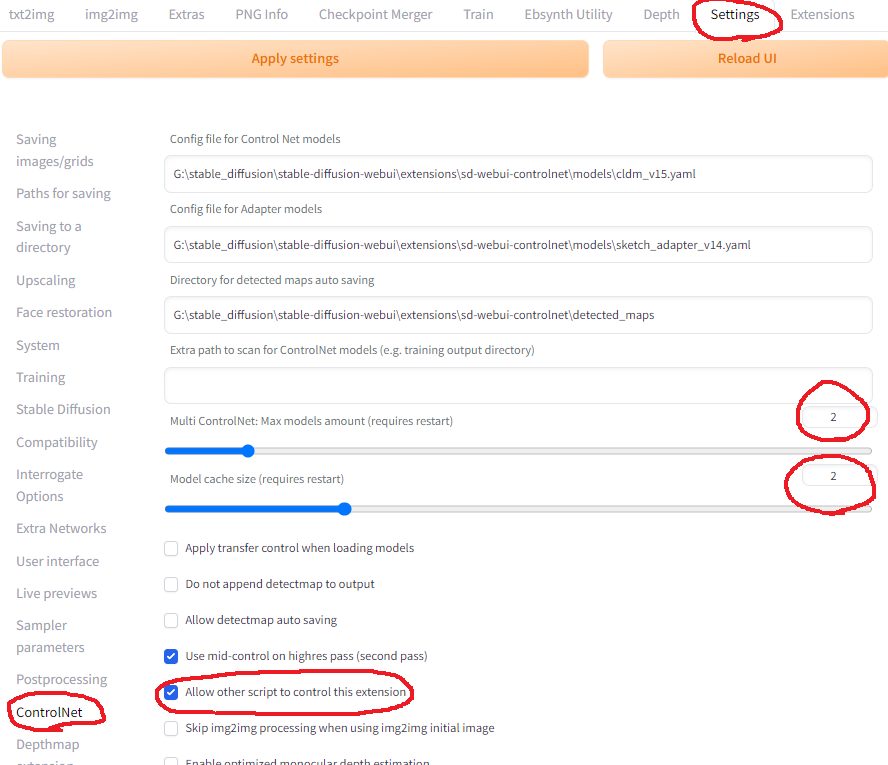

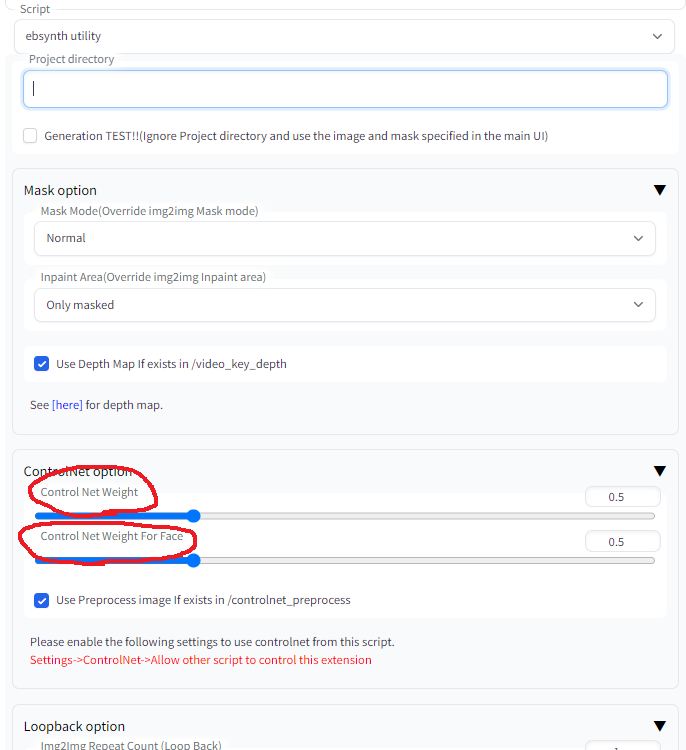

Nota 2: Como usar o Multi-Controlnet

na configuração da webui

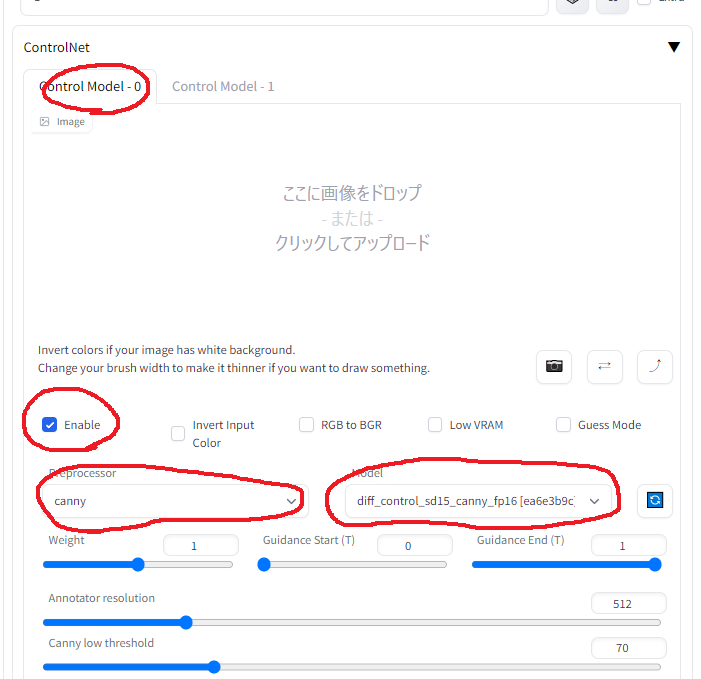

Nas configurações do ControlNet na guia IMG2IMG (para ControlNet 0)

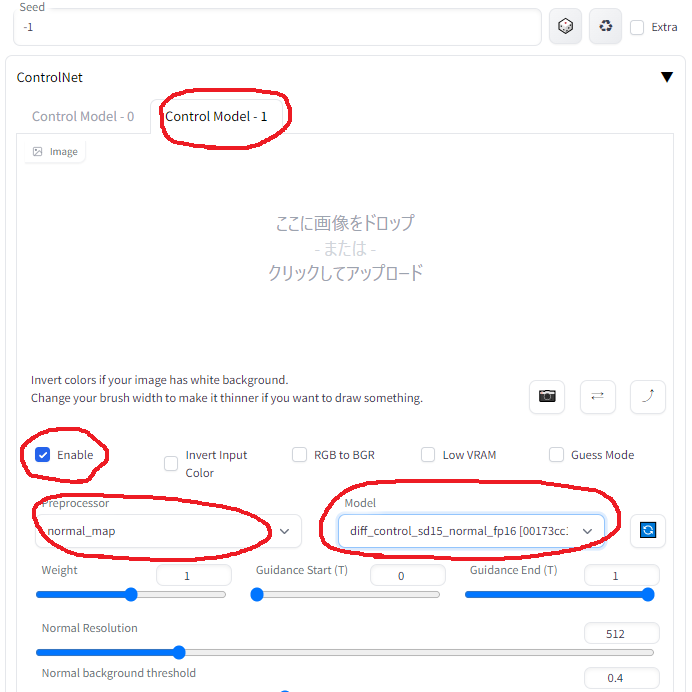

Nas configurações do ControlNet na guia IMG2IMG (para Controlnet 1)

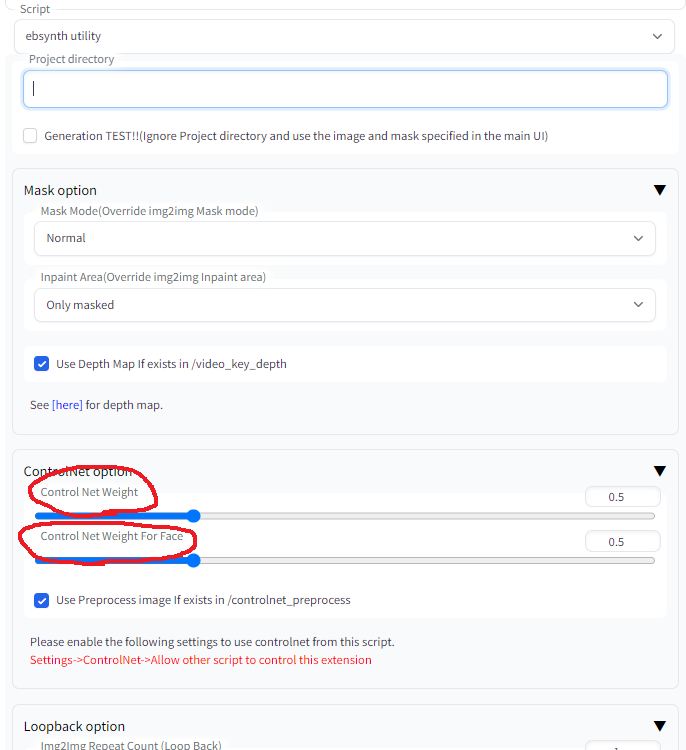

Em configurações de ebsynth_utility na guia img2img

Aviso: "Peso" nas configurações do Controlnet é substituído pelos seguintes valores

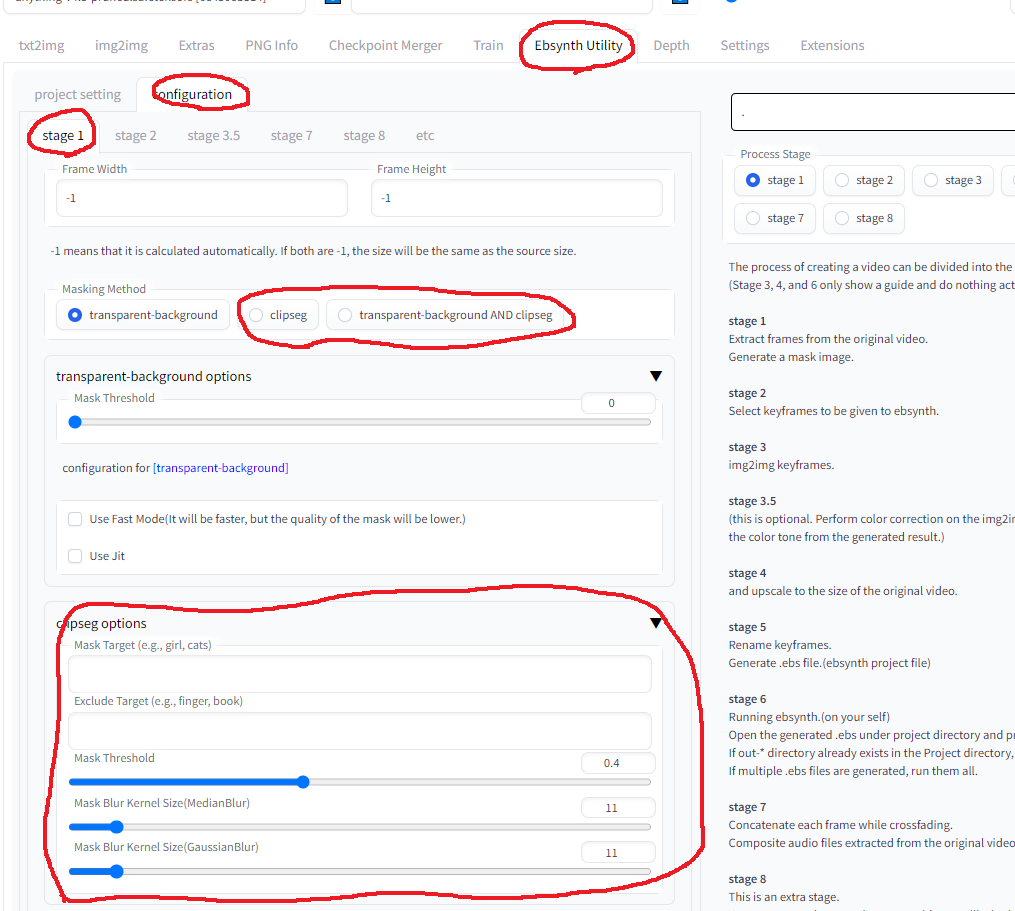

Nota 3: Como usar o clipseg