Esta é uma lista com curadoria de artigos "Modelo de idioma como serviço (LMAAs)", que é mantido principalmente por Tianxiang Sun. Incentivamos fortemente os pesquisadores da PNL que estão interessados neste tópico para fazer solicitação de puxar para adicionar ou atualizar os trabalhos (consulte contribuindo). Assista a este repositório para obter as atualizações mais recentes!

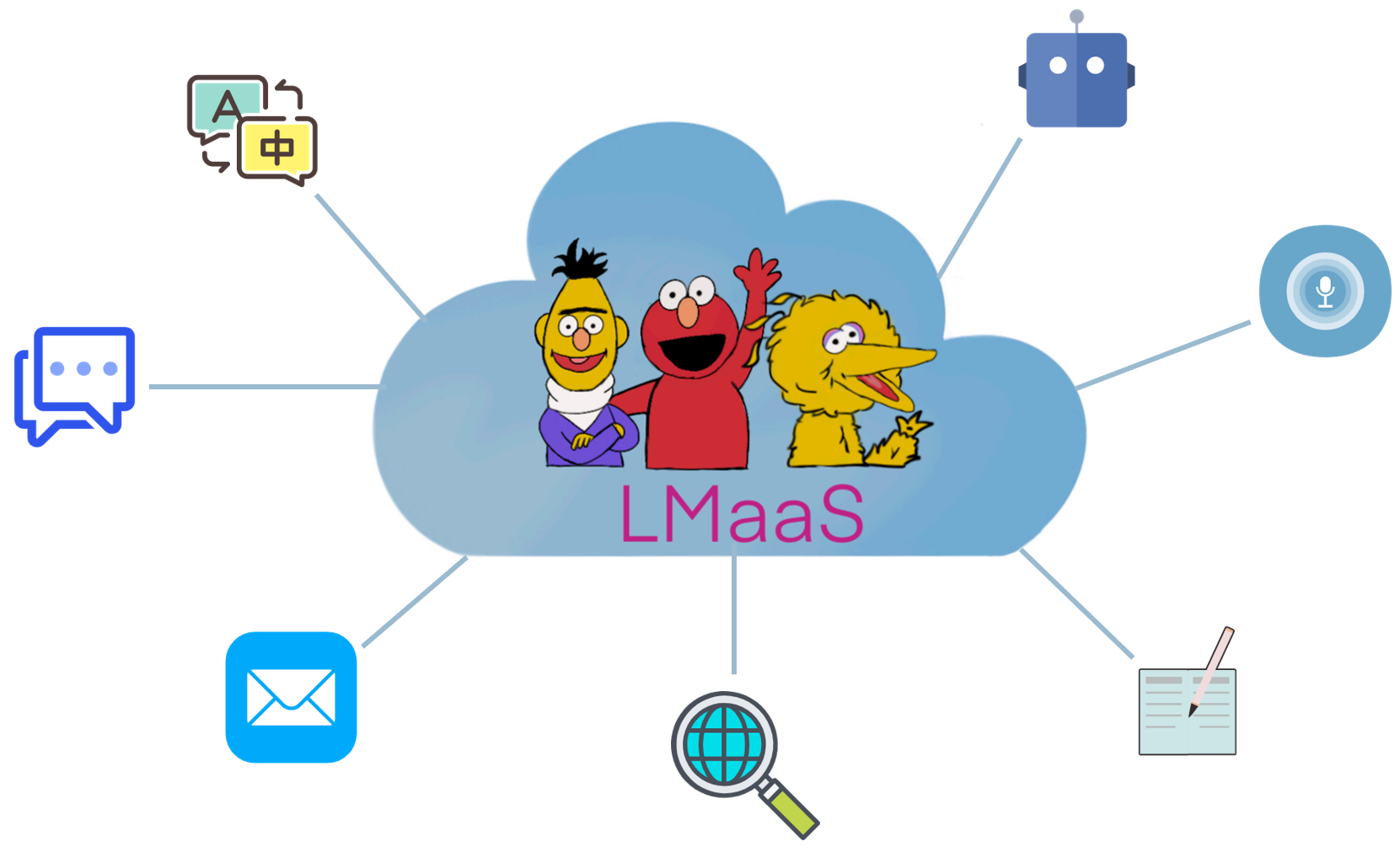

Devido a razões comerciais e custo de ajuste caro, os modelos de grandes idiomas pré-treinados (LLMs), como o GPT-3, geralmente são liberados como um serviço em vez de pesos do modelo de fornecimento aberto. Chamamos esse cenário de " Modelo de idioma como serviço (LMAAs) " (o termo é originalmente usado em nosso papel ICML'2022). Nesse cenário, os usuários podem acessar os poderosos LLMs por meio de suas APIs de inferência. O serviço do LLMS alimentou muitos casos de uso (consulte a demonstração do GPT-3). Em contraste com o ajuste fino, os LMAAs permitem que um único LLM de uso geral sirva muitas tarefas de diferença e, portanto, é altamente eficiente em termos de implantação. No entanto, como adaptar o LLMS para segmentar tarefas sem acesso a seus parâmetros e gradientes é um desafio. Para fazer com que os LLMs beneficiem um público mais amplo, coletamos trabalhos que se encaixam nesse cenário para facilitar pesquisas futuras.

Quais papéis se encaixam no cenário de LMAAs? Consideramos principalmente artigos que adaptam LLMs às tarefas a jusante sem acessar os parâmetros do modelo e os gradientes. Embora os LLMs de ajuste fino também possam ser serviços após a implantação, eles estão limitados a resolver uma única tarefa para o público limitado. Em nosso escopo, preferimos servir modelos de uso geral para uma variedade de usuários.

Na literatura existente, existem várias linhas de pesquisa que se encaixam nos LMAAs:

O limite entre o prompt de texto e o aprendizado no contexto é um pouco embaçado. Neste repositório, a categoria de prompt de texto contém trabalhos que não usam amostras marcadas, enquanto a categoria de aprendizado no contexto é composta por trabalhos que incluem amostras marcadas nos avisos.

NOTA: Um tópico relacionado (e parcialmente sobreposto) é o aprendizado rápido , que visa resolver tarefas a jusante usando LLMs de propósito geral, convertendo entrada e saída com algum modelo e verbalizador, respectivamente. No entanto, a maioria dos trabalhos em aprendizado imediato exige o acesso aos parâmetros e gradientes do modelo e, portanto, não se encaixa em nosso escopo. Para documentos de aprendizagem rápidos que não são adequados para os LMAAs, recomendamos contribuir para outra lista de papel impressionante: Prompt Paper.

Comparado com os LLMs específicos de tarefas de ajuste fino, os LMAAs têm as seguintes vantagens:

A abreviação do trabalho.

A principal característica do trabalho.

A principal configuração experimental do trabalho.

Modelos de idiomas como bases de conhecimento? EMNLP 2019

Fabio Petroni, Tim Rocktäschel, Patrick Lewis, Anton Bakhtin, Yuxiang Wu, Alexander H. Miller, Sebastian Riedel . [PDF] [Código]

Como podemos saber quais modelos de idiomas sabem? TACL 2020

Zhengbao Jiang, Frank F. Xu, Jun Araki, Graham Neubig . [PDF] [Código]

Modelos de idiomas são poucos alunos. Neurips 2020

Tom B. Brown, Benjamin Mann, Nick Ryder, Melanie Subbiah, Jared Kaplan, Prafulla Dhariwal, Arvind Neelakantan, Pranav Shyam, Sastry Girish, Amanda Askell, Sandhini Agarwal, Ariel Herbert-Voss, Gretchen Krueger, Sandhini Agarwal, Ariel Herbert-Voss, Gretchen Krueger, Sandhini Agarwal, Ariel Herbert-Voss, Gretchen Krueger, Ramesh, Daniel M. Ziegler, Jeffrey Wu, Clemens Winter, Christopher Hesse, Mark Chen, Eric Sigler, Mateusz Litwin, Scott Gray, Benjamin Chess, Jack Clark, Christopher Berner, Sam McCandlish, Alec Radford, Ilya Sutskever, Dario Amodei . [PDF]

Adaptação de modelos de linguagem para aprendizado de tiro zero por meta-ajuste no conjunto de dados e coleções rápidas . Resultados do EMNLP 2021

Ruiqi Zhong, Kristy Lee, Zheng Zhang, Dan Klein . [PDF] [Código]

Os modelos de idiomas FinetUned são alunos de tiro zero . ICLR 2022

Jason Wei, Maarten Bosma, Vincent Y. Zhao, Kelvin Guu, Adams Wei Yu, Brian Lester, Nan Du, Andrew M. Dai, Quoc V. Le . [PDF] [Código]

O treinamento solicitado por várias tarefas permite a generalização da tarefa zero . ICLR 2022

Victor Sanh, Albert Webson, Colin Raffel, Stephen H. Bach, Lintang Sutawika, Zaid Alyafeai, Antoine Chaffin, Arnaud Stiegler, Teven Le Scao, Arun Raja, Manan Dey, M Saiful Bari, Canwen Xu, Urmish Thakker, Shanya Sharma Sharma, Eliza Szczechla, Taewoon Gunjan Chhablani, Nihal Nayak, DeBajyoti Datta, Jonathan Chang, Mike Tian-Jian Jiang, Han Wang, Matteo Manica, Sheng Shen, Zheng Xin Yong, Harshit Pandey, Rachel Bawden, Thomas Wang, Trishala Neer, Nera, Harshit Pandey, Rachel Bawden, Thomas Wang, Trishala Neer, Nera, Harshit Pandey, Rachel Bawden, Thomas Wang, Trishala , Andrea Santilli, Thibault Fevry, Jason Alan Fries, Ryan Teehan, Tali Bers, Stella Biderman, Leo Gao, Thomas Wolf, Alexander M. Rush . [PDF] [Código]

Treinando modelos de idiomas para seguir as instruções com feedback humano . Pré -impressão 2022.3

Long Ouyang, Jeff Wu, Xu Jiang, Diogo Almeida, Carroll L. Wainwright, Pamela Mishkin, Chong Zhang, Sandhini Agarwal, Katarina Slama, Alex Ray, John Schulman, Jacob Hilton, Fraser Kelton, Luke Miller, Maddie Simens, Amanda Askell, Peter Welinder, Paul Christiano, Jan Like, Ryan Lowe . [PDF] [Código]

Modelos de idiomas grandes são motivos de tiro zero . Preprint 2022.6

Takeshi Kojima, Shixiang Shane Gu, Machel Reid, Yutaka Matsuo, Yusuke Iwasawa . [PDF] [Código]

Resposta de perguntas em vídeo com tiro zero por meio de modelos de idiomas bidirecionais congelados . Preprint 2022.6

Antoine Yang, Antoine Miech, Josef Sivic, Ivan Laptev, Cordelia Schmid . [PDF] [Código]

Os modelos de idiomas são interfaces de uso geral . Preprint 2022.6

Yaru Hao, Haoyu Song, Li Dong, Shaohan Huang, Zewen Chi, Wenhui Wang, Shuming MA, Furu Wei . [PDF] [Código]

Geração imediata no nível do repositório para grandes modelos de código de código. Preprint 2022.6

Disha Shrivastava, Hugo Larochelle, Daniel Tarlow [PDF] [Código], 2022.6

Ignore o prompt anterior: técnicas de ataque para modelos de idiomas. Best Paper Award @ Neurips ML Safety Workshop 2022.

Fábio Perez, Ian Ribeiro [PDF] [Project], 2022.11

Modelos de idiomas são poucos alunos. Neurips 2020

Tom B. Brown, Benjamin Mann, Nick Ryder, Melanie Subbiah, Jared Kaplan, Prafulla Dhariwal, Arvind Neelakantan, Pranav Shyam, Sastry Girish, Amanda Askell, Sandhini Agarwal, Ariel Herbert-Voss, Gretchen Krueger, Sandhini Agarwal, Ariel Herbert-Voss, Gretchen Krueger, Sandhini Agarwal, Ariel Herbert-Voss, Gretchen Krueger, Ramesh, Daniel M. Ziegler, Jeffrey Wu, Clemens Winter, Christopher Hesse, Mark Chen, Eric Sigler, Mateusz Litwin, Scott Gray, Benjamin Chess, Jack Clark, Christopher Berner, Sam McCandlish, Alec Radford, Ilya Sutskever, Dario Amodei . [PDF]

Calibre antes do uso: Melhorando o desempenho de poucos modelos de idiomas . ICML 2021

Tony Z. Zhao, Eric Wallace, Shi Feng, Dan Klein, Sameer Singh . [PDF] [Código]

Uma explicação do aprendizado no contexto como inferência bayesiana implícita . ICLR 2022

Sang Michael Xie, Aditi Raghunathan, Percy Liang, Tengyu MA . [PDF] [Código]

A cadeia de pensamento provocando provas o raciocínio em grandes modelos de idiomas . Pré -impressão 2022.1

Jason Wei, Xuezhi Wang, Dale Schuurmans, Maarten Bosma, Brian Ichter, Fei Xia, Ed Chi, Quoc Le, Denny Zhou . [PDF]

Generalização cruzada através de instruções de crowdsourcing de idiomas naturais . ACL 2022

Swaroop Mishra, Daniel Khashabi, Chitta Baral, Hannaneh Hajishirzi . [PDF] [Código]

Prompts de ordens fantástica e onde encontrá-las: superando a sensibilidade à ordem pronta de poucas fotos . ACL 2022

Yao Lu, Max Bartolo, Alastair Moore, Sebastian Riede, Pontus Stenenetorp . [PDF]

Modelo de linguagem de canal barulhento solicitando a classificação de texto com poucas fotos . ACL 2022

Sewon Min, Mike Lewis, Hannaneh Hajishirzi, Luke Zettlemoyer . [PDF] [Código]

Meta-aprendizagem via modelo de idioma no ajuste no contexto . ACL 2022

Yanda Chen, Ruiqi Zhong, Sheng Zha, George Karypis, ele . [PDF] [Código]

O que faz bons exemplos de contexto para o GPT-3? Deelio@ACL 2022

Jiachang Liu, Dinghan Shen, Yizhe Zhang, Bill Dolan, Lawrence Carin, Weizhu Chen . [PDF]

Aprendendo a recuperar instruções para o aprendizado no contexto . NAACL 2022

Ohad Rubin, Jonathan Herzig, Jonathan Berant . [PDF] [Código]

METAICL: Aprendendo a aprender no contexto . NAACL 2022

Sewon Min, Mike Lewis, Luke Zettlemoyer, Hannaneh Hajishirzi . [PDF] [Código]

Melhorando o aprendizado de poucos tiros no contexto por meio de treinamento auto-supervisionado . NAACL 2022

Mingda Chen, Jingfei DU, Ramakanth Pasunuru, Todor Mihaylov, Srini Iyer, Veselin Stoyanov, Zornitsa Kozareva . [PDF]

Aprendizagem auto-gerada no contexto: alavancando os modelos de linguagem auto-regressiva como um gerador de demonstração . LPLM@NAACL 2022

Hyuhng Joon Kim, Hyunsoo Cho, Junyeob Kim, Taeuk Kim, Kang Min Yoo, Sang-Goo Lee . [PDF]

Repensando o papel das demonstrações: o que faz o aprendizado no contexto funcionar? Pré -impressão 2022.2

Sewon Min, Xinxi Lyu, Ari Holtzman, Mikel Artetxe, Mike Lewis, Hannaneh Hajishirzi, Luke Zettlemoyer . [PDF] [Código]

Aprendizagem no Contexto para o rastreamento do estado de diálogo com poucos tiros. Pré -impressão 2022.3

Yushi Hu, Chia-Hsuan Lee, Tianbao Xie, Tao Yu, Noah A. Smith, Mari Ostendorf . [PDF] [Código]

A autoconsistência melhora o raciocínio da cadeia de pensamentos nos modelos de idiomas . Pré -impressão 2022.3

Xuezhi Wang, Jason Wei, Dale Schuurmans, Quoc Le, Ed Chi, Denny Zhou . [PDF]

Estrela: Raciocínio de Bootstrapping autodidata com raciocínio com raciocínio . Pré -impressão 2022.3

Eric Zelikman, Yuhuai Wu, Noah D. Goodman . [PDF]

Benchmarking Generalização por meio de instruções no contexto em mais de 1.600 tarefas de idioma . Pré -impressão 2022.4

Wang Wang, Swaroop Mishra, Pegah Alipoormolabashi, Yeganeh Kordi, Amirreza Mirzaei, Anjana Arunkumar, Arjun Ashok, Arut Selvan Dhanasekaran, Athharva Naik, David, Esphaan, Giannis Karaman, Stap, Esphaan, Giannis Karaman, Ishani Mondal, Jacob Anderson, Kirby Kuznia, Krima Doshi, Maitreya Patel, Kuntal Kumar Pal, Mehrad Moradshahi, Mihir Parmar, Mirali Purohit, Neeraj Varshney, Phani Rohitha Kanna, Purohit, Ravohit, Ravohi Sampat, Savan Doshi, Siddhartha Mishra, Sujan Reddy, Sumanta Patro, Tanay Dixit, Xudong Shen, Chitta Baral, Yejin Choi, Noah A. Smith, Hannaneh Hajishirzi, Daniel Khashabi . [PDF] [Código]

Os modelos de idiomas podem aprender com as explicações no contexto? . Pré -impressão 2022.4

Andrew K. Lampinen, Ishita Dasgupta, Stephanie Cy Chan, Kory Matthewson, Michael Henry Tessler, Antonia Creswell, James L. McClelland, Jane X. Wang, Felix Hill . [PDF]

Os rótulos da verdadeira-verdade é importante: uma visão mais profunda nas demonstrações de entrada de entrada . Pré -impressão 2022.5

Junyeob Kim, Hyuhng Joon Kim, Hyunsoo Cho, Hwiyeol Jo, Sang-woo Lee, Sang-Goo Lee, Kang Min Yoo, Taeuk Kim . [PDF]

A falta de confiabilidade das explicações na aprendizagem de poucas fotos no contexto . Pré -impressão 2022.5

XI YE, Greg Durrett . [PDF]

O pedido menos ao máximo permite o raciocínio complexo em grandes modelos de linguagem . Pré -impressão 2022.5

Denny Zhou, Nathanael Schärli, Le Hou, Jason Wei, Nathan Scales, Xuezhi Wang, Dale Schuurmans, Olivier Bousquet, Quoc Le, Ed Chi . [PDF]

Promotamento Maiêutico: Raciocínio logicamente consistente com explicações recursivas . Pré -impressão 2022.5

Jaehun Jung, Lianhui Qin, Sean Welkeck, Faeze Brahman, Chandra Bhagavatula, Ronan Le Bras, Yejin Choi . [PDF]

No avanço de tornar os modelos de idiomas melhores raciocínio . Preprint 2022.6

Yifei Li, Zeqi Lin, Shizhuo Zhang, Qiang Fu, Bei Chen, Jian-Guang Lou, Weizhu Chen . [PDF] [Código]

Habilidades emergentes de grandes modelos de linguagem . Preprint 2022.6

Jason Wei, Yi Tay, Rishi Bommasani, Colin Raffel, Barret Zoph, Sebastian Borgeaud, Dani Yogatama, Maarten Bosma, Denny Zhou, Donald Metzler, Ed H. Chi, Tatsunori Hashimoto, Oriol Vinyals, Percy Liang, Jeff Dean, William Fedus . [PDF]

Os modelos de idiomas são interfaces de uso geral . Preprint 2022.6

Yaru Hao, Haoyu Song, Li Dong, Shaohan Huang, Zewen Chi, Wenhui Wang, Shuming MA, Furu Wei . [PDF] [Código]

O que os transformadores podem aprender no contexto? Um estudo de caso de classes de função simples . Preprint 2022.8

Shivam Garg, Dimitris Tsipras, Percy Liang, Gregory Valiant . [PDF] [Código]

Aprendizagem destilando contexto . Pré -impressão 2022.9

Charlie Snell, Dan Klein, Ruiqi Zhong . [PDF]

Modelos de linguagem de ligação em idiomas simbólicos . Pré -impressão 2022.10

Zhoujun Cheng*, Tianbao Xie*, Peng Shi, Chengzu Li, Rahul Nadkarni, Yushi Hu, Caiming Xiong, Dragomir Radev, Mari Ostendorf, Luke Zettlemoyer, Noah A. Smith, Tao Yu . [PDF] [Código] [Site]

Preservando a capacidade de aprendizado no contexto em um modelo de grande idioma . Pré -impressão 2022.11

Yihan Wang, Si Si, Daliang LI, Michal Lukasik, Felix Yu, Cho-Jui Hsieh, Inderjit S Dhillon, Sanjiv Kumar . [PDF]

Ensinar o raciocínio algorítmico por meio de aprendizado no contexto . Pré -impressão 2022.11

Hattie Zhou, Azade Nova, Hugo Larochelle, Aaron Courville, Behnam Neyshabur, Hanie Sedghi . [PDF]

Que algoritmo de aprendizado é o aprendizado no contexto? Investigações com modelos lineares . Pré -impressão 2022.11

Ekin Akyürek, Dale Schuurmans, Jacob Andreas, Tengyu MA, Denny Zhou . [PDF]

Ajuste de caixa preta para modelo de idioma como serviço . ICML 2022

Tianxiang Sun, Yunfan Shao, Hong Qian, Xuanjing Huang, XIPENG QIU. [PDF] [Código]

Aprendizagem imediata de caixa preta para modelos de idiomas pré-treinados . TMLR 2023.2

Shizhe Diao, Xuechun Li, Yong Lin, Zhichao Huang, Tong Zhang . [PDF]

Grips: Pesquisa de instrução baseada em gradiente, baseada em edição, promovendo grandes modelos de idiomas . Pré -impressão 2022.3

Archiki Prasad, Peter Hase, Xiang Zhou, Mohit Bansal . [PDF] [Código]

Poucos pedidos de geração de resposta controlável . Preprint 2022.6

Hsuan Su, Pohan Chi, Shih-Cheng Huang, Chung Ho Lam, Saurav Sahay, Shang-Tse Chen, Hung-Yi Lee . [PDF]

BBTV2: em direção a um futuro sem gradiente com grandes modelos de idiomas . EMNLP 2022

Tianxiang Sun, Zhengfu He, Hong Qian, Yunhua Zhou, Xuanjing Huang, Xipeng Qiu . [PDF] [Código]

RLPROMPT: Otimizando solicitações de texto discreto com aprendizado de reforço . EMNLP 2022

Mingkai Deng, Jianyu Wang, Cheng-Ping Hsieh, Yihan Wang, Han Guo, Tianmin Shu, Meng Song, Eric P. Xing, Zhiting Hu . [PDF] [Código]

Ajuste do clipe: Rumo ao aprendizado imediato sem derivado com uma mistura de recompensas . Resultados do EMNLP 2022

Yekun Chai, Shuohuan Wang, Yu Sun, Hao Tian, Hua Wu, Haifeng Wang . [PDF]

Tempera: Edição rápida de teste de teste por meio de aprendizado de reforço . Pré -impressão 2022.11

Tianjun Zhang, Xuezhi Wang, Denny Zhou, Dale Schuurmans, Joseph E. Gonzalez. [PDF] [Código]

PromptBoosting: Classificação de texto de caixa preta com dez passes para a frente . Pré -impressão 2022.12

Bairu Hou, Joe O'Connor, Jacob Andreas, Shiyu Chang, Yang Zhang . [PDF]

Pré-treinamento multitarefa de prompt modular para aprendizado chinês de poucos tiros . ACL 2023

Tianxiang Sun, Zhengfu He, Qin Zhu, Xipeng Qiu, Xuanjing Huang . [PDF]

Quando a descida de gradiente atende à otimização sem derivados: uma correspondência feita no cenário de caixa preta . ACL 2023

Chengcheng Han, Liqing Cui, Renyu Zhu, Jianing Wang, Nuo Chen, Qiushi Sun, Xiang Li, Ming Gao . [PDF]

Faça ajuste de caixa preta baseada em preto colorido: aumentando a generalização do modelo de três perspectivas ortogonais . LREC-COLING 2024

Qiushi Sun, Chengcheng Han, Nuo Chen, Renyu Zhu, Jingyang Gong, Xiang Li, Ming Gao . [PDF]

Sintonizar ou não sintonizar? Adaptar representações pré -ridicularizadas a diversas tarefas . Repl4nlp@ACL 2019

Matthew E. Peters, Sebastian Ruder, Noah A. Smith . [PDF]

As explicações podem ser úteis para calibrar os modelos de caixas pretas? ACL 2022

XI YE, Greg Durrett . [PDF] [Código]

O co-treinamento melhora a aprendizagem rápida baseada em grandes modelos de idiomas . ICML 2022

Hunter Lang, Monica Agrawal, Yoon Kim, David Sontag . [PDF]

Tune Y: um paradigma de ajuste eficiente para modelos pré-treinados em larga escala por meio de aprendizado de representação de etiquetas . Pré -impressão 2022.2

Yitao Liu, Chenxin AN, XIPENG QIU . [PDF]

LST: Ajuste lateral da escada para aprendizado de transferência eficiente em parâmetro e memória . Neurips 2022

Yi-lin Sung, Jaemin Cho, Mohit Bansal . [PDF] [Código]

Ajuste do decodificador: entendimento eficiente da linguagem como decodificação . Pré -impressão 2022.12

Ganqu Cui, Wentao Li, Ning Ding, Longtao Huang, Zhiyuan Liu, Maosong Sun. [PDF]

Gerando conjuntos de dados com modelos de idiomas pré -teremia . EMNLP 2021

Timo Schick, Hinrich Schütze . [PDF] [Código]

GPT3MIX: Aproveitando modelos de idiomas em larga escala para aumento de texto . Resultados do EMNLP 2021

Kang Min Yoo, Dongju Park, Jaewook Kang, Sang-woo Lee, Woomyeong Park . [PDF] [Código]

Gerou conhecimento solicitando o raciocínio de senso comum . ACL 2022

Jiacheng Liu, Alisa Liu, Ximing Lu, Sean Welkeck, Peter West, Ronan Le Bras, Yejin Choi, Hannaneh Hajishirzi . [PDF] [Código]

Zerogen: aprendizado eficiente de tiro zero via geração de dados . EMNLP 2022

Jiacheng Ye, Jiahui Gao, Qintong Li, Hang Xu, Jiangtao Feng, Zhiyong Wu, Tao Yu, Lingpeng Kong . [PDF] [Código]

Zerogen+: Geração de dados de alta qualidade autoguiada em aprendizado eficiente de tiro zero . Pré -impressão 2022.2

Jiahui Gao, Renjie Pi, Yong Lin, Hang Xu, Jiacheng Ye, Zhiyong Wu, Xiaodan Liang, Zhenguo Li, Lingpeng Kong . [PDF]

Augesc: Aumentação de diálogo com grandes modelos de idiomas para conversas de apoio emocional . Resultados do ACL 2023

Chujie Zheng, Sand Sabour, Jiaxin Wen, Zheng Zhang, Minlie Huang . [PDF]

Gerando dados de treinamento com modelos de idiomas: para o entendimento da linguagem zero . Neurips 2022

Yu Meng, Jiaxin Huang, Yu Zhang, Jiawei Han [PDF] [Código]

? Primeiro, obrigado por reservar um tempo para contribuir! ?

Etapas para contribuir:

PaperNumber na parte superior da página de acordo e envie sua solicitação de tração. Recomendamos dar uma explicação muito breve por que você acha que um artigo deve ser adicionado ou alterado.Não se preocupe se você colocar algo errado, nós os corrigiremos para você. Basta contribuir e promover seu trabalho incrível aqui!

Além dos seguintes colaboradores que enviaram solicitações de tração, também gostaríamos de agradecer a Ohad Rubin e Kang Min Yoo por recomendar documentos.