Converse com seus dados corporativos usando LLM

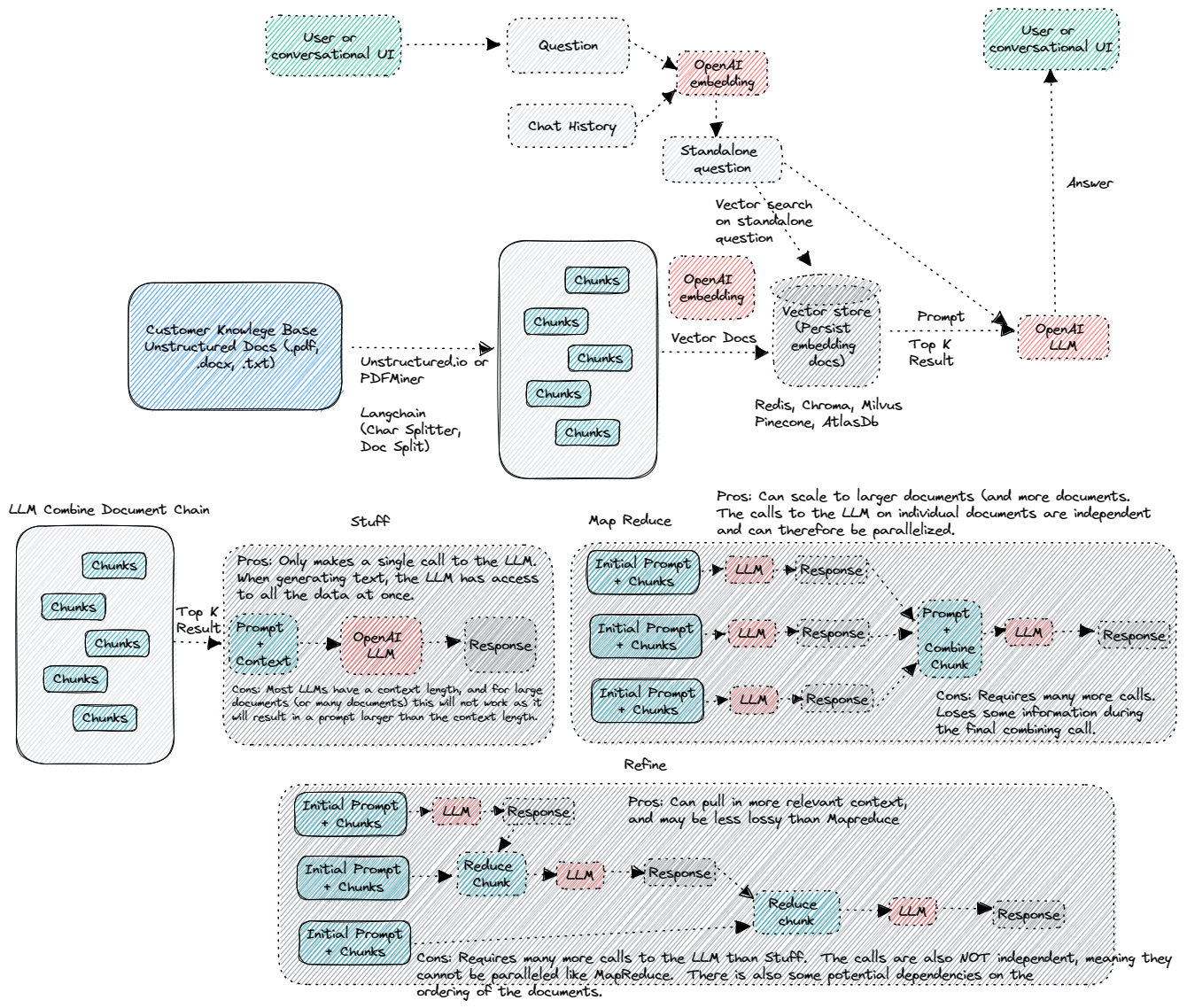

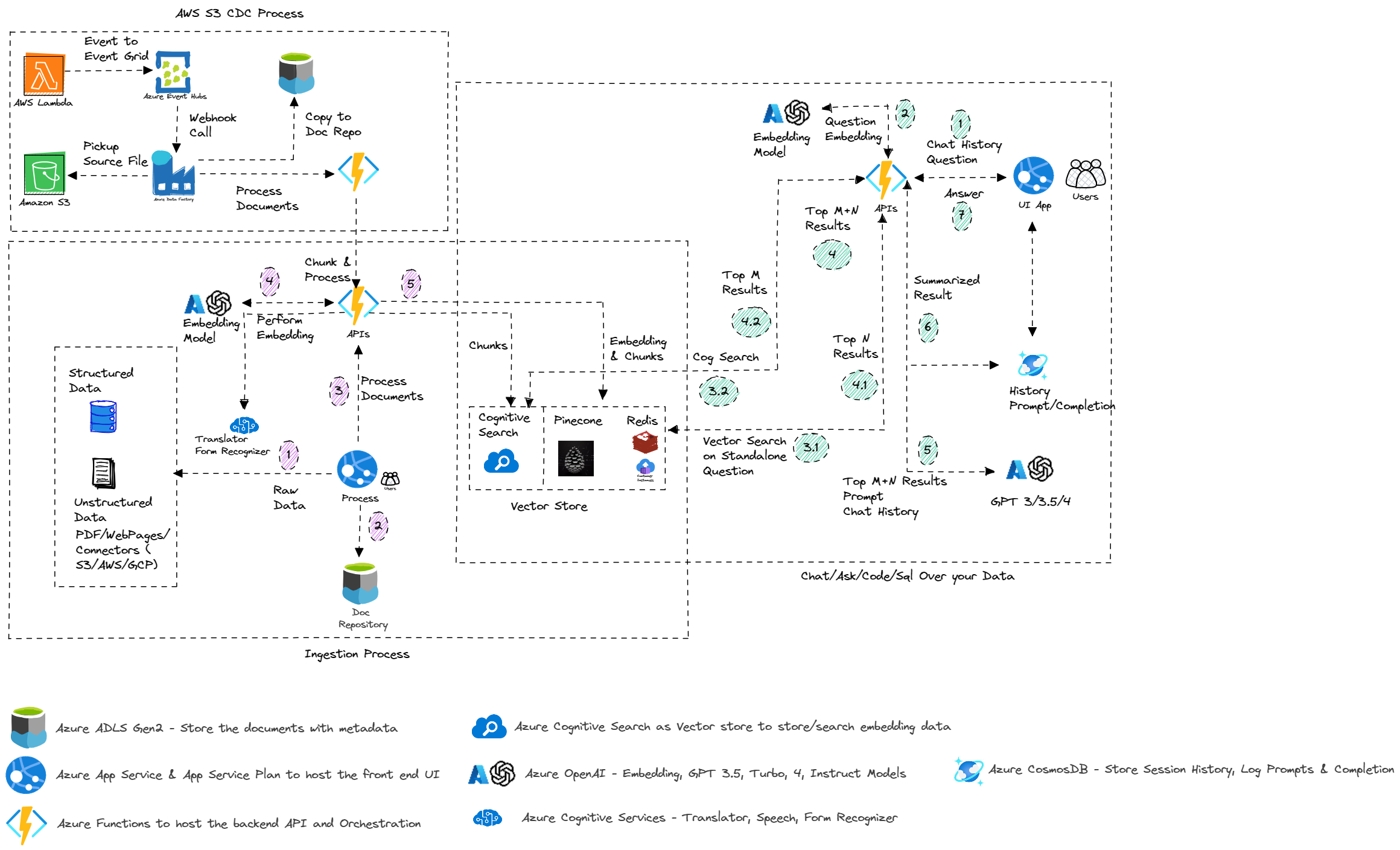

Esta amostra demonstra algumas abordagens para criar experiências semelhantes ao ChatGPT sobre seus próprios dados. Ele usa o serviço Azure OpenAI para acessar o modelo ChatGPT (GPT-35-Turbo e GPT3) e o Vector Store (Pinecone, Redis e outros) ou a pesquisa cognitiva do Azure por indexação e recuperação de dados.

O repositório fornece uma maneira de fazer upload de seus próprios dados, para que esteja pronto para tentar o fim para terminar.

Atualizações

- 30/03/2024 - Refatorado para manter o bate -papo, o fluxo de bate -papo, o QNA, o upload e a funcionalidade do administrador. Todos os outros serão transferidos para o seu próprio repo.

- 3/10/2024 - Mova a versão de fluxo imediato para ENTOOAPF

- 9/3/2024 - Versão inicial de técnicas avançadas de pano e padrão de pano multimodal

- 28/02/2024 - Removido Recursos de análise da SEC e foi transferido para o seu próprio repo na SEC

- 28/01/2024 - Remova os recursos do pitchbook enquanto são movidos para o seu próprio repo no PIB

- 19/02/2024 - Atualizada o pacote Python & OpenAI> 1.0. Alterações feitas em toda a API do Python para quebrar mudanças introduzidas em Openai e Langchain.

- 10/12/2023 - Versão inicial do Autonomous Promptflow. Por enquanto, apoiando os índices Pinecone, mas o suporte à pesquisa cognitiva e Redis serão atualizados em breve.

- 29/09/2023 - Adicionado Avaliar o Promptflow. O fluxo imediato criado uma vez criado no Azure ML, pode ser anexado à sua execução existente para avaliar o seguinte processo de avaliação:

- Faixa-O fluxo de avaliação de atendimento de perguntas e respostas avaliará os sistemas de geração aumentada de perguntas e respostas, aproveitando os modelos de idiomas grandes (LLM) de ponta (LLM) para medir a qualidade e a segurança de suas respostas. A utilização do GPT-3.5 como modelo de idioma para ajudar com medições visa alcançar uma alta concordância com as avaliações humanas em comparação com as medições matemáticas tradicionais. GPT_Groundnedness (contra o contexto): mede o quão fundamentado as respostas previstas do modelo são contra o contexto. Mesmo que as respostas do LLM sejam verdadeiras, se não verificáveis contra o contexto, essas respostas são consideradas não aterradas.

- Similaridade da ADA-O fluxo de avaliação de perguntas e respostas ADA_SIMilaridade avaliará os sistemas de geração aumentada de recuperação de perguntas e respostas, aproveitando os modelos de linguagem de última geração (LLM) para medir a qualidade e a segurança de suas respostas. A utilização do GPT-3.5 como modelo de idioma para ajudar com medições visa alcançar uma alta concordância com as avaliações humanas em comparação com as medições matemáticas tradicionais. O fluxo de avaliação de similaridade da ADA permite avaliar e avaliar seu modelo com a ADA similaridade ADA, assistida por LLM, METRI ADA_SIMilaridade: mede a similaridade de cosseno das incorporações da ADA da previsão do modelo e da verdade do solo. Ada_similaridade é um valor no intervalo [0, 1].

- Coerência-O fluxo de avaliação de coerência de perguntas e respostas avaliará os sistemas de geração aumentada de recuperação de perguntas e respostas, alavancando os modelos de idiomas grandes (LLM) de última geração para medir a qualidade e a segurança de suas respostas. A utilização do GPT-3.5 como modelo de idioma para ajudar com medições visa alcançar uma alta concordância com as avaliações humanas em comparação com as medições matemáticas tradicionais. O fluxo de avaliação de coerência permite avaliar e avaliar seu modelo com a métrica de coerência assistida por LLM. GPT_COERENCE: mede a qualidade de todas as frases na resposta prevista de um modelo e como elas se encaixam naturalmente. A coerência é pontuada em uma escala de 1 a 5, sendo 1 a pior e 5 sendo a melhor.

- Similaridade-O fluxo de avaliação de similaridade de perguntas e respostas avaliará os sistemas de geração aumentada de recuperação de perguntas e respostas, aproveitando os modelos de linguagem de grande ponta (LLM) para medir a qualidade e a segurança de suas respostas. A utilização do GPT-3.5 como modelo de idioma para ajudar com medições visa alcançar uma alta concordância com as avaliações humanas em comparação com as medições matemáticas tradicionais. O fluxo de avaliação de similaridade permite avaliar e avaliar seu modelo com a métrica de similaridade assistida por LLM. GPT_Similaridade: mede a similaridade entre as respostas da verdade do solo fornecidas pelo usuário e a resposta prevista do modelo. A similaridade é pontuada em uma escala de 1 a 5, sendo 1 a pior e 5 sendo a melhor.

- Pontuação F1-O fluxo de avaliação de perguntas e respostas de perguntas e respostas avaliará os sistemas de geração aumentada de perguntas e respostas, usando a pontuação F1 com base na contagem de palavras na resposta prevista e na verdade. O fluxo de avaliação de pontuação F1 permite determinar a métrica de escore F1 usando o número de tokens comuns entre a versão normalizada da verdade do solo e a resposta prevista. F1-Score: Calcule a pontuação F1 com base nos tokens na resposta prevista e na verdade fundamental. F1-score é um valor no intervalo [0, 1]. A métrica de fundamento é pontuada em uma escala de 1 a 5, sendo 1 a pior e 5 sendo a melhor.

- 22/09/2023 - Adicionado Promptflow para SQLask. Verifique se os valores de configuração

PFSQLASK_URL e PFSQLASK_KEY são adicionados ao endpoint implantado para ativar o recurso. Verifique também que os valores de configuração SynapseName , SynapsePool , SynapseUser e SynapsePassword são adicionados à conexão entaoai Promptflow. Moveu a exclusão do recurso de sessão para o ChatGPT para a página de administração. - 20/09/2023 - Adicionada configuração para permitir que o usuário final altere o tipo de pesquisa para o índice de armazenamento de vetores de pesquisa cognitiva (híbrido, similaridade/vetor e re -rank híbrido), com base nas melhores práticas que compartilhamos. QNA, bate -papo e fluxo rápido são modificados. A QNA e o bate -papo estão implementando a implementação personalizada do Vector Store de Langchain e o fluxo rápido usando as funções auxiliares. Corrigido o problema com QNA/Chat/Promptflow não gerando perguntas de acompanhamento.

- 18/09/2023 - Refaturou o SQL NLP para não usar o agente/cadeia do banco de dados Langchain e, em vez disso, usar prompts personalizados.

- 15/09/2023 - Modificou o pacote de pesquisa do Azure para 11.4.0b9 e Langchain para a versão mais recente. Capacidade adicionada para executar a avaliação no PromptFlow para QNA e bate -papo. Os dados de PDF e avaliação BERT podem ser usados para executar o lote e a avaliação no fluxo imediato. Notebook de amostra mostrando o processo de fluxo e E2E está disponível. A pasta de bate -papo do Bert permite testar o fluxo rápido do E2E, a execução do lote e a avaliação na forma de notebook.

- 03/09/2023 - Adicionado API para bate -papo usando o fluxo rápido. Permita que o usuário final selecione entre as funções do Azure como API (configuração

ApiType no aplicativo da Web) ou usando o Prompt Flow Gerencied Endpoint. - 02/09/2023 - API adicionada para resposta a perguntas usando o fluxo rápido. Permita que o usuário final selecione entre as funções do Azure como API (configuração

ApiType no aplicativo da Web) ou usando o Prompt Flow Gerencied Endpoint. - 31/08/2023 - Adicionado exemplo para LLMOPs usando o fluxo rápido. O repositório adicionará a flexibilidade de usar o modelo de fluxo rápido como uma alternativa às funções atuais do Azure.

- 20/08/2023 - Adicionado suporte para os arquivos de marcação (como arquivo zip) e removeu o chunk_size = 1 do Azure OpenAiEmbedding

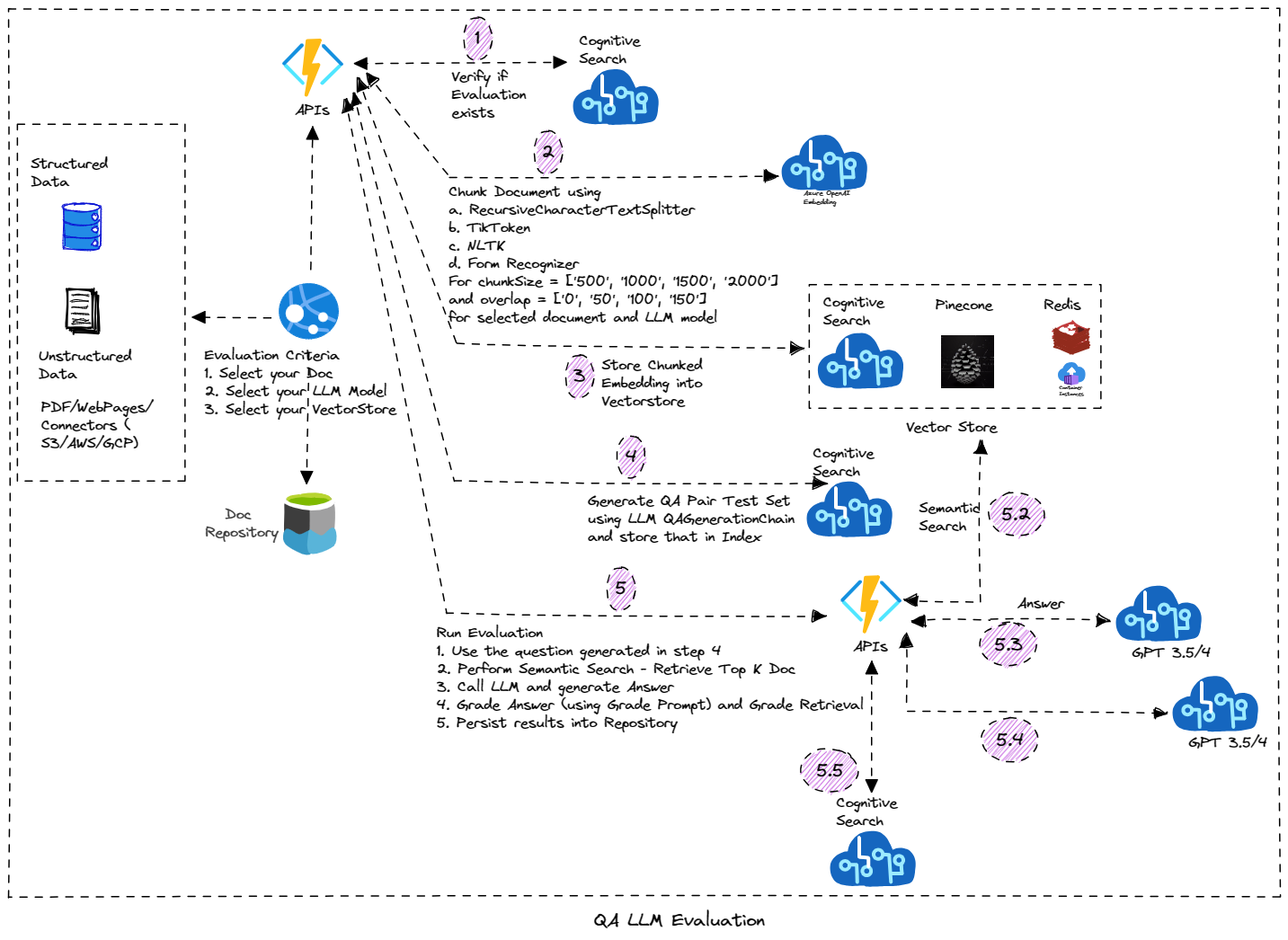

- 8/11/2023 - Corrigido o problema com o recurso de streaming de bate -papo.

- 8/10/2023 - Breaking Alterações - refatou todo o código para usar o valor de configuração

OpenAiEndPoint em vez do OpenAiService . É para apoiar as melhores práticas, conforme as descritas no registro corporativo via Gerenciamento de API do Azure. O seu OpenAiEndPoint se o uso do APIM será o URL do gateway da API e o OpenAiKey será a tecla Produto/Unlimited. Se não estiver usando o APIM, você não precisa alterar a chave, mas verifique se OpenAiEndPoint é URL totalmente qualificado da sua implantação AOAI. OpenAiService não é mais usado. As alterações impactaram o trabalho no recurso de bate -papo no fluxo, por isso está desativado por enquanto e será ativado depois de testado e corrigido. - 9/9/2023 - Adicionado chamado de função na interface ChatGPT como caixa de seleção. A amostra demonstra a capacidade de chamar funções. Atualmente, a API meteorológica, a API de ações e a pesquisa do Bing são suportadas. A chamada de função está na visualização e suportada apenas na "versão da API" de "2023-07-01-preview"; portanto, atualize a implantação existente para usar essa versão. Detalhes sobre as funções de chamada. Para implantação existente, adicione

WeatherEndPoint , WeatherHost , StockEndPoint , StockHost e RapidApiKey Configuration para o App Function Azure. - 8/8/2023 - Adicionada interface de bate -papo com a opção "Stream". Esse recurso permite transmitir a conversa para o cliente. Você precisará adicionar

OpenAiChat , OpenAiChat16k , OpenAiEmbedding , OpenAiEndPoint , OpenAiKey , OpenAiApiKey , OpenAiService , OpenAiVersion , PineconeEnv , PineconeIndex , PineconeKey , RedisAddress , RedisPassword , RedisPort PROPRIEDADE DE APPAPAPP. - 30/07/2023 - Código não utilizado removido - Summaryandqa e Chat

- 28/07/2023 - Começou a remover o uso do modelo DaVinci. Por enquanto removeu o uso de toda a funcionalidade, exceto o workshop. Funcionalidade de resumo refatorada com base no feedback para permitir que o usuário especifique os tópicos prompt e predefinidos para resumir.

- 26/07/2023 - Remova o playground do OpenAI das ferramentas de desenvolvedor como recursos avançados deles disponíveis na seção ChatGPT.

- 25/07/2023 - Adicione a guia para os recursos de bate -papo para oferecer suporte ao recurso ChatGPT diretamente do modelo em vez de "bate -papo em dados". Você precisará adicionar a propriedade

CHATGPT_URL no Azure App Service (WebApp) para ativar o recurso fora da implantação da nova função do Azure. - 23/07/2023 - Adicionado o restante do recurso para a interface do usuário do PIB e a versão inicial da geração do deck do PowerPoint como a saída. Para um novo recurso adicionado, verifique se você adiciona a variável

FMPKEY à configuração do WebApp. - 20/07/2023 - Recurso adicionado para conversar com dados do PIB (registros da SEC e transcrição de chamadas de ganho). Como a nova função do Azure é implantada, verifique se a propriedade

PIBCHAT_URL é adicionada ao Azure WebApp com o URL para suas funções do Azure implantadas - 18/07/2023 - Refatorou o código PIB para resolver alguns dos problemas de desempenho e correções de bugs.

- 17/07/2023 - Removeu a interface de bate -papo GPT3 com a aposentadoria dos modelos "DaVinci".

- 16/07/2023 - Versão inicial da interface do usuário do PIB (atualmente suportando 5 etapas - perfil da empresa, transcrições de chamadas, comunicados à imprensa, registros e classificações/recomendações da SEC). Você precisará de acesso à assinatura paga (FMP ou modificar com base no que sua empresa tem acesso). Para usar com o FMP, você precisará adicionar

FmpKey nas funções do Azure. Devido à dependência circular, você precisa adicionar manualmente manualmente SecDocPersistUrl e SecExtractionUrl nas funções do Azure. - 14/07/2023 - Adicione suporte ao modelo GPT3.5 16K e capacidade de reduzir o documento> 4000 tokens com> 500 sobreposição. Para o ChunkSize> 4000, ele padrão é de 16k token para a funcionalidade QNA e Chat. Adicionado provedor de identidade ao aplicativo e autenticação para QNA e interface de bate -papo. Para o modelo GPT3.5 16K, você precisará adicionar a propriedade

OpenAiChat16k no aplicativo de função do Azure. - 13/07/2023 - Permita que o usuário final selecione ChunkSize e Chunkoverlap Configuration. Versão inicial de Modelo de Prompt Substituir.

- 11/07/2023 - Copiloto funcional do PIB na forma do notebook.

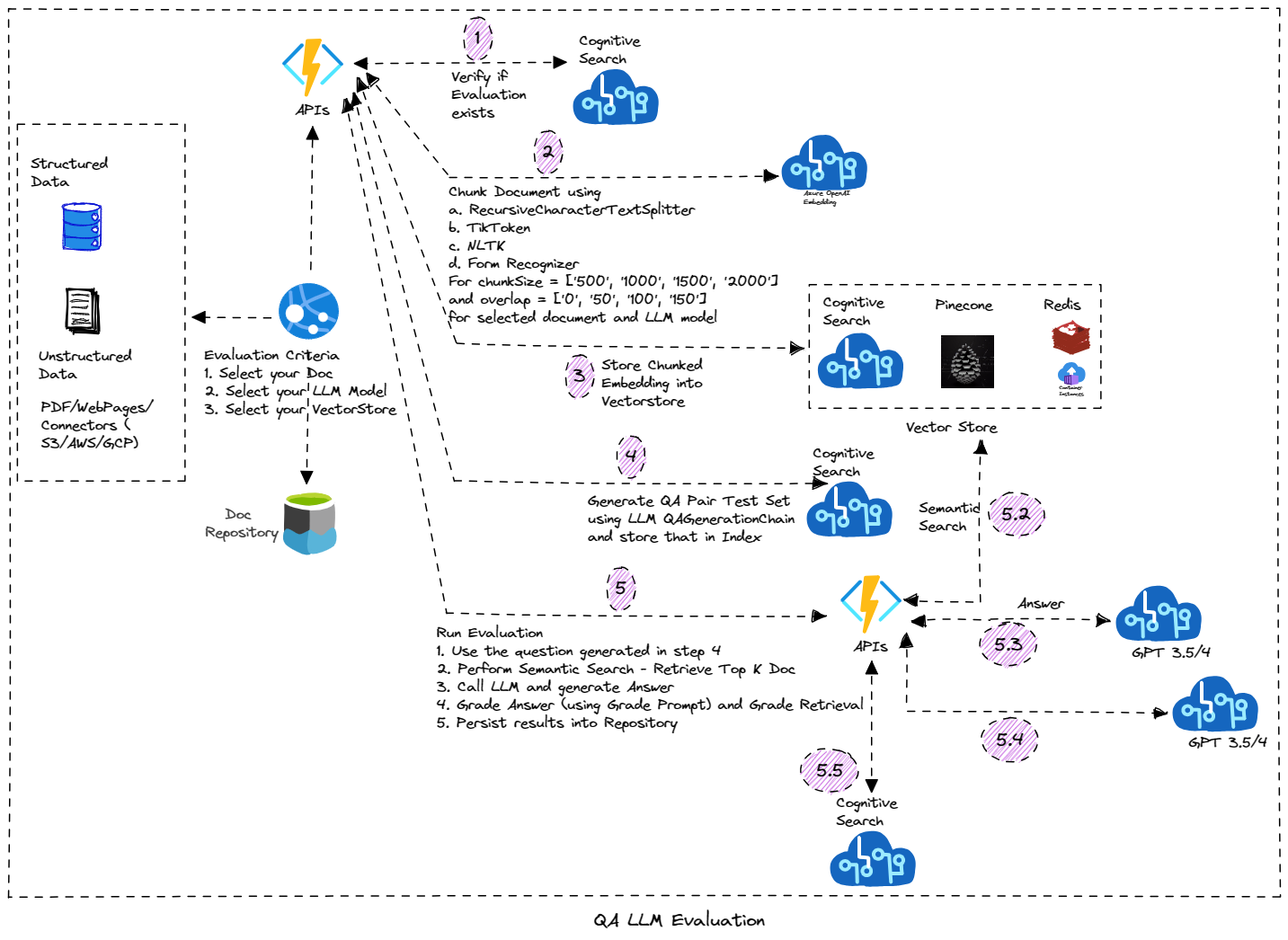

- 8/8/2023 - Adicionado o recurso para renomear a sessão para chatgpt. Também adicionou a interface do usuário para a ferramenta de avaliador. Esse recurso se concentra na execução da avaliação baseada em LLM no seu documento. Ele gera automaticamente o conjunto de dados de teste (com perguntas e respostas) e execute a classificação nesse documento usando parâmetros diferentes e gera os resultados da avaliação. Ele é construído sobre funções duráveis do Azure e é implementado usando o padrão de encadeamento de funções. Você precisará adicionar

BLOB_EVALUATOR_CONTAINER_NAME (verifique se o mesmo nome do contêiner é criado na conta de armazenamento) e RUNEVALUATION_URL (URL da configuração de implantação de função durável) no aplicativo da Web do Azure para implantação existente e se deseja usar o recurso de avaliador. Na implantação da função do Azure, adicione as configurações AzureWebJobsFeatureFlags (Value EnableWorkerIndexing) e as configurações OpenAiEvaluatorContainer . - 05/07/2023 - Adicionado o recurso para excluir a sessão. Esse recurso requer o recurso que está em visualização e você precisará ativar isso na conta CosmosDB na sua assinatura. Bloco de tentativa/captura simples adicionado, caso você não tenha ativado/implantado o CosmosDB para continuar a implementação do ChatGPT.

- 7/07/2023 - Versão inicial de "sessões" de armazenamento para interface GPT3.5/ChatGPT. Sessão e mensagens são armazenadas/recuperadas do CosmosDB. Verifique se você possui o serviço COSMOSDB provisionado ou crie um novo (para implantação existente). Você precisará adicionar configurações de

CosmosEndpoint , CosmosKey , CosmosDatabase e CosmosContainer no aplicativo Funções do Azure e no aplicativo da web. - 25/06/2023 - Notebook mostrando a avaliação da qualidade da resposta de maneira sistemática (perguntas de geração automática e cadeia de avaliação), apoiando as configurações de QA LLM (tamanho do bloco, sobreposição, técnica de incorporação). Consulte o Notebook do avaliador para obter mais informações.

- 18/06/2023 - Adicione a página de administração que apoia o gerenciamento da base de conhecimento.

- 17/06/2023 - Adicionado botão "Lista de perguntas" para fazer um recurso de pergunta para exibir a lista de todas as perguntas que estão na base de conhecimento. Seguindo três propriedades

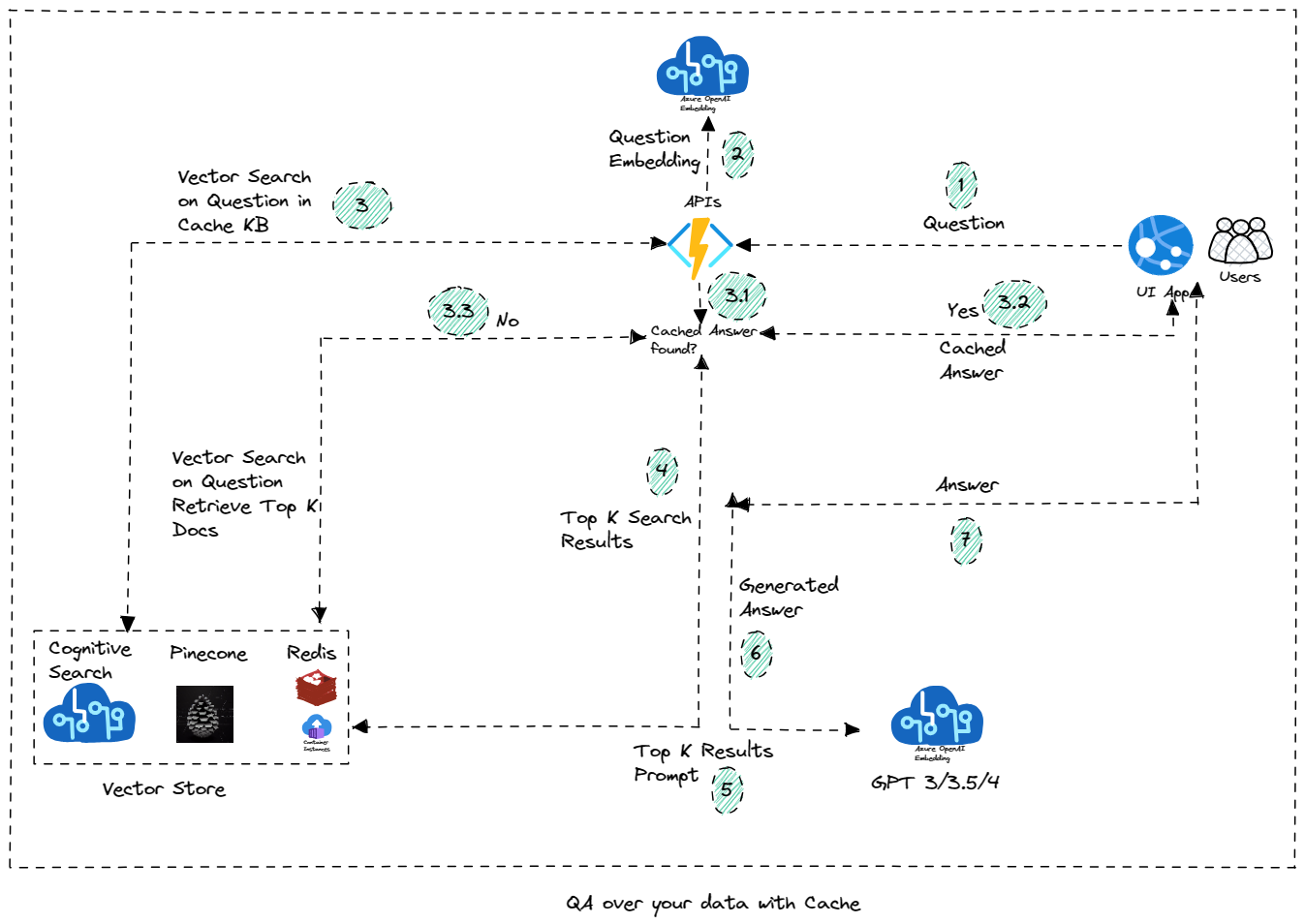

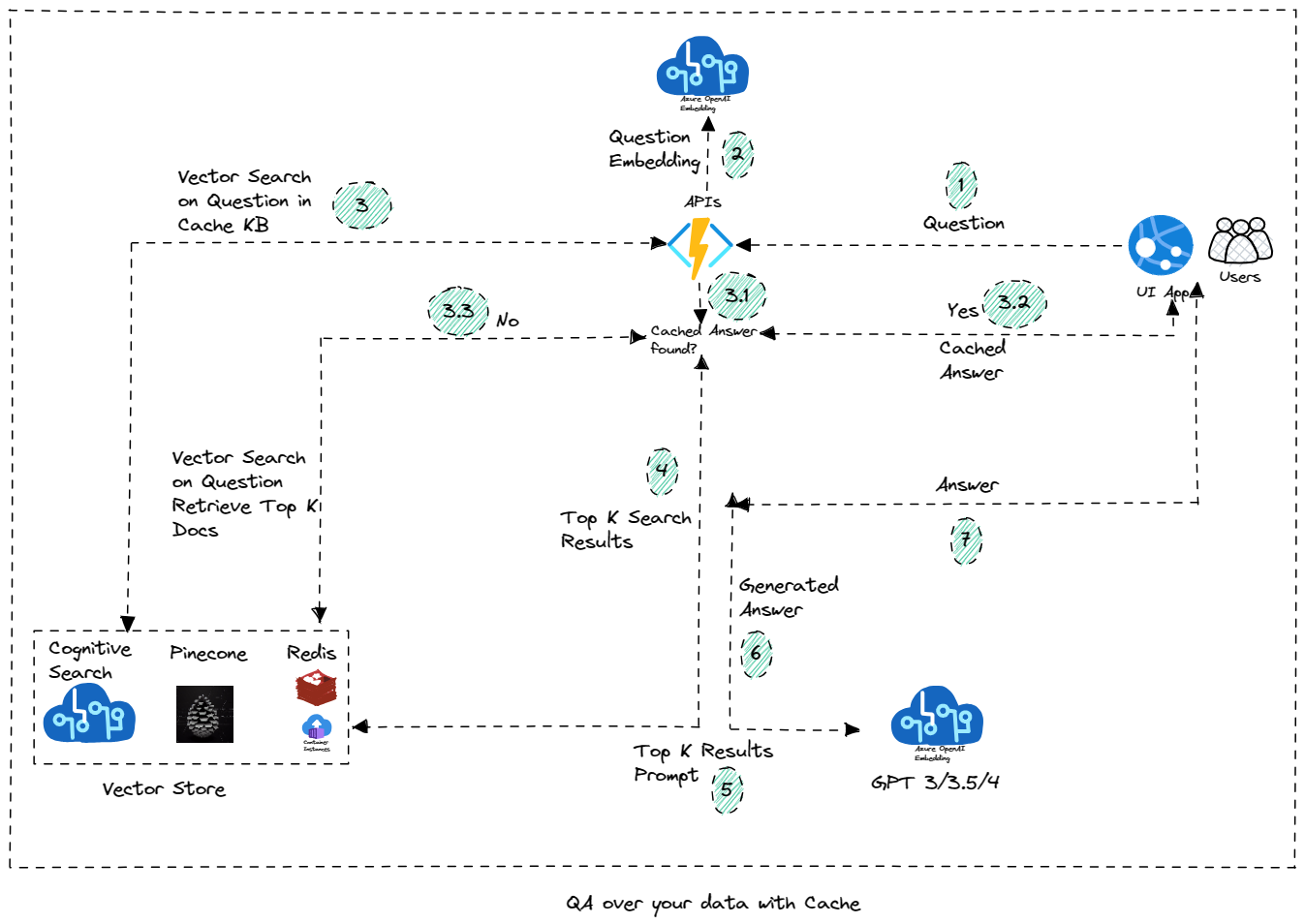

SEARCHSERVICE , SEARCHKEY e KBINDEXNAME (valor padrão do AOAIKB) precisam ser adicionados ao serviço de aplicativos do Azure para ativar o recurso de botão "Lista de perguntas". - 16/06/2023 - Adicione o recurso para usar a pesquisa cognitiva do Azure como Vector Store para armazenar a base de conhecimento em cache. As perguntas que não estão no KB são enviadas ao modelo LLM para encontrar a resposta via OAI, ou então ela é respondida do armazenamento em cache. A nova propriedade

KbIndexName precisa ser adicionada ao aplicativo de função do Azure. Adicionado o caderno para testar o recurso como parte do workshop. TODO: Adicione o recurso para adicionar a pergunta à KB na interface de bate -papo (e faça com que a sessão seja baseada na sessão). Um recurso para "regenerar" a resposta do LLM (em vez de resposta em cache) será adicionado em breve. - 07/06/2023 - Adicione o Playground OpenAi em ferramentas de desenvolvedor e a versão inicial da criação do copilot (por enquanto com notebook, mas eventualmente será movido como recurso de copilot). Adicione o script, a gravação e o exemplo para o caso de uso da análise de fala em tempo real. Mais a ser adicionado em breve.

- 27/05/2023 - Adicione o conteúdo do workshop na forma dos notebooks que podem ser aproveitados para aprender/executar os cenários. Você pode encontrar os notebooks na pasta do workshop. Detalhes sobre o conteúdo do workshop estão disponíveis aqui.

- 26/05/2023 - Adicione o recurso de resumo para resumir o documento usando o Stuff Stuff, MapReduce ou Refine Summarization. Para usar esse recurso (na implantação existente), certifique -se de adicionar a configuração

OpenAiSummaryContainer para funcionar o aplicativo e BLOB_SUMMARY_CONTAINER_NAME Configuração para o serviço de aplicativo do Azure (verifique se o valor que você insere é o mesmo que o nome do contêiner no armazenamento do Azure e que você criou o contêiner). Você também precisa adicionar a configuração PROCESSSUMMARY_URL ao serviço de aplicativo do Azure (verifique se o valor que você entra é o mesmo que o URL da função do Azure). - 24/05/2023 - Adicione o recurso para fazer upload de arquivos CSV e agente CSV para responder/bate -papo perguntas sobre os dados tabulares. O Smart Agent também suporta responder a perguntas sobre dados do CSV.

- 22/5/2023 - Versão inicial do "Smart Agent" que oferece flexibilidade para conversar com todos os documentos enviados na solução. Também permite que você converse com o cenário do banco de dados SQL. À medida que mais recursos são adicionados, o agente continuará construindo isso (por exemplo, converse com CSV/Excel ou dados tabulares)

- 21/05/2023 - Adicione a seção Ferramentas do desenvolvedor - conversão de código experimental e guru rápido.

- 17/05/2023 - Altere a fonte Edgar para a loja de vetores de pesquisa cognitiva em vez de redis.

- 15/5/2023 - Adicione a opção de usar "Pesquisa cognitiva" como Vector Store para armazenar o índice. A pesquisa cognitiva do Azure oferece pesquisa de vetores puros e recuperação híbrida-bem como um sofisticado sistema de renomeamento alimentado pelo Bing em uma única solução integrada. Inscrever-se. Apoie o upload de documentos do Word.

- 10/5/2023 - Adicione as opções de como o documento deve ser fundido. Se você deseja usar o reconhecedor do formulário, verifique se o recurso de reconhecimento de formulário é criado e as configurações de aplicativo apropriadas

FormRecognizerKey e FormRecognizerEndPoint estão configuradas. - 5/07/2023 - Opção disponível para selecionar o Azure OpenAI ou OpenAI. Para o OpenAI, verifique se você possui

OpenAiApiKey nas configurações de funções do Azure. Para o Azure OpenAI, você precisará de configurações de endpoint OpenAiKey , OpenAiService e OpenAiEndPoint . Você também pode selecionar essa opção para bate -papo/pergunta/SQL NLP/Analytics de fala e outros recursos (da página Configurações do desenvolvedor). - 5/03/2023 - Senha necessária para fazer upload e introdução da página de administração iniciando com gerenciamento de índice

- 30/04/2023 - Versão inicial do recurso de agente de tarefas adicionado. Agentes autônomos são agentes projetados para serem mais longos. Você dá a eles um ou vários objetivos de longo prazo e eles executam independentemente esses objetivos. Os aplicativos combinam o uso da ferramenta e a memória de longo prazo. O recurso inicial implementa o bebê AGI com ferramentas de execução

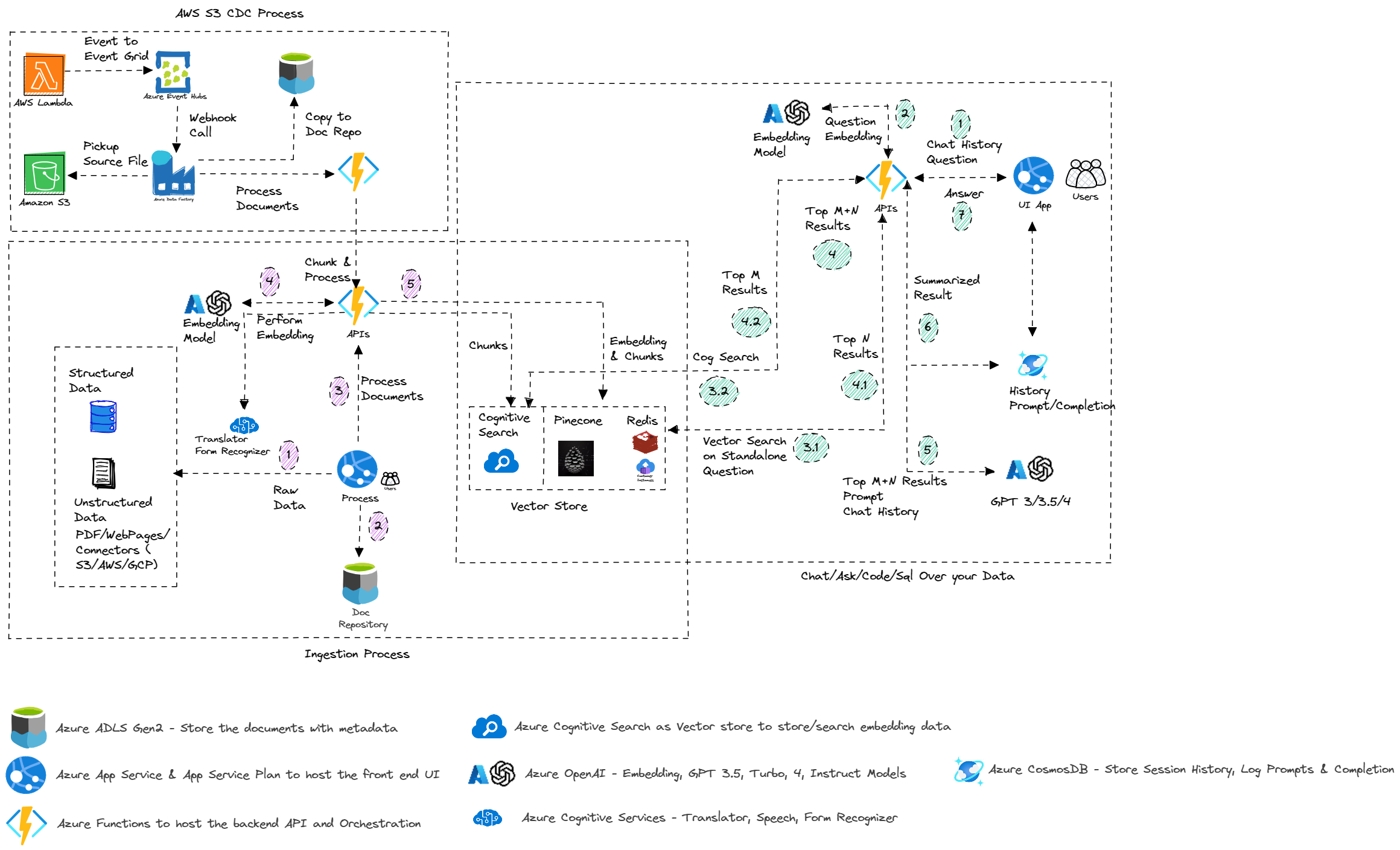

- 29/04/2023 - AWS S3 Integração de processos usando a função S3, AWS Lambda e Azure Data Factory (implantação automatizada ainda não disponível, os scripts estão disponíveis na pasta/implantação/AWS)

- 28/04/2023 - Corrija bugs, citações e perguntas de acompanhamento no controle de qualidade e bate -papo. Promot um pouco mais restritivo para limitar a resposta do documento.

- 25/04/2023 - Versão inicial do agente virtual do Power

- 21/04/2023 - Adicione a guia Dados SQL Query & SQL ao SQL NLP e corrija citações e perguntas de acompanhamento para os recursos de bate -papo e pergunta

- 17/04/2023 - Analítica de fala em tempo real e discurso para texto e texto para discursos para os recursos de bate -papo e pergunta. (Você pode configurar o texto do texto para o recurso de fala nas configurações do desenvolvedor. Você precisará de serviços de fala do Azure)

- 13/04/2023 - Adicione um novo recurso para apoiar as perguntas de fazer perguntas em vários documentos usando o agente de controle de qualidade do vetorial

- 8/04/2023 - pergunte ao seu SQL - usando o agente de banco de dados SQL ou usando a cadeia de banco de dados SQL

- 29/3/2023 - Script de implantação automatizada

- 23/3/2023 - Adicione a pesquisa cognitiva como opção para armazenar documentos

- 19/03/2023 - Adicione a implementação de bate -papo do GPT3

- 18/03/2023 - API para gerar resumo em documentos e QA de amostra

- 17/3/2023

- Apoie o upload de vários documentos

- Correção de bug - Implementação de Vectorsore Redis

- 16/3/2023 - Lançamento inicial, pergunte seus dados e converse com seus dados

Site de teste

Converse e pergunte seus dados

Características

Lista de recursos

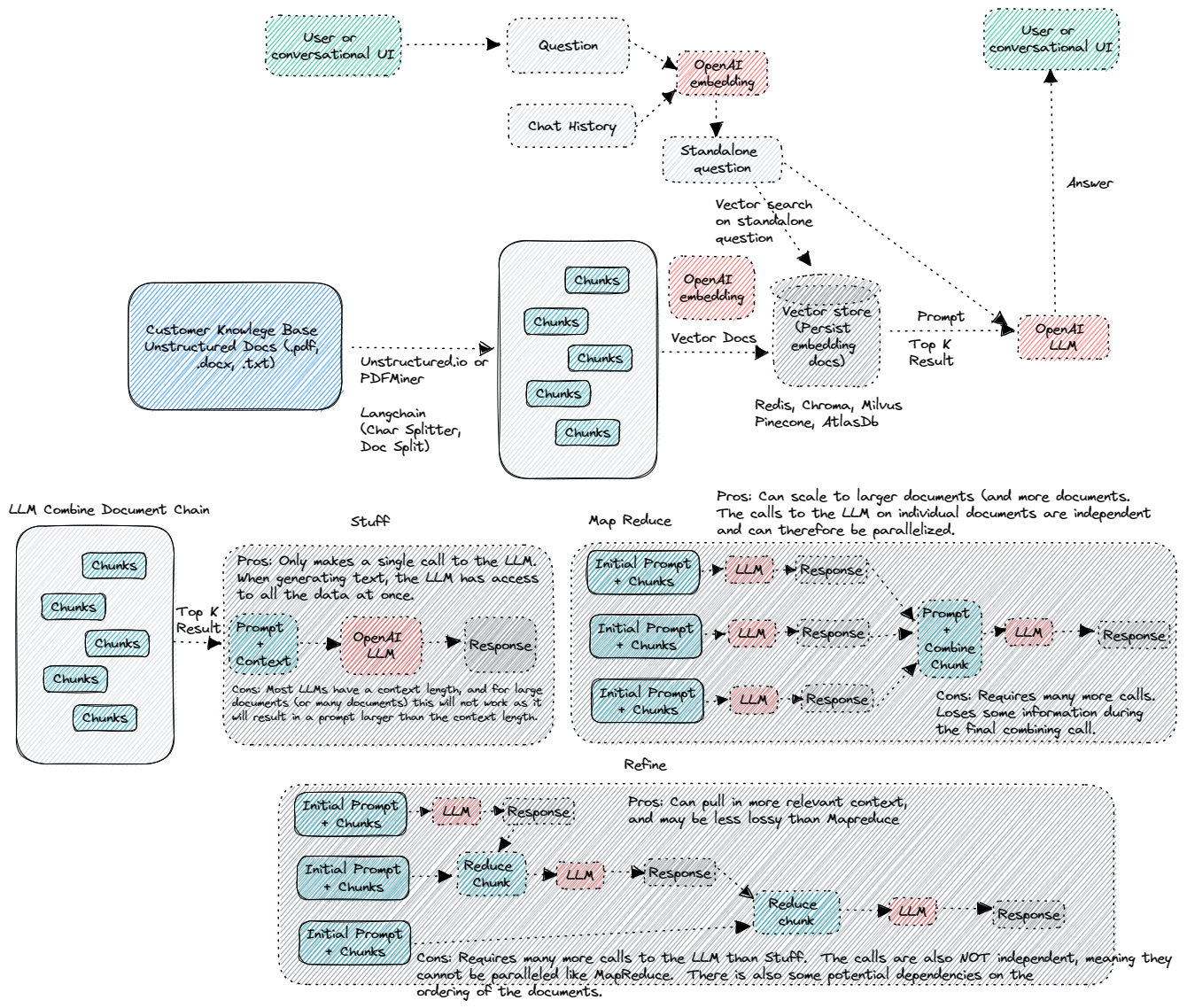

Arquitetura

Arquitetura do Azure

QA sobre seus dados com cache

Avaliação de QA LLM

Começando

Comece

Configuração

Configuração de aplicativos de aplicativo e função

Recursos

- Revolucione seus dados corporativos com ChatGPT: Aplicativos de próxima geração com o Azure OpenAi e Pesquisa Cognitiva

- Pesquisa cognitiva do Azure

- Serviço do Azure Openai

- Pesquisa de Redis

- Pinecone

- Loja de vetores de pesquisa cognitiva

Contribuições

Estamos abertos a contribuições, seja na forma de novo recurso, atualize a funcionalidade existente ou melhor documentação. Por favor, crie uma solicitação de tração e vamos revisá -la e mesclá -la.

Observação

Adaptado do Repo em Openai-COGSearch, Call Center Analytics, Auto Avaliador e Edgar Crawler