【2024.06.13】 Suporte MiniCPM-Llama3-V-2_5 Modelo, modifique a variável de ambiente MODEL_NAME=minicpm-v PROMPT_NAME=minicpm-v DTYPE=bfloat16

[2024.06.12] Suporte o modelo GLM-4V , modifique a variável de ambiente MODEL_NAME=glm-4v PROMPT_NAME=glm-4v DTYPE=bfloat16 , consulte GlM4V para exemplos de teste.

【2024.06.08】 O modelo QWEN2 foi suportado, modifique a variável de ambiente MODEL_NAME=qwen2 PROMPT_NAME=qwen2

【2024.06.05】 Suporte o modelo GLM4 e modifique a variável de ambiente MODEL_NAME=chatglm4 PROMPT_NAME=chatglm4

【2024.04.18】 Code Qwen , SQL Q&A Demo

【2024.04.16】 Modelo de reordenação Rerank de suporte, método de uso

【 QWEN1.5 】 A variável de ambiente MODEL_NAME=qwen2 PROMPT_NAME=qwen2

Para mais notícias e história, vá aqui

Conteúdo principal deste projeto

Este projeto implementa uma interface de back -end unificada para o raciocínio de modelos grandes de código aberto, o que é consistente com a resposta do OpenAI e possui as seguintes características:

Ligue para vários modelos de código aberto na forma de OpenAI ChatGPT API

? Sustta suporte de streaming para alcançar o efeito da impressora

Implementar modelo de incorporação de texto para fornecer suporte para perguntas e respostas ao conhecimento do documento

? Aste suporta várias funções de langchain , uma ferramenta de desenvolvimento de modelos de linguagem em larga escala

Você só precisa simplesmente modificar as variáveis de ambiente para usar o modelo de código aberto como um modelo alternativo para chatgpt , fornecendo suporte de back-end para vários aplicativos

Suporta o carregamento de modelos lora auto-textos

⚡ Apoiar a aceleração da inferência VLLM e processamento de solicitações simultâneas

| capítulo | descrever |

|---|---|

| Modelo de suporte | Modelos de código aberto suportados por este projeto e informações breves |

| ? Método de início | Comandos de configuração e inicialização do ambiente para modelos de inicialização |

| ⚡Vllm Método de inicialização | Comandos de configuração e inicialização do ambiente para iniciar modelos usando vLLM |

| Método de chamada | Como ligar depois de iniciar o modelo |

| ❓faq | Respostas a algumas perguntas frequentes |

Modelo de idioma

| Modelo | Tamanho do parâmetro do modelo |

|---|---|

| Baichuan | 7b/13b |

| Chatglm | 6b |

| Deepseek | 7b/16b/67b/236b |

| Internlm | 7b/20b |

| Lhama | 7b/13b/33b/65b |

| Lhama-2 | 7b/13b/70b |

| Lhama-3 | 8b/70b |

| Qwen | 1.8b/7b/14b/72b |

| Qwen1.5 | 0,5b/1,8b/4b/7b/14b/32b/72b/110b |

| Qwen2 | 0,5b/1,5b/7b/57b/72b |

| Yi (1/1.5) | 6b/9b/34b |

Para detalhes, consulte o método de inicialização do VLLM e o método de inicialização dos transformadores.

Modelo de incorporação

| Modelo | Dimensão | Link de peso |

|---|---|---|

| BGE-Large-Zh | 1024 | BGE-Large-Zh |

| M3E-Large | 1024 | MOKA-AI/M3E-LARGE |

| Text2vec-Large-Chinese | 1024 | Text2vec-Large-Chinese |

| BCE-EBEDDING-BASE_V1 (recomendado) | 768 | BCE-EBEDDING-BASE_V1 |

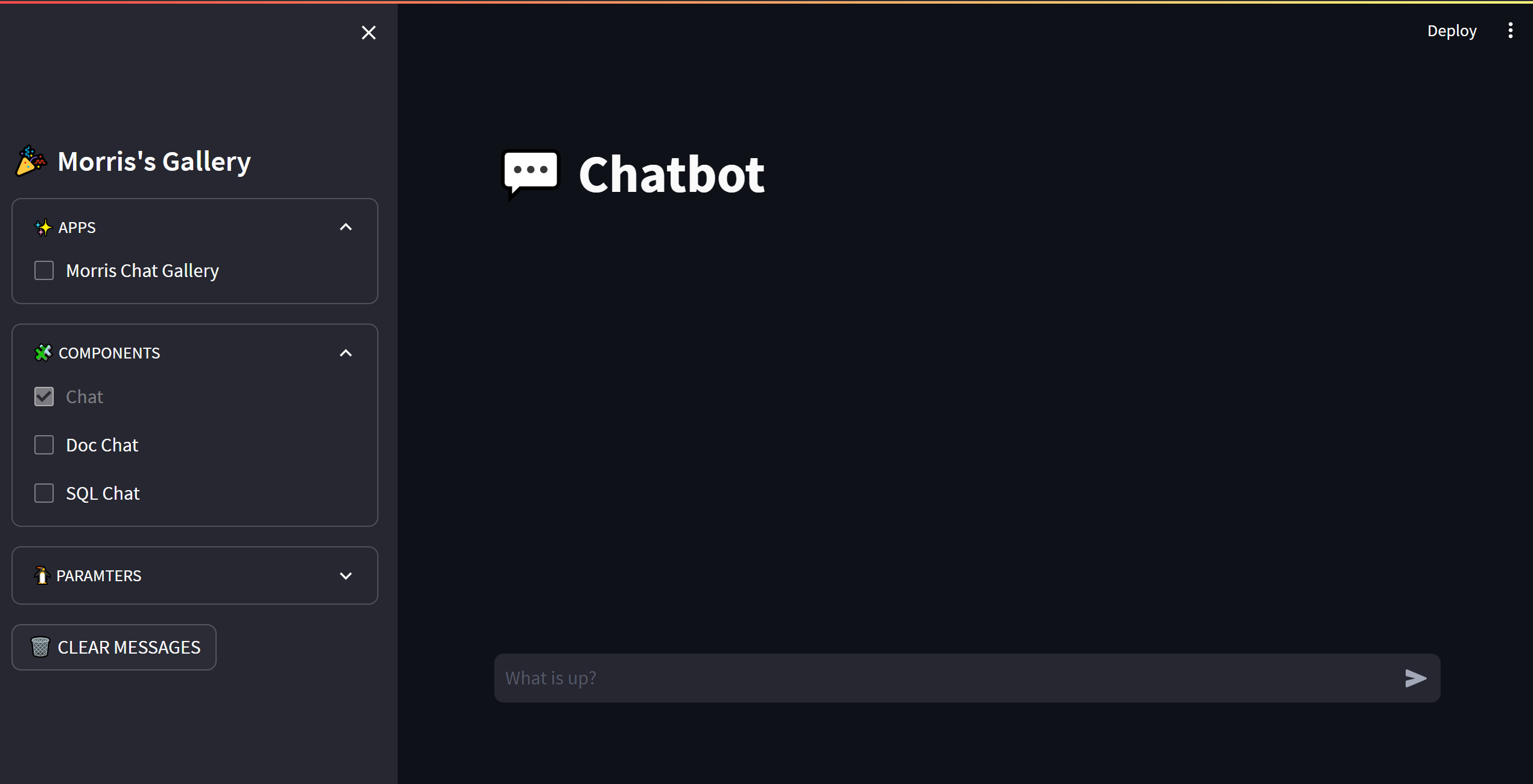

OPENAI_API_KEY : Basta preencher uma string aqui

OPENAI_API_BASE : o endereço da interface da startup de back -end, como: http: //192.168.0.xx: 80/v1

cd streamlit-demo

pip install -r requirements.txt

streamlit run streamlit_app.py

from openai import OpenAI

client = OpenAI (

api_key = "EMPTY" ,

base_url = "http://192.168.20.59:7891/v1/" ,

)

# Chat completion API

chat_completion = client . chat . completions . create (

messages = [

{

"role" : "user" ,

"content" : "你好" ,

}

],

model = "gpt-3.5-turbo" ,

)

print ( chat_completion )

# 你好!我是人工智能助手 ChatGLM3-6B,很高兴见到你,欢迎问我任何问题。

# stream = client.chat.completions.create(

# messages=[

# {

# "role": "user",

# "content": "感冒了怎么办",

# }

# ],

# model="gpt-3.5-turbo",

# stream=True,

# )

# for part in stream:

# print(part.choices[0].delta.content or "", end="", flush=True) from openai import OpenAI

client = OpenAI (

api_key = "EMPTY" ,

base_url = "http://192.168.20.59:7891/v1/" ,

)

# Chat completion API

completion = client . completions . create (

model = "gpt-3.5-turbo" ,

prompt = "你好" ,

)

print ( completion )

# 你好!我是人工智能助手 ChatGLM-6B,很高兴见到你,欢迎问我任何问题。 from openai import OpenAI

client = OpenAI (

api_key = "EMPTY" ,

base_url = "http://192.168.20.59:7891/v1/" ,

)

# compute the embedding of the text

embedding = client . embeddings . create (

input = "你好" ,

model = "text-embedding-ada-002"

)

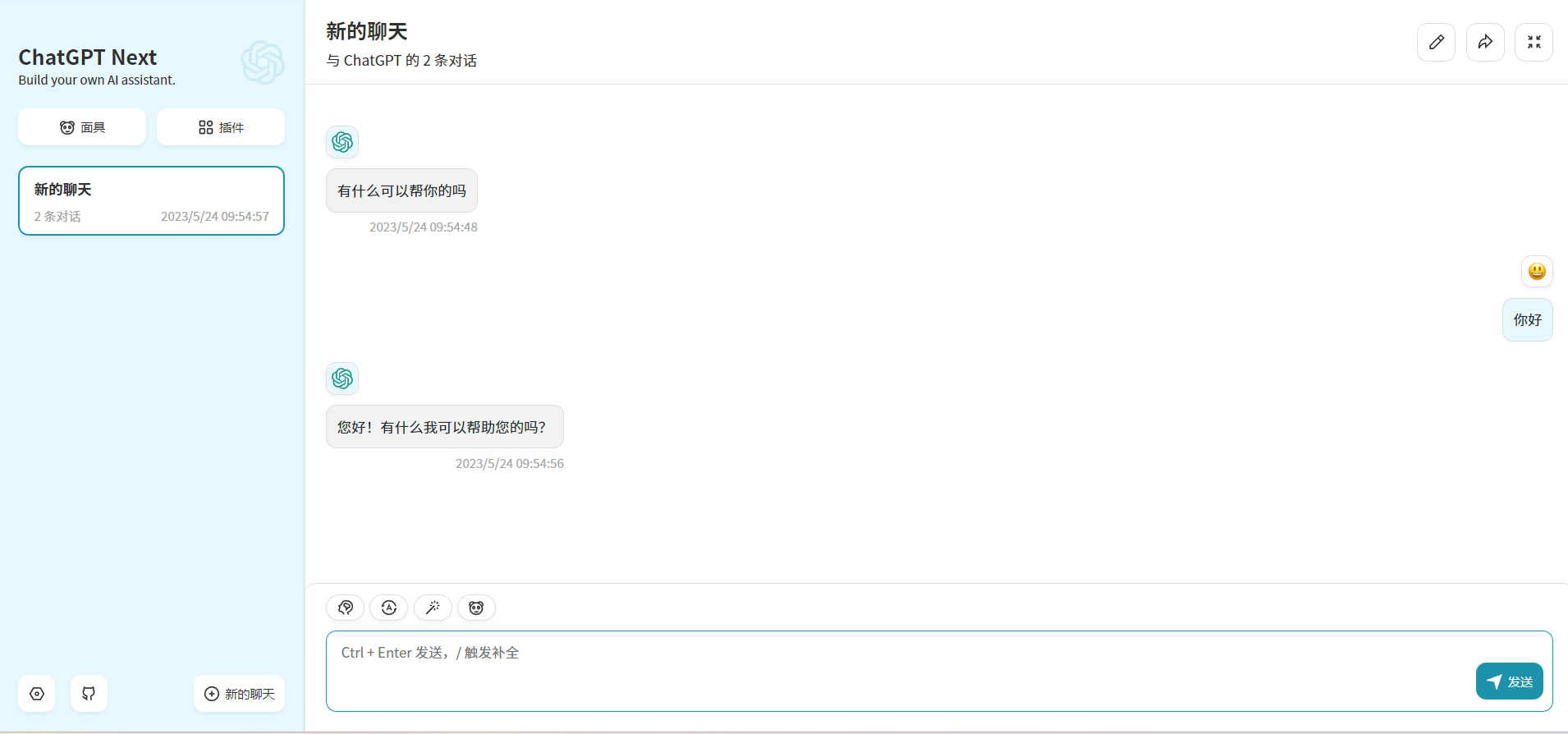

print ( embedding ) Ao modificar OPENAI_API_BASE , a maioria dos aplicativos chatgpt e projetos de front-end podem ser conectados perfeitamente!

docker run -d -p 3000:3000

-e OPENAI_API_KEY= " sk-xxxx "

-e BASE_URL= " http://192.168.0.xx:80 "

yidadaa/chatgpt-next-web

# 在docker-compose.yml中的api和worker服务中添加以下环境变量

OPENAI_API_BASE: http://192.168.0.xx:80/v1

DISABLE_PROVIDER_CONFIG_VALIDATION: ' true '

Este projeto está licenciado sob a licença Apache 2.0 , consulte o arquivo de licença para obter mais informações.

Chatglm: um modelo de linguagem de diálogo bilíngue aberto

Bloom: um modelo de linguagem multilíngue de acesso aberto de 176b-parâmetros

Lhama: modelos de linguagem de fundação abertos e eficientes

Codificação de texto eficiente e eficaz para a lhama e a alpaca chinesa

Phoenix: Democratizando o ChatGPT entre os idiomas

Moss: um modelo de idioma de conversação com plug-in de código aberto

FastChat: uma plataforma aberta para treinamento, servir e avaliar chatbots baseados em modelos de linguagem

Langchain: Construindo aplicações com LLMs através da composibilidade

Chuanhuchatgpt