Recentemente, a turbulência dos projetos OpenAI e sora deixou o mundo exterior preocupado com a movimentada indústria de vídeo de IA.

No final de setembro, Mira Murati, diretora de tecnologia da OpenAI, e Barrett Zoff, vice-presidente de pesquisa, que desempenharam um papel importante no desenvolvimento dos modelos o1, GPT-4o e GPT-4v, Barret Zoph e chefe. o oficial de pesquisa Bob McGrew também anunciou suas saídas.

Em 4 de outubro, o líder do projeto Sora, Tim Brooks, anunciou oficialmente sua renúncia na plataforma social X e ingressou no Google DeepMind.

Se você comer isso junto com o fato de que não há um cronograma definido para a versão oficial de Sora, será como um drama familiar onde a bolha de um projeto estrela estourou e todos no jogo têm seus próprios planos.

Recentemente, a competição de vídeo AI começou a se tornar mais intensa.

De acordo com estatísticas da SimilarWeb, o número total de visitas ao site Luma AI da empresa líder mundial em geração de vídeos de IA em setembro foi de apenas 11,81 milhões de vezes, uma redução mensal de 38,49%. O grande sucesso pika também teve uma queda no total de visitas em setembro. Embora tenha se tornado popular novamente com uma série de novos efeitos de modelo na nova versão em outubro, a questão de como o produto pode continuar a atrair o interesse do usuário surgiu gradualmente.

Alguns inicialmente cautelosos em relação a Sora estão agora sendo reavaliados, como o cineasta Patrick Cederberg, que disse em abril que precisava fazer com que o modelo gerasse centenas de clipes curtos antes que pudesse encontrar um clipe curto disponível. Em outras palavras, Sora é muito difícil de usar.

Felizmente, Tim Brooks não se despediu do vídeo de IA. Ele provavelmente se juntará à ferramenta de geração de vídeo de IA da DeepMind, Veo. A ascensão e queda de Sora podem não ser a única referência para a indústria de vídeo de IA. Pelo menos em termos de capacidades, desafiantes como Meta Movie Gen estão começando a afirmar que mataram Sora. O ecossistema doméstico de produtos de vídeo de IA também vem passando por novas mudanças.

O resfriamento da trilha de vídeo da IA, em outras palavras, também é o período de gestação antes que o próximo lote de produtos melhores seja iterado. Recentemente, parece que um produto suficientemente surpreendente chegou aos olhos do público.

01

PixVerse V3 realmente quebra a barreira dimensional

À medida que os produtos de vídeo de IA no mercado se tornaram tão abundantes que as pessoas estão começando a sentir "fadiga visual", o PixVerse V3 é realmente especial o suficiente?

Se você tiver dúvidas semelhantes, a aparência deste Pikachu é suficiente para dissipar a maioria delas.

Exceto pelas demonstrações em conferências de imprensa que não podem ser reproduzidas, esta é provavelmente a primeira vez que imagens bidimensionais e o mundo real podem interagir de forma tão harmoniosa na geração de vídeo por IA.

Na foto, a imagem desse Pikachu é exatamente a mesma que lembramos do desenho animado, mas ele apareceu em uma rua muito movimentada e depois pulou nos braços de um irmão mais novo.

Este é o prompt necessário para este vídeo:

Câmera frontal central: Pikachu está em uma rua movimentada da cidade, ao lado de um mochileiro. O mochileiro passa pela câmera e Pikachu corre por trás. Pulou nos braços do mochileiro. Pikachu abraçou alegremente seu pescoço e ficou bem perto. Os pedestres se apressaram e os mochileiros carregaram Pikachu para frente, cujas bochechas brilhavam de excitação, iluminando o momento. Charmoso e sem esforço.

Em 1934, "Hollywood Party" produzida pela MGM, a ação de Jimmy Durant de segurar o "Mickey Mouse" com os dedos tornou-se a primeira cena clássica da história do cinema mundial que combinou desenhos animados e imagens reais 90 anos depois, este Efeitos que estão cheios. de engenhosidade, mas extremamente complicado de implementar, pode finalmente ser feito pela IA.

O que é ultrajante é que Pikachu foi feito pela IA, e o mundo real onde Pikachu vive também foi feito pela IA. A julgar pelos efeitos, o Pixverse V3 tem uma compreensão muito suave da entrada da animação no mundo real.

Além do Pikachu, você também pode usar o seguinte prompt, que parece ter muitos elementos, para gerar um vídeo do Tio Mario entrando na estação de trem:

O vídeo mostra uma estação de trem movimentada repleta de uma multidão diversificada de passageiros esperando ansiosamente por seus trens. A câmera percorre a cena, capturando a atmosfera animada de Super Mario, um robusto personagem italiano com rosto redondo, vestindo seu icônico chapéu vermelho. macacão azul. A câmera segue Mario de perto enquanto ele sobe com confiança na plataforma, com o rosto radiante de entusiasmo. O vídeo tem um estilo realista.

No vídeo, a estação ferroviária está repleta de passageiros de todos os tipos esperando ansiosamente pelo trem. A câmera percorre a cena, capturando a atmosfera animada. À medida que o trem se aproxima lentamente da plataforma, a câmera segue o personagem italiano alto e de rosto redondo, Super Mario. Usando seu icônico chapéu vermelho e macacão azul, ele caminha confiantemente para a plataforma com um sorriso animado no rosto. O estilo do vídeo é muito realista.

Há um protagonista distinto, Mario, na imagem. Cada uma das multidões movimentadas atrás dele tem diferentes detalhes de seus movimentos. À medida que Mario avança ao longo da câmera, as bordas onde os personagens animados se cruzam com o ambiente real também são tratadas com muita clareza. e de forma limpa, ao mesmo tempo, o trem também entrou na estação.

Se os personagens de desenhos animados não conseguem satisfazer seu apetite, vamos dar uma olhada no desempenho do PixVerse V3 em grandes cenas.

——Palavras-chave: O dragão adormece.

O prompt completo é assim:

Foto de rastreamento Steadycam de um dragão mergulhando na água, o monge levanta os braços em agradecimento.

Rastreamento Steadicam: Um dragão mergulha na água e um monge levanta os braços em agradecimento.

Embora o vídeo ainda careça de alguns dos detalhes mencionados em Prompt, no geral, seja a consistência do movimento da câmera, a capacidade de usar tons sombrios para expressar sutilmente a tensão da imagem, e o uso de monstros distantes e abandonados carros em primeiro plano Os recursos de geração de vídeo do PixVerse V3 começaram a se aproximar da qualidade de imagem do filme.

Além dos vídeos Vincent, desta vez o PixVerse V3 também demonstrou excelentes recursos de vídeo baseados em imagem.

O vídeo de Tusheng é muito imaginativo. Você pode tentar encontrar um belo pôster de filme de faroeste americano, adicionar um aviso e deixá-lo fazer algumas coisas "ultrajantes" - como encontrar um Revolver de baixa qualidade.

O prompt é assim:

O prompt completo é assim:

A pistola falha com fumaça preta, o que suja o rosto do homem.

A pistola falhou e saiu fumaça preta, manchando o rosto do homem.

A sensação mais distinta do PixVerse V3 em termos de recursos de vídeo Wensheng e vídeo Tusheng é que ele está extremamente próximo dos pontos de interesse da vida cotidiana das pessoas comuns. Na verdade, com exceção dos profissionais relacionados à criação de vídeos, poucas pessoas têm a necessidade de usar software de vídeo de IA para criar um trabalho perfeito de cinema e televisão. Pelo contrário, mais pessoas que acabaram de usar a capacidade de geração de vídeo estão curiosas para saber se essa capacidade pode ser reproduzida com o mundo real ou até com elas mesmas. Por exemplo, você pode apresentar seus personagens de desenhos animados favoritos nos lugares onde você sai todos os dias, ou até mesmo se transformar em personagens de desenhos animados como o Homem de Ferro.

Muitas das dificuldades encontradas atualmente pelos produtos de vídeo de IA devem-se ao facto de estarem presos à autopromoção de capacidades técnicas e os utilizadores terem desaparecido. Nesta fase, quando a tecnologia de vídeo Vincent acaba de surgir, o que a maioria das pessoas comuns pode gostar é de um produto de vídeo de IA que seja próximo o suficiente e amigável o suficiente.

Dessa perspectiva, o atual PixVerse V3 pode ser o produto que adivinha com mais precisão a mente do usuário.

A maravilha do PixVerse V3 não se deve apenas aos recursos iterativos do grande modelo de vídeo AI por trás do PixVerse V3, mas também à otimização dos recursos de compreensão imediata de palavras. Acredito que pessoas cuidadosas terão notado isso depois de ver os exemplos de prompt acima.

"Assunto + Descrição do Assunto + Movimento + Ambiente" é uma fórmula Prompt que maximiza a eficácia da geração de vídeo AI. Em comparação com a V2.5, agora você pode adicionar uma dimensão de "descrição da cena" ao PixVerse V3.

É claro que, além de seguir essa fórmula, Prompt precisa descrever as ações do personagem com o máximo de detalhes possível e evitar descrições simplificadas demais.

Ao mesmo tempo, o PixVerse V3 também possui uma seleção mais rica de vídeos de saída. Em termos de formatos de vídeo de saída, o PixVerse V3 suporta uma variedade de proporções de vídeo, incluindo 16:9, 9:16, 3:4, 4:3 e 1. :1., a função de estilização também foi atualizada após esta atualização de versão. Agora, os dois modos de Vincent Video e Tusheng Video suportam quatro opções de estilo de animação, realidade, argila e 3D.

Em uma palavra, o PixVerse V3 não só é mais forte desta vez, como também quer colocar descrições de produtos em suas mãos, linha por linha.

Na plataforma social X, muitos seguidores de produtos de IA começaram a usar o PixVerse V3, como Pierrick Chevallier, que tem muitos fãs. Ele até montou uma postagem dedicada para mostrar os vídeos que gerou usando o PixVerse V3. Além de sua poderosa capacidade de geração, o que chama a atenção é que ele mostra muitos vídeos com “sabor de Halloween”.

02

Neste Halloween, deixe o PixVerse V3 fazer os “efeitos”

Para romper o círculo de um produto de vídeo de IA bastante interessante, além de ter suporte técnico suficiente, ele também precisa de uma boa oportunidade. Falando nisso, o lançamento do PixVerse V3 chega na hora certa.

1º de novembro é o Halloween, e este momento no final de outubro é o auge anual da imaginação dos jovens. Em conjunto com o tema Halloween, o PixVerse V3 lançou uma série de modelos com tema Halloween, permitindo que você use IA para “lançar feitiços” em tudo ao seu redor.

Há um total de 8 modelos com tema de Halloween lançados no PixVerse V3 desta vez, um dos quais se concentra em "Transformação em uma Pessoa Viva".

Por exemplo, um monstro aparece do nada na cidade.

Além dessas cenas grandes, o PixVerse V3 pode tornar os elementos de uma foto "vivos" diretamente, como fazer o cachorrinho em "Estou esperando por você na chuva" realmente sair da foto:

O cachorrinho ainda tem um movimento natural de levantar a cabeça antes de se levantar. Depois de sair da foto, a foto original só deixou um gramado calmo, e todo o efeito ficou deslumbrante.

Este modelo também possui uma jogabilidade mais imaginativa. Por exemplo, pode-se permitir que o Homem Vitruviano nas obras de Leonardo da Vinci saia do círculo que o enquadra?

Algo assim:

Poder fazer um show desses no Halloween é o suficiente para surpreender o público.

Desta vez, o segundo tipo de template preparado pelo PixVerse V3 para o Halloween segue o caminho abstrato.

Por exemplo, deixe uma caixa de ferro se levantar e fugir:

Ou quebre um Porsche em pedaços e transforme-o em uma pilha de blocos:

Claro, desta vez os modelos do PixVerse V3 também têm muitos mais efeitos de Halloween que podem ser reproduzidos, como colocar um chapéu de mago na foto de um personagem e depois movê-lo, assim:

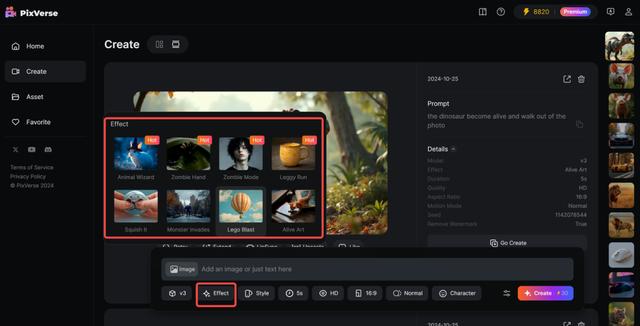

Esses modelos de Halloween estão incluídos no novo recurso Effect do PixVerse V3. É muito simples de usar. Após fazer o upload da imagem, selecione o efeito desejado e clique para gerá-lo. Não precisa se preocupar em inserir prompts no meio.

Desta vez, o PixVerse V3 mostra recursos de geração multimodal mais fortes. Com base em seu próprio vídeo Wensheng e vídeo Tusheng, o PixVerse V3 agora pode fazer com que o vídeo gerado carregue o conteúdo de som que o usuário deseja e, se o vídeo original não for longo o suficiente, o PixVerse V3 agora. tem a capacidade de criar continuações adicionais do vídeo original.

Esses recursos de geração multimodal também se tornaram dois novos recursos estreando no PixVerse V3 junto com o Effect. A primeira função é Lipsync, uma função de sincronização labial que pode gerar vozes sincronizadas de personagens multilíngues para vídeos.

A função Lipsync permite que os usuários insiram seus próprios direitos autorais ou carreguem arquivos de áudio com base no vídeo gerado e, em seguida, o PixVerse adaptará automaticamente o formato da boca dos personagens do vídeo com base nos direitos autorais ou no conteúdo do arquivo de áudio. Atualmente, o Lipsync pode suportar vídeos com duração de 30 segundos e os idiomas que podem sincronizar os lábios incluem inglês, chinês, francês e japonês.

Outra função é estender o vídeo, ou pode ser entendido como uma continuação da história.

Em resposta ao problema de que a duração do vídeo gerado atualmente é muito curta, no PixVerse V3, os usuários podem selecionar o vídeo gerado, clicar no botão "Estender", inserir palavras de aviso relacionadas a como desenvolver ainda mais o vídeo, clicar em "criar ", e o vídeo original será A direção proposta alcança a progressão da trama, mantendo um alto grau de coerência entre os personagens e ações.

Com a adição de recursos de geração de vídeo multimodal, o PixVerse V3 agora pode gerar vídeos de IA com narrativas maiores e melhores efeitos audiovisuais, e os limites da criação de vídeos de IA foram ainda mais ampliados.

Crie um produto de vídeo de IA que seja verdadeiramente reproduzível

“O momento do ChatGPT será quando os usuários comuns poderão usá-lo”, disse Wang Changhu, fundador e CEO da Aishi Technology, em uma entrevista em abril deste ano.

Nos últimos dois anos, cada novo vislumbre de tecnologia de modelos em grande escala foi transformado em novas grandes narrativas sobre métodos de produção, como se a vida humana fosse completamente subvertida num curto período de tempo. Mas até agora isso não aconteceu.

Ao mesmo tempo, o entusiasmo trazido por Sora e a imaginação técnica excessivamente ambiciosa fizeram gradualmente com que todo o campo dos produtos de vídeo de IA perdesse o foco e não encontrasse nenhuma ligação com a vida pública. Portanto, por um lado, produtos de vídeo de IA como Runway, que são posicionados como ferramentas profissionais, são difíceis de sair do círculo devido ao alto limite de uso. Por outro lado, produtos que estão posicionados mais para o geral. o público caiu no dilema de "queimar depois de ler" depois de ser experimentado por todos os usuários Depois que a novidade passa, é difícil reter o produto. O produto carece de ideias de desenvolvimento claras e específicas, por isso não tem escolha a não ser afundar. a lógica simples da “filtragem” e dos “efeitos especiais”.

Em outras palavras, a enorme abertura das capacidades de geração de IA faz com que quase todos os produtos atuais no campo do vídeo de IA pareçam algum tipo de produto semiacabado. A aleatoriedade e a incontrolabilidade do conteúdo gerado são empacotadas em uma experiência nova, o que também significa. que é difícil de usar no campo usado em um cenário específico e persistente.

Assim como quando o mundo exterior ficou impressionado com a capacidade de geração de balões de Sora, Patrick Cederberg ficou preocupado com a falta de consistência na geração de conteúdo de Sora. Ele reclamou que a cor dos balões mudaria a cada geração, e essas imperfeições significam muito. do trabalho de pós-produção ainda é inevitável. Existem muitos problemas semelhantes, e é por isso que, embora Hollywood tenha começado a atacar há um ano pela potencial perturbação da indústria cinematográfica por parte dos grandes modelos, um ano depois, a sora ainda não consegue realmente entrar no fluxo de trabalho do cinema e da televisão.

Atualmente, os produtos de vídeo de IA estão mais ou menos presos em uma situação semelhante - embora os recursos de geração de vídeo de IA tenham entusiasmado a todos há muito tempo, os produtos de geração de vídeo de IA ainda são um belo “show de vendas”.

Diante da nova torrente tecnológica, é difícil que um produto permaneça “concreto”. No entanto, o que a Aishi Technology forneceu da versão web original do PixVerse para o PixVerse V3 atual é um caminho de iteração raro, claro e ordenado.

Em janeiro deste ano, a Aishi Technology lançou oficialmente a versão web do PixVerse, um produto de vídeo PixVerse. Mas naquela época, incluindo o PixVerse, o problema encontrado por quase todos os produtos de vídeo Wensheng era que as imagens geradas eram incontroláveis, o que significava que os usuários não podiam gerar continuamente conteúdo de vídeo em torno de um personagem unificado. Três meses depois, a versão web do PixVerse foi equipada com a função C2V (Character to Video) desenvolvida com base no grande modelo de vídeo autodesenvolvido, que inicialmente resolveu o problema de consistência na criação de vídeo por IA, extraindo com precisão os recursos do personagem para bloqueá-lo.

Depois de fixar o “papel” no vídeo, o PixVerse concentrou as iterações subsequentes na “controlabilidade” do comportamento no conteúdo gerado. Em junho deste ano, a Aishi Technology lançou o pincel de movimento Magic Brush. Os usuários podem controlar com precisão o movimento e a direção de cada elemento simplesmente espalhando os elementos na tela do vídeo. O PixVerse V2 foi lançado no final de julho. Além de mostrar bastante controle sobre o conteúdo gerado, a dificuldade dos prompts também foi significativamente reduzida. Ao mesmo tempo, os meios de ajuste fino dos efeitos gerados tornaram-se mais abundantes.

Esta é outra iteração com intenções muito claras – “A forma específica do produto precisa ser testada, mas no final ainda esperamos servir a maioria dos usuários comuns”, como disse Wang Changhu em uma entrevista anterior.

Quando os recursos de geração de vídeo não conseguem atender diretamente às necessidades dos usuários comuns, servir criadores profissionais e desenvolver ferramentas de próxima geração baseadas em novos paradigmas de geração de conteúdo é uma prioridade maior. "Quando os fatores de produção são incluídos pela tecnologia - por exemplo, a IA substitui atores, cenas e câmeras durante as filmagens - então os recursos de geração de vídeo da IA podem começar a ser usados pelo público, e o círculo de usuários se expandirá gradualmente, criando enormes oportunidades. "

Desta vez, o PixVerse 3V começou a tentar introduzir mais jogabilidade relacionada à vida das pessoas comuns, e tentou usar o Prompt para configurar a lente. Este último pode ser visto como uma tentativa de substituir parcialmente a câmera. Deste ponto de vista, a Aishi Technology tem trilhado um caminho muito determinado no aprimoramento da direção de seu produto.

Na onda tecnológica de geração de vídeo de IA, onde a divergência é a beleza, a escolha da Aishi Technology é ir contra a tendência geral, ficar longe de grandes narrativas e fornecer o plano mais específico sobre como os produtos de vídeo de IA podem ser reproduzidos.

Somente quando as pessoas puderem segurá-lo em suas mãos e brincar com ele o máximo possível, o aplicativo de vídeo de IA poderá fazer a transição de um “show de vendedores” liderado por Sora para um vibrante “show de compradores”.

A impressionante estreia do PixVerse V3 pode ser o início de outra mudança positiva por trás desse “esfriamento” dos vídeos de IA.