A Meta Platforms lançou uma nova versão simplificada do modelo Llama, Llama 3.21B e 3B, que permite a operação estável de modelos de linguagem em larga escala em smartphones e tablets comuns. O editor de Downcodes explicará detalhadamente esse progresso revolucionário e seu significado.

A Meta Platforms lançou hoje uma nova versão simplificada de seu modelo Llama, incluindo os produtos Llama3.21B e 3B, que pela primeira vez permitiram a operação estável de modelos de linguagem em larga escala em smartphones e tablets comuns. Ao integrar de forma inovadora tecnologia de treinamento quantitativo e algoritmos de otimização, a nova versão reduz o tamanho do arquivo em 56%, reduz os requisitos de memória em execução em 41% e aumenta a velocidade de processamento para 4 vezes a da versão original, mantendo a qualidade de processamento contínuo original. Texto de 8.000 caracteres.

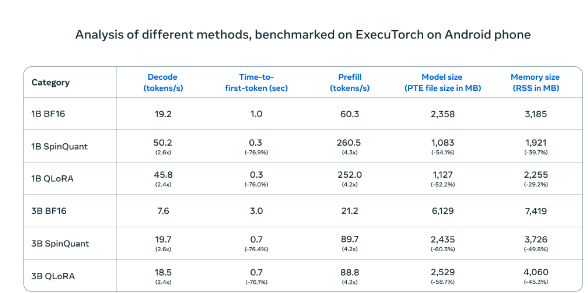

Quando testados em telefones Android, os modelos de IA compactados do Meta (SpinQuant e QLoRA) foram significativamente mais rápidos e eficientes do que as versões padrão. Modelos menores rodam quatro vezes mais rápido e usam menos memória

No teste real do telefone celular OnePlus12, esta versão compactada mostrou desempenho comparável à versão padrão e, ao mesmo tempo, melhorou muito a eficiência operacional, resolvendo efetivamente o problema de longo prazo de poder de computação insuficiente dos dispositivos móveis. A Meta optou por adotar uma estratégia de mercado de cooperação aberta e realizar uma cooperação profunda com os principais fabricantes de processadores móveis, como Qualcomm e MediaTek. A nova versão será lançada simultaneamente através do site oficial da Llama e da plataforma Hugging Face, proporcionando aos desenvolvedores acesso conveniente. canais.

Esta estratégia contrasta fortemente com outros gigantes do setor. Quando o Google e a Apple optam por integrar profundamente novas tecnologias aos seus sistemas operacionais, a rota aberta do Meta oferece aos desenvolvedores maior espaço para inovação. Este lançamento marca a mudança nos modelos de processamento de dados de servidores centralizados para terminais pessoais. As soluções de processamento local podem não apenas proteger melhor a privacidade do usuário, mas também fornecer uma experiência de resposta mais rápida.

Este avanço tecnológico pode desencadear grandes mudanças semelhantes às que ocorreram durante a popularização dos computadores pessoais, embora ainda enfrente desafios como os requisitos de desempenho dos dispositivos e a seleção da plataforma do desenvolvedor. À medida que o desempenho dos dispositivos móveis continua a melhorar, as vantagens das soluções de processamento localizado surgirão gradualmente. A Meta espera promover o desenvolvimento de toda a indústria em uma direção mais eficiente e segura por meio da cooperação aberta e abrir novos caminhos para o desenvolvimento futuro de aplicações para dispositivos móveis.

A versão simplificada do modelo Llama traz novas possibilidades para aplicações móveis de IA, e também vale a pena aprender com a indústria a sua estratégia de cooperação aberta. No futuro, à medida que a tecnologia continua a amadurecer e a tornar-se mais popular, o processamento localizado de IA tornar-se-á uma tendência dominante.