O editor do Downcodes soube que a Hugging Face lançou hoje o SmolLM2, uma série de modelos de linguagem compactos que impressionam em termos de desempenho e exigem muito menos recursos computacionais do que modelos grandes. Esta é, sem dúvida, uma boa notícia para os desenvolvedores que desejam implantar aplicativos de IA em dispositivos com recursos limitados. SmolLM2 é lançado sob a licença Apache 2.0 e fornece três modelos com diferentes tamanhos de parâmetros, que podem ser adaptados de forma flexível a vários cenários de aplicação.

A Hugging Face lançou hoje o SmolLM2, um novo conjunto de modelos de linguagem compactos que alcançam desempenho impressionante e exigem muito menos recursos computacionais do que modelos maiores. O novo modelo é lançado sob a licença Apache 2.0 e vem em três tamanhos – parâmetros 135M, 360M e 1,7B – adequados para implantação em smartphones e outros dispositivos de ponta com poder de processamento e memória limitados.

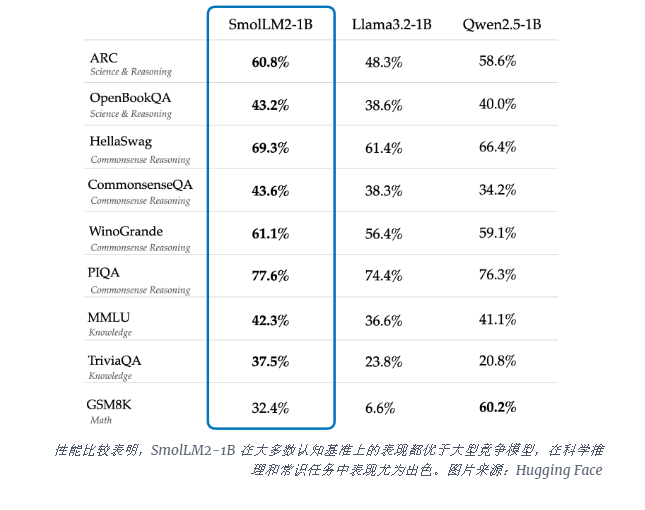

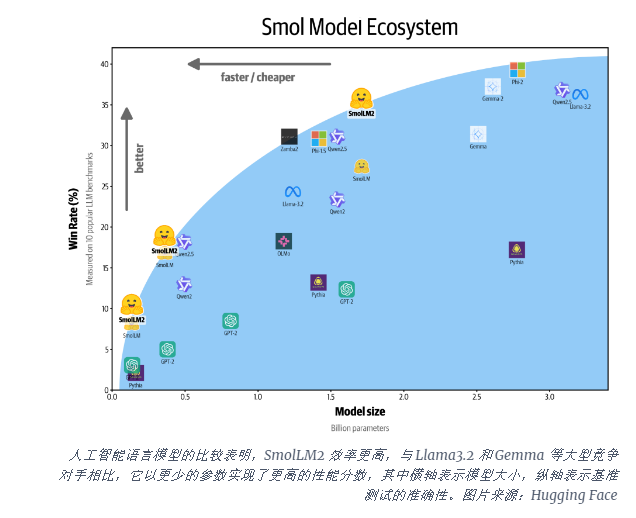

O modelo SmolLM2-1B supera o modelo Llama1B da Meta em vários benchmarks importantes, particularmente com bom desempenho em raciocínio científico e tarefas de bom senso. O modelo supera grandes modelos concorrentes na maioria dos benchmarks cognitivos, usando uma combinação diversificada de conjuntos de dados, incluindo FineWeb-Edu e conjuntos de dados especializados de matemática e codificação.

O lançamento do SmolLM2 chega em um momento crítico, à medida que a indústria de IA enfrenta as demandas computacionais da execução de grandes modelos de linguagem (LLMs). Embora empresas como a OpenAI e a Anthropic continuem a ultrapassar os limites da escala do modelo, há um reconhecimento crescente da necessidade de uma IA leve e eficiente que possa ser executada nativamente no dispositivo.

O SmolLM2 oferece uma abordagem diferente para trazer capacidades poderosas de IA diretamente para dispositivos pessoais, apontando para um futuro onde ferramentas avançadas de IA estarão disponíveis para mais usuários e empresas, não apenas para gigantes da tecnologia com data centers massivos. Esses modelos suportam uma variedade de aplicações, incluindo reescrita de texto, resumo e chamada de função, e são adequados para implantação em cenários onde restrições de privacidade, latência ou conectividade tornam impraticáveis soluções de IA baseadas em nuvem.

Embora estes modelos mais pequenos ainda tenham limitações, representam parte de uma tendência mais ampla em direção a modelos de IA mais eficientes. O lançamento do SmolLM2 mostra que o futuro da inteligência artificial pode não pertencer apenas a modelos cada vez maiores, mas a arquiteturas mais eficientes que podem fornecer desempenho poderoso com menos recursos.

O surgimento do SmolLM2 oferece novas possibilidades para o desenvolvimento de aplicações leves de IA e também indica que a tecnologia de IA se tornará mais popular e beneficiará mais usuários. O editor do Downcodes acredita que modelos de IA mais eficientes e com baixo consumo de recursos surgirão no futuro para promover o desenvolvimento de tecnologia de inteligência artificial.