O editor de Downcodes vai levar você a entender a tecnologia Google ReCapture e como essa tecnologia disruptiva vai mudar a edição de vídeos! O ReCapture permite que usuários comuns realizem facilmente ajustes de movimento da câmera de nível profissional, redesenhem a linguagem da lente de vídeo e tragam mudanças revolucionárias na pós-produção de vídeo. Esta tecnologia não depende mais dos métodos tradicionais de representação intermediária 4D, mas utiliza habilmente o conhecimento de movimento de modelos de vídeo generativos para transformar a edição de vídeo em um processo de conversão de vídeo para vídeo, simplificando bastante o processo de operação e mantendo as características dos detalhes do vídeo. e qualidade de imagem.

A mais recente tecnologia ReCapture lançada pela equipe de pesquisa do Google está subvertendo o método tradicional de edição de vídeo. Esta inovação permite que usuários comuns implementem facilmente ajustes de movimento da câmera de nível profissional e redesenhem a linguagem da lente para vídeos já capturados.

Na pós-produção de vídeo tradicional, alterar o ângulo da câmera de um vídeo capturado sempre foi um problema técnico. Quando as soluções existentes lidam com diferentes tipos de conteúdo de vídeo, muitas vezes é difícil manter efeitos complexos de movimento de câmera e detalhes de imagem ao mesmo tempo. O ReCapture adota uma abordagem diferente e não usa o método tradicional de representação intermediária 4D. Em vez disso, ele usa habilmente o conhecimento de movimento armazenado no modelo de vídeo generativo e redefine a tarefa como um processo de conversão de vídeo para vídeo por meio da difusão de vídeo estável.

O sistema usa um fluxo de trabalho em dois estágios. O primeiro estágio gera o vídeo âncora, que é a versão inicial de saída com a nova posição da câmera. Este estágio pode ser alcançado criando vídeos multiângulos por meio de modelos de difusão como CAT3D, ou por estimativa de profundidade quadro a quadro e renderização de nuvem de pontos. Embora esta versão possa ter algumas inconsistências de tempo e falhas visuais, ela lançou as bases para a Fase Dois.

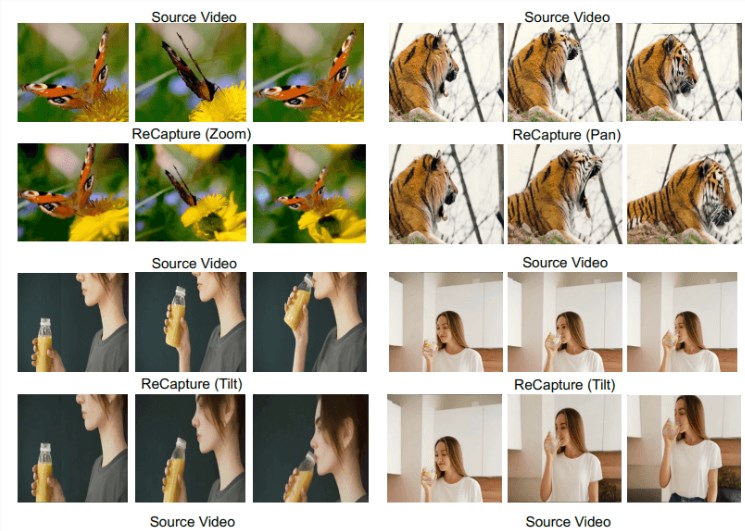

O segundo estágio aplica o ajuste fino de vídeo mascarado, aproveitando um modelo de vídeo generativo treinado em imagens existentes para criar efeitos de movimento realistas e alterações de tempo. O sistema introduz uma camada temporal LoRA (Low Rank Adaptation) para otimizar o modelo para que ele possa compreender e replicar as características dinâmicas específicas dos vídeos âncora sem retreinar todo o modelo. Ao mesmo tempo, a camada espacial LoRA garante que os detalhes e o conteúdo da imagem sejam consistentes com o novo movimento da câmera. Isso permite que o modelo de vídeo generativo conclua operações como zoom, panorâmica e inclinação, mantendo o movimento característico do vídeo original.

Embora o ReCapture tenha feito progressos importantes no processamento de vídeo amigável, ele ainda está em fase de pesquisa e ainda está um pouco longe da aplicação comercial. Vale a pena notar que, embora o Google tenha muitos projetos de IA de vídeo, ainda não os trouxe ao mercado. Entre eles, o projeto Veo pode ser o mais próximo do uso comercial. Da mesma forma, o modelo Movie-Gen lançado recentemente pela Meta e o Sora da OpenAI lançado no início do ano ainda não foram comercializados. Atualmente, o mercado de IA de vídeo é liderado principalmente por startups como a Runway, que lançou seu mais recente modelo Gen-3Alpha no verão passado.

O surgimento da tecnologia ReCapture anuncia a direção futura do desenvolvimento no campo da edição de vídeo. Embora ainda esteja em fase de pesquisa, suas funções poderosas e métodos de operação convenientes trarão, sem dúvida, mais possibilidades para a criação de vídeo. Esperamos a maturidade precoce e a aplicação comercial desta tecnologia no futuro, trazendo uma experiência de edição de vídeo mais conveniente e eficiente para a maioria dos usuários.