O editor do Downcodes aprendeu que a equipe Tongyi Qianwen abriu recentemente o código-fonte de sua mais recente série completa de modelos Qwen2.5-Coder, o que marca outro marco no campo de grandes modelos de código aberto. Os modelos da série Qwen2.5-Coder atraíram muita atenção devido às suas poderosas capacidades de codificação, diversas funções e praticidade conveniente. Eles demonstraram excelente desempenho na geração, reparo e raciocínio de código, fornecendo aos desenvolvedores ferramentas poderosas para promover o desenvolvimento do código aberto. LLMs. O código aberto desta série de modelos promoverá enormemente a aplicação e inovação da tecnologia de inteligência artificial no campo da programação.

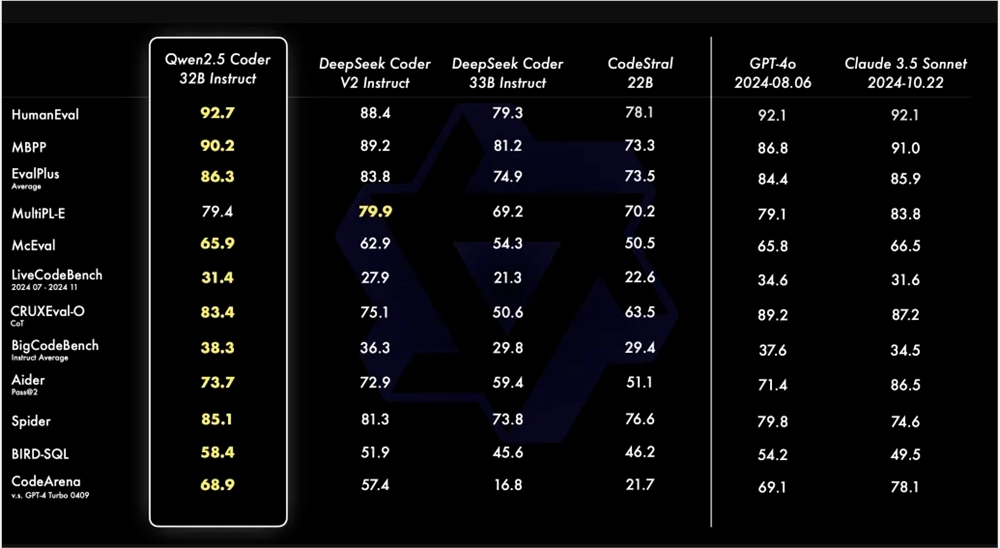

A equipe Tongyi Qianwen anunciou recentemente que abrirá o código de sua mais recente série Qwen2.5-Coder. Este movimento visa promover o desenvolvimento de LLMs de código aberto. Qwen2.5-Coder tem atraído atenção por seu poder, diversidade e praticidade. O modelo Qwen2.5-Coder-32B-Instruct atingiu o nível SOTA em termos de capacidades de código, que é equivalente ao GPT-4o, mostrando capacidades abrangentes, incluindo geração de código, reparo de código e raciocínio de código. Ele alcança desempenho superior em vários benchmarks de geração de código e atinge uma pontuação de 73,7 no benchmark Aider, que é comparável ao GPT-4o.

Qwen2.5-Coder suporta mais de 40 linguagens de programação e obteve 65,9 pontos no McEval, com linguagens como Haskell e Racket apresentando desempenho particularmente bom. Isso se deve à limpeza e correspondência exclusiva de dados na fase de pré-treinamento. Além disso, o Qwen2.5-Coder-32B-Instruct também tem um bom desempenho em recursos de reparo de código em diversas linguagens de programação, pontuando 75,2 no benchmark MdEval, ficando em primeiro lugar.

Para testar o desempenho de alinhamento do Qwen2.5-Coder-32B-Instruct nas preferências humanas, um benchmark de avaliação de preferência de código anotado internamente, Code Arena, foi construído. Os resultados mostram que Qwen2.5-Coder-32B-Instruct tem vantagens no alinhamento preferido.

A série Qwen2.5-Coder tem modelos de código aberto em quatro tamanhos desta vez, incluindo 0,5B/3B/14B/32B, cobrindo os seis tamanhos de modelos convencionais para atender às necessidades de diferentes desenvolvedores. O oficial fornece dois modelos: Base e Instruct. O primeiro serve como base para os desenvolvedores ajustarem o modelo, e o último serve como modelo de chat oficialmente alinhado. Existe uma correlação positiva entre o tamanho do modelo e o desempenho, e o Qwen2.5-Coder atinge desempenho SOTA em todos os tamanhos.

O modelo 0,5B/1,5B/7B/14B/32B do Qwen2.5-Coder adota a licença Apache2.0, enquanto o modelo 3B é licenciado apenas para pesquisa. A equipe verificou a eficácia dos LLMs Scaling on Code avaliando o desempenho do Qwen2.5-Coder de diferentes tamanhos em todos os conjuntos de dados.

O código aberto do Qwen2.5-Coder oferece aos desenvolvedores uma escolha de modelo de programação poderosa, diversificada e prática, ajudando a promover o desenvolvimento e a aplicação de modelos de linguagem de programação.

Link do modelo do codificador Qwen2.5:

https://modelscope.cn/collections/Qwen25-Coder-9d375446e8f5814a

Resumindo, o código aberto do Qwen2.5-Coder traz uma ferramenta poderosa para os desenvolvedores, e seu excelente desempenho e ampla aplicabilidade promoverão enormemente o desenvolvimento do campo de geração e programação de código. Esperamos que o Qwen2.5-Coder possa desempenhar um papel em mais cenários de aplicação no futuro.