Um novo estudo do MIT revelou semelhanças impressionantes entre a estrutura interna dos grandes modelos de linguagem (LLMs) e o cérebro humano, desencadeando um acalorado debate no campo da inteligência artificial. O editor do Downcodes explicará em detalhes as descobertas inovadoras desta pesquisa e sua importância para o desenvolvimento futuro da IA. Através de uma análise aprofundada do espaço de ativação do LLM, os pesquisadores descobriram recursos estruturais de três níveis. A descoberta desses recursos nos ajudará a entender melhor o mecanismo de funcionamento do LLM e fornecerá novas direções para o desenvolvimento da futura tecnologia de IA.

A IA realmente começou a "desenvolver um cérebro"?! A pesquisa mais recente do MIT mostra que a estrutura interna de um grande modelo de linguagem (LLM) é surpreendentemente semelhante ao cérebro humano!

Este estudo usou tecnologia de autoencoder esparso para conduzir uma análise aprofundada do espaço de ativação do LLM e descobriu três níveis de recursos estruturais, que são surpreendentes:

Primeiro, no nível microscópico, os pesquisadores descobriram a existência de estruturas semelhantes a “cristalinas”. As faces desses “cristais” são compostas de paralelogramos ou trapézios, semelhantes a analogias de palavras familiares, como “homem:mulher::rei:rainha”.

O que é ainda mais surpreendente é que essas estruturas “cristalinas” se tornam mais claras após a remoção de alguns fatores de interferência irrelevantes (como o comprimento da palavra) através de técnicas de análise discriminante linear.

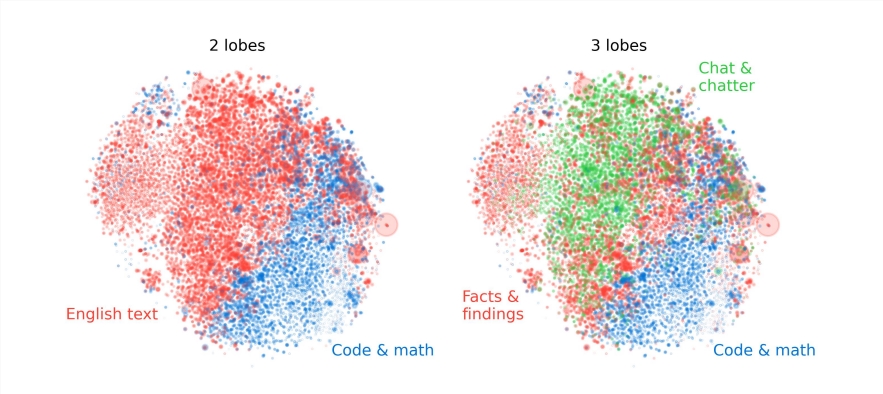

Em segundo lugar, a nível meso, os investigadores descobriram que o espaço de activação do LLM tem uma estrutura modular semelhante às divisões funcionais do cérebro humano.

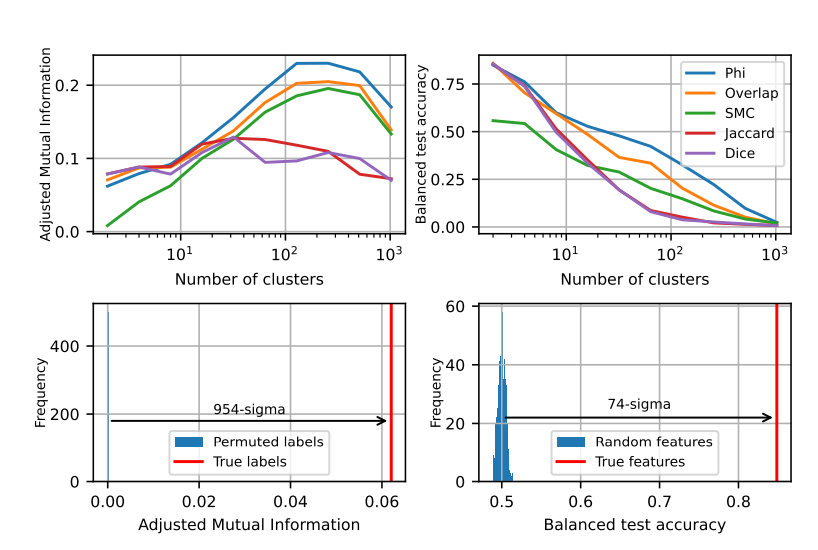

Por exemplo, recursos relacionados à matemática e à codificação agrupam-se para formar um “lóbulo” semelhante aos lobos funcionais do cérebro humano. Através da análise quantitativa de múltiplos indicadores, os investigadores confirmaram a localização espacial destes “lóbulos”, mostrando que as características co-ocorrentes também estão mais agrupadas espacialmente, muito além do que seria esperado de uma distribuição aleatória.

No nível macro, os pesquisadores descobriram que a estrutura geral da nuvem de pontos característicos do LLM não é isotrópica, mas apresenta uma distribuição de autovalores de lei de potência, e essa distribuição é mais óbvia na camada intermediária.

Os pesquisadores também analisaram quantitativamente a entropia de agrupamento de diferentes níveis e descobriram que a entropia de agrupamento da camada intermediária era menor, indicando que a representação de recursos era mais concentrada, enquanto a entropia de agrupamento das camadas iniciais e finais era maior, indicando que o recurso a representação era mais dispersa.

Esta pesquisa nos fornece uma nova perspectiva sobre a compreensão dos mecanismos internos de grandes modelos de linguagem e também estabelece as bases para o desenvolvimento de sistemas de IA mais poderosos e inteligentes no futuro.

O resultado desta pesquisa é emocionante, pois não apenas aprofunda nossa compreensão dos modelos de linguagem em grande escala, mas também aponta uma nova direção para o desenvolvimento futuro da inteligência artificial. O editor do Downcodes acredita que com o avanço contínuo da tecnologia, a inteligência artificial mostrará seu forte potencial em mais áreas e trará um futuro melhor para a sociedade humana.