GPT-4V, artefato conhecido como “olhar fotos e falar”, tem sido criticado por sua falta de compreensão de interfaces gráficas. É como uma pessoa “cega à tela” que muitas vezes clica nos botões errados, o que é enlouquecedor. No entanto, espera-se que o modelo OmniParser lançado pela Microsoft resolva completamente este problema! OmniParser é como um “tradutor de tela”, convertendo capturas de tela na linguagem estruturada de fácil compreensão do GPT-4V, tornando a “visão” do GPT-4V mais nítida. O editor de Downcodes levará você a ter uma compreensão profunda deste modelo mágico, ver como ele ajuda o GPT-4V a superar o defeito da "cegueira ocular" e a incrível tecnologia por trás dele.

Você ainda se lembra do GPT-4V, um artefato conhecido como “olhar fotos e falar” Ele pode entender o conteúdo das fotos e realizar tarefas com base nas fotos. É uma bênção para os preguiçosos! fraqueza: sua visão não é muito boa !

Imagine que você pede ao GPT-4V para clicar em um botão para você, mas ele clica em todos os lugares como uma “tela cega”, não é uma loucura?

Hoje vou apresentar a vocês um artefato que pode melhorar a aparência do GPT-4V - OmniParser Este é um novo modelo lançado pela Microsoft, com o objetivo de solucionar o problema de interação automática de interfaces gráficas de usuário (GUI).

O que o OmniParser faz?

Simplificando, OmniParser é um “tradutor de tela” que pode analisar capturas de tela em uma “linguagem estruturada” que o GPT-4V pode entender. OmniParser combina o modelo interativo de detecção de ícones ajustado, o modelo de descrição de ícones ajustado e a saída do módulo OCR.

Essa combinação produz uma representação estruturada da interface do usuário, semelhante ao DOM, bem como capturas de tela que cobrem as caixas delimitadoras de elementos potencialmente interativos. Os pesquisadores primeiro criaram um conjunto de dados interativo de detecção de ícones usando páginas da web populares e conjuntos de dados de descrição de ícones. Esses conjuntos de dados são usados para ajustar modelos especializados: um modelo de detecção para analisar áreas interativas na tela e um modelo de descrição para extrair a semântica funcional dos elementos detectados.

Especificamente, OmniParser irá:

Identifique todos os ícones e botões interativos na tela, marque-os com caixas e atribua a cada caixa um ID exclusivo.

Use texto para descrever a função de cada ícone, como “Configurações” e “Minimizar”. Reconheça o texto na tela e extraia-o.

Desta forma, o GPT-4V pode saber claramente o que está na tela e o que cada coisa faz. Basta informar o ID de qual botão você deseja clicar.

Quão incrível é o OmniParser?

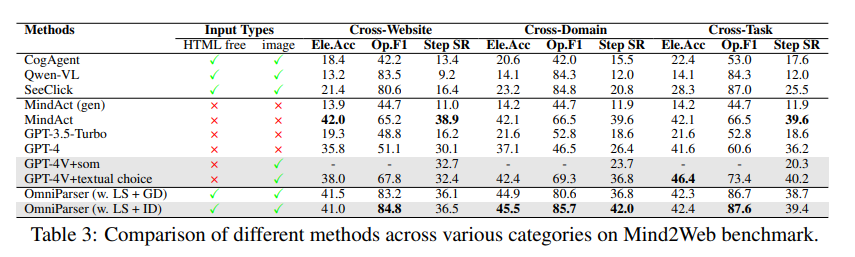

Os pesquisadores usaram vários testes para testar o OmniParser e descobriram que ele pode realmente tornar o GPT-4V “melhor”!

No teste ScreenSpot, o OmniParser melhorou bastante a precisão do GPT-4V, superando até mesmo alguns modelos especialmente treinados para interfaces gráficas. Por exemplo, no conjunto de dados ScreenSpot, o OmniParser melhora a precisão em 73%, superando os modelos que dependem da análise de HTML subjacente. Notavelmente, a incorporação da semântica local dos elementos da UI resultou em uma melhoria significativa na precisão da previsão - os ícones do GPT-4V foram rotulados corretamente de 70,5% a 93,8% ao usar a saída do OmniParser.

No teste Mind2Web, OmniParser melhorou o desempenho do GPT-4V em tarefas de navegação na web, e sua precisão superou até mesmo o GPT-4V que usa assistência de informações HTML.

No teste AITW, o OmniParser melhorou significativamente o desempenho do GPT-4V em tarefas de navegação em telefones celulares.

Quais são as deficiências do OmniParser?

Embora OmniParser seja muito poderoso, ele também apresenta algumas pequenas falhas, como:

É fácil ficar confuso quando se depara com ícones ou textos repetidos , e são necessárias descrições mais detalhadas para distingui-los.

Às vezes, o quadro não é desenhado com precisão suficiente , fazendo com que o GPT-4V clique na posição errada.

A interpretação dos ícones é ocasionalmente errônea e requer contexto para uma descrição mais precisa.

No entanto, os pesquisadores estão trabalhando duro para melhorar o OmniParser e acreditam que ele se tornará cada vez mais poderoso e eventualmente se tornará o melhor parceiro do GPT-4V!

Experiência do modelo: https://huggingface.co/microsoft/OmniParser

Entrada de papel: https://arxiv.org/pdf/2408.00203

Introdução oficial: https://www.microsoft.com/en-us/research/articles/omniparser-for-pure-vision-based-gui-agent/

Destaque:

✨OmniParser pode ajudar o GPT-4V a entender melhor o conteúdo da tela e executar tarefas com mais precisão.

OmniParser teve um bom desempenho em diversos testes, comprovando sua eficácia.

?️OmniParser ainda tem algumas áreas para melhorias, mas há esperança no futuro.

Resumindo, OmniParser traz melhorias revolucionárias na interação do GPT-4V com interfaces gráficas de usuário. Embora ainda existam algumas deficiências, o seu potencial é enorme e vale a pena esperar pelo seu desenvolvimento futuro. O editor do Downcodes acredita que com o avanço contínuo da tecnologia, OmniParser se tornará uma estrela brilhante no campo da inteligência artificial!