O editor do Downcodes soube que a empresa de inteligência artificial Anthropic lançou uma API de processamento em lote de mensagens. Essa nova tecnologia reduz em 50% o custo das empresas que processam grandes quantidades de dados. Esta mudança marca um grande avanço no campo do processamento de big data, economizando muito dinheiro para as empresas, ao mesmo tempo que melhora a eficiência e a conveniência do processamento de big data. Este novo recurso não apenas reduz custos, mas, mais importante ainda, muda a filosofia de preços da indústria, cria economias de escala para a computação de IA e espera-se que promova a popularização de aplicações de IA em empresas de médio porte.

Recentemente, a empresa de inteligência artificial Anthropic lançou oficialmente seu novo produto - Message Batches API. Esta nova tecnologia permite às empresas reduzir em 50% o custo de processamento de grandes quantidades de dados. Esta mudança traz, sem dúvida, boas notícias para o processamento de big data.

Através desta API, as empresas podem processar até 10.000 consultas de forma assíncrona em 24 horas, tornando os modelos de IA de ponta mais acessíveis.

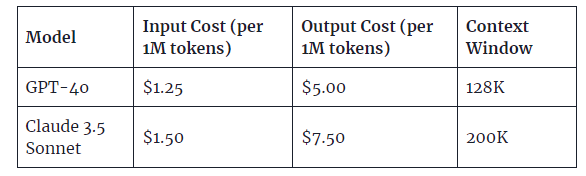

À medida que a tecnologia de IA continua a desenvolver-se, os desafios enfrentados pelas empresas também aumentam, especialmente no processamento de dados. A API de processamento em lote lançada pela Anthropic desta vez é 50% mais barata do que o processamento em tempo real em termos de taxas de token de entrada e saída.

O que é interessante é que esta mudança não é apenas uma simples estratégia de redução de preços, mas também uma mudança na filosofia de preços da indústria. Ao descontar o processamento em grande escala, a Anthropic está criando economias de escala para a computação de IA, ao mesmo tempo que potencialmente impulsiona a adoção de aplicações de IA em empresas de médio porte. Imagine que a análise de dados em grande escala, anteriormente considerada cara e complexa, é agora tão simples e económica.

Vale ressaltar que a API de processamento em lote da Anthropic já está disponível nos modelos Claude3.5Sonnet, Claude3Opus e Claude3Haiku. No futuro, essa funcionalidade será expandida no Vertex AI do Google Cloud e no Amazon Bedrock.

Em comparação com aplicativos que exigem resposta em tempo real, embora o processamento em lote seja mais lento, em muitos cenários de negócios, o processamento “oportuno” costuma ser mais importante do que o processamento “em tempo real”. As empresas estão a começar a prestar atenção em como encontrar o melhor equilíbrio entre custo e velocidade, o que terá um novo impacto na implementação da IA.

No entanto, apesar das vantagens óbvias do processamento em lote, ele também levanta algumas questões. À medida que as empresas se habituam ao processamento em lote de baixo custo, haverá um impacto no desenvolvimento da tecnologia de IA em tempo real. Para manter um ecossistema de IA saudável, é necessário encontrar o equilíbrio certo entre o processamento em lote avançado e o real? capacidades de processamento de tempo.

Destaque:

✅ A API de processamento em lote de mensagens recém-lançada da Anthropic permite que as empresas reduzam o custo de processamento de grandes quantidades de dados em 50%.

✅ A nova API suporta até 10.000 consultas assíncronas, melhorando a acessibilidade do processamento de big data.

✅ As empresas estão começando a prestar atenção ao processamento “just-in-time” em aplicações de IA, o que pode representar desafios ao desenvolvimento de IA em tempo real.

O lançamento da API de processamento em lote de mensagens da Anthropic, sem dúvida, traz novas possibilidades para a indústria de IA e fornece às empresas soluções de processamento de big data mais econômicas. No futuro, continuaremos atentos à inovação e ao desenvolvimento da Anthropic na área de IA. Acredito que à medida que a tecnologia continua a avançar, a IA servirá melhor todas as esferas da vida.