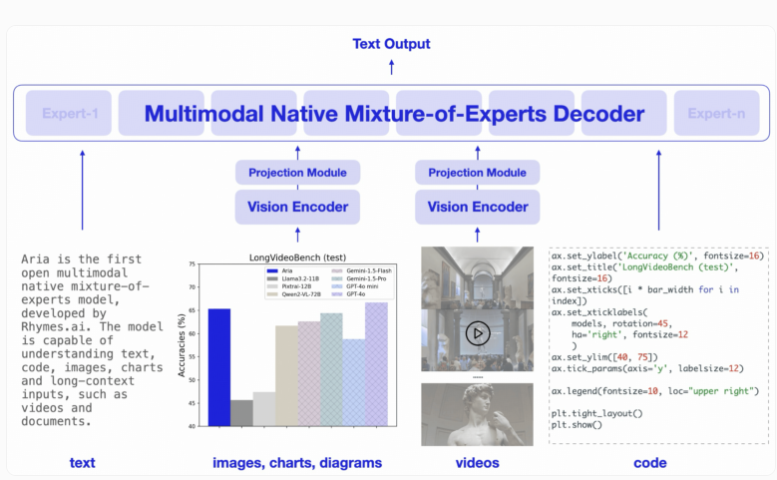

A startup Rhymes AI, com sede em Tóquio, lançou seu primeiro modelo de inteligência artificial, Aria, um modelo especialista híbrido multimodal (MoE) de código aberto. O editor do Downcodes aprendeu que o Aria tem um bom desempenho no processamento de uma variedade de entradas, como texto, código, imagens e vídeos, e suas capacidades superam até mesmo alguns modelos de negócios bem conhecidos. Aria usa uma arquitetura MoE exclusiva para aumentar a eficiência computacional por meio de vários especialistas especializados e possui uma janela de contexto multimodal de até 24,9 bilhões de parâmetros e 64.000 tokens, permitindo lidar com dados de entrada mais longos. A Rhymes AI também cooperou com a AMD para otimizar o desempenho do modelo e lançou o aplicativo de pesquisa BeaGo baseado em hardware AMD.

Aria foi projetado para fornecer recursos superiores de compreensão e processamento em uma variedade de formatos de entrada, incluindo texto, código, imagens e vídeo. Diferente do modelo Transformer tradicional, o modelo MoE substitui sua camada feed-forward por múltiplos especialistas profissionais. Ao processar cada token de entrada, um módulo de roteamento seleciona um subconjunto de especialistas para ativar, melhorando assim a eficiência computacional e reduzindo o número de parâmetros de ativação por token.

O decodificador da Aria pode ativar 3,5 bilhões de parâmetros por token de texto, e todo o modelo possui 24,9 bilhões de parâmetros. Para lidar com entradas visuais, Aria também projetou um codificador visual leve com 438 milhões de parâmetros que pode converter entradas visuais de vários comprimentos, tamanhos e proporções em tokens visuais. Além disso, a janela de contexto multimodal do Aria atinge 64.000 tokens, o que significa que pode lidar com dados de entrada mais longos.

Em termos de treinamento, o Rhymes AI é dividido em quatro estágios: primeiro usa dados de texto para pré-treinamento, depois introduz dados multimodais, seguido por treinamento de longa sequência e, finalmente, ajuste fino.

Neste processo, Aria usou um total de 6,4 trilhões de tokens de texto e 400 bilhões de tokens multimodais para pré-treinamento. Os dados vieram de conjuntos de dados conhecidos, como Common Crawl e LAION, e algumas melhorias sintéticas foram realizadas.

De acordo com testes de benchmark relevantes, o Aria supera modelos como Pixtral-12B e Llama-3.2-11B em múltiplas tarefas multimodais, de linguagem e de programação, e tem custos de inferência mais baixos devido a menos parâmetros de ativação.

Além disso, o Aria tem um bom desempenho no processamento de vídeos com legendas ou documentos de várias páginas, e sua capacidade de entender vídeos e documentos longos excede outros modelos de código aberto, como GPT-4o mini e Gemini1.5Flash .

Para facilidade de uso, a Rhymes AI lança o código-fonte do Aria no GitHub sob a licença Apache2.0, suportando uso acadêmico e comercial. Ao mesmo tempo, eles também fornecem uma estrutura de treinamento que pode ajustar o Aria para múltiplas fontes e formatos de dados em uma única GPU. Vale ressaltar que a Rhymes AI firmou uma cooperação com a AMD para otimizar o desempenho do modelo e demonstrou um aplicativo de pesquisa chamado BeaGo, que pode ser executado em hardware AMD para fornecer aos usuários resultados de pesquisa de IA de texto e imagem mais abrangentes.

Destaque:

Aria é o primeiro modelo de IA especialista híbrido multimodal de código aberto do mundo.

Aria supera muitos modelos semelhantes ao processar uma variedade de entradas, como texto, imagens e vídeos.

?Rhymes AI coopera com a AMD para otimizar o desempenho do modelo e lançar o aplicativo de pesquisa BeaGo que suporta múltiplas funções.

Em suma, o código aberto e o alto desempenho do modelo Aria trouxeram novos avanços no campo da inteligência artificial e forneceram ferramentas poderosas para desenvolvedores e pesquisadores. Suas capacidades multimodais e alta eficiência computacional proporcionam grande potencial em aplicações futuras. O editor do Downcodes espera a aplicação e desenvolvimento do Aria em mais campos.