A capacidade de raciocínio de grandes modelos de linguagem (LLMs) é um ponto importante de pesquisa no campo da inteligência artificial. A equipe de pesquisa de IA da Apple publicou recentemente um artigo revelando as limitações dos LLMs no raciocínio matemático. O editor do Downcodes interpretará o conteúdo principal do artigo e analisará seu impacto no desenvolvimento da tecnologia de IA.

No mundo da inteligência artificial, as capacidades de raciocínio dos modelos de aprendizado de máquina, especialmente os grandes modelos de linguagem (LLMs), sempre foram o foco dos cientistas.

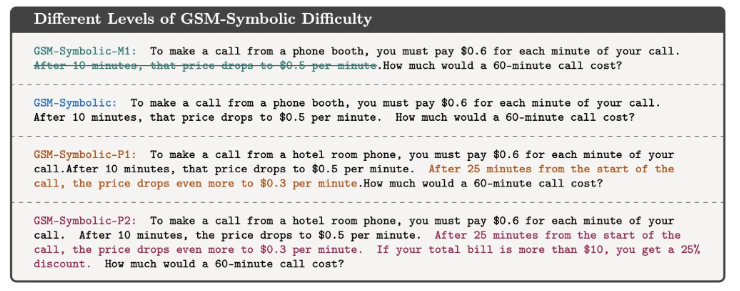

Recentemente, a equipe de pesquisa de IA da Apple publicou um artigo intitulado “Compreendendo as limitações de grandes modelos de linguagem no raciocínio matemático”, que revelou as limitações desses modelos para lidar com problemas lógicos.

No artigo, os pesquisadores demonstram isso por meio de um problema matemático simples. Eles primeiro fizeram uma pergunta sobre Oliver colhendo kiwis:

Conforme mostrado abaixo:

Oliver colheu 44 kiwis na sexta-feira. No sábado ele colheu mais 58 kiwis. No domingo, ele colheu o dobro de kiwis que na sexta-feira. Quantos kiwis Oliver tem no total?

Obviamente, a resposta é 44+58+ (44*2) =190. Embora grandes modelos de linguagem não sejam matematicamente perfeitos, eles podem resolver problemas como esse de maneira bastante confiável.

Mas se você adicionar algumas informações irrelevantes para observar a resposta do modelo, como:

Oliver colheu 44 kiwis na sexta-feira. No sábado ele escolheu outros 58. No domingo, ele colheu o dobro de kiwis que na sexta-feira, mas cinco deles eram um pouco menores que a média. Quantos kiwis Oliver tem?

Embora isso não mude a natureza matemática do problema, mesmo os LLMs mais modernos dão respostas erradas sob esta pequena perturbação. Por exemplo, GPT-o1-mini subtraiu incorretamente 5 kiwis pequenos do número total de kiwis colhidos no domingo.

Esta experiência mostra que embora os LLMs possam dar a resposta correta em alguns casos, eles não compreendem realmente a natureza do problema.

Os pesquisadores acreditam que os padrões de falha desses modelos indicam que eles não estão realizando um raciocínio lógico verdadeiro, mas replicando as etapas de raciocínio observadas nos dados de treinamento. É como se um LLM fosse capaz de contar que “eu te amo” geralmente é seguido por “eu também te amo”, mas isso não significa que ele realmente entende o significado do amor.

Mehrdad Farajtabar, um dos coautores do artigo, explicou ainda mais as descobertas nas redes sociais. Ele ressalta que, embora seja possível melhorar o desempenho do modelo em alguns casos simples através de uma melhor engenharia de dicas, para perturbações complexas o modelo pode precisar de mais dados contextuais para lidar corretamente, e essas perturbações podem não ser viáveis para uma criança pequena lidar. .Não é um problema.

Este estudo nos lembra que, embora os LLMs sejam excelentes no processamento da linguagem, suas habilidades em raciocínio lógico ainda são limitadas. Esta não é apenas uma questão académica. À medida que a tecnologia de IA se torna cada vez mais parte da nossa vida quotidiana, as respostas a estas questões tornam-se cada vez mais importantes.

Não podemos simplesmente presumir que a IA pode compreender e executar tarefas complexas, mas deve ter uma compreensão mais profunda de como funcionam e das suas limitações. Esta pesquisa nos fornece uma compreensão mais profunda das tecnologias de IA, ao mesmo tempo que fornece informações valiosas sobre como usamos e desenvolvemos essas tecnologias.

Referência: https://techcrunch.com/2024/10/11/researchers-question-ais-reasoning-ability-as-models-stumble-on-math-problems-with-trivial-changes/

Em suma, a investigação da equipa da Apple destaca as limitações dos grandes modelos de linguagem no raciocínio lógico, lembrando-nos que precisamos de ser cautelosos sobre as capacidades da IA e continuar a prestar atenção à sua direção de desenvolvimento para evitar a dependência excessiva das suas capacidades. No futuro, precisamos estudar mais profundamente como melhorar as capacidades de raciocínio dos LLMs para que possam compreender verdadeiramente a essência do problema, em vez de apenas imitar os padrões existentes.