O editor de Downcodes irá levá-lo a compreender um fenômeno perturbador no campo da IA – o colapso do modelo. Imagine que um modelo de IA é como um blogueiro de culinária que começa a comer a comida que cozinha. Quanto mais come, mais fica viciado e a comida se torna cada vez mais desagradável. é quando o modelo entra em colapso. Ocorre quando um modelo de IA depende demais dos dados que gera, levando a um declínio na qualidade do modelo ou até mesmo ao fracasso total. Este artigo se aprofundará nas causas, efeitos e como evitar o colapso do modelo.

Uma coisa estranha aconteceu recentemente no círculo de IA, como um blogueiro de culinária que de repente começou a comer a comida que cozinhava e, quanto mais comia, mais viciado ficava, e a comida se tornava cada vez mais desagradável. É bastante assustador dizer isso. O termo profissional é chamado de colapso do modelo.

O que é o colapso do modelo? Simplificando, se um modelo de IA usar uma grande quantidade de dados autogerados durante o processo de treinamento, ele cairá em um ciclo vicioso, fazendo com que a qualidade da geração do modelo fique cada vez pior e, eventualmente, piore. falhar.

É como um ecossistema fechado. O modelo de IA é o único ser vivo neste sistema e os alimentos que ele produz são dados. No início ainda conseguia encontrar alguns ingredientes naturais (dados reais), mas com o passar do tempo passou a confiar cada vez mais nos ingredientes “artificiais” que produzia (dados sintéticos). O problema é que esses ingredientes “artificiais” são nutricionalmente deficientes e apresentam algumas das falhas do próprio modelo. Se você comer demais, o “corpo” do modelo de IA entrará em colapso e as coisas geradas se tornarão cada vez mais escandalosas.

Este artigo estuda o fenômeno do colapso do modelo e tenta responder a duas questões principais:

O colapso do modelo é inevitável? O problema pode ser resolvido misturando dados reais e sintéticos?

Quanto maior o modelo, mais fácil é travar?

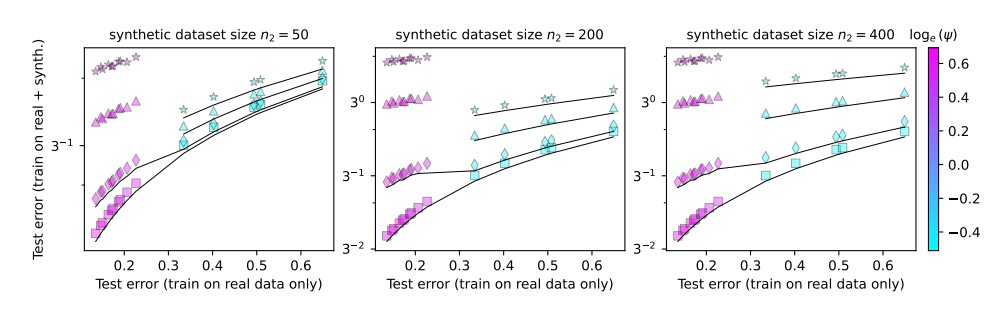

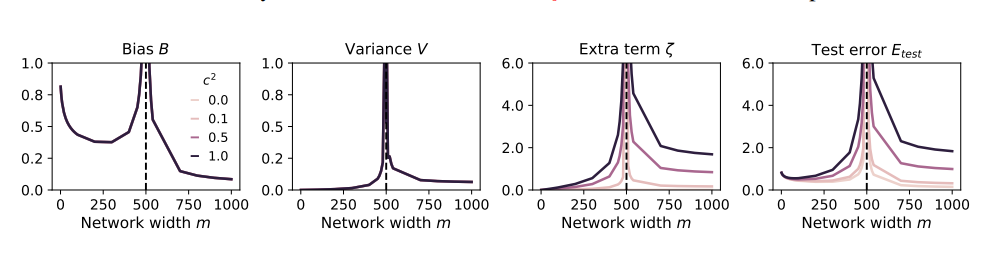

Para estudar essas questões, os autores do artigo desenvolveram uma série de experimentos e utilizaram um modelo de projeção aleatória para simular o processo de treinamento da rede neural. Eles descobriram que usar até mesmo uma pequena porção dos dados sintéticos (digamos, 1%) poderia causar o colapso do modelo. Para piorar a situação, à medida que o tamanho do modelo aumenta, o fenómeno do colapso do modelo torna-se mais grave.

É como um blogueiro de culinária que começou a experimentar todos os tipos de ingredientes estranhos para chamar a atenção, mas acabou ficando com dor de estômago. Para recuperar as perdas, ele só conseguiu aumentar a ingestão de alimentos e comer coisas cada vez mais estranhas. Como resultado, seu estômago foi piorando cada vez mais e ele finalmente teve que abandonar o mundo da alimentação e da radiodifusão.

Então, como devemos evitar o colapso do modelo?

Os autores do artigo fizeram algumas sugestões:

Priorize o uso de dados reais: Dados reais são como alimentos naturais, ricos em nutrientes e são a chave para o crescimento saudável dos modelos de IA.

Use dados sintéticos com cautela: dados sintéticos são como alimentos artificiais. Embora possam complementar alguns nutrientes, você não deve confiar muito neles, caso contrário, serão contraproducentes.

Controle o tamanho do modelo: Quanto maior o modelo, maior será o apetite e mais fácil será ter estômago ruim. Ao usar dados sintéticos, controle o tamanho do modelo para evitar superalimentação.

O colapso do modelo é um novo desafio encontrado no processo de desenvolvimento da IA. Ele nos lembra que, ao mesmo tempo em que buscamos a escala e a eficiência do modelo, devemos também prestar atenção à qualidade dos dados e à saúde do modelo. Só desta forma os modelos de IA poderão continuar a desenvolver-se de forma saudável e a criar maior valor para a sociedade humana.

Artigo: https://arxiv.org/pdf/2410.04840

Em suma, o colapso do modelo é um problema digno de atenção no desenvolvimento da IA. Precisamos tratar os dados sintéticos com cautela, prestar atenção à qualidade dos dados reais e controlar a escala do modelo para evitar o fenômeno da "IA". comendo demais." Espero que esta análise possa ajudar todos a compreender melhor o colapso do modelo e contribuir para o desenvolvimento saudável da IA.