O editor do Downcodes traz grandes novidades para você! Há um novo membro no campo da inteligência artificial - a Zyphra lançou oficialmente seu modelo de linguagem pequena Zamba2-7B! Este modelo de 7 mil milhões de parâmetros alcançou um avanço no desempenho, especialmente em termos de eficiência e adaptabilidade, mostrando vantagens impressionantes. Não é apenas adequado para ambientes de computação de alto desempenho, mas, mais importante ainda, o Zamba2-7B também pode ser executado em GPUs de consumo, permitindo que mais usuários experimentem facilmente o encanto da tecnologia avançada de IA. Este artigo irá aprofundar as inovações do Zamba2-7B e seu impacto no campo do processamento de linguagem natural.

Recentemente, a Zyphra lançou oficialmente o Zamba2-7B, um modelo de linguagem pequena com desempenho sem precedentes, com número de parâmetros chegando a 7B.

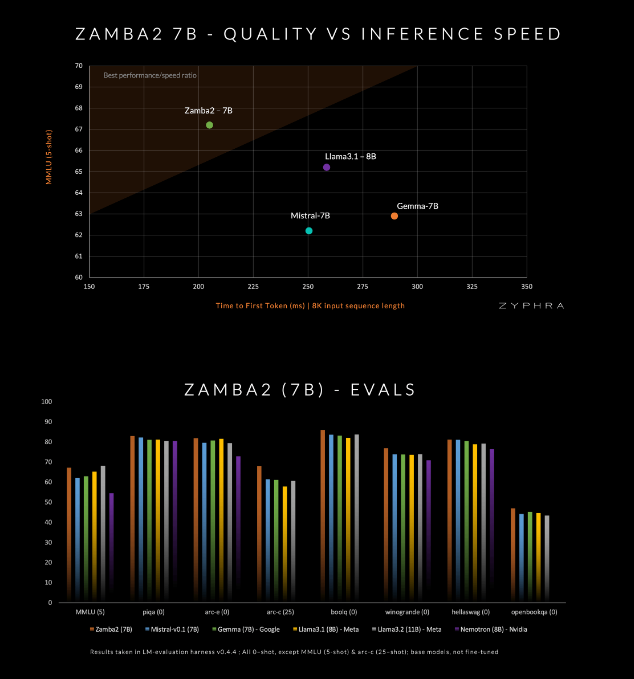

Este modelo afirma superar os concorrentes atuais em qualidade e velocidade, incluindo Mistral-7B, Gemma-7B do Google e Llama3-8B da Meta.

O Zamba2-7B foi projetado para atender às necessidades de ambientes que exigem recursos poderosos de processamento de linguagem, mas são limitados pelas condições de hardware, como processamento no dispositivo ou uso de GPUs de nível consumidor. Ao melhorar a eficiência sem sacrificar a qualidade, a Zyphra espera permitir que uma gama mais ampla de usuários, sejam empresas ou desenvolvedores individuais, desfrute da conveniência da IA avançada.

Zamba2-7B fez muitas inovações em sua arquitetura para melhorar a eficiência e as capacidades de expressão do modelo. Diferente do modelo da geração anterior Zamba1, Zamba2-7B usa dois blocos de atenção compartilhada. Este design pode lidar melhor com as dependências entre o fluxo de informações e as sequências.

O bloco Mamba2 forma o núcleo de toda a arquitetura, o que torna a utilização dos parâmetros do modelo superior à dos modelos de conversores tradicionais. Além disso, o Zyphra também usa projeção de adaptação de baixa classificação (LoRA) em blocos MLP compartilhados, o que melhora ainda mais a adaptabilidade de cada camada, mantendo a compactação do modelo. Graças a estas inovações, o primeiro tempo de resposta do Zamba2-7B foi reduzido em 25% e o número de tokens processados por segundo aumentou em 20%.

A eficiência e adaptabilidade do Zamba2-7B foram verificadas por testes rigorosos. O modelo é pré-treinado em um enorme conjunto de dados contendo três trilhões de tokens, que são dados abertos de alta qualidade e rigorosamente selecionados.

Além disso, o Zyphra também introduz um estágio de pré-treinamento de “recozimento” que reduz rapidamente a taxa de aprendizado para processar tokens de alta qualidade com mais eficiência. Esta estratégia permite que o Zamba2-7B tenha um bom desempenho em benchmarks, superando os concorrentes em velocidade e qualidade de inferência, e é adequada para tarefas como compreensão e geração de linguagem natural sem exigir os enormes recursos computacionais exigidos pelos modelos tradicionais de alta qualidade.

O amba2-7B representa um grande avanço em modelos de linguagem pequena, mantendo alta qualidade e desempenho, ao mesmo tempo em que dá atenção especial à acessibilidade. Através de um design arquitetônico inovador e tecnologia de treinamento eficiente, a Zyphra criou com sucesso um modelo que não é apenas fácil de usar, mas também pode atender a diversas necessidades de processamento de linguagem natural. O lançamento de código aberto do Zamba2-7B convida pesquisadores, desenvolvedores e empresas a explorar seu potencial e espera-se que avance no desenvolvimento do processamento avançado de linguagem natural na comunidade em geral.

Entrada do projeto: https://www.zyphra.com/post/zamba2-7b

https://github.com/Zyphra/transformers_zamba2

O lançamento de código aberto do Zamba2-7B trouxe uma nova vitalidade ao campo do processamento de linguagem natural e proporcionou mais possibilidades para os desenvolvedores. Esperamos que o Zamba2-7B seja mais amplamente utilizado no futuro e promova o progresso contínuo da tecnologia de inteligência artificial!