OpenAI lançou um novo modelo atraente gpt-4o-audio-preview, que fez avanços significativos no campo de geração e análise de fala, trazendo aos usuários uma experiência de interação de voz mais natural e inteligente. O editor de Downcodes irá levá-lo a ter uma compreensão aprofundada das principais funções, cenários de aplicação e estratégias de preços deste modelo, e analisar seu impacto potencial em vários setores.

OpenAI mais uma vez lidera a tendência da tecnologia de inteligência artificial e lança um novo modelo gpt-4o-audio-preview. Este modelo não só demonstra capacidades surpreendentes na geração e análise de fala, mas também abre novas possibilidades para a interação humano-computador. Vamos dar uma olhada mais de perto nas características deste modelo inovador e suas aplicações potenciais.

As principais funções do gpt-4o-audio-preview incluem três aspectos principais: primeiro, ele pode gerar respostas de voz naturais e suaves com base em texto, fornecendo forte suporte para aplicativos como assistentes de voz e atendimento virtual ao cliente. Em segundo lugar, o modelo tem a capacidade de analisar a emoção, a entonação e o tom da entrada de áudio, o que tem amplas perspectivas de aplicação nas áreas de computação afetiva e análise da experiência do usuário. Por fim, suporta interação voz a voz, onde o áudio pode ser usado tanto como entrada quanto como saída, estabelecendo a base para uma gama completa de sistemas de interação por voz.

Comparado com a API Realtime existente da OpenAI, gpt-4o-audio-preview concentra-se mais nos detalhes do processamento de fala. É excelente na geração de fala, análise de sentimentos e interação de fala, com foco particular no processamento de recursos sutis, como entonação e emoção. Por outro lado, o Realtime API concentra-se mais no processamento de dados em tempo real e é adequado para cenários que exigem feedback imediato, como conversão de fala em texto em tempo real ou tradução em tempo real e outros aplicativos continuamente interativos.

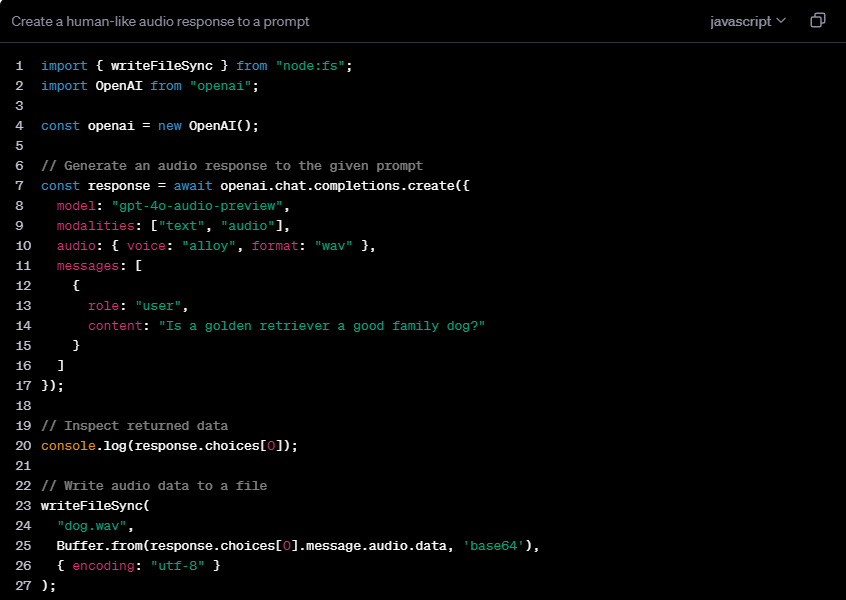

A flexibilidade do gpt-4o-audio-preview se reflete em seu suporte para múltiplas combinações de modos. Os usuários podem selecionar a entrada de texto para gerar saída de texto e áudio ou usar a entrada de áudio para obter saída de texto e fala. Além disso, ele também oferece suporte à conversão de áudio para texto e modos de entrada mistos, fornecendo aos desenvolvedores opções ricas.

Em termos de preços, a OpenAI adota um modelo de cobrança baseado em tokens. O preço da entrada de texto é relativamente baixo, em torno de US$ 5 por milhão de tokens. A produção de texto é um pouco maior, em torno de US$ 15 por milhão de tokens. O custo do processamento de áudio é relativamente alto, com a entrada custando US$ 100 por milhão de tokens (aproximadamente US$ 0,06 por minuto), enquanto a saída de áudio chega a US$ 200 por milhão de tokens (aproximadamente US$ 0,24 por minuto). Esta estratégia de preços reflete a complexidade e os requisitos de recursos computacionais do processamento de áudio.

O lançamento do gpt-4o-audio-preview terá, sem dúvida, um impacto transformador em vários setores. Na área de atendimento ao cliente, pode proporcionar uma experiência de interação por voz mais natural e emocional. Na indústria da educação, esta tecnologia pode ser usada para desenvolver assistentes inteligentes de aprendizagem de línguas para ajudar os alunos a melhorar a sua pronúncia e entonação. Na indústria do entretenimento, espera-se que conduza uma síntese de fala mais realista e uma interação de personagens virtuais. Além disso, em termos de tecnologia assistiva, o gpt-4o-audio-preview pode fornecer serviços de fala para texto mais precisos para deficientes auditivos ou fornecer descrições de voz mais ricas para deficientes visuais.

Detalhes: https://platform.openai.com/docs/guides/audio/quickstart

Em suma, o surgimento do modelo gpt-4o-audio-preview marca uma nova etapa na tecnologia de inteligência artificial de voz. Suas funções poderosas e amplas perspectivas de aplicação trarão mudanças revolucionárias nos futuros métodos de interação humano-computador. O editor do Downcodes espera ver aplicações mais inovadoras baseadas neste modelo.