O editor do Downcodes aprendeu que estudiosos chineses do Georgia Institute of Technology e da NVIDIA propuseram uma estrutura inovadora de ajuste fino chamada RankRAG, que simplifica significativamente o complexo processo de geração de aprimoramento de recuperação (RAG). O RankRAG ajusta um único modelo de linguagem grande (LLM) para realizar simultaneamente as tarefas de recuperação, classificação e geração, melhorando significativamente o desempenho e a eficiência e alcançando resultados experimentais que são superiores aos modelos de código aberto existentes. Esta tecnologia inovadora traz novas possibilidades para a aplicação da IA em vários campos.

Recentemente, dois estudiosos chineses do Georgia Institute of Technology e da NVIDIA propuseram uma nova estrutura de ajuste fino chamada RankRAG. Essa estrutura simplifica muito o complexo pipeline RAG original e usa o método de ajuste fino para permitir que o mesmo LLM conclua a recuperação, classificação e geração. tarefas, o que também resultou em uma melhoria substancial no desempenho.

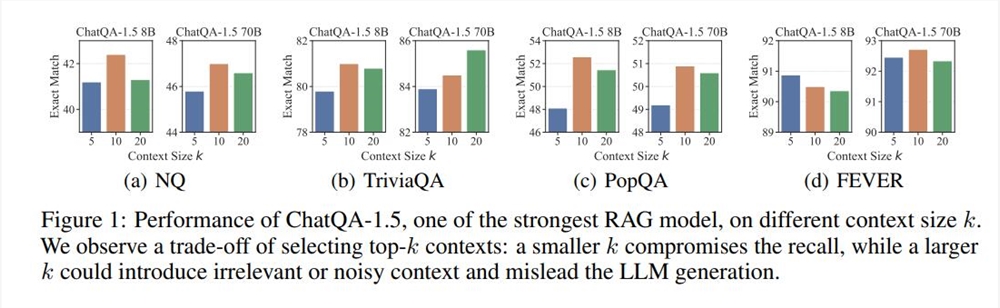

RAG (Retrieval-Augmented Generation) é uma tecnologia comumente usada na implantação de LLM e é particularmente adequada para tarefas de geração de texto que exigem uma grande quantidade de conhecimento factual. Geralmente, o processo de RAG é: um modelo denso baseado na codificação de texto recupera os k principais segmentos de texto de um banco de dados externo e, em seguida, o LLM os lê e gera. Este processo tem sido amplamente utilizado, mas também apresenta limitações, como a seleção do valor k. Se o valor k for muito grande, mesmo o LLM que suporta contexto longo terá dificuldade em processá-lo rapidamente. Se o valor k for muito pequeno, será necessário um mecanismo de recuperação de alta recuperação e os recuperadores e modelos de classificação existentes terão suas próprias deficiências;

Com base nos problemas acima, a estrutura RankRAG apresenta uma nova ideia: expandir os recursos do LLM por meio do ajuste fino e permitir que o LLM conclua a recuperação e a classificação por si só. Os resultados experimentais mostram que este método não só melhora a eficiência dos dados, mas também melhora significativamente o desempenho do modelo. Especialmente em vários benchmarks gerais e benchmarks de uso intensivo de conhecimento biomédico, o modelo Llama38B/70B ajustado pelo RankRAG superou os modelos ChatQA-1.58B e ChatQA-1.570B, respectivamente.

A chave do RankRAG é seu alto grau de interatividade e editabilidade. Os usuários podem não apenas visualizar o conteúdo gerado por IA em tempo real, mas também editar e iterar diretamente na interface. Este mecanismo de feedback instantâneo melhora muito a eficiência do trabalho e torna a IA um assistente verdadeiramente poderoso no processo criativo. O que é ainda mais interessante é que esta atualização faz com que esses artefatos não estejam mais limitados à plataforma Claude e os usuários possam compartilhá-los facilmente em qualquer lugar.

Esta inovação da estrutura de ajuste fino do RankRAG também inclui dois estágios de ajuste fino de instrução. O primeiro estágio é o ajuste fino supervisionado (SFT), que mistura vários conjuntos de dados para melhorar a capacidade de seguimento de instruções do LLM. O conjunto de dados de ajuste fino do segundo estágio contém uma variedade de dados de controle de qualidade, dados de controle de qualidade aprimorados por recuperação e dados de classificação contextual para aprimorar ainda mais os recursos de recuperação e classificação do LLM.

Em experimentos, o RankRAG supera consistentemente o atual modelo SOTA de código aberto ChatQA-1.5 em nove conjuntos de dados de domínio geral. Especialmente em tarefas desafiadoras de controle de qualidade, como controle de qualidade de cauda longa e controle de qualidade multi-hop, o RankRAG melhora o desempenho em mais de 10% em relação ao ChatQA-1.5.

No geral, o RankRAG não apenas tem um bom desempenho em tarefas de recuperação e geração, mas também demonstra sua forte adaptabilidade no benchmark biomédico RAG Mirage. Mesmo sem ajuste fino, o RankRAG supera muitos modelos de código aberto em áreas especializadas em tarefas de resposta a perguntas médicas.

Com a introdução e melhoria contínua da estrutura RankRAG, temos motivos para acreditar que o futuro da criação colaborativa entre IA e humanos será mais brilhante. Tanto os desenvolvedores independentes quanto os pesquisadores podem usar esta estrutura inovadora para inspirar mais ideias e possibilidades e promover o desenvolvimento de tecnologia e aplicações.

Endereço do artigo: https://arxiv.org/abs/2407.02485

O surgimento da estrutura RankRAG anuncia outro salto para modelos de linguagem em larga escala nas áreas de recuperação de informação e geração de texto. Seu design simples e eficiente e excelente desempenho fornecerão, sem dúvida, novas direções e motivação para o desenvolvimento da tecnologia de IA no futuro. Esperamos que o RankRAG mostre seu forte potencial em mais áreas!