O editor do Downcodes vai te ajudar a entender os “usos alternativos” dos trabalhos acadêmicos! Nos últimos anos, a fonte de dados de treinamento para modelos de IA atraiu atenção generalizada. Muitos editores acadêmicos estão "embalando e vendendo" artigos de pesquisa para empresas de tecnologia para melhorar as capacidades dos sistemas de IA. Isto envolveu enormes transações e desencadeou discussões acaloradas na comunidade académica sobre direitos de propriedade intelectual, direitos de autor e a ética do desenvolvimento da IA. Este artigo irá aprofundar os mecanismos, impactos e tendências futuras por trás deste fenômeno.

Você já pensou que seu trabalho de pesquisa pode ter sido usado para treinar IA? Sim, muitas editoras académicas estão a “empacotar e vender” os seus resultados a empresas tecnológicas que desenvolvem modelos de IA. Não há dúvida de que esta mudança causou grande agitação na comunidade de investigação científica, especialmente quando os autores nada sabem sobre ela. Os especialistas dizem que se o seu ainda não estiver sendo usado por um modelo de linguagem grande (LLM), há uma boa chance de que o seja em um futuro próximo.

Recentemente, a editora académica britânica Taylor & Francis chegou a um acordo de 10 milhões de dólares com a Microsoft, permitindo à gigante tecnológica utilizar os seus dados de investigação para melhorar as capacidades dos seus sistemas de IA. Já em junho, a editora americana Wiley também chegou a um acordo com uma empresa e recebeu US$ 23 milhões em receitas em troca de seu conteúdo ser usado para treinar modelos generativos de IA.

Se um artigo estiver disponível on-line, seja de acesso aberto ou protegido por acesso pago, é provável que ele tenha sido inserido em algum modelo de linguagem amplo. “Uma vez que um papel é usado para treinar um modelo, ele não pode ser removido depois que o modelo é treinado”, disse Lucy Lu Wang, pesquisadora de IA da Universidade de Washington.

Grandes modelos de linguagem requerem grandes quantidades de dados para serem treinados, que muitas vezes são extraídos da Internet. Ao analisar bilhões de trechos de linguagem, esses modelos são capazes de aprender e gerar textos fluentes. Os artigos acadêmicos tornaram-se um "tesouro" muito valioso para desenvolvedores de LLM devido à sua alta densidade de informações e longa extensão. Esses dados ajudam a IA a fazer melhores inferências científicas.

Recentemente, a tendência de compra de conjuntos de dados de alta qualidade está aumentando, e muitos meios de comunicação e plataformas conhecidas começaram a cooperar com desenvolvedores de IA para vender seu conteúdo. Considerando que sem um acordo muitas obras podem ser silenciosamente sucateadas, este tipo de cooperação só se tornará mais comum no futuro.

No entanto, alguns desenvolvedores de IA, como a Rede de Inteligência Artificial em Grande Escala, optam por manter seus conjuntos de dados abertos, mas muitas empresas que desenvolvem IA generativa mantêm seus dados de treinamento em segredo. Nada se sabe sobre os dados de treinamento. plataformas como arXiv e bancos de dados como PubMed são, sem dúvida, alvos populares para empresas de IA rastrearem.

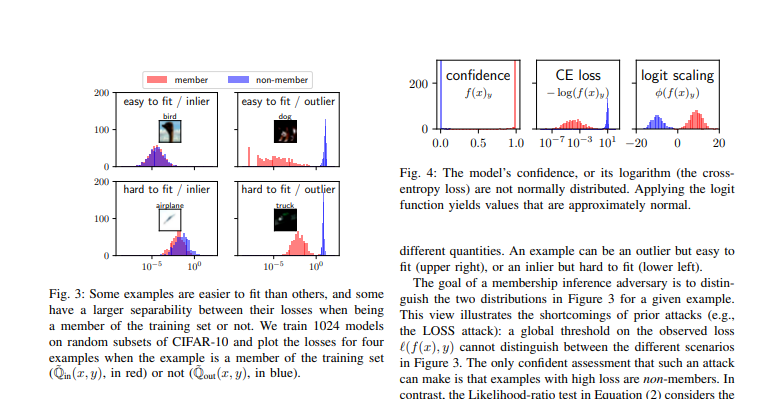

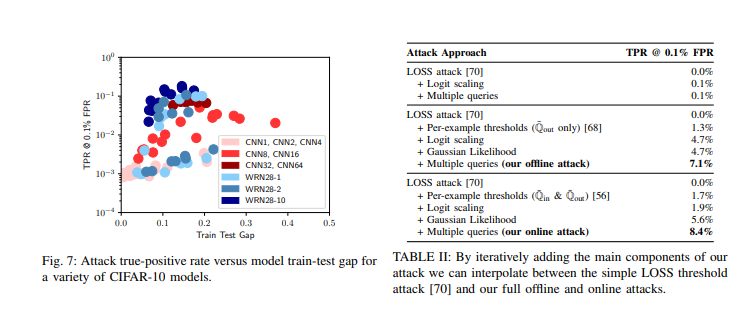

Não é simples provar se um determinado artigo aparece no conjunto de treinamento de um determinado LLM. Os pesquisadores podem usar frases incomuns do artigo para testar se a saída do modelo corresponde ao texto original, mas isso não prova completamente que o artigo não foi usado, porque os desenvolvedores podem ajustar o modelo para evitar a saída direta de dados de treinamento.

Mesmo que seja comprovado que um LLM utilizou um texto específico, o que acontece a seguir Os editores afirmam que o uso não autorizado de texto protegido por direitos autorais constitui violação, mas também há objeções de que o LLM não está copiando o texto, mas sim gerando novo texto? analisando o conteúdo da informação.

Atualmente há um processo de direitos autorais em andamento nos Estados Unidos que pode se tornar um caso histórico. O New York Times está processando a Microsoft e o desenvolvedor do ChatGPT, OpenAI, acusando-os de usar seu conteúdo de notícias para treinar modelos sem permissão.

Muitos estudiosos acolhem com satisfação a inclusão de seus trabalhos nos dados de treinamento do LLM, especialmente quando esses modelos podem melhorar a precisão da pesquisa. No entanto, nem todos os investigadores da profissão estão a aceitar isto com calma e muitos sentem que os seus empregos estão ameaçados.

Em geral, os autores científicos individuais têm actualmente pouca influência nas decisões de vendas dos editores, e não existe um mecanismo claro sobre como o crédito é atribuído e se é utilizado para artigos publicados. Alguns pesquisadores expressaram frustração: "Esperamos ter a ajuda de modelos de IA, mas também esperamos ter um mecanismo justo. Ainda não encontramos tal solução."

Referências:

https://www.nature.com/articles/d41586-024-02599-9

https://arxiv.org/pdf/2112.03570

A direção futura da IA e da publicação académica ainda não é clara, e as questões de direitos de autor, a privacidade dos dados e os mecanismos de proteção dos direitos e interesses dos autores precisam de ser melhorados. Este não é apenas um jogo entre editores e empresas de tecnologia, mas também uma questão importante relacionada ao desenvolvimento sustentável da pesquisa acadêmica e à ética da tecnologia de IA, que requer atenção e esforços conjuntos de toda a sociedade.