O Laboratório de Inteligência Artificial de Xangai lançou a versão mais recente do modelo da série Scholar Puyu, InternLM2.5, no Fórum Principal WAIC Science Frontier em 4 de julho de 2024. As capacidades de raciocínio desta versão em cenários complexos foram significativamente melhoradas, ela suporta contexto ultralongo de 1 milhão e pode realizar pesquisas na Internet e integração de informações de forma independente, o que é um grande avanço. O editor de Downcodes explicará detalhadamente as funções e informações de código aberto do InternLM2.5.

O Laboratório de Inteligência Artificial de Xangai lançou uma nova versão do modelo da série Scholar Puyu, InternLM2.5, no Fórum Principal WAIC Science Frontier em 4 de julho de 2024. As capacidades de raciocínio desta versão em cenários complexos foram amplamente aprimoradas, ela suporta contexto ultralongo de 1 milhão e pode realizar pesquisas na Internet de forma independente e integrar informações de centenas de páginas da web.

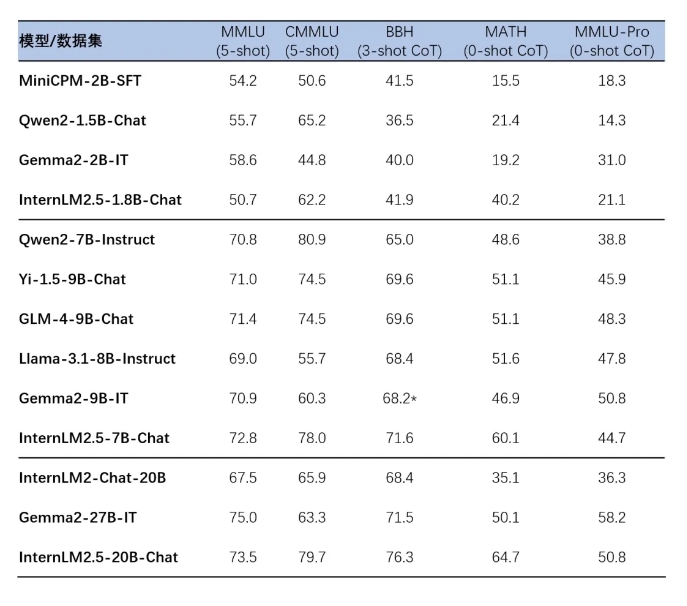

InternLM2.5 lançou três versões de parâmetros do modelo, nomeadamente 1.8B, 7B e 20B, para se adaptar a diferentes cenários de aplicação e necessidades do desenvolvedor. A versão 1.8B é um modelo ultraleve, enquanto a versão 20B oferece desempenho abrangente mais forte e suporta cenários práticos mais complexos. Todos esses modelos são de código aberto e podem ser encontrados na página inicial de modelos grandes da série Scholar·Puyu, na página inicial do ModelScope e na página inicial do Hugging Face.

O InternLM2.5 itera em múltiplas tecnologias de síntese de dados, melhorando significativamente as capacidades de raciocínio do modelo. Em particular, a taxa de precisão no conjunto de avaliação matemática MATH atingiu 64,7%. Além disso, o modelo melhora as capacidades de processamento do comprimento do contexto através de um treinamento eficiente no estágio de pré-treinamento.

Os modelos da série InternLM2.5 também alcançam integração perfeita com estruturas de inferência e ajuste fino downstream, incluindo a estrutura de ajuste fino XTuner e a estrutura de inferência LMDeploy desenvolvida independentemente pelo Laboratório de Inteligência Artificial de Xangai, bem como outras estruturas com extensas bases de usuários no comunidade como vLLM e Ollama e llama.cpp. A ferramenta SWIFT lançada pela comunidade Moda também suporta a inferência, ajuste fino e implantação de modelos da série InternLM2.5.

A experiência de aplicação desses modelos inclui raciocínio complexo em várias etapas, compreensão precisa das intenções de conversação em vários turnos, operações flexíveis de controle de formato e a capacidade de seguir instruções complexas. Guias detalhados de instalação e uso são fornecidos para facilitar que os desenvolvedores comecem rapidamente.

Página inicial do modelo grande da série Scholar·Puyu:

https://internlm.intern-ai.org.cn

Página inicial do ModelScope:

https://www.modelscope.cn/organization/Shanghai_AI_Laboratory?tab=model

Abraçando a página inicial do rosto:

https://huggingface.co/internlm

Link de código aberto InternLM2.5:

https://github.com/InternLM/InternLM

O lançamento de código aberto do InternLM2.5 traz novas possibilidades para pesquisas e aplicações no campo da inteligência artificial. Acredita-se que seu desempenho poderoso e facilidade de uso atrairão muitos desenvolvedores para explorar e inovar. O editor de Downcodes espera ver mais aplicativos excelentes baseados em InternLM2.5!