A startup israelense de inteligência artificial aiOla lançou um novo modelo de reconhecimento de fala de código aberto, Whisper-Medusa, que é aprimorado no Whisper da OpenAI e é 50% mais rápido. É de código aberto sob a licença do MIT na Hugging Face e é permitido para uso comercial. O editor de Downcodes lhe dará uma explicação detalhada deste novo modelo atraente.

A startup israelense de inteligência artificial aiOla recentemente deu um grande passo e anunciou o lançamento de um novo modelo de reconhecimento de fala de código aberto, Whisper-Medusa.

Este modelo não é simples. É 50% mais rápido do que o famoso Whisper da OpenAI. Ele é construído com base no Whisper, mas usa uma nova arquitetura de "atenção de múltiplas cabeças" para prever o número de tokens de uma vez. Muito além do OpenAI! produtos. Além disso, o código e os pesos foram divulgados no Hugging Face sob licença do MIT, que permite pesquisa e uso comercial.

Gill Hetz, vice-presidente de pesquisa da aiOla, disse que o código aberto pode incentivar a inovação e a cooperação comunitária, tornando-a mais rápida e completa. Este trabalho pode abrir caminho para sistemas complexos de inteligência artificial que podem compreender e responder às perguntas dos usuários quase em tempo real.

Nesta era em que os modelos básicos podem produzir uma variedade de conteúdos, o reconhecimento avançado de voz ainda é muito importante. O Whisper, por exemplo, pode lidar com falas complexas em diferentes idiomas e sotaques. Ele é baixado mais de 5 milhões de vezes por mês, oferece suporte a muitos aplicativos e se tornou o padrão ouro para reconhecimento de fala.

Então, o que há de tão especial no Whisper-Medusa de aiOla?

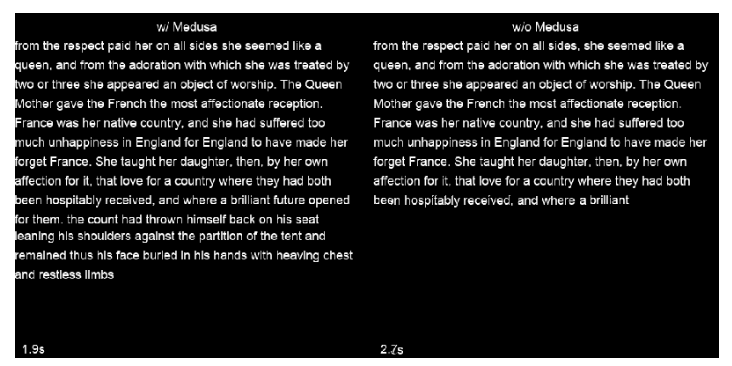

A empresa mudou a estrutura do Whisper e adicionou um mecanismo de atenção multicabeças, que pode prever 10 tokens por vez e aumentar a velocidade em 50% sem afetar a precisão. Um método de aprendizado de máquina fracamente supervisionado foi usado para treinar este modelo, e haverá versões mais poderosas no futuro. Além do mais, como a espinha dorsal do Whisper-Medusa é construída no Whisper, as melhorias de velocidade não ocorrerão às custas do desempenho.

Ao treinar Whisper-Medusa, aiOla usou um método de aprendizado de máquina chamado supervisão fraca. Como parte disso, congelou os principais componentes do Whisper e treinou um módulo adicional de previsão de token usando as transcrições de áudio geradas pelo modelo como rótulos.

Quando questionado se alguma empresa poderia obter acesso antecipado ao Whisper-Medusa, Hetz disse que eles foram testados em casos reais de uso de dados corporativos e podem ser executados com precisão em cenários do mundo real, tornando os aplicativos de voz mais responsivos no futuro. Em última análise, ele acredita que o aumento das velocidades de reconhecimento e transcrição permitirá tempos de resposta mais rápidos para aplicações de voz e abrirá caminho para o fornecimento de respostas em tempo real.

Destaque:

?50% mais rápido: o Whisper-Medusa da aiOla é significativamente mais rápido que o reconhecimento de fala Whisper da OpenAI.

?Sem perda de precisão: a velocidade é melhorada, mantendo a mesma precisão do modelo original.

Amplas perspectivas de aplicação: Espera-se que acelere a resposta, melhore a eficiência e reduza custos em aplicações de voz.

Em suma, espera-se que o modelo Whisper-Medusa da aiOla, com sua vantagem de velocidade e atributos de código aberto, desencadeie uma nova onda no campo do reconhecimento de fala e traga melhorias significativas de desempenho para diversas aplicações de fala. O editor de Downcodes continuará a prestar atenção ao desenvolvimento subsequente e às contribuições da comunidade deste modelo.