A Nous Research lança o revolucionário otimizador de treinamento de IA DisTrO, quebrando a situação em que o treinamento de grandes modelos de IA é limitado a grandes gigantes corporativos. O DisTrO pode reduzir significativamente a quantidade de transmissão de dados entre várias GPUs e pode treinar modelos de IA com eficiência, mesmo em ambientes de rede comuns. Isso reduzirá bastante o limite para o treinamento de modelos de IA e permitirá que mais indivíduos e instituições participem do desenvolvimento de tecnologia de pesquisa de IA. e desenvolvimento em andamento. Espera-se que esta tecnologia inovadora mude completamente o modelo de pesquisa e desenvolvimento no campo da IA e promova a popularização e o desenvolvimento da tecnologia de IA.

Recentemente, a equipe de pesquisa da Nous Research trouxe novidades interessantes para o círculo tecnológico. Eles lançaram um novo otimizador chamado DisTrO (Distributed Internet Training). O nascimento desta tecnologia significa que poderosos modelos de IA não são apenas patentes de grandes empresas, mas as pessoas comuns também têm a oportunidade de utilizar os seus próprios computadores para uma formação eficiente em casa.

A mágica do DisTrO é que ele pode reduzir significativamente a quantidade de informações que precisam ser transferidas entre várias unidades de processamento gráfico (GPUs) ao treinar um modelo de IA. Através desta inovação, poderosos modelos de IA podem ser treinados em condições normais de rede e até permitir que indivíduos ou instituições em todo o mundo unam forças para desenvolver conjuntamente tecnologia de IA.

De acordo com um artigo técnico da Nous Research, a melhoria da eficiência do DisTrO é surpreendente. A eficiência do treinamento com ele é 857 vezes maior do que a de um algoritmo comum – All-Reduce. passo também é reduzido de 74,4 GB para 74,4 GB. Estas melhorias não só tornam a formação mais rápida e barata, mas também significam que mais pessoas têm a oportunidade de participar neste domínio.

A Nous Research afirmou na sua plataforma social que através do DisTrO, investigadores e instituições já não necessitam de depender de uma determinada empresa para gerir e controlar o processo de formação, o que lhes proporciona mais liberdade para inovar e experimentar. Este ambiente competitivo aberto ajuda a promover o progresso tecnológico e, em última análise, beneficia toda a sociedade.

No treinamento em IA, os requisitos de hardware costumam ser proibitivos. Em particular, as GPUs Nvidia de alto desempenho tornaram-se cada vez mais escassas e caras nesta época, e apenas algumas empresas bem financiadas podem arcar com o fardo de tal treinamento. No entanto, a filosofia da Nous Research é exatamente o oposto. Eles estão empenhados em abrir o treinamento de modelos de IA ao público a um custo menor e em se esforçar para permitir a participação de mais pessoas.

DisTrO funciona reduzindo a sobrecarga de comunicação em quatro a cinco ordens de magnitude, reduzindo a necessidade de sincronização de gradiente total entre GPUs. Esta inovação permite que os modelos de IA sejam treinados em ligações de Internet mais lentas, sendo hoje suficientes as velocidades de download de 100 Mbps e de upload de 10 Mbps facilmente acessíveis a muitos lares.

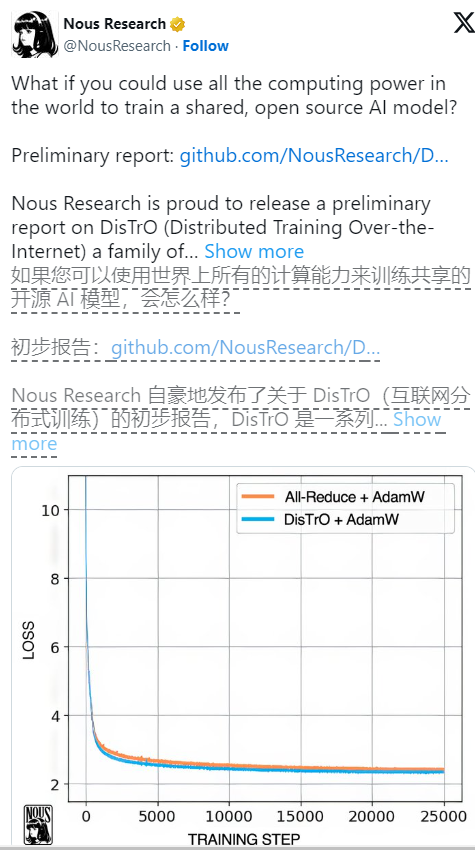

Em testes preliminares no modelo de linguagem grande Llama2 da Meta, o DisTrO mostrou resultados de treinamento comparáveis aos métodos tradicionais, ao mesmo tempo que reduziu significativamente a quantidade de comunicação necessária. Os pesquisadores também disseram que, embora até agora só tenham sido testados em modelos menores, eles especulam provisoriamente que à medida que o tamanho do modelo aumenta, a redução nos requisitos de comunicação pode ser mais significativa, chegando até a 1.000 a 3.000 vezes.

Vale ressaltar que embora o DisTrO flexibilize o treinamento, ele ainda conta com suporte de GPU, mas agora essas GPUs não precisam ser reunidas no mesmo lugar, mas podem ser dispersas pelo mundo e colaborar através da Internet comum. Vimos que o DisTrO foi capaz de se igualar ao método tradicional AdamW+All-Reduce em termos de velocidade de convergência quando testado rigorosamente usando 32 GPUs H100, mas reduziu significativamente os requisitos de comunicação.

DisTrO não é adequado apenas para modelos de linguagem grandes, mas também pode ser usado para treinar outros tipos de IA, como modelos de geração de imagens. As perspectivas de aplicação futura são animadoras. Além disso, ao melhorar a eficiência da formação, o DisTrO também pode reduzir o impacto ambiental da formação em IA porque optimiza a utilização da infra-estrutura existente e reduz a necessidade de grandes centros de dados.

Através do DisTrO, a Nous Research não só promove avanços tecnológicos na formação em IA, mas também promove um ecossistema de investigação mais aberto e flexível, que abre possibilidades ilimitadas para o desenvolvimento futuro da IA.

Referência: https://venturebeat.com/ai/this-could-change-everything-nous-research-unveils-new-tool-to-train-powerful-ai-models-with-10000x-efficiency/

O surgimento do DisTrO anuncia o processo de democratização do treinamento em IA, reduz o limiar de participação, promove o rápido desenvolvimento e a aplicação generalizada da tecnologia de IA e traz nova vitalidade e possibilidades ilimitadas ao campo da IA. No futuro, esperamos que o DisTrO traga mais surpresas ao desenvolvimento da IA.