Alibaba anunciou que abrirá o código-fonte de seu modelo de linguagem visual de segunda geração Qwen2-VL e fornecerá interfaces API e código-fonte aberto para facilitar o uso dos desenvolvedores. O modelo fez progressos significativos na compreensão de imagens e vídeos, suporta vários idiomas e possui fortes capacidades de agente visual, capazes de operar telefones celulares e robôs de forma autônoma. Qwen2-VL fornece modelos em três tamanhos: 2B, 7B e 72B para atender às necessidades de diferentes cenários de aplicação. O modelo 72B tem melhor desempenho na maioria dos indicadores, enquanto o modelo 2B é adequado para aplicações móveis.

Em 2 de setembro, Tongyi Qianwen anunciou o código aberto de seu modelo de linguagem visual de segunda geração Qwen2-VL e lançou APIs para tamanhos 2B e 7B e seu modelo de versão quantificada na plataforma Alibaba Cloud Bailian para os usuários ligarem diretamente.

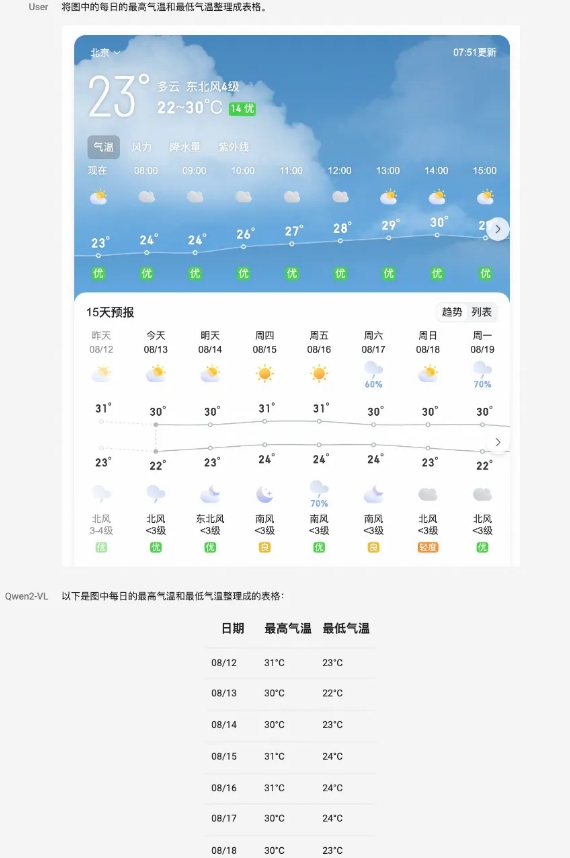

O modelo Qwen2-VL alcança melhorias abrangentes de desempenho em vários aspectos. Ele pode compreender imagens de diferentes resoluções e proporções e alcançou desempenho líder mundial em testes de benchmark como DocVQA, RealWorldQA e MTVQA. Além disso, o modelo também pode compreender vídeos longos de mais de 20 minutos e suportar perguntas e respostas baseadas em vídeo, diálogos e aplicativos de criação de conteúdo. Qwen2-VL também possui poderosos recursos de inteligência visual e pode operar telefones celulares e robôs de forma autônoma para realizar raciocínios e tomadas de decisões complexas.

O modelo é capaz de compreender textos multilíngues em imagens e vídeos, incluindo chinês, inglês, a maioria dos idiomas europeus, japonês, coreano, árabe, vietnamita e muito mais. A equipe de Tongyi Qianwen avaliou as capacidades do modelo em seis aspectos, incluindo questões universitárias abrangentes, habilidade matemática, compreensão de documentos, tabelas, texto e imagens em vários idiomas, perguntas e respostas gerais da cena, compreensão de vídeo e capacidades do agente.

Como modelo principal, o Qwen2-VL-72B atingiu o nível ideal na maioria dos indicadores. O Qwen2-VL-7B atinge um desempenho altamente competitivo com sua escala econômica de parâmetros, enquanto o Qwen2-VL-2B oferece suporte a aplicativos móveis ricos e possui recursos completos de compreensão de imagens e vídeos em vários idiomas.

Em termos de arquitetura de modelo, Qwen2-VL continua a estrutura de série de ViT mais Qwen2. Todos os três tamanhos de modelos usam 600M ViT, suportando entrada unificada de imagens e vídeos. A fim de melhorar a percepção do modelo de informações visuais e capacidades de compreensão de vídeo, a equipe atualizou a arquitetura, incluindo a implementação de suporte completo para resolução dinâmica nativa e usando o método de incorporação de posição de rotação multimodal (M-ROPE).

A plataforma Alibaba Cloud Bailian fornece API Qwen2-VL-72B, que os usuários podem chamar diretamente. Ao mesmo tempo, o código-fonte aberto de Qwen2-VL-2B e Qwen2-VL-7B foi integrado ao Hugging Face Transformers, vLLM e outras estruturas de terceiros, e os desenvolvedores podem baixar e usar os modelos por meio dessas plataformas.

Plataforma Alibaba Cloud Bailian:

https://help.aliyun.com/zh/model-studio/developer-reference/qwen-vl-api

Github:

https://github.com/QwenLM/Qwen2-VL

Abraçando o rosto:

https://huggingface.co/collections/Qwen/qwen2-vl-66cee7455501d7126940800d

Modelo mágicoEscopo:

https://modelscope.cn/organization/qwen?tab=model

Experiência modelo:

https://huggingface.co/spaces/Qwen/Qwen2-VL

Em suma, o código aberto do modelo Qwen2-VL fornece aos desenvolvedores ferramentas poderosas, promove o desenvolvimento de tecnologia de modelo de linguagem visual e traz mais possibilidades para vários cenários de aplicação. Os desenvolvedores podem obter o modelo e o código por meio do link fornecido para começar a construir seus próprios aplicativos.