A Microsoft lançou recentemente três poderosos modelos de IA Phi-3.5, nomeadamente Phi-3.5-mini-instruct, Phi-3.5-MoE-instruct e Phi-3.5-vision-instruct, visando modelos de raciocínio leve e especialistas híbridos e tarefas multimodais, respectivamente. são otimizados. Isto marca o progresso significativo da Microsoft no campo da inteligência artificial multilingue e multimodal, solidificando ainda mais a sua posição de liderança neste campo. Todos os três modelos são lançados sob a licença de código aberto do MIT, proporcionando aos desenvolvedores uma ampla gama de possibilidades de aplicação.

A Microsoft anunciou o lançamento de três novos modelos Phi-3.5, consolidando ainda mais a sua posição de liderança no desenvolvimento de inteligência artificial multilíngue e multimodal. Os três novos modelos são: Phi-3.5-mini-instruct, -3.5-MoE-instruct e Phi-3.5-vision-instruct, cada um visando diferentes cenários de aplicação.

O modelo Phi-3.5Mini Instruct é um modelo leve de IA com 380 milhões de parâmetros, muito adequado para ambientes com poder de computação limitado. Ele suporta um comprimento de contexto de 128k e é otimizado especificamente para recursos de execução de instruções, tornando-o adequado para tarefas como geração de código, resolução de problemas matemáticos e raciocínio lógico. Apesar do seu pequeno tamanho, este modelo apresenta uma competitividade impressionante em tarefas de diálogo multilíngue e multivoltas, superando outros modelos da sua classe.

Entrada: https://huggingface.co/microsoft/Phi-3.5-mini-instruct

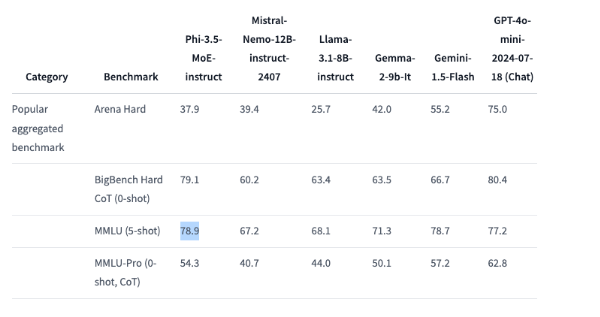

O modelo Phi-3.5MoE, um modelo “híbrido especialista”, combina vários tipos diferentes de modelos, cada um focado em uma tarefa específica. Possui 41,9 bilhões de parâmetros e suporta um comprimento de contexto de 128k, o que pode demonstrar um desempenho poderoso em uma variedade de tarefas de raciocínio. Este modelo tem um desempenho muito bom em código, matemática e compreensão multilíngue, superando até modelos maiores em alguns benchmarks, como superar o GPT-4o da OpenAI no MMLU (Massive Multi-Task Language Understanding) mini.

Entrada: https://huggingface.co/microsoft/Phi-3.5-MoE-instruct

O modelo Phi-3.5Vision Instruct é um modelo avançado de IA multimodal que integra recursos de processamento de texto e imagem e é adequado para tarefas como compreensão de imagens, reconhecimento óptico de caracteres, análise de gráficos e tabelas e resumo de vídeo. Este modelo também suporta um comprimento de contexto de 128k e pode lidar com tarefas complexas de visão multiquadro.

Entrada: https://huggingface.co/microsoft/Phi-3.5-vision-instruct

Para treinar esses três modelos, a Microsoft realizou processamento de dados em larga escala. O modelo Mini Instruct usou 3,4 trilhões de marcadores e foi treinado em 512 GPUs H100-80G por 10 dias; o modelo Vision Instruct usou 500 bilhões de marcadores e foi treinado em 6 dias e o modelo MoE foi usado em 23 dias; para treinamento.

Vale ressaltar que esses três modelos Phi-3.5 são todos lançados sob a licença de código aberto do MIT e os desenvolvedores podem usar, modificar e distribuir livremente esses softwares. Isto não só reflete o apoio da Microsoft à comunidade de código aberto, mas também permite que mais desenvolvedores integrem recursos de IA de ponta em seus aplicativos.

Destaque:

A Microsoft lançou três novos modelos de IA, visando raciocínio leve, especialistas híbridos e tarefas multimodais.

?Phi-3.5MoE supera o GPT-4o mini em testes de benchmark e tem um bom desempenho.

? Todos os três modelos são licenciados sob a licença de código aberto do MIT e os desenvolvedores podem usá-los e modificá-los livremente.

Em suma, os três modelos Phi-3.5 lançados pela Microsoft, com seu desempenho poderoso, ampla gama de cenários de aplicação e licenças abertas, terão, sem dúvida, um impacto profundo no campo da inteligência artificial e fornecerão ferramentas poderosas aos desenvolvedores e pesquisadores. também anunciam a nova direção do futuro desenvolvimento da tecnologia de IA.