O metacientista Thomas Scialom explicou o processo de desenvolvimento do Llama 3.1 em detalhes no podcast Latent Space e apresentou uma prévia da direção de desenvolvimento do Llama 4. O Llama 3.1 não é um simples empilhamento de parâmetros, mas uma compensação entre tamanho do parâmetro, tempo de treinamento e limitações de hardware. Seu tamanho de parâmetro 405B é uma resposta ao GPT-4o. Embora o enorme tamanho do modelo dificulte sua execução em computadores comuns, o recurso de código aberto permite que mais pessoas participem e promovam o desenvolvimento tecnológico.

O nascimento do Llama3.1 é um equilíbrio perfeito entre escala de parâmetros, tempo de treinamento e limitações de hardware. O enorme corpo do 405B não é uma escolha aleatória, mas um desafio lançado pela Meta ao GPT-4o. Embora as limitações de hardware impeçam a execução do Llama3.1 em todos os computadores domésticos, o poder da comunidade de código aberto torna tudo possível.

Durante o desenvolvimento do Llama 3.1, Scialom e sua equipe reexaminaram a Lei de Escalabilidade. Eles descobriram que o tamanho do modelo era realmente fundamental, mas o mais importante era a quantidade total de dados de treinamento. Llama3.1 optou por aumentar o número de tokens de treinamento, mesmo que isso significasse gastar mais poder computacional.

Não há mudanças radicais na arquitetura do Llama 3.1, mas Meta fez grandes esforços em termos de escala e qualidade dos dados. O oceano de tokens 15T deu ao Llama3.1 um salto qualitativo na profundidade e amplitude do conhecimento.

Em termos de seleção de dados, a Scialom acredita firmemente que há muito lixo de texto na Internet pública e que o verdadeiro ouro são os dados sintéticos. No processo de pós-treinamento do Llama3.1, nenhuma resposta escrita manualmente foi utilizada, mas confiou totalmente nos dados sintéticos gerados pelo Llama2.

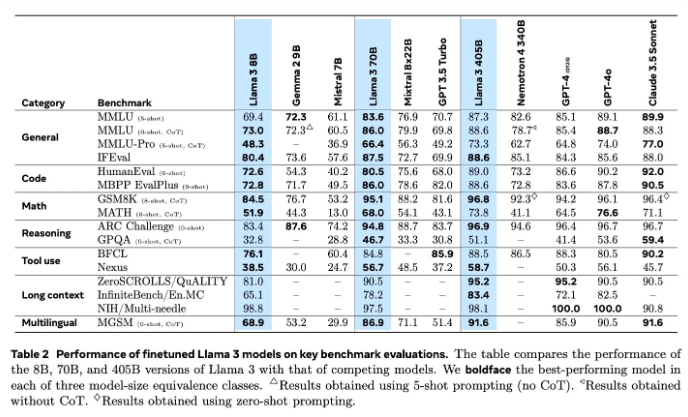

A avaliação de modelos sempre foi um problema difícil no campo da IA. Llama3.1 tentou vários métodos de avaliação e melhoria, incluindo modelos de recompensa e diversos testes de benchmark. Mas o verdadeiro desafio reside em encontrar os estímulos certos que possam derrotar modelos poderosos.

A Meta iniciou o treinamento do Llama4 em junho e, desta vez, focou na tecnologia de agentes. O desenvolvimento de ferramentas de agente como o Toolformer anuncia a nova exploração da Meta no campo da IA.

O código aberto do Llama3.1 não é apenas uma tentativa ousada da Meta, mas também uma reflexão profunda sobre o futuro da IA. Com o lançamento do Llama4, temos motivos para acreditar que a Meta continuará a liderar o caminho em IA. Vamos aguardar ansiosamente como o Llama4 e a tecnologia do agente redefinirão o futuro da IA.

Através de uma compreensão profunda do processo de P&D do Llama 3.1, podemos ver a inovação e os esforços contínuos da Meta no campo de modelos de linguagem em larga escala, bem como sua ênfase na comunidade de código aberto. A direção de pesquisa e desenvolvimento do Llama 4 também indica a tendência futura de desenvolvimento da tecnologia de IA, que vale a pena esperar e observar. Vamos aguardar ansiosamente como a tecnologia de IA se desenvolverá no futuro.